歷史表明,網絡安全威脅隨著新的技術進步而增加。關系數據庫帶來了SQL注入攻擊,Web腳本編程語言助長了跨站點腳本攻擊,物聯網設備開辟了創建僵尸網絡的新方法。而互聯網打開了潘多拉盒子的數字安全弊病,社交媒體創造了通過微目標內容分發來操縱人們的新方法,并且更容易收到網絡釣魚攻擊的信息,比特幣使得加密ransowmare攻擊成為可能。類似的威脅網絡安全的方法還在不斷產生。關鍵是,每項新技術都會帶來以前難以想象的新安全威脅。

最近,深度學習和神經網絡在支持各種行業的技術方面變得非常突出。從內容推薦到疾病診斷和治療以及自動駕駛,深度學習在做出關鍵決策方面發揮著非常重要的作用。

現在我們所面臨的問題是,知道神經網絡和深度學習算法所特有的安全威脅是什么?在過去幾年中,我們已經看到了惡意行為者開始使用深度學習算法的特征和功能來進行網絡攻擊的示例。雖然我們仍然不知道何時會出現大規模的深度學習攻擊,但這些例子可以說成是將要發生事情的序幕。

你應該知道

深度學習和神經網絡可用于放大或增強已存在的某些類型的網絡攻擊。例如,你可以使用神經網絡在網絡釣魚詐騙中復制目標的寫作風格。正如DARPA網絡大挑戰在2016年所展示的那樣,神經網絡也可能有助于自動發現和利用系統漏洞。但是,如上所述,我們專注于深度學習所特有的網絡安全威脅,這意味著在深度學習算法進入我們的軟件之前,它們不可能存在。我們也不會涵蓋算法偏見和神經網絡的其他社會和政治含義,如操縱選舉。要研究深度學習算法的獨特安全威脅,首先必須了解神經網絡的獨特特征。

什么使深度學習算法獨一無二?

深度學習是機器學習的一個子集,機器學習是一個人工智能領域,其中軟件通過檢查和比較大量數據來創建自己的邏輯。機器學習已存在很長時間,但深度學習在過去幾年才開始流行。

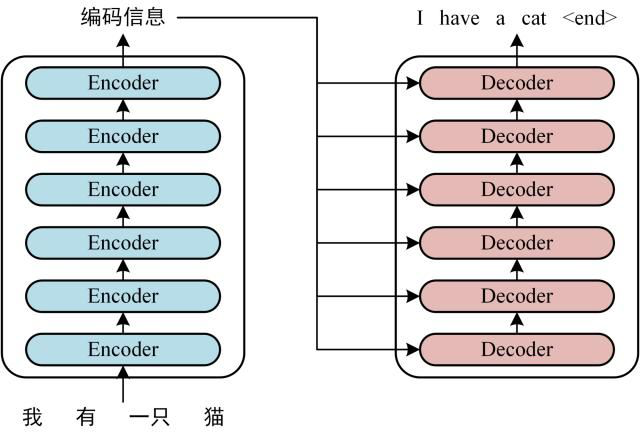

人工神經網絡是深度學習算法的基礎結構,大致模仿人類大腦的物理結構。與傳統的軟件開發方法相反,傳統的程序員精心編寫定義應用程序行為的規則,而神經網絡通過閱讀大量示例創建自己的行為規則。

當你為神經網絡提供訓練樣例時,它會通過人工神經元層運行它,然后調整它們的內部參數,以便能夠對具有相似屬性的未來數據進行分類。這對于手動編碼軟件來說是非常困難的,但神經網絡卻非常有用。

例如,如果你使用貓和狗的樣本圖像訓練神經網絡,它將能夠告訴你新圖像是否包含貓或狗。使用經典機器學習或較舊的AI技術執行此類任務非常困難,一般很緩慢且容易出錯。計算機視覺、語音識別、語音轉文本和面部識別都是由于深度學習而取得巨大進步的。

但神經網絡在保證準確性的同時,失去的卻是透明度和控制力。神經網絡可以很好地執行特定任務,但很難理解數十億的神經元和參數是如何進行網絡決策的。這被稱為“AI黑匣子”問題。在許多情況下,即使是創建深度學習算法的人也很難解釋他們的內部工作原理。

總結深度學習算法和神經網絡兩個與網絡安全相關的特征:

他們過分依賴數據,這意味著他們與他們訓練的數據一樣好(或壞)。它們是不透明的,這意味著我們不知道它們如何起作用。接下來,我們看看惡意行為者如何利用深度學習算法的獨特特征來進行網絡攻擊。

對抗性攻擊

神經網絡經常會犯錯,這對人類來說似乎是完全不合邏輯甚至是愚蠢的。例如,去年,英國大都會警察局用來檢測和標記虐待兒童圖片的人工智能軟件錯誤地將沙丘圖片標記為裸體。在另一個案例中,麻省理工學院的學生表示,對玩具龜進行微小改動會導致神經網絡將其歸類為步槍。

這些錯誤一直伴隨著神經網絡而存在。雖然神經網絡通常會輸出與人類產生的結果非常相似的結果,但它們并不一定經歷相同的決策過程。例如,如果你只用白貓和黑狗的圖像訓練一個神經網絡,它可能會優化其參數,根據動物的顏色而不是它們的物理特征對動物進行分類。

對抗性的例子,導致神經網絡產生非理性錯誤的輸入,強調了AI算法和人類思維的功能之間的差異。在大多數情況下,可以通過提供更多訓練數據并允許神經網絡重新調整其內部參數來修復對抗性示例。但由于神經網絡的不透明性,找到并修復深度學習算法的對抗性示例可能非常困難。

惡意行為者可以利用這些錯誤對依賴深度學習算法的系統進行對抗性攻擊。例如,在2017年,密歇根州華盛頓大學以及加州大學伯克利分校的研究人員表示,通過進行小幅調整來停止標志,他們可以使自動駕駛汽車的計算機視覺算法不可見。這意味著黑客可以強迫自動駕駛汽車以危險的方式行事并可能導致事故。如下面的例子所示,沒有人類駕駛員不會注意到“被黑”的停車標志,但神經網絡可能完全失明。

在另一個例子中,卡內基梅隆大學的研究人員表示,他們可以欺騙面部識別系統背后的神經網絡,通過佩戴一副特殊的眼鏡將一個人誤認為另一個人。這意味著攻擊者可以使用對抗攻擊來繞過面部識別身份驗證系統。

對抗性攻擊不僅限于計算機視覺,它們還可以應用于依賴神經網絡和深度學習的語音識別系統。加州大學伯克利分校的研究人員涉及了一種概念驗證,在這種概念驗證中,他們操縱音頻文件的方式會讓人耳不被注意,但會導致AI轉錄系統產生不同的輸出。例如,這種對抗性攻擊可用于以在播放時向智能揚聲器發送命令的方式來改變音樂文件,播放文件的人不會注意到文件包含的隱藏命令。

目前,只在實驗室和研究中心探索對抗性攻擊。暫時還沒有證據表明發生過對抗性攻擊的真實案例。發展對抗性攻擊與發現和修復它們一樣困難,因為對抗性攻擊也非常不穩定,它們只能在特定情況下工作。例如,視角或照明條件的微小變化可以破壞對計算機視覺系統的對抗性攻擊。

但它們仍然是一個真正的威脅,對抗性攻擊將變得商業化只是時間問題,正如我們在深度學習的其他不良用途中看到的那樣。

但我們也看到人工智能行業也正在努力幫助減輕對抗深度學習算法的對抗性攻擊的威脅。在這方面可以提供幫助的方法之一是使用生成對抗網絡(GAN)。GAN是一種深度學習技術,它使兩個神經網絡相互對抗以產生新數據。第一個網絡即生成器創建輸入數據,第二個網絡,即分類器,評估由生成器創建的數據,并確定它是否可以作為特定類別傳遞。如果它沒有通過測試,則生成器修改其數據并再次將其提交給分類器。兩個神經網絡重復該過程,直到生成器可以欺騙分類器認為它創建的數據是真實的。GAN可以幫助自動化查找和修補對抗性示例的過程。

另一個可以幫助強化神經網絡抵御對抗性攻擊的趨勢是創建可解釋的人工智能。可解釋的AI技術有助于揭示神經網絡的決策過程,并有助于調查和發現對抗性攻擊的可能漏洞。一個例子是RISE,一種由波士頓大學研究人員開發的可解釋的人工智能技術。RISE生成熱圖,表示輸入的哪些部分對神經網絡產生的輸出有貢獻。諸如RISE之類的技術可以幫助在神經網絡中找到可能存在問題的參數,這些參數可能使它們容易受到對抗性攻擊。

RISE產生的顯著圖的例子

數據中毒(Data poisoning)

雖然對抗性攻擊在神經網絡中可以發現并解決相關問題,但數據中毒通過利用其過度依賴數據在深度學習算法中產生問題行為。深度學習算法沒有道德、常識和人類思維所具有的歧視的概念。它們只反映了他們訓練的數據隱藏的偏見和趨勢。2016年,推特用戶向微軟部署的人工智能聊天機器人提供仇恨言論和種族主義言論,在24小時內,聊天機器人變成了納粹支持者和大屠殺否認者,然后毫不猶豫地發出了惡意評論。

由于深度學習算法僅與其數據質量保持一致,因此為神經網絡提供精心定制的訓練數據的惡意行為者可能會導致其表現出有害行為。這種數據中毒攻擊對于深度學習算法特別有效,這些算法從公開可用或由外部參與者生成的數據中提取訓練。

已經有幾個例子說明刑事司法、面部識別和招募中的自動化系統由于其訓練數據中的偏差或缺點而犯了錯誤。雖然這些例子中的大多數是由于困擾我們社會的其他問題而在我們的公共數據中已經存在的無意錯誤,但沒有什么能阻止惡意行為者故意毒害訓練神經網絡的數據。

例如,考慮一種深度學習算法,該算法監視網絡流量并對安全和惡意活動進行分類。這是一個無監督學習的系統。與依賴于人類標記的示例來訓練其網絡的計算機視覺應用相反,無監督的機器學習系統通過未標記的數據來仔細查找共同的模式,而無需接收關于數據所代表的具體指令。

例如,AI網絡安全系統將使用機器學習為每個用戶建立基線網絡活動模式。如果用戶突然開始下載比正常基線顯示的數據多得多的數據,系統會將其歸類為潛在的惡意意圖人員。但,具有惡意意圖的用戶可以通過以小增量增加他們的下載習慣來欺騙系統以慢慢地“訓練”神經網絡以認為這是他們的正常行為。

數據中毒的其他示例可能包括訓練面部識別認證系統以驗證未授權人員的身份。去年,在Apple推出新的基于神經網絡的Face ID身份驗證技術之后,許多用戶開始測試其功能范圍。正如蘋果已經警告的那樣,在某些情況下,該技術未能說出同卵雙胞胎之間的區別。

但其中一個有趣的失敗是兩兄弟的情況,他們不是雙胞胎,看起來不一樣,年齡相差多年。這對兄弟最初發布了一段視頻,展示了如何用Face ID解鎖iPhone X.但后來他們發布了一個更新,其中他們表明他們實際上通過用他們的面部訓練其神經網絡來欺騙Face ID。其實這是一個無害的例子,但很容易看出同一模式如何為惡意目的服務。

由于神經網絡不透明且開發人員不創建規則,因此很難調查并發現用戶可能故意對深度學習算法造成的有害行為。

基于深度學習的惡意軟件

今年早些時候,IBM的研究人員引入了一種新的惡意軟件,它利用神經網絡的特性針對特定用戶隱藏惡意負載,有針對性的攻擊以前是擁有大量計算和情報資源的國家和組織。

但是,由IBM開發的概念驗證惡意軟件DeepLocker表明,此類攻擊可能很快成為惡意黑客的正常操作方式。DeepLocker已將其惡意行為和有效負載嵌入到神經網絡中,以將其隱藏在端點安全工具之外,后者通常會在應用程序的二進制文件中查找簽名和預定義模式。

DeepLocker的另一個特點是使用神經網絡為其有效載荷指定特定目標。為了顯示基于深度學習的惡意軟件的破壞性功能,IBM研究人員為DeepLocker提供了勒索軟件病毒,并將其嵌入到視頻會議應用程序中。

同時,惡意軟件的開發人員在通過網絡攝像頭看到特定用戶的面部時,可以訓練神經網絡來激活有效負載。由于惡意軟件嵌入在視頻會議應用程序中,因此它可以合法訪問網絡攝像頭的視頻源,并能夠監控應用程序的用戶。一旦目標在攝像機前顯示他們的臉,DeepLocker就會釋放勒索軟件并開始加密用戶計算機上的所有文件。

黑客將能夠使用DeepLocker等惡意軟件根據他們的性別和種族,用特定深度學習算法來定位特定用戶或群體。我們尚未了解深度學習算法和神經網絡的網絡安全威脅的規模。創建DeepLocker的研究人員表示,他們并不確定此類惡意軟件是否已經在黑客放棄。未來在神經網絡領域面臨的網絡安全問題,還存在諸多不確定性!

電子發燒友App

電子發燒友App

評論