作者 李安 ? ? ? ? ? ? ?

安思疆科技CEO,碩士畢業于浙江大學光電系,曾就職于華為2012實驗室,獨立設計了3D結構光系統,主導潛望式鏡頭光學設計,大規模應用在華為旗艦機,多項核心技術專利(包括美國專利)第一發明人,發表多篇論文,精通幾何光學、衍射光學,激光,復雜光電系統設計,熟悉微納光學、圖像處理、3D視覺算法、光電芯片等領域,擁有完整的產品及產業經驗和深厚的理論及技術背景。安思疆也是繼蘋果之后,第2家發布消費級面陣dToF激光雷達的公司。

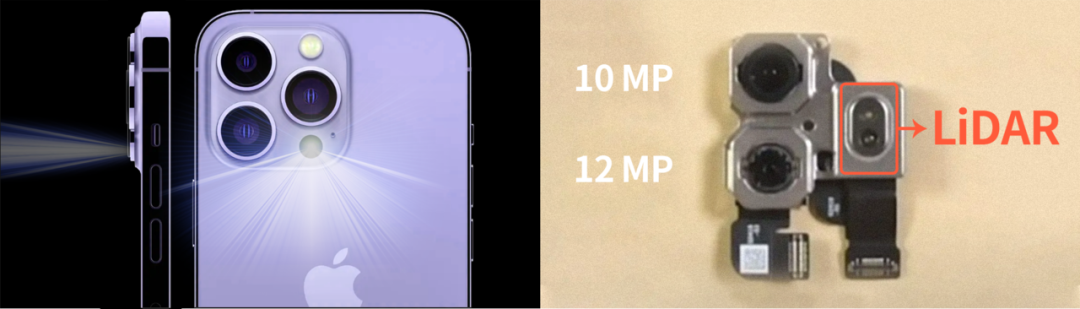

2022年9月,蘋果發布了全新的iPhone 14系列手機,其中Pro和Pro Max均延續了前代配置中的后置dToF Lidar模組,用于手機AR、3D掃描建模、輔助對焦等功能,大幅提升智能手機3D視覺體驗。

實際上,早在2020年3月蘋果發布新款iPad Pro,其后置相機模塊中就進行了大幅革新,首次搭載了自研的基于dToF技術的Lidar模塊( Light detection and range激光雷達);隨后僅隔半年,在10月份發布iPhone 12系列中,也搭載了這一技術;是蘋果繼2017年發布3D結構光后,迎來的又一重大技術里程碑,同時也是大面陣3D Lidar首次在消費電子產品中的大規模應用。

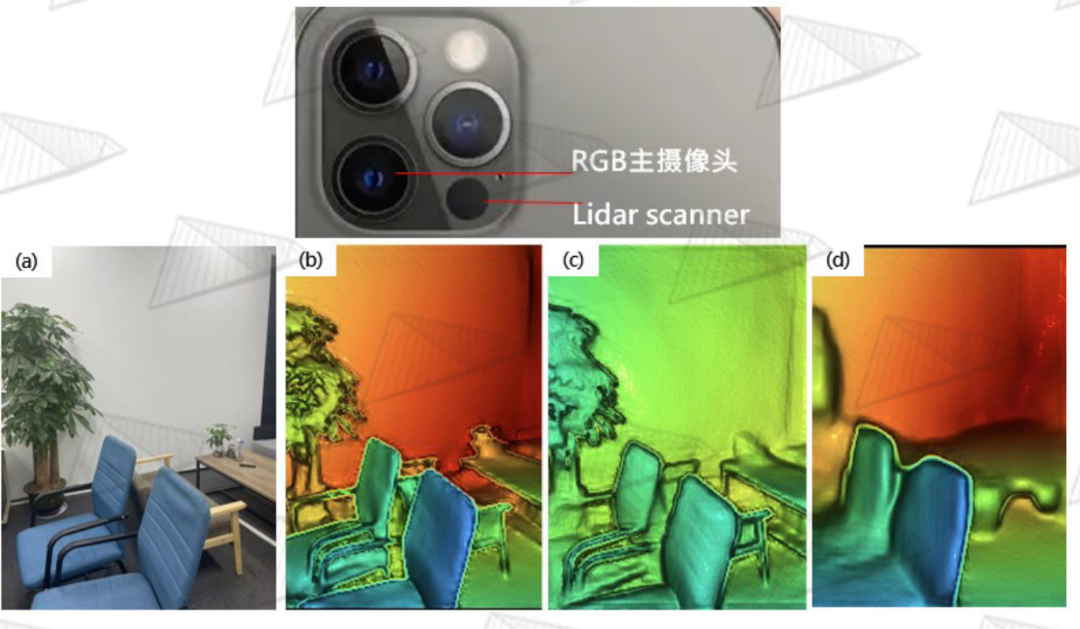

圖1.?iPhone后置激光雷達

3D感測技術作為蘋果公司近年來重點布局的方向,已應用在生物識別、拍照、游戲、建模、虛擬現實、增強現實等領域,進一步強化了其在3D視覺技術領域的護城河。從其技術布局的規劃來看,我們完全有理由相信,在很快到來的Apple Glass中,3D 傳感器是不可或缺的。

3D傳感技術主流包括結構光技術(Structure Light)和光飛行時間測量技術(ToF, Time of Flight), 后者又分為間接飛行時間測量(iToF, indirect Time of Flight)和直接飛行時間測量(dToF, direct Time of Flight)。蘋果在技術路徑上最終選擇了結構光技術和dToF技術分別應用在前置相機和后置相機上,形成互補,兼顧前置和后置的各種3D視覺應用。

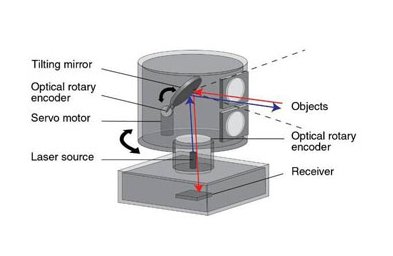

3D結構光經過幾年的發展,大家已經比較熟悉,除了手機,iPad之外,也已應用在了許多地方,例如微信與支付寶的3D刷臉支付、3D人臉門鎖、各種各樣的機器人、3D 視頻和體感游戲等場景中。而dToF技術對于消費電子產品的愛好者來講雖然是比較前沿的技術,但其實也已經應用好幾年了,例如:聽筒附近的接近傳感器,用來探測耳朵是否靠近以此控制屏幕亮滅;某些手機的后置相機模塊中配備的距離傳感器,用來輔助拍照對焦。雖然這些傳感器使用了dToF的原理,但都是單點或者少點的探測,只能做一些簡單的功能,無法實現大視場范圍、高分辨的3D面陣成像,因而不能用來做視覺上復雜的多功能應用。在蘋果的激光雷達發布之前,面陣的dToF技術主要應用在車載激光雷達,目前成熟的方案采用是機械式掃描和半機械式掃描來實現線陣向面陣的轉化。而蘋果的激光雷達則是大面陣dToF技術第一次在消費電子場景中使用,并且采用了基于可尋址VCSEL的全固態方案,真正做到了“出道即巔峰”。

秉承好技術就要用起來的理念,蘋果為這套3D Lidar系統也是“操碎了心”,將眾多復雜學科和前沿技術深度交叉,這也是作者從業這么長時間以來,所遇到的最精密、最復雜,也是融合性最高的光電視覺傳感器,為了能讓大家能由淺及深全面了解,作者將從器件到系統設計進行全方位的解析。

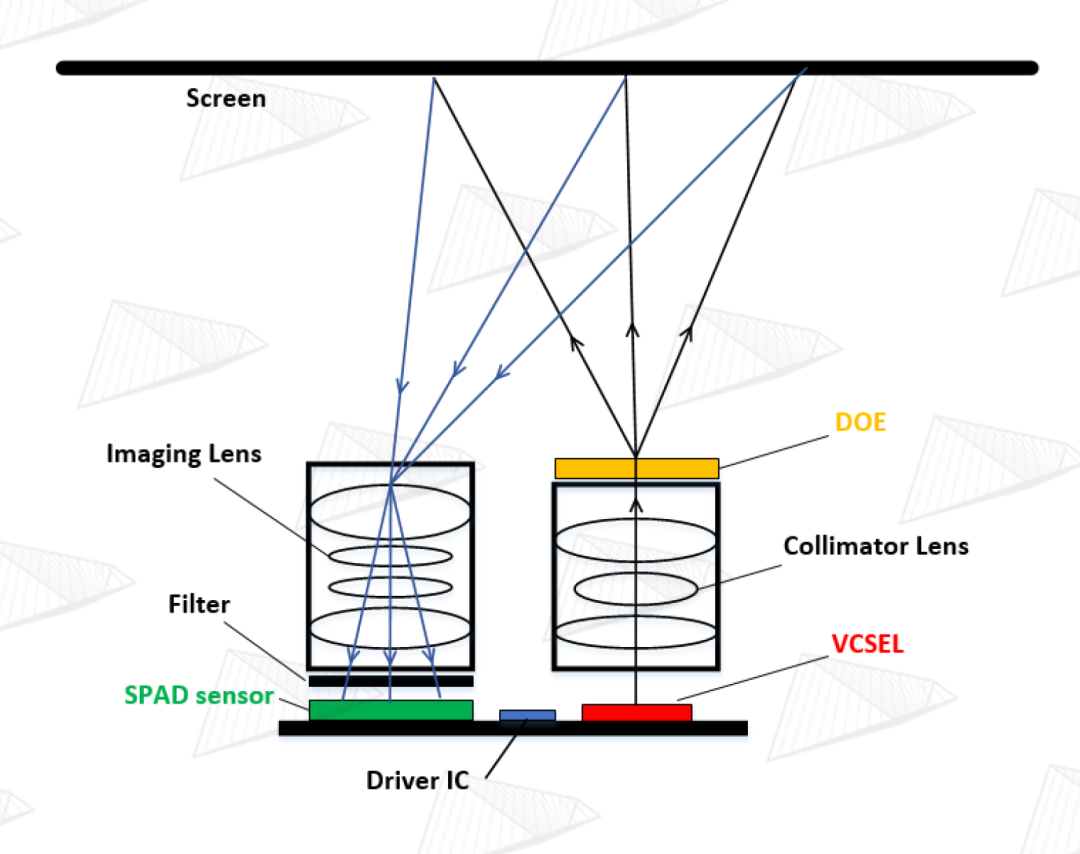

圖2. 3D Lidar核心器件組成及工作原理示意圖

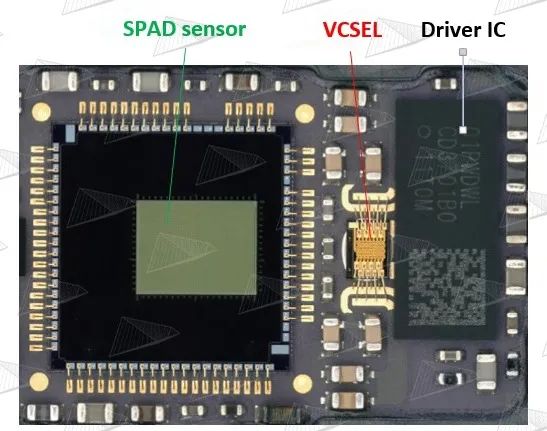

圖3. 蘋果 3D Lidar 電路板實物圖

如圖2和圖3,蘋果3D Lidar的核心部件為VCSEL+ Collimator +DOE(組成發射端)、Imaging Lens +Narrow-band Filter +SPAD (組成接收端)、高速高功率激光驅動電路。我們先對各個核心器件做一個基本了解。

核心器件篇 ? ? CORE COMPONENTS ? ? ? ? ?

VCSEL ?

Collimator ?

DOE ?

Imaging Lens ?

Narrow-band Filter ?

SPAD ?

高速高功率激光驅動電路

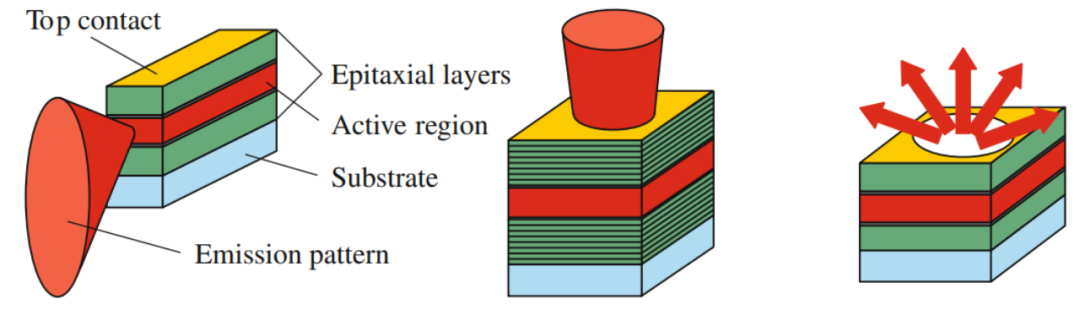

VCSEL垂直腔面發射激光器 Vertical-Cavity Surface-Emitting Laser 激光是愛因斯坦在研究粒子的受激輻射時演變而來的技術,是使光波在含有增益介質的光學腔(諧振腔)里產生穩定的駐波震蕩,以此實現光能量放大。第1臺激光器由美國科學家在1960年利用紅寶石制成,激光的中文名是由錢學森先生翻譯的。我們可以按光束出射的方式,將激光分為2種類型,即EEL(Edge-Emitting Laser 邊發射激光)和VCSEL(Vertical-Cavity Surface-Emitting Laser 垂直腔面發射激光),如圖4。 制作激光器的材料可以是固體、氣體、染料和半導體。目前用于消費電子和汽車電子等領域的主要是半導體激光器和光纖激光器(屬于固體激光器),也開始在車載有應用,不過本文討論的是半導體激光器范疇。 那么,EEL和VCSEL的區別是什么?顧名思義,EEL的光束是從器件的側邊發射出來,由于激光芯片可以在水平方向做得比較長,因此激光可以獲得充分的能量增益,功率可以做得很大,目前絕大部分激光器都是EEL。VCSEL則是垂直于激光芯片表面(即厚度方向)發光。

VCSEL垂直腔面發射激光器 Vertical-Cavity Surface-Emitting Laser 激光是愛因斯坦在研究粒子的受激輻射時演變而來的技術,是使光波在含有增益介質的光學腔(諧振腔)里產生穩定的駐波震蕩,以此實現光能量放大。第1臺激光器由美國科學家在1960年利用紅寶石制成,激光的中文名是由錢學森先生翻譯的。我們可以按光束出射的方式,將激光分為2種類型,即EEL(Edge-Emitting Laser 邊發射激光)和VCSEL(Vertical-Cavity Surface-Emitting Laser 垂直腔面發射激光),如圖4。 制作激光器的材料可以是固體、氣體、染料和半導體。目前用于消費電子和汽車電子等領域的主要是半導體激光器和光纖激光器(屬于固體激光器),也開始在車載有應用,不過本文討論的是半導體激光器范疇。 那么,EEL和VCSEL的區別是什么?顧名思義,EEL的光束是從器件的側邊發射出來,由于激光芯片可以在水平方向做得比較長,因此激光可以獲得充分的能量增益,功率可以做得很大,目前絕大部分激光器都是EEL。VCSEL則是垂直于激光芯片表面(即厚度方向)發光。

圖4. 左:邊發射激光,光從芯片側邊發出;中:VCSEL,光從芯片表面發出;右:LED,光從各個方向發出.

眾所周知,芯片的厚度一般都非常薄,因此激光獲得的能量增益有限,VCSEL中的增益腔長一般只有納米、微米量級,跟EEL差幾個數量級,因此VCSEL的功率很難做大。不過,可以實現級聯放大的多節VCSEL也已經開始成熟應用,但目前還與EEL有較大差距。VCSEL是在1979年,也就是激光發明近20年后,才由日本科學家發明,其難點之一就是增益腔太短,導致損耗大于增益,很難穩定發光;經過不斷的改善,直到上世紀90年代才開始在通信領域上逐漸應用。雖然存在這些缺點,但是VCSEL同樣有EEL無法比擬的幾大優勢:

1 ? 多點陣&緊湊封裝 VCSEL可以很輕松做到將幾十甚至上千個激光發射單元集成在小于數平方毫米的面積上,相鄰的兩個激光器單元之間的間隔甚至可短至~10um,這是EEL幾乎不可能做到的,因此也非常便于封裝集成,可以完全復用目前攝像頭的COB(Chip on Board)工藝,對比之下EEL的封裝則稍顯笨拙。 2 ? 圖案化&分區照明 VCSEL還可以將眾多激光點源按特殊設計排布,形成任意的圖案,例如iPhone前置3D結構光中使用的偽隨機散斑編碼VCSEL,如果同時采用特殊的制程,可以將這些激光點陣按組別進行物理隔離,分時、分區點亮,進而可以進行更精細更復雜的設計,提升系統性能,這也是EEL無法獨立實現的。 3 ? 規模化量產&成本 由于是垂直晶圓表面發光,VCSEL在工藝制程上有巨大的優勢,在晶圓制作完成之后,可以直接利用探針技術進行在線的晶圓級測試。而EEL則不行,因為邊發射的激光一般需要在諧振腔的兩側,也即晶圓的水平方向進行解理鍍反射膜,才能形成激光諧振腔,因此切割后還要繼續進行加工和測試,這就大大降低了生產效率,增加很多成本。對于工業、車載等領域,尚可接受,但對于手機等量級的消費電子領域顯然是無法接受的。 4 ? 發散角圓對稱

由于VCSEL束縛電流的孔徑形狀一般是圓形或接近圓形,所以其發散角在各個方向都相等,是圓對稱的,因此光斑也是圓形,有利于后續光學整形系統的設計。EEL的孔徑一般是橫縱比較大的矩形,所以EEL的發散角是橢圓狀,而且水平和垂直的發散角相差比較大,光斑是一個比較扁的橢圓形,這對后續的光束整形是比較不友好的。

綜上,在消費電子領域,對激光功率、光束質量以及可靠性等要求相對較低,這就在很大程度上屏蔽了VCSEL的弱點,而其優勢則完全發揮。因此,消費電子過去、現在和未來的趨勢也必然是以VCSEL這種垂直表面發光形式的器件為主,這也是為什么蘋果對此進行了大規模的投資。未來HCSEL水平腔表面發射激光(Horizontal V-Cavity Surface-Emitting Laser)也將逐步應用起來,這是一種結合了EEL和VCSEL優點的激光器,在此不展開詳述。總之,在消費電子領域采用表面發射形式的激光擁有巨大優勢。

準直鏡頭&接收鏡頭 Collimator & Imaging Lens 這兩個器件是成像光學鏡頭,屬于比較傳統的幾何光學領域,只不過前者用于投影,后者用于攝影。? Collimator,業界一般稱為準直鏡頭,在蘋果的結構光和dToF Lidar上都有應用,但其實除蘋果之外,一般的ToF技術都不使用準直鏡,原因在后面會講到。準直鏡頭由多個光學鏡片組合而成,用來將激光光源投射到場景中。本質上作用有二,其一是將激光的發散角整形至接近0度,其二是將僅約1mm2、由多個激光點陣形成的微小圖案投射出去并放大,放大倍率通常在數百倍至數千倍。這也是為什么1mm2大小的VCSEL所投射出來的點陣卻能最終覆蓋前方大視場范圍場景的原因之一,原因之二則是后面要講的DOE所起的作用。?? Imaging Lens,業界一般稱為接收鏡頭,是所有2D、3D視覺中必不可少的器件,包括單反相機、手機相機、安防監控、工業檢測、機器視覺等。在dToF Lidar的系統應用中,與Collimator一樣,一般也是由多個光學鏡片組成,其作用是成像接收TX端所投射出來的放大散斑,并在焦面上重新縮小至數平方毫米,以便微小尺寸的光電傳感器接收。

準直鏡頭&接收鏡頭 Collimator & Imaging Lens 這兩個器件是成像光學鏡頭,屬于比較傳統的幾何光學領域,只不過前者用于投影,后者用于攝影。? Collimator,業界一般稱為準直鏡頭,在蘋果的結構光和dToF Lidar上都有應用,但其實除蘋果之外,一般的ToF技術都不使用準直鏡,原因在后面會講到。準直鏡頭由多個光學鏡片組合而成,用來將激光光源投射到場景中。本質上作用有二,其一是將激光的發散角整形至接近0度,其二是將僅約1mm2、由多個激光點陣形成的微小圖案投射出去并放大,放大倍率通常在數百倍至數千倍。這也是為什么1mm2大小的VCSEL所投射出來的點陣卻能最終覆蓋前方大視場范圍場景的原因之一,原因之二則是后面要講的DOE所起的作用。?? Imaging Lens,業界一般稱為接收鏡頭,是所有2D、3D視覺中必不可少的器件,包括單反相機、手機相機、安防監控、工業檢測、機器視覺等。在dToF Lidar的系統應用中,與Collimator一樣,一般也是由多個光學鏡片組成,其作用是成像接收TX端所投射出來的放大散斑,并在焦面上重新縮小至數平方毫米,以便微小尺寸的光電傳感器接收。

評價光學成像鏡頭的性能指標叫像差,包含了畸變、色差、場曲、球差以及比較綜合的評價參數MTF等。像差的意思是成像的差別,也即實際的成像與完美成像的差別,因此通常用于攝影的光學鏡頭肯定是要求各種像差,例如畸變,越小越好,越接近于0越好;但是,蘋果卻反其道而行之,故意把Imaging Lens的畸變設計得特別大,這非常獨特,幾乎沒有先例,這一點我們將在后面系統篇中進行解析。

DOE 衍射光學元件 Diffraction Optical Element DOE衍射光學元件,屬于物理光學范疇,我們都知道光具有波粒二象性,光電效應證明其粒子的特性,光的衍射現象則證明了其波動的特性,其實二者本質上也是自洽的。一般來講,在幾何成像光學領域用的是光線光學的理論,即偏粒子性,而在光的衍射干涉等領域則采用波動光學理論,即偏波動性。實際上,波動光學的理論可以完全適用于幾何成像光學,只是這樣會讓問題解析變得更繁瑣復雜,所以才不這樣用。那么,我們通常所說的幾何光學、衍射光學以及最近比較熱門的超表面光學(Meta Surface)的區別是什么呢? 讓我們來做一個更本質的區分,假設光波的波長為λ(可見光波長為380nm~760nm),器件的特征尺寸(feature size 可以理解為最小結構)為d, 一般來講可以這樣分 ?d<0.1λ~λ,這時特征尺寸已經非常小,不僅衍射現象很明顯,對光波的電磁特性也會產生不可忽略的影響,這時候光的偏振等特性必須要納入考慮的范圍,但正因為對偏振有影響,所以可在極短的光程中對光波進行非常精細的操控,超表面光學(Meta Surface)就屬于這一范疇,要用嚴格耦合波理論才能精確描述。

DOE 衍射光學元件 Diffraction Optical Element DOE衍射光學元件,屬于物理光學范疇,我們都知道光具有波粒二象性,光電效應證明其粒子的特性,光的衍射現象則證明了其波動的特性,其實二者本質上也是自洽的。一般來講,在幾何成像光學領域用的是光線光學的理論,即偏粒子性,而在光的衍射干涉等領域則采用波動光學理論,即偏波動性。實際上,波動光學的理論可以完全適用于幾何成像光學,只是這樣會讓問題解析變得更繁瑣復雜,所以才不這樣用。那么,我們通常所說的幾何光學、衍射光學以及最近比較熱門的超表面光學(Meta Surface)的區別是什么呢? 讓我們來做一個更本質的區分,假設光波的波長為λ(可見光波長為380nm~760nm),器件的特征尺寸(feature size 可以理解為最小結構)為d, 一般來講可以這樣分 ?d<0.1λ~λ,這時特征尺寸已經非常小,不僅衍射現象很明顯,對光波的電磁特性也會產生不可忽略的影響,這時候光的偏振等特性必須要納入考慮的范圍,但正因為對偏振有影響,所以可在極短的光程中對光波進行非常精細的操控,超表面光學(Meta Surface)就屬于這一范疇,要用嚴格耦合波理論才能精確描述。

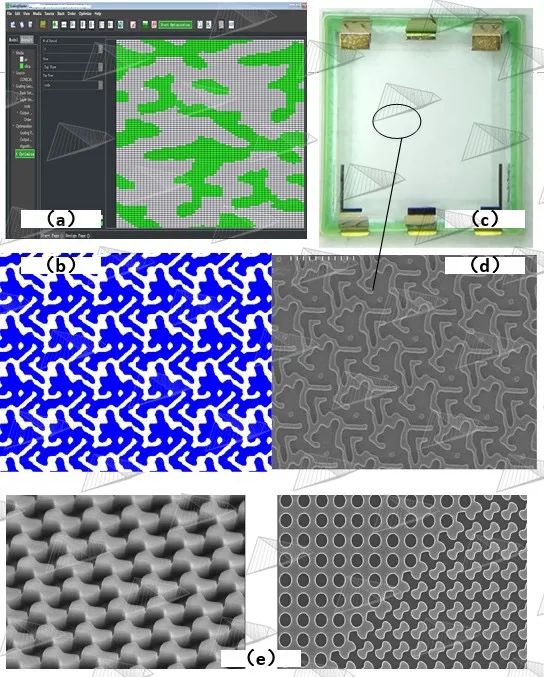

圖5.?(a)安思疆自研的DOE設計軟件GratingMaster (b)DOE的GDS加工設計文件 (c)安思疆自研的DOE實物圖 (d)掃描電子顯微鏡下的微納結構 (e)蘋果激光雷達的DOE顯微鏡圖像

λ

回到DOE,經過上述的了解,我們對DOE有了基本認識。DOE在蘋果的3D結構光和3D Lidar中都有使用,其功能是比較容易理解的,本質上是把一束光分裂成若干份,再通俗一點講就是把一束光復制多份,起到復制的作用。因此DOE可以把上述Collimator放大的散斑圖案進行復制,相當于對散斑的投射范圍進行了二次放大,蘋果的3D結構光視野范圍~90°,因此即使被攝人臉的位置偏離較大時也能同樣解鎖。蘋果的3D Lidar視野范圍也達到了~70°。角度越大,系統設計和DOE設計難度都急劇增大,不過目前已經有超過100°的超廣角3D 結構光產品,例如安思疆的Nuwa系列產品已經可以達到110°。

?

窄帶濾光片 Narrow-band Filter 該器件屬于薄膜光學領域,是比較傳統的領域。3D Lidar中使用的是940nm近紅外VCSEL激光器,窄帶濾光片的作用是濾除掉940nm之外的環境光,最大程度減少干擾,大大提高信噪比,但因為制造工藝的原因會比普通的截止濾光片貴不少。這一器件相對常見就不再展開討論。

SPAD 單光子雪崩二極管 Single Photon Avalanche Diode 前述的VCSEL屬于光源器件,是將電能轉化為光能;光學鏡頭、DOE和濾光片則屬于無源被動器件,即不用消耗電能;現在要講的SPAD芯片則是將光能轉化為電能,并且還能通過模擬-數字轉換,將探測到的光信號最終轉換成數字形式向外輸出,是一顆集成了光電探測模塊、模擬電路模塊、數字電路模塊的高度集成化的芯片,是相對比較新興的領域,而且蘋果還把它做成了大面陣的陣列,這也是陣列SPAD第一次在消費電子領域應用。乘著蘋果的東風,第一次出場就是上億數量級的超大規模量產,這與幾年前VCSEL和DOE的消費級大規模應用幾乎如出一轍,蘋果也將SPAD sensor訂單交與了最親密的合作伙伴——日本索尼公司。 采用定制化工藝制造的固態SPAD盡管已經發明了幾十年,但是之前一直存在兩個問題: 一是器件體積大,價格昂貴; 二是器件與集成電路難以兼容。近幾年來,基于CMOS工藝的SPAD陣列的成功設計和制造很好地解決了這兩方面的問題,從遠紅外到深紫外頻段SPAD都能實現單光子級別的探測靈敏度,與光電倍增管、APD等相比較,其具有更高的量子效率、更小的尺寸、更低的擊穿電壓,能識別單光子,可數字化成像,抗環境光干擾等特點,其最大的優勢在于能夠實現遠距離測距,且具備較高精準度,因此在激光雷達、核醫學設備、生物診斷、高能物理、射線探測、分析儀器等多個領域已有廣泛應用。 ?

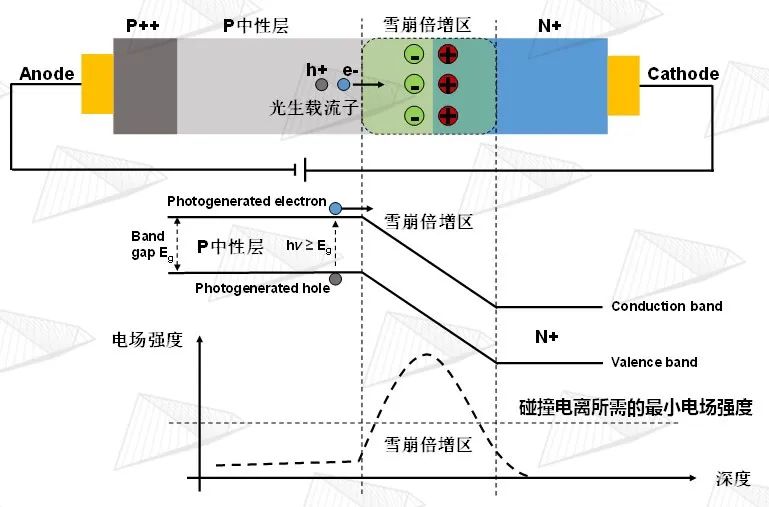

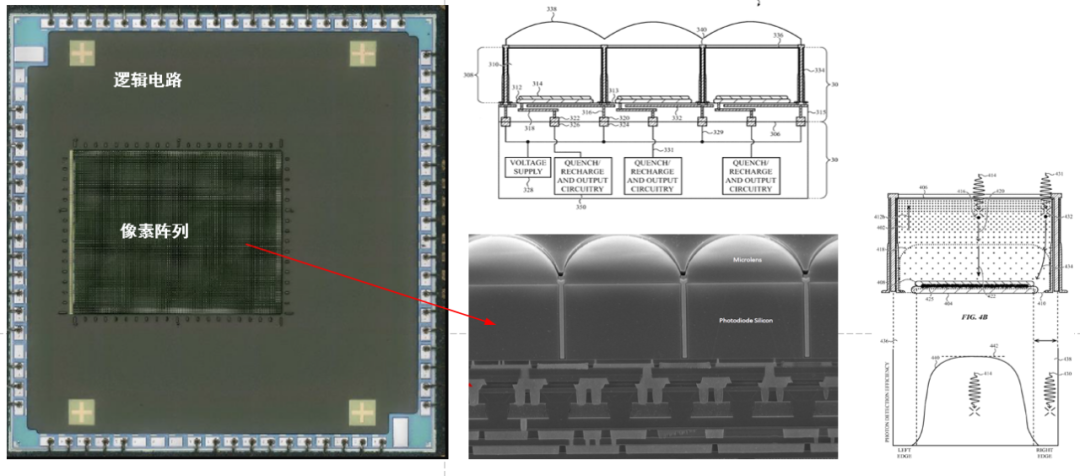

圖6. SPAD工作原理

如圖6所示,SPAD是一種基于內光電效應的光電探測器件,當在PN結兩端施加足夠的反向偏置電壓時,光子被中性層吸收后將所攜帶的能量傳遞給價帶上的電子使其躍遷至導帶,從而產生光生載流子,在內部電勢的作用下向雪崩倍增區漂移,當雪崩倍增區的內建電場大于碰撞電離所需的最小電場強度時,光生載流子獲得更高的能量后被加速,與雪崩倍增區的晶格原子發生多次碰撞產生更多的電子-空穴對。這種雪崩倍增效應使器件內部的電子-空穴對呈現指數倍的增長,從而產生極高的光生電流。

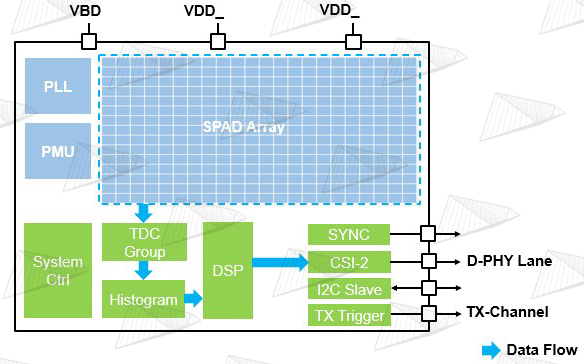

圖7. 典型的SPAD sensor架構 圖7展示了典型的SPAD sensor架構,可以看出是這是一種非常綜合型的芯片,包含SPAD光電二極管、模擬電路、模數混合電路、數字電路等。

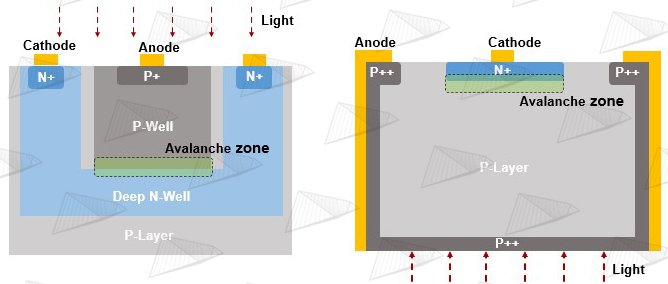

圖8. 左右分別為典型的共陰極(Common Cathode)FSI和共陽極(Common Anode)BSI像素結構 如圖8,與傳統圖像傳感器類似,從制造工藝來分,SPAD sensor可以分為FSI(前照式)和BSI(背照式)兩種類型。這兩種結構在制造上的差異要遠大于傳統圖像傳感器,原因就在于每個像素都需要與TDC相連接,導致采用BSI的工藝會大大增加復雜度。

圖9. 蘋果采用BSI工藝的SPAD sensor實物圖和像素剖面圖 如圖9,蘋果采用的是BSI工藝,將SPAD層與邏輯電路層通過一種先進的低溫銅-銅鍵合工藝連接起來,這樣可以把邏輯電路完全掩藏在底部,從而使SPAD的受光面積達到接近100%,最大限度的提升感光效率,蘋果在其專利中對此進行了詳述。  高速高功率激光驅動電路 High Speed & High Power Laser Driver Circuit

高速高功率激光驅動電路 High Speed & High Power Laser Driver Circuit

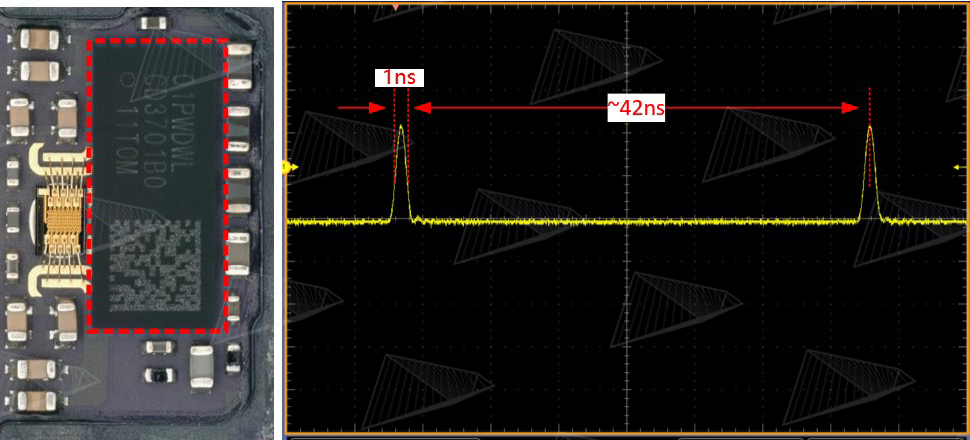

圖10. iPhone激光雷達的驅動芯片和光脈沖,每秒發射約2400萬個光脈沖

dToF的測量原理中要用到超短脈沖激光,因此也對激光的驅動電路提出了要求:1.脈沖寬度~1ns;2.瞬時電流在某些應用中最高要達到~20A。單看脈沖寬度,這不能算是很高的要求,但是要同時滿足大電流就變得非常困難,由于大部分驅動芯片還是硅基形式,無法承載這么大的高速電流,因此不僅在消費電子領域幾乎沒有過類似的需求,即使在車載領域也很難找到一顆集成的驅動芯片來同時滿足這兩個要求。目前主要的解決方式是:短脈沖驅動芯片+GaN開關,未來將這二者集成在一起是趨勢。無論如何,為了產生超短+高功率的激光脈沖,并且保持脈沖不變形,對激光器以及其驅動電路都提出了極高的要求。

系統篇 ? ? SYSTEM ? ? ? ? ? ?

前面我們對蘋果Lidar中使用的各種器件做了逐一介紹,從中我們可以看到這些器件之間幾乎沒有相通之處,每一個器件都是一個獨立的領域,集結了幾何光學、衍射光學、光電子學、激光、半導體物理、模擬電路、數字電路等領域最前沿的技術,而且對于最終的產品系統來講,這還只包含了一半的東西,剩下一半是算法軟件。

3D視覺和2D視覺的一大區別就是3D視覺的軟硬件具有非常強的耦合性,這會在下面講到。 如此多前沿學科的交叉必然使得系統設計異常復雜,但是學科交叉又是最容易產生創新的地方,那么這么多的交叉會產生怎樣的效果呢?接下來我們一起看看蘋果到底是如何設計這套Lidar系統,根據公開專利顯示在2014年左右,也就是蘋果花了將近4億美金收購PrimeSense(3D結構光公司)之后,就開始同步研究這一技術了。

我們首先從應用場景出發對產品規格提出需求,主要針對手機和Pad用戶。因為是在后置模塊,需要做3D建模、SLAM、AR渲染等應用,所以距離不能太近,但人是習慣于握著設備移動掃描的,使用距離肯定也不用像車載那么遠,那么5米就是一個適中的范圍;對于分辨率和視場角,Lidar的應用不需要像結構光一樣多達數百萬的分辨率,也不需要用來做Face ID等高精度應用,而是用于平面檢測、空間定位、物體測量、虛擬場景和現實場景的1:1融合等等;結合對后續算法的綜合平衡,起碼要達到HQVGA分辨率,而視場角則與后置主攝像頭匹配,可以略小一點;對于體積尺寸,毫無疑問,手機上最大的限制就是空間,可謂寸土寸金,而Lidar包含接收和發射兩個模塊,如何能夠做得比一個普通的攝像頭更小,而且還要小很多,這是極具挑戰的,但這也是必須要滿足的;對于功耗,Lidar使用起來時會持續工作,因此必須在300mw~500mw范圍上下不能太大;對于使用環境,必須適用室內、室外、強光和弱光,全場景下都有同樣的性能,這樣才能讓普通用戶感受不到差別,但這其實是很困難的一項要求,一般來說在其他應用領域可以做取舍但對于手機用戶而言是斷然不行的;對于成本,當然是越低越好,考慮到是革命性產品,可以接受一定的溢價,從拆解情況來估算,蘋果的Lidar物料成本大概在$10~$12之間,是完全可接受的。歸納如下:

使用距離:~5m

分辨率,視場角:~HQVGA;~70° ?

尺寸:不能大于普通2D攝像頭,越小越好

功耗:300mw~500mw,越小越好

使用場景:全光照場景,24小時全天候

成本:$10~$12

需要注意是,以上需求必須同時滿足。

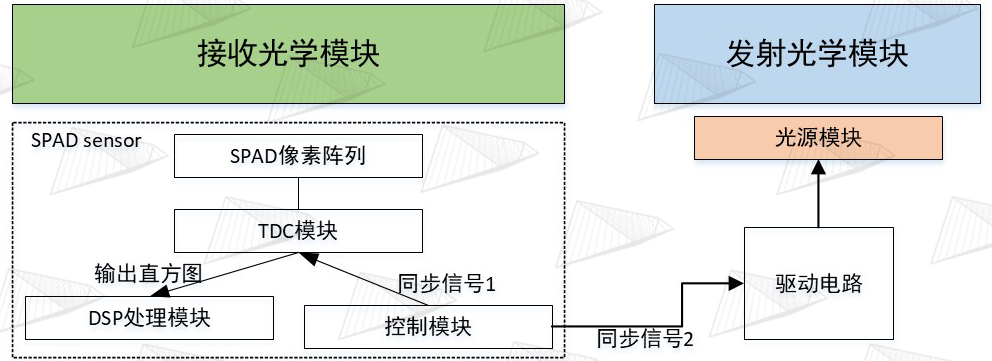

圖11. dToF測量原理 在設計解決方案之前,我們先了解一下系統工作的基本邏輯和原理。典型的dToF系統的測量原理是:以單次測量周期為例,如圖11,SPAD芯片內部的控制電路會發出“開始”信號,這一信號一方面會讓內部的TDC計時器開始計時,另一方面會傳送出去給到外部的激光驅動芯片作為同步觸發信號,驅動芯片接收到觸發信號后,會產生一個~1ns的超窄脈沖電流,觸發脈沖信號和輸出脈沖電流之間由于經過了Driver IC會有時延,這種時延一般是ns級,所以一般在其他的應用中都不太需要考慮,但在dToF測量系統中是不行的,這一時延需要在模組生產的過程中進行測量并且補償,而且它還與溫度相關,這會使得精準補償的難度增加,在此不展開討論。VCSEL接收到電流脈沖之后開始發光(這里也會有時延產生,需要補償),光束由準直鏡放大準直后投射到DOE上,DOE經過復制擴散形成更大的投射范圍,再經過場景中的物體反射回接收鏡頭,經過接收鏡頭的縮小成像后照射在SPAD陣列上, 雪崩二極管接收到光脈沖后會產生雪崩電流,致使TDC的計時中斷,從而得到一次飛行時間t1,同時淬滅復位電路會將測量電路快速復位,等待下一個測量周期的光脈沖到來,這樣經過多次重復該過程就算是一次完整的測量。假設測量N次,其中n次有效(n

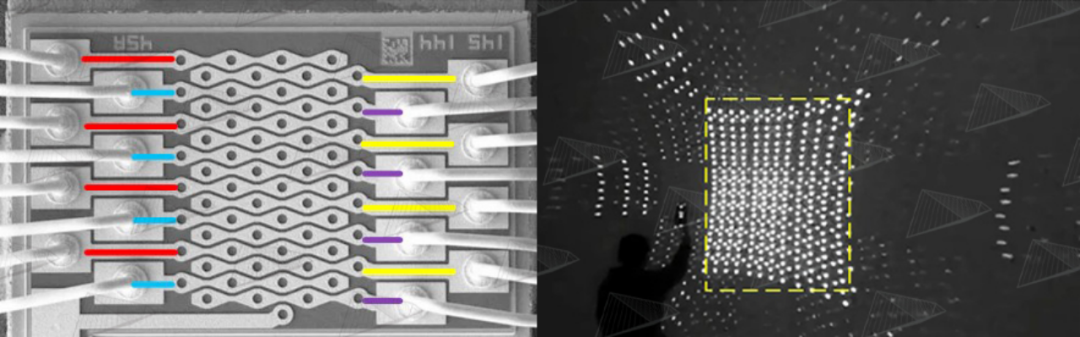

圖12. 蘋果激光雷達使用的VCSEL,總共64點。其中紅、黃、藍、紫每4行為同一組,這4組點陣是并聯關系,分時點亮,配合光學系統投射出激光散斑,達到掃描目的,如右圖所示。圖中黃色虛線框之外的點陣是由DOE的高階衍射造成的,不影響效果。 與一般的均勻分布的面陣Flash照明不同,蘋果這種方案采用了與3D結構光類似的點陣激光,但不同于結構光超過3萬個激光點陣,Spot dToF僅僅只有576個激光點陣,相差50倍,不過其單點功率要遠高于結構光。之所以采用點陣是因為在相同電功率下,其出射的光能量密度要遠遠高于面陣方案,按照估算,差別甚至可以達到15~30倍,這樣可以解決兩個非常棘手的大難題:?

1 在戶外使用時陽光干擾的問題,光功率密度的大幅度提升能夠使得即使在陽光干擾的狀態下,仍然可以保持足夠的信噪比,所以大家會看到蘋果的Lidar即使在盛夏最強的陽光下效果依然不下降。

2 由于點數少,光功率密度大,因此VCSEL不需要很大的瞬時電流,也就不需要引入大功率器件,極大地緩解了手機硬件電路的設計壓力,可以完全與當前的設計兼容。 采用這種點陣方案不僅能夠維持戶外使用的效果,而且由于能量集中,其抗干擾能力也會得到極大的加強。總而言之,在手機這種限制極多的情況下,Spot dToF是手機后置3D視覺的最優解。 不過,在獲得最佳效果的同時,同樣也帶來了兩大挑戰:??

1 這種全固態的點陣掃描對光學系統設計提出了極高的要求;

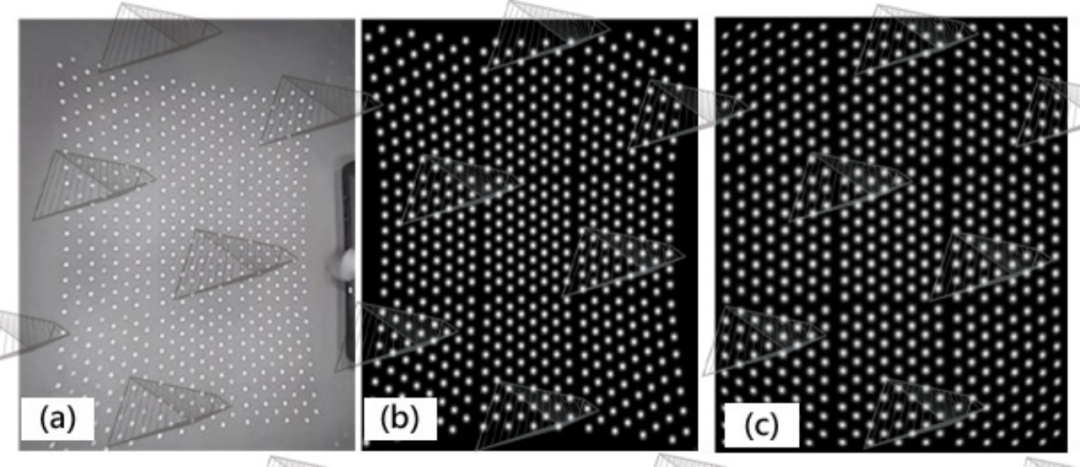

2 由于只有576個點(24*24),獲得的有效分辨率太低,與系統規格中要求的HQVGA差了70倍~80倍。 如果能克服這兩大問題,那么就不會再存在技術瓶頸了,這兩個問題正是蘋果dToF Lidar真正的核心所在。 我們先來看怎么解決第一個問題。前述的SPAD芯片中的TDC計時器是一種非常消耗硬件資源的模塊,如果要一次全部同時曝光則需要576個TDC,這樣會大大增加芯片面積,進而增加芯片成本、模組體積和功耗。因此可以采用144個TDC進行時分復用,每次只采集144個激光點陣的飛行時間,分4次采集,這樣就可以減少TDC數量,降低成本、體積和功耗,并且由于dToF的單次測量時間是ns級的,所以不用擔心由于時分復用導致最終系統幀率不足。同時,為了完美配合TDC的工作,實現能量零浪費,VCSEL上的激光點也被相應地分成了獨立的4組,我們可以稱之為“可尋址陣列”,每組16個點,經過DOE復制變成144個點,對應144個TDC。如此,雖然VCSEL有64個點,但實際上同一時間工作的只有16個點,那么VCSEL的驅動電流只需要能夠同時點亮16個點即可,大大減輕了Driver IC的負擔,按估算只需要~2A電流即可,這樣用一般的硅基芯片就能實現。由于這4組點陣是完全獨立的,因此Driver IC也要有4路獨立的驅動,不過對于Driver IC來說,除了增加一些設計難度,硬件上的資源增加是完全可控的。根據拆解情況,是德州儀器TI為蘋果定制了這顆比較獨特的Driver IC,并且其中應該還集成了用于檢測ITO電路狀態的功能。ITO是一種透明的導電玻璃,嵌入在DOE里用于實時監測DOE的狀態是否正常,DOE的狀態正常與否會影響出射激光的功率密度,引發人眼安全問題。 上面我們講到TDC時分復用,并且每個TDC同時只對應測量一個激光點斑,這是比較好理解的。那么問題在于用來接收的sensor是一個像素陣列,每一個像素都是一個獨立的SPAD,分辨率大概是200*150=30000,我們知道TDC是要與SPAD連接在一起工作的,那么144個TDC如何能與30000個TDC相連接呢,就算時分復用的話,那么每個TDC要與3000/144≈200個SPAD連接,然后分時工作200次,這顯然與上述的分4次工作相去甚遠。

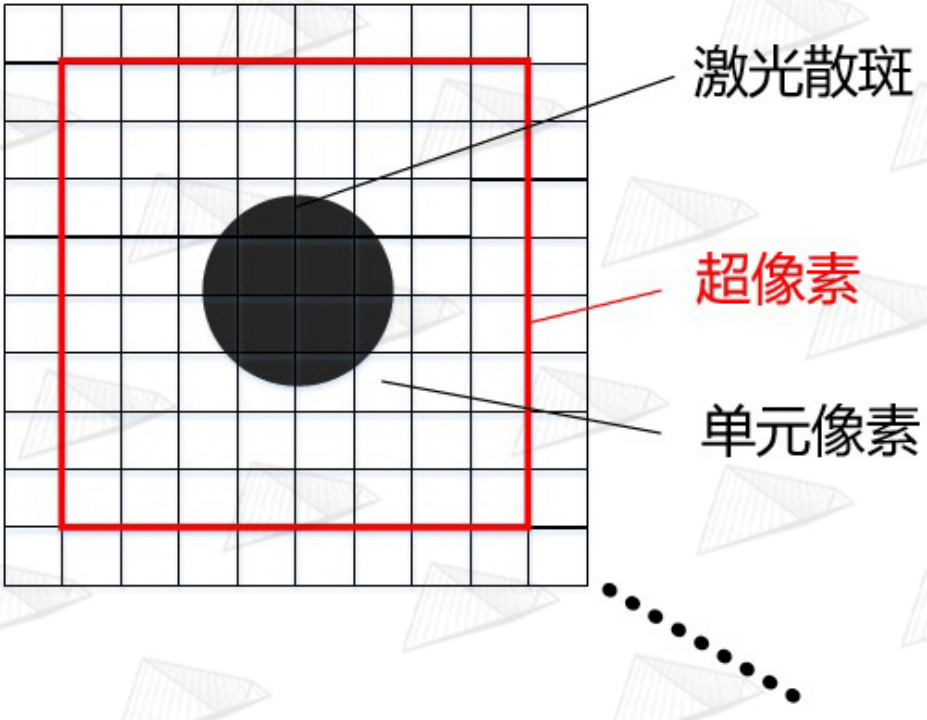

圖13. 超像素結構示意圖

我們在這里引入蘋果稱之為超像素(Super pixel)的概念,如圖13,其實就是把m*n個單元像素通過類似在CIS中常用的Binning方式來合并,變成1個像素,這個像素就稱為超像素,而TDC連接的就是這個超像素。每個超像素就是一個小區域,其中包含了數十個單元像素,在這個超像素工作的時候,對應的激光斑點就落在這個超像素內,從而進行感光測量。知道這個概念之后,既然有576個點,那就應該對應有576個超像素,每個超像素由約50個SPAD單元像素組成。這576個超像素也分成4組,又因為只有144個TDC,所以每個TDC連接4個超像素,然后分時復用,144*4=576,這樣就與前述問題符合了。

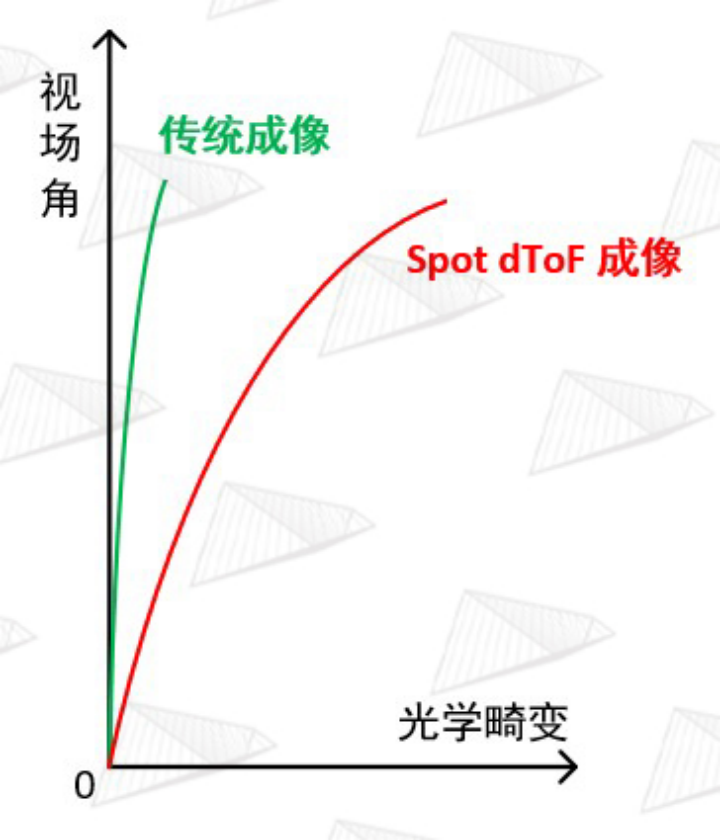

圖14. Spot dToF 成像鏡頭的畸變要遠大于傳統鏡頭以補償DOE的投影光學畸變

圖15. (a)實拍iPhone激光雷達散斑 (b)安思疆自研SimuLight 2.0仿真引擎設計結果 (c)SimuLight 2.0仿真引擎光學畸變校正后的結果,其中第1、5、9、……、41、45行1組,第2、6、……、42、46行1組,第3、7、……、43、47行1組,第4、8、……、44、48行1組,四組分時點亮形成掃描。

以上討論了SPAD芯片是如何配合測量系統工作的,總結一下就是144個TDC能同時對應144個超像素,144個超像素對應144個激光散斑,分4次掃描,就可以得到144*4=576個激光散斑對應的距離。那么問題又來了,由于同一時間只會有144個超像素在工作,剩余的432個超像素是不工作的,如果這時候激光散斑沒有落入正在工作的超像素上,那就無法測量,因此必須要為此設計一套精密的光學投影及成像系統,保證VCSEL發射的激光散斑能準確的落入正在工作中的超像素內。

蘋果采用了與結構光類似的發射和接收方案設計,在發射端采用了可尋址的VCSEL,分成4組,每組16個激光點會同時亮,然后通過Collimator準直和放大,接著經過DOE 3x3復制再擴大后,投射出144個激光散斑,經過場景的反射之后由接收端的imaging lens精準地成像在對應的超像素之內,以便完成測量。但此處有個非常棘手的問題,DOE的衍射由于滿足的是正弦方程,當投影角度變大時會導致散斑發生顯著畸變,這在3D結構光中是允許存在的,可以通過算法校正,但是在spot dToF Lidar中是不可行的,因為sensor上超像素的排列必須是規則的,如果散斑的排布發生畸變,則會導致視野邊緣的散斑落入非工作的超像素內,進而測量無效,這是絕對不允許的。

為了解決DOE帶來的光學畸變問題,蘋果將imaging lens的光學畸變也設計得非常大,如圖14和15所示,做了很大的反畸變來補償DOE的正畸變以達到校正畸變的目的,并且由于引入如此大的光學畸變,還必須要在后處理的算法中對得到的三維點云再次進行校正以消除imaging lens的畸變。這一設計是非常罕見的做法,因為降低并消除光學畸變是幾乎所有成像鏡頭設計的基本追求,但在蘋果的lidar系統中不這樣做又不行,實際上這種“反其道而行之”的設計是該光學系統中最難設計的一部分。這樣的復雜系統也導致了各器件之間的耦合度到達了前所未有的程度,任何一個器件的某一參數改變,都會帶來其他器件的隨之更改,否則將會直接導致整個系統不工作。

在系統設計上還剩下最后一個關于超像素的問題,實際是兩個,一方面由于發射和接收采用的是非同軸設計,會產生視差,因此必須要綜合考慮使用距離、模組尺寸、單元像素大小、組裝誤差等眾多因素,才能最終確定超像素的子單元像素的數量,在蘋果方案中此數量大概是50個。另一方面,散斑在SPAD陣列上成像的大小一般只占據超像素其中的幾個單元像素,例如9個,但如果把整個超像素的探測深度都定義為同一個深度的話,就會大大降低其空間的橫向分辨率,即XY方向的分辨率(假設深度是Z方向)。舉個簡單例子,這可能會導致最終完全分辨不清手指和整個手,如此低的分辨率是不能接受的,為了解決這一問題,蘋果在每個超像素中還劃分了更細的像素組合,我們可以把它叫做超細像素,這些超細像素會在測量周期的前段進行掃描,從而準確定位散斑在超像素中的位置,接著再進行全面的測量。這一過程也是十分復雜的,又大大增加了SPAD陣列的設計難度,此處不再贅述。

到此為止,還差最后一個問題就能說完了,雖然這個問題只占一個環節,但卻占一半的重要性,那就是配套這個系統的算法。按照上述的方案,如果所有器件都完美地協同工作,我們就能得到576=24*24分辨率的精確深度圖,但相信大家都能看出問題,那就是分辨率太稀疏,完全沒有發揮SPAD陣列30000=150*200分辨率的能力。這就需要通過軟件來補齊最后的這一短板,蘋果應用了當前AI&機器視覺領域最前沿的研究成果,利用主攝單目RGB生成稠密但不準確的深度,利用Spot dToF生成稀疏但準確的深度,最后利用神經網絡引擎將兩者進行算法融合,得到一幅既稠密又準確的深度圖,也就是我們在手機上最終看到的效果。當然這一過程并不像此處所講的這么簡單,也需要龐大的工程量,安思疆也是經過了2年的研究才有成果。

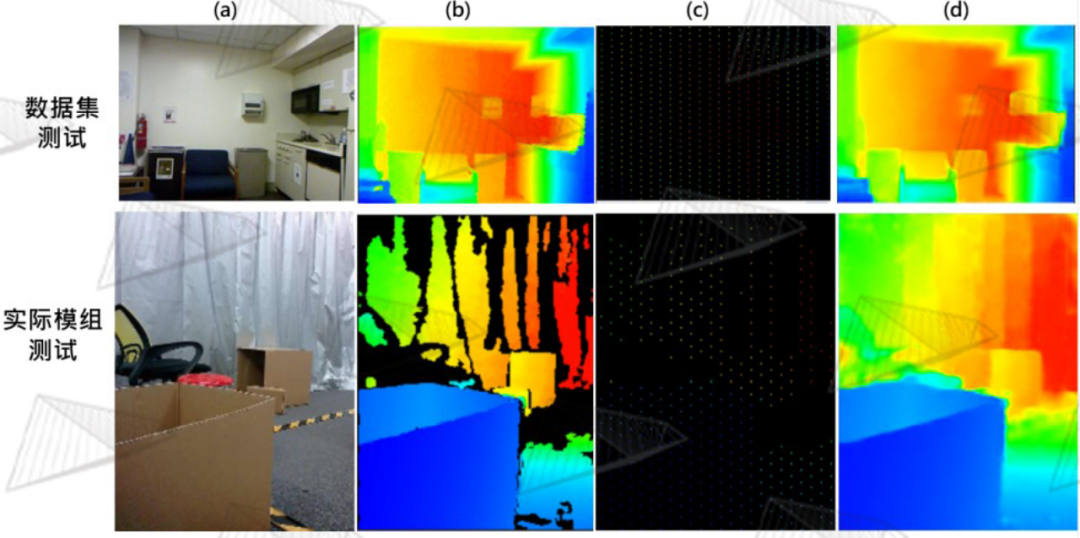

圖16. (a)主攝2D彩色圖像?(b)Lidar正常工作時生成的深度圖,不同顏色代表不同的距離?(c)只遮擋Lidar Scanner (d)只遮擋主攝像頭

如圖16所示,iPhone的Lidar Scanner實際上還結合了它左邊的主攝像頭,兩者正常協同工作時,才能得到深度準確且輪廓清晰的深度圖,如(b)所示;當單獨遮住Lidar Scanner時,如圖(c)所示輪廓依然清晰,但此時顏色發生很大變化,說明深度不準確;當單獨遮擋主攝像頭時,如圖(d)所示顏色雖然準確,也即深度雖然準確,但是輪廓細節已經丟失,即當Lidar單獨工作時就會出現前面所述的深度太稀疏的缺陷。以上情況充分說明,只有當主攝像頭、Lidar scanner、AI深度融合算法同時工作時,才能得到理想的結果。蘋果在這里使用的算法叫“Sparse-to-Dense”,稀疏轉稠密算法,這是當前AI視覺領域最前沿的課題之一。安思疆對此也進行了深入研究,同樣取得了理想結果。

圖17. (a)2D彩色圖像 (b)Ground truth (c)稀疏深度 (d)融合后的深度

通過安思疆現有的高精度模組可獲取大量高質量的3D數據,帶來了極大便利,在此基礎上采用了一種有監督的深度學習算法,得到高質量的深度融合模型。如圖17所示,我們分別在公開數據集和實際模組中對自研的融合算法進行了測試,可以看到很理想的效果呈現。 蘋果Spot dToF激光雷達的解析到這里就基本結束了,因為采用了如此復雜的設計,這顆激光雷達的生產組裝也異常復雜,由韓國LG最先進的工廠為其代工。

一顆小小的激光雷達,其中蘊含了如此多的黑科技,即便復制都很難,其背后的研發投入必定是巨大的,這也是其產品定價的底氣所在。難,才是價值所在,安思疆立志與產業界一道攻堅克難。

寫作此文的目的是為了讓更多的從業者深入了解這一有深遠意義的dToF技術與產品,我們不僅要做好,還要做得更好!

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論