VPoA是由慣性傳感器和面部識別應用程序捕獲的頭部運動的俯仰、偏航和滾動角度推斷出來的。該系統還包括一個基于平板電腦的應用程序,該系統自動收集來自駕駛環境的數據,例如,速度和位置。它還使注釋器能夠觀察到的駕駛員行為,例如與乘客的交互。我們對15名年輕人和15名老年人進行了一項自然研究,以證明該系統在識別視覺行為模式方面的功效,這些模式與以前使用傳統數據收集方法的研究中所確定的模式相似。一個新的發現是,如果有乘客在場,年輕組比老年組更頻繁地看腿部。腿部是與使用手機相關的VPoA。

I.引言

誘發視覺分心的次要工作是導致駕駛者撞車的主要原因,與他們的年齡無關。視覺分心是一種注意力不集中,被定義為由于執行次要活動而導致的視線偏離,導致視線偏離道路。了解隨著年齡的增長,視覺和注意力行為的變化如何影響駕駛,仍然是醫學、工程和社會科學等相關領域研究界的一個課題。研究視覺行為有助于確定進一步改進技術的領域,例如開發需要低量工作負荷的信息娛樂系統和在自動駕駛期間吸引視覺注意力的警報系統。然而,很少有人關注使用智能傳感技術來收集駕駛員的視覺注意力以進行此類研究。 ? 觀察性研究主要使用攝像機和眼球追蹤器來收集數據,這涉及到人類觀察員對視頻數據進行編碼以識別視覺干擾。例如,通過分析一周內從 70 名不同年齡的司機拍攝的視頻記錄,可以確定,與視線向車外看相比,車內的分心與視線向車內看的增加更相關。

同樣地,一項對148名青少年和老年人進行的基于視頻的觀察研究顯示,使用基于車輛的警告反饋系統并不會對進行次要工作的可能性有顯著影響作用。最后,最近一項大規模自然研究的結果顯示,與中年司機相比,做次要工作對30歲以下和65歲以上的司機來說,風險一直較高。研究還顯示,老司機做次要工作的頻率遠遠低于年輕司機。在上述作品中,編碼是識別駕駛員與次要工作相關的視覺行為的一項基本任務。編碼被認為是一項要求很高的任務,可能需要一個以上的訓練有素的分析員來減少花費的時間和人為錯誤。該項目旨在開發一個有利于在自然研究中收集數據的傳感系統,以了解司機的視覺行為。它支持實時收集司機的視覺注意點(VPoAs)和與駕駛環境相關的數據,如速度和道路類型。

該傳感方法基于兩個前提: ? 1)頭部姿勢是預測駕駛員意圖一個很好的指標,也是估算眼球注視的一個很好的代表。心理學家已經證明,頭部運動與掃描信息的目光變化的關聯并不限于大范圍的目光變化; ?

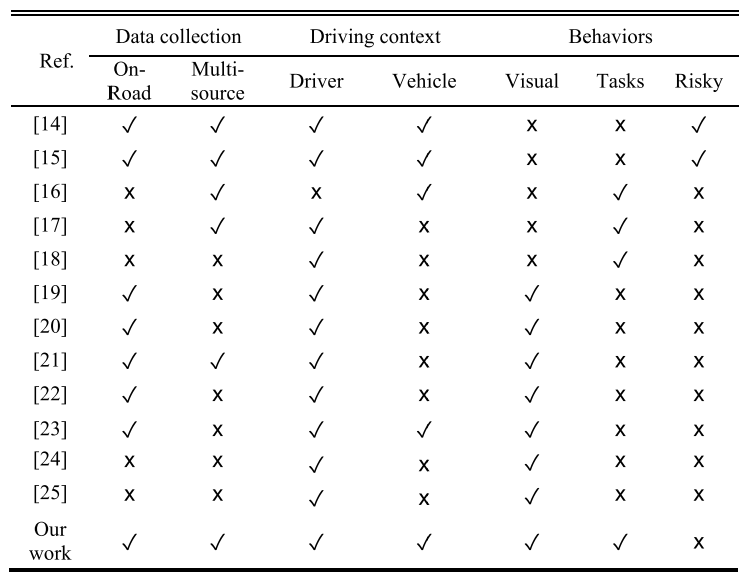

表1?擬用平臺來感知司機的行為數據 ? 此外,頭部運動與任務性能有關。也就是說,當提取信息的任務更加困難時,頭部的移動會增加,這在年輕的讀者(6-10歲的兒童)中很明顯。同樣地,在駕駛環境中,向特定區域掃視的發生和持續時間取決于任務的復雜性。 ? 2)視覺注意點(VPoA)是主要和次要活動的適當提示。它是車輛駕駛艙內的一個區域,駕駛員由于注意力轉移而調整頭部方向。例如,主要任務可能包括查看側后視鏡和窗戶區域。而次要任務可能是低頭使用手機或與廣播、乘客互動。 ?

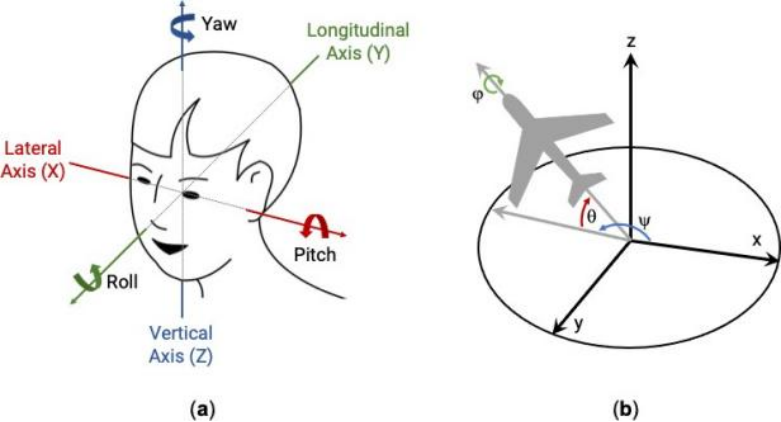

本文提出了一個智能多源傳感系統,它結合了一個單一的可穿戴的慣性傳感器和一個手機攝像頭來收集頭部的俯仰、偏航和滾動角度。該系統的智能在于其通過k-NN算法從這些角度進行VPoA,該算法是一種監督式機器學習技術。該系統還包括一個平板電腦應用程序,用于自動收集駕駛環境數據,如速度,以及由人工注釋者輸入的數據,如在紅色交通燈前停車。

本文的貢獻在于: ? ?一個多源傳感系統,與僅有攝像頭的方法相比,能提供最高的VPoA預測精度,并包括便于收集駕駛環境數據的組件; ? ?對基于k-NN的單個模型進行驗證和實時測試,以便從駕駛員的偏航、俯仰和滾動頭部運動中推斷出VPoA; ? ?一項自然研究證明該系統在識別年輕人和老年人的視覺行為模式方面的有效性,類似于以前使用傳統數據收集方法的研究中所識別的模式; ? ?發現掃視次數與有/無乘客駕駛之間的新關系,包括發現年齡組之間的顯著差異。 ? 本文的其余部分介紹了相關工作(第二節)、理論背景(第三節)、系統功能(第四節)、系統推理模型的評估(第五節)、為證明系統功效而進行的研究方法(第六節)及其結果(第七節),最后是我們的結論(第八節)。

? II.相關工作

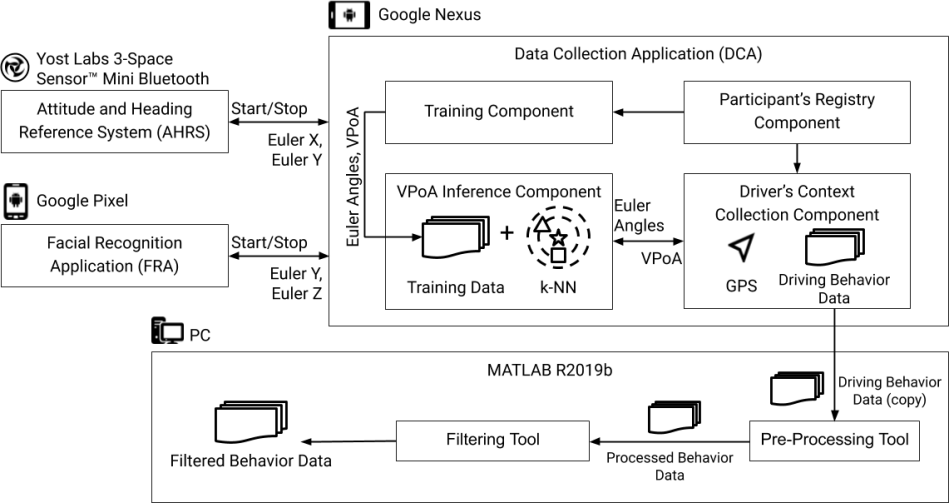

已經提出了幾個傳感平臺(見表一)來檢測分心行為,分類為視覺行為、次要任務和危險駕駛。其中一些平臺支持感知與推斷分心有關的駕駛環境,并了解分心發生的背景。駕駛環境包括以下數據:i)車輛動態,如速度、位置、剎車、車道位置和轉向角度;ii)駕駛員動態,如頭部姿勢、身體姿勢、眼球運動和生物信號。 ?

參考文獻[14]提出了一個基于云的傳感架構,通過智能手機的傳感器收集和存儲駕駛數據。其目的是促進駕駛環境數據的收集,以生成出行的統計報告,幫助第三方,如開發人員,識別危險情況。它利用攝像頭來跟蹤和存儲司機的頭部旋轉/傾斜角度、眼球的比率和嘴巴的張開程度。它還使用GPS和IMU傳感器來確定速度、加速度,并使用一個麥克風來記錄噪音水平。參考文獻[15]提出了一個自動模糊集優化的框架,該框架從通過多種來源獲得的兩類背景數據中估計危險駕駛的強度。具體來說,它使用攝像頭、慣性測量單元和車載診斷儀來收集基于動態車輛的駕駛環境,如速度、車道偏離和車道坡度。另外,通過智能腕帶和心率監測傳感器,可以識別駕駛員的情況,如情緒。

一個模擬各種道路場景的實驗表明,結合兩種類型的環境使框架比只使用一種環境更有利地運作。 ? 其他工作探討了推斷次要任務的感應方法和算法。例如,在文獻[16]中,通過使用隨機森林(RF)算法,輸入駕駛模擬器獲得的車輛動態數據,如轉向角和速度,推斷出發短信的準確率為85.38%,吃東西的準確率為81.26% 在[17]中,兩個可穿戴的慣性測量單元(IMU)被用來量化司機的軀干和手腕運動,通過使用卷積神經網絡(CNN)檢測五個次要任務,準確率為87%。推斷出的活動包括喝水、發短信、打手機、使用觸摸屏和把記號筆放在杯架上。由于實驗是使用駕駛模擬器進行的,因此推斷結果并未反映車輛運動對 IMU 測量的影響。

由于最不明顯的任務是用手機交談,作者開發了一種基于圖像的方法,它結合了一個用于物體檢測的深度神經網絡和一個多層感知器,從耳朵和手的相關區域推斷出司機的狀態,其準確率為59%。 ? 其他工作也探索了不同的傳感方法和推理方法來識別視覺注意力(見表二)。例如,在[19]中,作者探索了幾何方法,如受限局部模型、象形結構模型、正字法和縮放技術(POS),以從面部特征生成的三維頭部模型中識別俯仰、偏航和滾動。通過在自然駕駛過程中收集的數據集,所提出的方法可以在 96% 的時間內可靠地跟蹤頭部運動,而俯仰角是最難確定的角度,因為它比偏航和滾動呈現更多的誤差。 ? 與我們的工作類似,一些研究集中于從頭部方向的角度推斷出視覺注意力的區域。

參考文獻 [20] 提出了一種基于幾何的新方法來實時檢測視線偏離道路 (EOR)。它通過對安裝在方向盤柱子上的攝像頭捕捉到的面部特征進行3-D幾何分析,估計頭部姿勢和視線注視。在測試參與者將目光投向車輛擋風玻璃和駕駛室的18個區域的情景時,它達到了90%以上的EOR準確性。參考文獻[21]提出了一個頭部跟蹤系統,該系統使用兩個前置攝像頭來捕捉頭部姿勢的靜態特征(俯仰、偏航、滾動、面部中心和嘴部區域)和頭部動態特征(平均角速度)。通過隨機森林(RF)分類器,作者確定,與只使用靜態特征(85.7%)相比,結合頭部姿勢動態特征,可以提供更好的性能(93%)來識別車輛駕艙內的7個區域。在 [22] 中,Choi 等人探索了用于虹膜跟蹤的 Haar 特征人臉檢測器和 MOSSE 過濾器。

之后,卷積神經網絡 (CNN) 將圖像分類為九個不同的凝視區域,準確率達到 95%。結果發現,推斷駕駛員傾向于改變眼睛方向而不是頭部的區域(例如后視鏡),錯誤率最高。在[23]中,提出了一個基于深度神經網絡(DNN)的注視檢測系統來估計多達8個注視區。用相機收集的頭部姿勢角度和眼部標記,被輸入到DNN中。作者收集了道路上的數據,以證明該模型的通用性,并采用了省略一個司機的交叉驗證技術。獲得的準確率為86.5%。他們還分析了包括指示司機正在看哪里的車輛信號的可行性,這將準確率提高到92.3%。

然而,作者沒有具體說明可以使用什么類型的車內傳感器。在[24]中提出了減少當收集大型數據集來訓練一個推斷視覺注意力的模型時注釋工作的建議。為此,轉移學習方法與預先訓練好的CNN模型一起使用,通過在移動設備上回歸來進行注視評估任務。為了驗證這一方法,從模擬環境中用手機攝像頭拍攝的圖像中提取出的駕駛員面部和眼部特征推斷出10個駕駛員注視區。獲得的準確率為60.25%。然而,這項研究缺乏實時測試和使用額外的傳感器來收集可用作基本事實的可靠數據集。 ?

表2?提出的檢測駕駛員視覺行為的方法 ? 參考文獻[25]提出了一種基于外觀的頭部無姿勢的眼睛注視預測方法,用于駕駛員注意力區域的估計。作者應用隨機森林技術將從數據庫中獲得的頭部矢量和眼睛圖像分類為 18 個駕駛員的注視區域。整體準確率為92.61%,預測部分擋風玻璃區域的準確率最低。如表二所示,基于攝像頭的技術提供了高精確度的結果; 然而,當司機的臉被遮擋、大幅旋轉或光照變化時,它們不夠可靠。使用IMU可以克服攝像機系統持續跟蹤頭部姿勢的局限性,反之亦然。正如下一節所解釋的,這些技術中的每一項都可以抵消另一項的局限性。因此,我們提出了一種結合IMU和攝像頭的新方法,形成了一個實用的傳感系統,它能捕捉可靠的頭部方向角度,以預測司機的視覺注意點(VPoA),其準確度高于其他系統。 ?

III.VPOA感知和推斷方法

A.頭部方位多源傳感

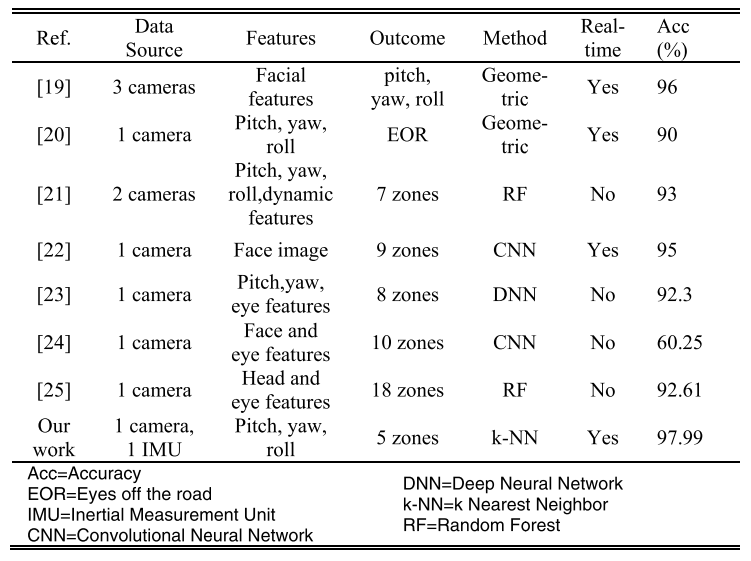

人的頭部方向是用俯仰、滾動和偏航運動來描述的,這些運動分別在其緯線(X)、縱線(Y)和垂直(Z)軸上進行(見圖1a)。這些軸與通常稱為 X、Y 和 Z 軸的參考系進行比較,以定義頭部方向。歐拉角被用來量化這種比較,因為它們表達了一個關于固定坐標系的硬性方向。如圖 1.b 所示,θ 是俯仰角或歐拉 X,φ 是滾動角或歐拉 Y,ψ 是偏航角或歐拉 Z。為了量化頭部三個自由度的方向,我們建議在司機的頭部安裝一個IMU傳感器,在方向盤上安裝一個前置攝像頭。每種方法都有以下優點和局限性。 ? 正如 Tawari 和 Trivedi (2014)所確定的,偏航角 (Euler Z) 是最相關的推斷角度,因為駕駛員在關鍵時刻(例如車道變換和右/左轉)容易做出較大的頭部運動。? ?

圖1 身體的定向系統:a)軸和旋轉運動。b) 相對于地球的歐拉角。 ? 然而,當使用基于攝像頭的系統時,自動閉合阻礙了面部特征的可見性,影響了對頭部方向的估計,特別是在俯仰方面。根據一項報道,計算機視覺(CV)技術在跟蹤駕駛員頭部的偏航和滾動角度時比在俯仰角度時更準確。因此,目前的CV開放存取庫提供了可靠的偏航和滾動測量,但在檢測俯仰角(歐拉X)方面受到限制。

? 另一方面,IMU 可以有效地估計駕駛員的俯仰和滾動,但由于它使用地球作為參考系,因此無法提供對偏航角 (Euler Z) 的準確估計。因此,即使司機沒有大幅移動他/她的頭部,車輛的左轉和右轉也會影響頭部方向在其垂直Z軸(偏航)上的估計。為了彌補現有CV技術的局限性,我們在駕駛員的頭上安裝了一個IMU裝置,它能提供可靠的俯仰和滾動估計。 ? 因此,我們使用多源檢測方法來捕捉司機的頭部方向特征,以與俯仰、偏航和滾動有關的歐拉角給出。

? B.個體化推斷法 ? 我們使用K-NN算法(k-NN)來建立由頭部運動產生的歐拉角和觀察到的VPoA之間的關系。k-NN可以很容易地實現個性化,因為它的訓練階段包括收集和存儲一組訓練樣本和相應的類標簽。同時,其他技術需要收集訓練樣本并進行訓練階段,以生成映射函數或推理模型。

? 由于不同的因素可能會影響看VPoA所需的頭部移動量,如司機的身高、駕駛風格或視覺處理速度,而視覺處理速度會隨著年齡的增長而受到影響,我們決定在我們的傳感平臺中加入個性化的推理模型。k-NN的個性化為我們的傳感平臺提供了優勢,可以輕松配置,對不同人群進行研究。此外,k-NN 是一種易于實現的機器學習 (ML) 方法,在我們之前的研究 [31] 中表現出高性能,該研究將一組分類器與在受控駕駛條件下收集的數據進行了比較。相比之下,在目前的工作中,我們評估 k-NN 以實現 VPoA 的實時推斷。 ?

圖2 通過傳感系統檢測到的VPoA ?

圖3 通過傳感系統檢測到的VPoA ? C.視覺注意點 (VPoA) ? 本研究確定了車輛駕駛艙的五個區域(見圖2),與執行主要和次要任務有關。道路被視為主要的VPoA,因為它是司機通勤時關注的主要焦點。左邊和右邊的VPoA用于監控后視鏡。當司機與前座乘客進行視覺互動時,也使用右邊的VPoA。無線電/溫度和腿部 VPoA大多與更換收音機和用手機閱讀/發短信分別有關。

IV.系統的設計和實施

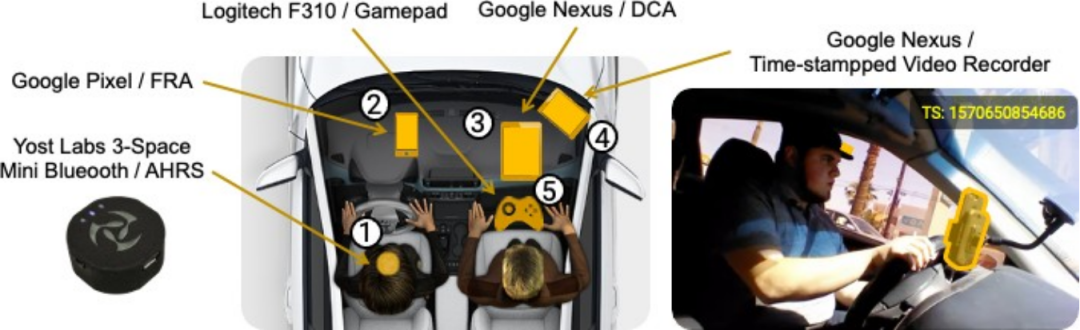

如圖 3 所示,系統架構包括三個子系統,托管在專用硬件上,用于在自然研究期間收集數據: 數據收集應用(DCA)、姿態和航向參考系統(AHRS)和面部識別應用(FRA),它們通過藍牙進行通信。它還包括MATLAB應用程序,用于處理所收集的數據,以便進行后期分析。

A.姿態和頭部參考系統 (AHRS)

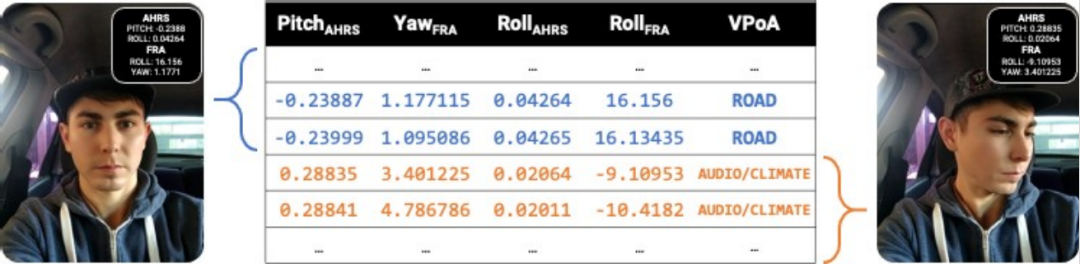

AHRS安裝在駕駛員的頭上,為DCA提供俯仰AHRS(歐拉X)和滾動AHRS(歐拉Y)的角度。它由 IMU 傳感器組成,即陀螺儀、加速度計和指南針。AHRS是Yost實驗室的3空間傳感器迷你藍牙,它包括一個專有的過濾算法(QGRAD2)來估計俯仰和滾動。它的尺寸為 30 毫米 x 30 毫米 x 13 毫米,重 9 克,電池續航時間為 4 小時。

圖4 DCA的用戶界面,用于收集:(a)參與者信息。(b)訓練數據;(c),(d)駕駛環境,以及(e)標記的數據,以驗證VPoA推理組件

B.人臉識別應用 (FRA)

FRA組件為DCA提供駕駛員頭部的滾動FRA(歐拉Y)和偏航FRA(歐拉Z)值。FRA是在Android Studio v3.5和API 16(Jelly Bean)上開發的,并部署在谷歌Pixel手機上,該手機必須放置在司機面前,攝像頭對準他們。FRA 使用 CameraView v2.6.1來捕獲和處理視頻流幀,并使用 SDK ML Kit for Firebase通過計算機視覺 (CV) 技術估計頭部方向。這個SDK允許FRA通過處理一組與臉部橢圓(1個特征)、眼睛(2個特征)、眉毛(4個特征)、嘴唇(4個特征)和鼻子(2個特征)相關的面部特征,以歐拉角的方式提取給定視頻幀上的頭部方向。

C.數據收集應用 (DCA)

DCA是主要的子系統,旨在從AHRS和FRA組件收集數據。它是使用 API 19 (Kit Kat) 在 Android Studio v3.5 上開發的移動應用程序,并在 Google Nexus 平板電腦上執行。由于k-NN需要訪問一組訓練樣本來對輸入數據進行實時分類,我們定義了兩種收集數據的模式: 訓練模式和駕駛行為模式。因此,根據所選擇的模式,不同的DCA的組件被激活。

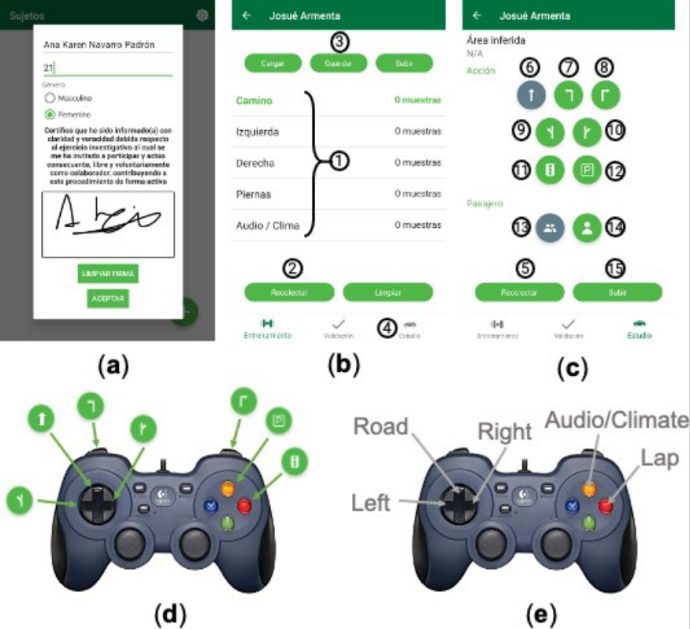

在訓練模式下,DCA被用來創建k-NN算法所需的訓練數據集,以推斷出駕駛過程中的VPoA。在這種模式下,研究的注釋者應該打開DCA應用程序的圖形用戶界面(GUI)來收集和標記數據。首先,他/她將看到參與者注冊組件的圖形用戶界面,選擇以前注冊的參與者或注冊一個新的參與者(見圖4a)。然后,呈現訓練組件的 GUI(見圖 4b),使注釋器能夠開始收集數據。

圖5 收集的圖元作為訓練數據

注釋者應首先從列表(1)中選擇一個VPoA,并要求參與者在特定的時間內將頭部對準它。注釋者點擊 "收集 "按鈕(2),從AHRS和FRA組件收集報告。因此,包含俯仰AHRS、滾動AHRS、滾動FRA、偏航FRA和注釋者指定的VPoA標簽的數據元組被存儲起來(見圖5)。若要停止收集它們,注釋者應再次點擊 "收集 "按鈕。上述過程需要對每個VPoA進行重復。為了完成數據收集過程,注釋者應保存(3)數據以生成訓練數據文件。之后,呈現下一個屏幕(4),啟動駕駛行為模式。

在駕駛行為模式下,DCA實時推斷駕駛員的VPoA(即在駕駛過程中)并收集駕駛環境數據。為了達到這個目的,注釋者應該使用圖4c所示的圖形用戶界面。通過點擊 "收集 "按鈕(5),駕駛環境數據收集組件開始收集來自AHRS和FRA組件的報告,并發送給VPoA推理組件。它通過使用訓練數據文件的 k-NN 算法將傳感器的報告分類為 VPoA。駕駛環境收集組件接收每個推斷出的VPoA,同時獲得駕駛環境數據,即來自GPS的車輛速度、緯度和經度。在駕駛過程中,注釋者可以通過在GUI中選擇相應的圖標來表明駕駛員是否進行了以下動作(見圖4c): 直線行駛(6),右轉(7)和左轉(8),換線(9,10),停在交通紅燈上(11),停車(12),與乘客(13)或不與乘客(14)進行視覺互動。我們還用一個羅技游戲手柄F310擴展了這個圖形用戶界面,它通過USB On-The-Go連接到谷歌Nexus平板電腦上,可以選擇用來標記收集的數據(見圖4d)。在上述DCA的組成部分中產生的數據按其各自的時間戳進行索引,并以CSV格式存儲在駕駛行為數據文件中。注釋者通過再次按下 "收集 "按鈕來結束駕駛環節(5),然后(15)將駕駛行為數據文件上傳到電腦上,供系統的MATLAB應用程序處理并準備進一步分析。

D.MATLAB 應用

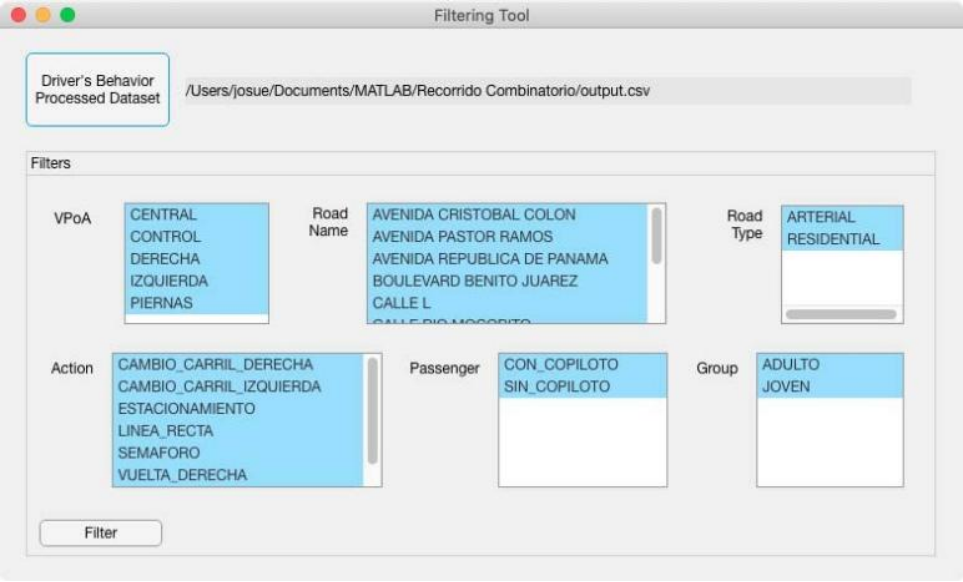

在駕駛過程中收集的數據(CSV格式的駕駛行為數據)應下載到電腦上,由以下用MATLAB R2019b的App Designer工具實現的應用程序來處理。

1)預處理工具: 它將經緯度坐標映射為道路名稱和類型,并將速度從m/s轉換為km/h單位(數據整理)。?

圖6 過濾工具的用戶界面

該應用程序更正了 VPoA 列以進行數據清理,以解決推理期間的錯誤分類。它使用時間戳檢查連續檢測到 VPoA 少于 0.1 秒的時間窗口。然后,它將VPoA改為以前被認為是正確分類的VPoA。該工具的輸出是CSV格式的加工行為數據文件,研究人員可以按照接下來的規定進行過濾。

2)過濾工具: 它提供了圖6所示的圖形用戶界面,使研究人員能夠選擇條件來過濾視覺行為數據。例如,如果選擇了一個特定的道路類型,該工具會顯示參與者對該條件下的每個VPoA的注視數量和固定時間。輸出的是CSV格式的過濾行為數據文件。

V.推理模型性能

在使用該系統對司機的視覺行為進行自然研究之前,我們評估了該系統的推理模型的性能。為了實現這一目標,我們招募了4名志愿者,他們的年齡從22歲到25歲不等,平均有5.25年的駕駛經驗(SD=1.08),他們用自己的汽車參與了以下評估階段。

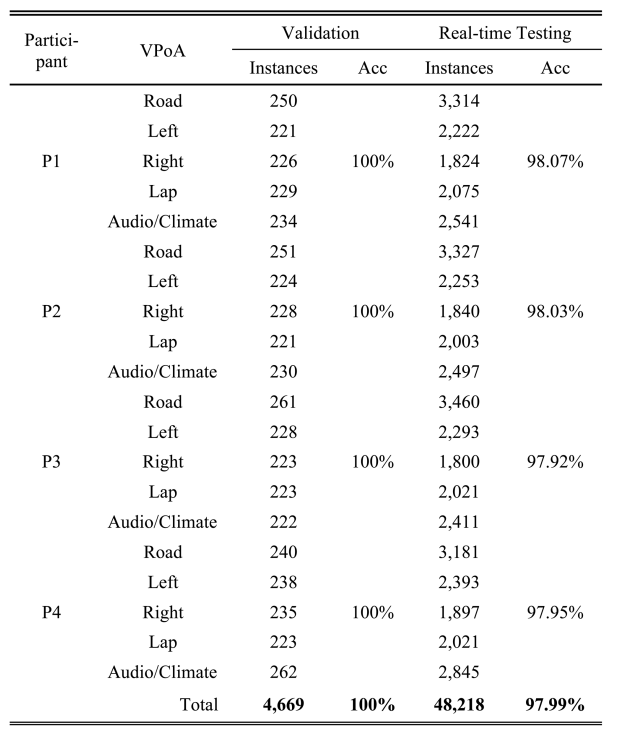

A.驗證

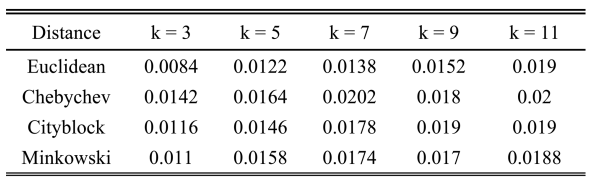

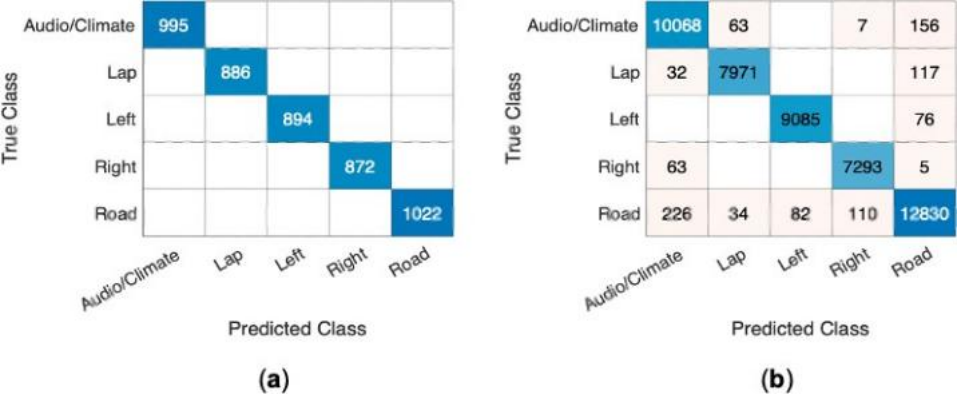

這個階段的目的是用單獨的訓練數據集(每個參與者一個)來驗證k-NN算法,這些數據集的收集不受車輛運動的影響。在訓練模式下,使用系統收集每個參與者的訓練數據集,采樣率設置為50赫茲,車輛停放。因此,我們能夠要求他們將頭部朝向每個 VPoA 大約 5 秒,這使得每個 VPoA 類收集 M=233.45 (SD=12.70) 個元組,如表 III 所示。對于在此階段進行的所有實驗,我們使用了 10 倍交叉驗證技術。我們使用完整的數據集(4,669個樣本)來尋找k的最佳值(k=3),這是用歐氏距離參數得到的,因為它產生的錯誤率最小(見表四);在之前的工作中也發現了類似的結果 。每個參與者的訓練數據集的分類準確率為100%,這意味著實例在同一類別內非常相似,而在不同類別之間則有足夠的差異,從而被錯誤分類(見圖7a)。

B.實時檢測

下一步是確定每個參與者生成的k-NN推理模型對來自傳感。

表3 數據集的規模和推斷的準確性 (ACC)

表4 每個距離度量和K參數對的分類損失

圖7 混淆矩陣顯示了數據集測試和實時驗證過程中正確和不正確分類的實例(a)和(b)

器的新的和未見過的樣本進行分類的準確性,這些樣本與我們的自然研究中收集的樣本相似。為了這個目的,參與者在駕駛行為模式下與系統進行了駕駛訓練,實時推斷VPoA。采樣頻率被設定為50赫茲。駕駛環節是在半控制的條件下進行的,以收集可靠的地面真實數據,同時保護參與者的安全。他們在一個空曠的停車場大約行駛了5分鐘,最高時速為20公里,由第一作者陪同進行指導。參與者能夠自由地將汽車轉到左邊和右邊。我們要求他們將頭朝向每個VPoA的方向,最多重復2秒鐘,直到該環節結束。

參與者通過羅技游戲手柄F310收集地面真實數據,即按下游戲手柄上對應VPoA的按鈕進行查看,當他們的注意力回到道路上時再按下按鈕(見圖4e)。因此,傳感器的樣本、推斷的VPoA和參與者輸入的標簽被收集起來,以估計推斷的準確性。在由48,218個樣本組成的數據集中,VPoA推理組件的準確率達到了97.99%(見表三)。混淆矩陣(見圖7b)顯示,除道路外,在左邊和其他VPoA之間,以及在右邊和左邊、右邊和腿部之間,從未發生過錯誤分類。這是因為這些區域之間有很大的物理隔離,所以分類器沒有將它們混淆。另一方面,大多數錯誤分類發生在相鄰的區域之間,如道路與其他每一個VPoA以及帶有音頻/溫度的右邊。

VI.方法

我們進行了一項自然研究,以證明該傳感系統在收集數據以識別駕駛視覺行為模式方面的功效。

研究表明,在正常的衰老過程中,所面臨的身體和認知的退化會改變司機的視覺行為模式,并影響安全駕駛的能力。由于這個原因,人們對分析不同年齡段的人在不同駕駛環境下的視覺注意力差異很感興趣。例如,與年輕司機(M=26.5 歲)相比,老年司機(M=67.5 歲)在交叉路口的掃描范圍較小。另外,從事次要任務會增加青少年(16-20歲)、青年(21-24歲)和老年司機(74歲)的撞車風險,而且對于所有年齡段的人來說,具有視覺-手動需求的任務比認知導向的任務更容易增加危險。以前的研究工作促使我們對老年人和年輕人進行研究。

A.目標和成果措施

自然主義研究的目的是分析老年人和年輕人的視覺行為及其與駕駛環境的關聯。我們定義了兩個因變量來衡量視覺行為: 每個 VPoA 的掃視次數及其注視時間; 以及與駕駛環境相關的四個自變量:道路類型(住宅或主干道)、車速、駕駛狀態(在直線車道上行駛或在紅燈處停車)以及前排座位上是否有乘客。

B.納入標準

參與者必須是活躍的司機,即經常開車并擁有有效的駕駛執照,年齡在18-29歲之間的人被列入最年輕的成人組,60歲或以上的人被列入最高年齡組。

圖8 車輛駕駛艙內的設備設置

圖9 參與者走過的路線:橙色為干線公路,藍色為居民區道路

他們都被要求有一輛車用于研究中使用。年輕的司機是來自我們大學系的學生志愿者。老年人通過在社交媒體上分發的小冊子和我們的聯系人進行招募,并獲得7美元的汽油費用補償。我校心理學系的倫理審查委員會批準了這項研究。所有參與者都通過簽署紙質表格和在參與者登記冊GUI上簽署口頭和書面同意(見圖4a)。

C.設備和駕駛場景

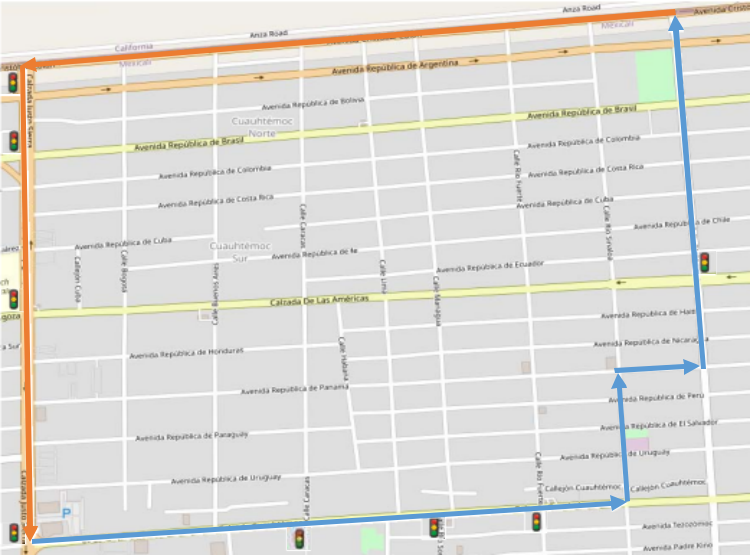

如圖8所示,參與者戴著一頂帽子,上面連接著AHRS系統(1)。將 Google Pixel 手機放在駕駛員面前進行人臉識別 (2)。注釋者使用谷歌Nexus平板電腦來登記司機的行動(3)。第二個平板電腦(4)也被安裝指向司機,用于記錄有時間戳的視頻,以后可以在數據分析時查閱。可以選擇使用游戲手柄來記錄駕駛員的動作(5)。駕駛路線包括住宅區(6公里)和干道(12公里)的道路(見圖9)。

D.程序和實驗設計

在訓練模式(車輛停放)下使用系統為每個參與者生成一個訓練數據文件。接下來,注釋者(第一作者)解釋了駕駛場景,并要求被試者以他/她通常的駕駛方式,在遵守國家交通法規的情況下,駕駛兩次賽道。這次駕駛的數據是使用駕駛行為模式的系統收集的。采集AHRS和FRA傳感器的讀數時,采樣率設定為50赫茲,而GPS的數據則以1赫茲采集。在第一圈,駕駛員被允許與坐在前排乘客座位上的注釋者保持閑聊。在第二圈中,注釋者在后座上,交流僅限于在忘記路線的情況下向駕駛員回憶。

表5?參與者的人口統計和駕駛特征

注釋者在GUI(如圖4c所示)中檢查司機的行動。該環節持續了40至60分鐘,取決于一天中的時間和交通情況。

E.數據分析

用描述性統計計算器對收集的數據進行分析。我們使用Tukey's fences來檢測離群值(k=1.5);通過t檢驗(兩個獨立的平均值,p=.05,雙尾)來確定組間視覺行為(因變量)的差異; Wilcoxon Signed-Rank Test ( p=.05, two-tailed)分析同組受試者中自變量對因變量的影響,Pearson積矩相關系數評估變量之間的關系( p= .05)。確定相關水平的標準是:0?|r|< 0.3為弱;0.3 |r|< 0.7為中等,|r|> 0.7為強。報告結果時采用APA風格。

VII.結果

A.參與者

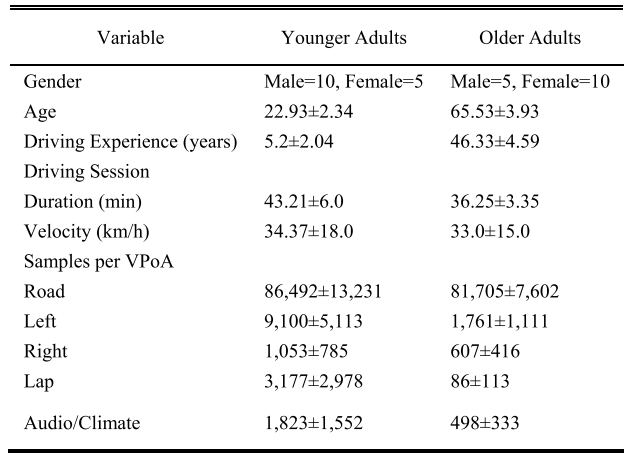

參與者是15名21-77歲的年輕成年人和15名60-73歲的老年人,他們的平均駕駛經驗分別為5.2年和47.33年。表五列出了其他參與者的特征和研究期間收集的數據信息。

B.各年齡組視覺行為的對比

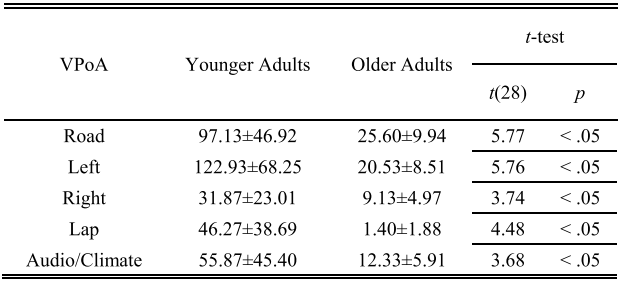

1)小組之間的注視次數: 根據獨立的t檢驗,我們發現在所有的VPoAs中,年輕的成人組在眼神數量上有顯著的差異(見表六)。我們將這一結果歸因于年輕司機(18-25歲)往往比老年人更多參與次要任務,包括使用手機和信息娛樂系統。

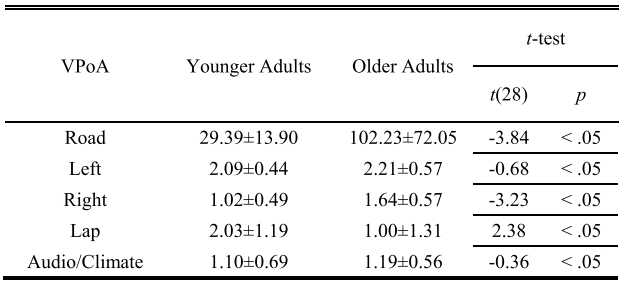

2)小組之間的注視持續時間: 由于老年人需要更多的時間來提取和處理信息,他們在道路、右邊、左邊和音頻/溫度區的凝視時間比年輕組更長(見表七)。從獨立t檢驗中,我們發現道路和右路的組間差異有顯著性; 以及左區和音頻/溫度區的非顯著性差異。從這些VPoA來看,左區不僅是觀看次數最多的區域,而且兩組的觀看時間都比較長。另一方面,年輕的成年人在腿部的注視時間要比年長的成年人長。該研究的視頻顯示,看腿部主要與手機閱讀/發短信有關。因此,我們的結果表明,老年人避免與低頭有關的次要活動(腿部和音頻/溫度)。根據其他研究,這些結果可能是由于這些VPoA需要更高的工作量或被認為是不相關的。研究發現,視線的固定時間取決于任務類型和任務的重要性,以及整體的工作負荷。例如,參考文獻 [45] 的研究發現,年長的駕駛員在完成請求的瀏覽任務時分配了更多的視覺注意力,并盯著目標信息超過 2 秒,而年輕的駕駛員實際上根本不再看一眼。

表6?基于對每個vpoa的注視次數的平均值和標準差的組間分析

表7 基于對每個 VPOA 的瀏覽持續時間(秒)的平均值和標準偏差的組間分析

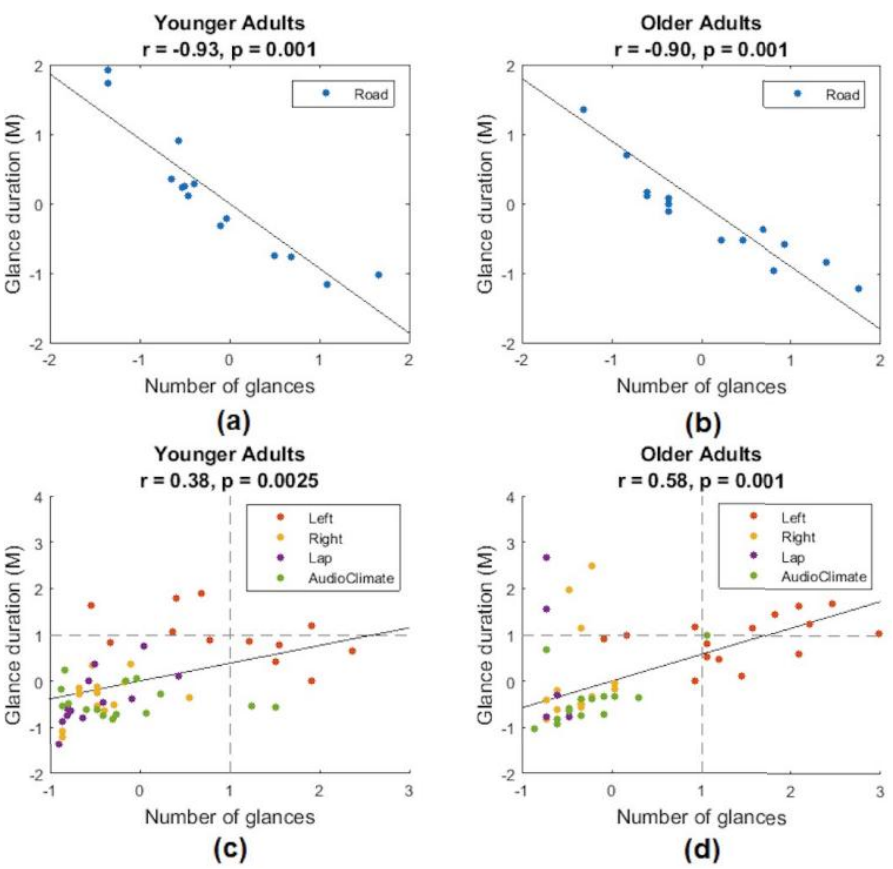

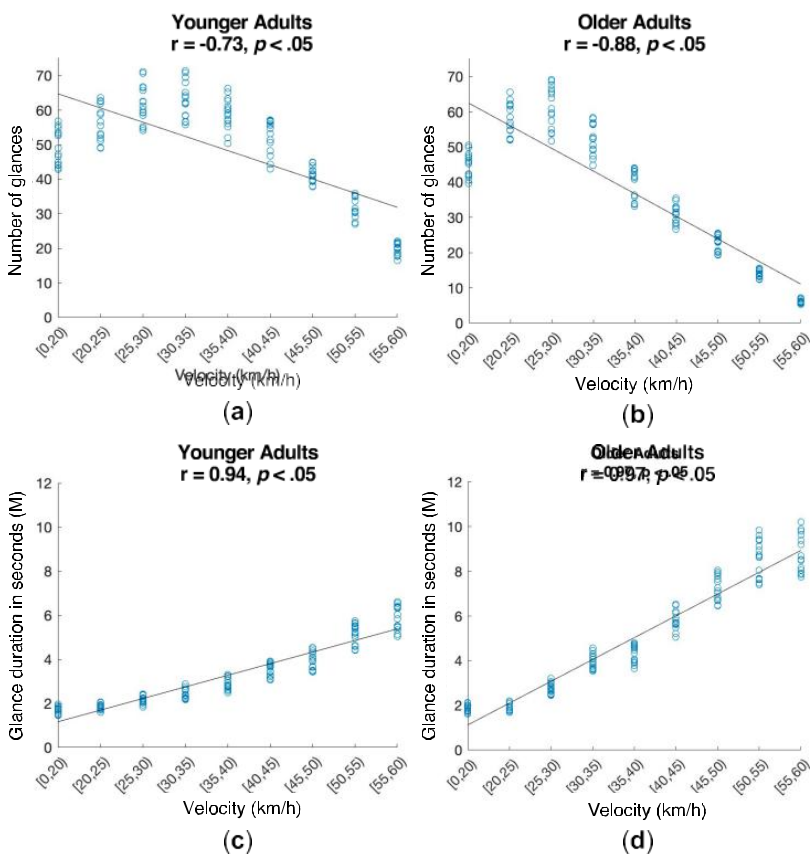

3)掃視次數與掃視持續時間的關系: 圖 10 的散點圖顯示了每個參與者對 VPoA 的標準化平均掃視持續時間和掃視次數。Pearson 皮爾遜相關的結果表明,對于年輕的成年人(r (13)=-.93, p <.05)和年長的成年人(r (13)=-.90, p <.05)來說,掃視的時間和掃視道路區域的次數之間存在著強烈的負相關(圖10a和b)。這些結果表明,觀察道路區域時間較長的司機往往觀察它的頻率較低。

圖10 (a) 年輕人和 (b) 老年人的掃視次數和掃視持續時間與道路的關系。年輕人 (c) 和 (d) 老年人的掃視次數與 VPoA 其余部分的關系。

反之亦然,那些更經常觀察這一領域的人則是以較短的目光來觀察。這種行為可以被解釋為一種補償機制,將足夠的視覺注意力分配給道路和其他VPoA。根據參考文獻[46],這種補償發生在執行次要任務時,因為如果任務更復雜,視覺要求更高,那么針對該任務的注視次數就會增加。同時,凝視的時間很短,經常持續不到2秒。

圖10c)和d)描述了參與者在其余VPoA中的視覺行為,即眼睛離開道路。皮爾遜相關的結果表明,對于年輕的成年人(r (13)=.38, p <.05)和年長的成年人(r (13)=.58, p <.05)來說,兩者的掃視持續時間和掃視次數之間存在中度關聯。老年人的散點圖(圖10d)似乎比年輕人的散點圖(圖10c)更分散,他們的視覺注意力管理形式類似。我們將這些結果歸因于老年人需要調整他們的視覺注意力管理以適應他們的認知和視覺技能,例如視敏度、信息處理能力和在兩個任務之間切換的能力。

C.視覺行為與駕駛環境的關系

圖11說明了速度是如何影響每組的視覺行為的。根據Pearson相關性,對于年輕的成年人(r (13)=-.73, p <.05)和年長的成年人(r (13)=-.88, p <.05)來說,瞥一眼的數量和速度之間存在著強烈的負相關(見7.2 a和b)。對于年輕人(r (13)=.94, p <.05 和老年人 (r (13)=.97, p=.05),平均掃視持續時間和速度呈正相關(見圖 12 c 和 d) )。因此,無論哪個年齡段,隨著速度的增加,

圖11 (a) 年輕人和 (b) 老年人對道路 VPoA 的速度和掃視次數之間的相關性;(c) 年輕人和 (d) 老年人的速度和掃視持續時間.

圖12 在(a)車輛行駛中和(b)在紅燈前停車時,有無乘客駕駛對掃視腿部的次數的影響;以及(c)在住宅和干道上駕駛對掃視的時間的影響

持續時間也會增加,但由于視覺注意力更集中在道路上,所以看的次數會減少。

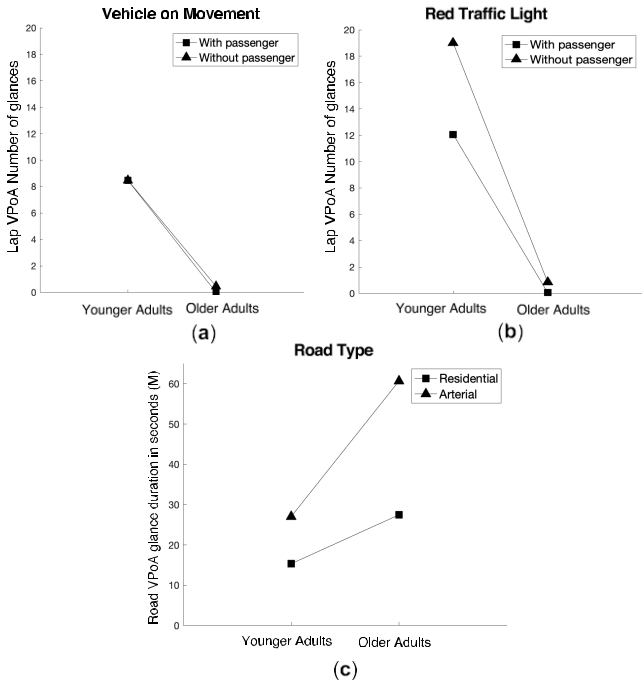

用電話交談或與乘客交談已被確定為誘發分心的次要任務。盡管已經研究了乘客如何影響年輕司機的手機使用,

表8?對道路VPOA的平均掃視時間(秒)

在不同道路類型上駕駛

但沒有研究量化司機對手機的視覺行為是如何受到乘客的影響的。因此,我們分析了在駕駛過程中,鄰座的乘客對腿部 的瀏覽次數的影響,這是一個與使用手機有關的VPoA。我們發現年輕組(M=17,SD=19.12)比老年組(M=0.46,SD= 0.74)更頻繁地看腿部(見圖12a),不管他們是否有乘客。根據獨立樣本t檢驗,有一個顯著的差異(t(28)=3.33, p <.05)。同樣地,在紅色交通燈下,老年人避免分心去看腿部。同時,Wilcoxon Signed-Rank測試表明,年輕的成年人對它的注視次數明顯增加(Z=-1.88,p <.05)(見圖12b)。我們的視頻觀察證實,他們主要使用手機發短信。

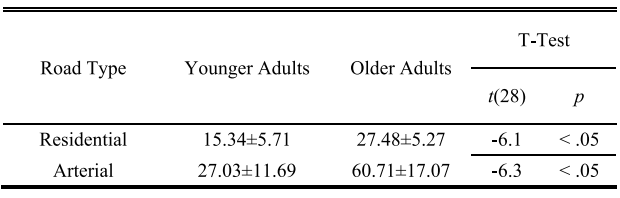

最后,我們的結果顯示,在居民區和干道上開車時,老年人注視道路的時間在統計學上比年輕人長(見表八和圖12c)。然而,所有參與者在干道上行駛時的凝視時間都比在住宅區時更長。從Wilcoxon Signed-Rank測試中,我們發現老年人(Z=-3.40,p <.05)和年輕組(Z=-3.40 p <.05)在道路類型之間的瞥視時間有顯著差異。由于允許在干道上的駕駛速度比在住宅試驗中更快,上述結果與圖11中的相關性有關。也就是說,隨著速度的增加,掃視道路的時間也延長了。

VIII.結論

本文提出了一種新的 IMU 和相機傳感器的使用和組合,以在其三個自由度上檢測頭部方向。我們的分類結果優于通過其他方法獲得的結果(見表二),我們將其歸因于傳感器的組合,以獲得可靠的頭部角度,包括那些代表觀察腿部和右VPoA所需的大型頭部運動。然而,我們需要進行更多的實驗來評估該模型推斷額外的VPoA的性能,并確定其在遮擋和各種光線條件下的效率。其他工作表明,當匯總一些相鄰的視覺區域或不考慮特定的擋風玻璃區域,如中心擋風玻璃時,準確性會增強。此外,由于我們的方法使用了個性化的訓練數據集,它取得了高準確率的結果。

該傳感系統的主要優勢在于,對不同的研究對象進行個性化的推斷模型是切實可行的。這個優勢是因為與基于深度學習的方法相比,使用 k-NN 是一種基于實例的學習類型,需要小的訓練數據集。我們計劃用其他近鄰技術進行實驗,如聚類k近鄰,以克服收集訓練樣本分布稍有不均的缺陷,這可以提高準確性。

本文的系統避免了對視頻數據進行編碼以識別視覺行為,使研究人員能夠分析駕駛模式 。因此,該系統有助于進行駕駛行為研究,因為它收集了與視覺行為和駕駛環境有關的高級數據。它的功效通過所進行的自然主義研究得到了證明,使我們能夠確定與以前使用傳統數據收集方法,即視頻觀察和編碼技術的研究中所報告的視覺行為模式相似。因此,我們的結論是,我們的方法能夠收集基本數據,以確定年輕司機和老年人之間視覺行為模式的一致差異。對于未來的工作,我們計劃使用該系統來分析不同的外部因素(例如,改變車道、一天中的時段或不同的交通密度)將如何影響司機的視覺行為。進行更多的研究將使我們能夠確定系統的設計特點,使其更加健全。

參考文獻:

[1] C. Siebe, “Distracted driving and risk of road crashes among novice andexperienced drivers,” J. Emergency Med., vol. 46, no. 4, pp. 600–601,Apr. 2014.?

[2] F. Guo et al., “The effects of age on crash risk associated with driverdistraction,” Int. J. Epidemiol., vol. 46, no. 1, pp. 258–265, Feb. 2017.?

[3] F. Zhang, S. Mehrotra, and S. C. Roberts, “Driving distractedwith friends: Effect of passengers and driver distraction on youngdrivers’ behavior,” Accident Anal. Prevention, vol. 132, Nov. 2019,Art. no. 105246.?

[4] D. L. Strayer et al., “Visual and cognitive demands of CarPlay, Androidauto, and five native infotainment systems,” Hum. Factors, J. Hum.Factors Ergonom. Soc., vol. 61, no. 8, pp. 1371–1386, Dec. 2019.?

[5] T. Louw and N. Merat, “Are you in the loop? Using gaze dispersion tounderstand driver visual attention during vehicle automation,” Transp.Res. C, Emerg. Technol., vol. 76, pp. 35–50, Mar. 2017.?

[6] J. Stutts et al., “Driver’s exposure to distractions in their natural drivingenvironment,” Accident Anal. Prevention, vol. 37, no. 6, pp. 1093–1101,Nov. 2005.?

[7] D. G. Kidd and M. L. Buonarosa, “Distracting behaviors amongteenagers and young, middle-aged, and older adult drivers when drivingwithout and with warnings from an integrated vehicle safety system,”J. Saf. Res., vol. 61, pp. 177–185, Jun. 2017.?

[8] J. F. Antin, F. Guo, Y. Fang, T. A. Dingus, J. M. Hankey, andM. A. Perez, “The influence of functional health on seniors’ drivingrisk,” J. Transp. Health, vol. 6, pp. 237–244, Sep. 2017.?

[9] R. D. Ray, J. M. Ray, D. A. Eckerman, L. M. Milkosky, and L. J. Gillins,“Operations analysis of behavioral observation procedures: A taxonomyfor modeling in an expert training system,” Behav. Res. Methods, vol. 43,no. 3, pp. 616–634, Sep. 2011.?

[10] R. E. Heyman, M. F. Lorber, J. M. Eddy, and T. V. West, “Behavioralobservation and coding,” in Handbook of Research Methods in Socialand Personality Psychology. Cambridge, U.K.: Cambridge Univ. Press,2014, pp. 345–372.?

[11] E. Murphy-Chutorian, A. Doshi, and M. M. Trivedi, “Head poseestimation for driver assistance systems: A robust algorithm and experi-mental evaluation,” in Proc. IEEE Intell. Transp. Syst. Conf., Oct. 2007,pp. 709–714.?

[12] B. Metz and H. P. Krueger, “Measuring visual distraction in driving:The potential of head movement analysis,” IET Intell. Transp. Syst.,vol. 4, no. 4, pp. 289–297, 2010.?

[13] J. A. Stern, T. B. Brown, L. Wang, and M. B. Russo, “Eye andhead movements in the acquisition of visual information,” Psychologia,vol. 48, no. 2, pp. 135–145, 2005.?

[14] A. Kashevnik, I. Lashkov, A. Ponomarev, N. Teslya, and A. Gurtov,“Cloud-based driver monitoring system using a smartphone,” IEEESensors J., vol. 20, no. 12, pp. 6701–6715, Jun. 2020.?

[15] J.-L. Yin, B.-H. Chen, K.-H. R. Lai, and Y. Li, “Automatic dangerous driving intensity analysis for advanced driver assistance systemsfrom multimodal driving signals,” IEEE Sensors J., vol. 18, no. 12,pp. 4785–4794, Jun. 2018.?

[16] M. Atiquzzaman, Y. Qi, and R. Fries, “Real-time detection of drivers’texting and eating behavior based on vehicle dynamics,” Transp. Res. F,Traffic Psychol. Behav., vol. 58, pp. 594–604, Oct. 2018.?

[17] L. Li, Z. Xie, X. Xu, Y. Liang, and W. Horrey, “Recognition of manualdriving distraction through deep-learning and wearable sensing,” in Proc.10th Int. Driving Symp. Hum. Factors Driver Assessment, TrainingVehicle Design, Driving Assessment, vol. 10, Jun. 2019, pp. 22–28.?

[18] L. Li, B. Zhong, C. Hutmacher, Y. Liang, W. J. Horrey, and X. Xu,“Detection of driver manual distraction via image-based hand andear recognition,” Accident Anal. Prevention, vol. 137, Mar. 2020,Art. no. 105432.?

[19] A. Tawari, S. Martin, and M. M. Trivedi, “Continuous head movementestimator for driver assistance: Issues, algorithms, and on-road evaluations,” IEEE Trans. Intell. Transp. Syst., vol. 15, no. 2, pp. 818–830,Apr. 2014.[20] F. Vicente, Z. Huang, X. Xiong, F. De la Torre, W. Zhang, and D. Levi,“Driver gaze tracking and eyes off the road detection system,” IEEETrans. Intell. Transp. Syst., vol. 16, no. 4, pp. 2014–2027, Aug. 2015.?

[21] A. Tawari and M. M. Trivedi, “Robust and continuous estimation ofdriver gaze zone by dynamic analysis of multiple face videos,” in Proc.IEEE Intell. Vehicles Symp., Jun. 2014, pp. 344–349.?

[22] I.-H. Choi, S. K. Hong, and Y.-G. Kim, “Real-time categorization ofdriver’s gaze zone using the deep learning techniques,” in Proc. Int.Conf. Big Data Smart Comput. (BigComp), Jan. 2016, pp. 143–148.?

[23] S. Dari, N. Kadrileev, and E. Hullermeier, “A neural network-baseddriver gaze classification system with vehicle signals,” in Proc. Int. JointConf. Neural Netw. (IJCNN), Jul. 2020, pp. 1–7.?

[24] I. R. Tayibnapis, M.-K. Choi, and S. Kwon, “Driver’s gaze zoneestimation by transfer learning,” in Proc. IEEE Int. Conf. Consum.Electron. (ICCE), Jan. 2018, pp. 1–5.

[25] Y. Wang, T. Zhao, X. Ding, J. Bian, and X. Fu, “Head pose-free eyegaze prediction for driver attention study,” in Proc. IEEE Int. Conf. BigData Smart Comput. (BigComp), Feb. 2017, pp. 42–46.?

[26] M. Kok, J. D. Hol, and T. B. Sch?n, “Using inertial sensors forposition and orientation estimation,” in Foundations and Trends in SignalProcessing, vol. 11, nos. 1–2. Boston, MA, USA: Now, Nov. 2017,pp. 1–153.?

[27] A. Fernández, R. Usamentiaga, J. Carús, and R. Casado, “Driverdistraction using visual-based sensors and algorithms,” Sensors, vol. 16,no. 11, p. 1805, Oct. 2016.?

[28] Face Detection | Firebase. Accessed: Aug. 17, 2020. [Online]. Available//firebase.google.com/docs/ml-kit/detect-faces?

[29] Amazon Web Services (AWS)—Cloud Computing Services.Accessed: Dec. 22, 2020. [Online]. Available: https://aws.amazon.com/rekognition?

[30] N. Bhatia and Vandana, “Survey of nearest neighbor techniques,” Int.J. Comput. Sci. Inf. Secur., vol. 8, no. 2, p. 11, Jul. 2010. [Online].Available: https://arxiv.org/pdf/1007.0085.pdf?

[31] J. M. Ramírez, M. D. Rodríguez, á. G. Andrade, L. A. Castro,J. Beltrán, and J. S. Armenta, “Inferring drivers’ visual focus attention through head-mounted inertial sensors,” IEEE Access, vol. 7,pp. 185422–185432, 2019.?

[32] Home—Yost Labs. Accessed: Aug. 17, 2020. [Online]. Available: https://yostlabs.com/?

[33] GitHub—Natario1/CameraView: A Well Documented, HighLevel Android Interface That Makes Capturing Pictures andVideos Easy, Addressing All of the Common Issues and Needs.Accessed: Sep. 15, 2020. [Online]. Available: https://github.com/natario1/CameraView?

[34] Android KitKat | Android Developers. Accessed: Sep. 15, 2020. [Online].Available: https://developer.android.com/about/versions/kitkat?

[35] Fused Location Provider API | Google Developers.Accessed: Sep. 15, 2020. [Online]. Available: https://developers.google.com/location-context/fused-location-provider/?

[36] MATLAB App Designer—MATLAB. Accessed: Sep. 15, 2020.[Online]. Available: https://www.mathworks.com/products/matlab/appdesigner.html?

[37] J. S. Armenta, M. D. Rodríguez, and A. G. Andrade, “A sensingarchitecture based on head-worn inertial sensors to study drivers’ visualpatterns,” Proceedings, vol. 31, no. 1, p. 34, Nov. 2019.?

[38] S. Classen et al., “Item development and validity testing for a self- andproxy report: The safe driving behavior measure,” Amer. J. OccupationalTherapy, vol. 64, no. 2, pp. 296–305, Mar. 2010.?

[39] S.-W. Park et al., “Association between unsafe driving performance andcognitive-perceptual dysfunction in older drivers,” PM R, vol. 3, no. 3,pp. 198–203, Mar. 2011.?

[40] M. Rizzo, “Impaired driving from medical conditions: A 70-year-oldman trying to decide if he should continue driving,” Jama, vol. 305,pp. 1018–1026, Mar. 2011.?

[41] S. W. Savage, L. Zhang, G. Swan, and A. R. Bowers, “The effectsof age on the contributions of head and eye movements to scanningbehavior at intersections,” Transp. Res. F, Traffic Psychol. Behav.,vol. 73, pp. 128–142, Aug. 2020.?

[42] Quick Statistics Calculators. Accessed: Jul. 16, 2019. [Online]. Available: https://www.socscistatistics.com/tests/?

[43] K. L. Young and M. G. Lenné, “Driver engagement in distractingactivities and the strategies used to minimise risk,” Saf. Sci., vol. 48,no. 3, pp. 326–332, Mar. 2010.?

[44] Q. C. Sun, J. C. Xia, J. He, J. Foster, T. Falkmer, and H. Lee, “Towardsunpacking older drivers’ visual-motor coordination: A gaze-basedintegrated driving assessment,” Accident Anal. Prevention, vol. 113,pp. 85–96, Apr. 2018.?

[45] A.-S. Wikman and H. Summala, “Aging and time-sharing in highwaydriving,” Optometry Vis. Sci., vol. 82, no. 8, pp. 716–723, Aug. 2005.?

[46] B. Metz, N. Sch?mig, and H.-P. Krüger, “Attention during visual secondary tasks in driving: Adaptation to the demands of the driving task,”Transp. Res. F, Traffic Psychol. Behav., vol. 14, no. 5, pp. 369–380,Sep. 2011.?

[47] N. Merat, V. Anttila, and J. Luoma, “Comparing the driving performanceof average and older drivers: The effect of surrogate in-vehicle infor-mation systems,” Transp. Res. F, Traffic Psychol. Behav., vol. 8, no. 2,pp. 147–166, Mar. 2005.

編輯:黃飛

?

電子發燒友App

電子發燒友App

評論