隨著圖像傳感器和新型傳感器的大幅進步,視覺系統正迅速變得無所不在。 ? 雖然傳感器本身通常是采用成熟節點芯片開發的,但它越來越多地與在最先進節點開發的視覺處理器相連。這使得每瓦性能達到了最高水平,而且還可以設計使用AI預訓練模型的AI加速器,同時仍然保持足夠小的尺寸與合適的溫度范圍,可用于AR/VR頭盔、手機和汽車艙內傳感器,在這些場景中通常同時采用多個攝像頭。 ?

嵌入式視覺峰會總主席、Edge AI和視覺聯盟創始人、BDTI總裁Jeff Bier說:“十年前,還沒有廣泛使用的計算機視覺處理器。今天,有幾十個。這很重要,因為計算機視覺算法非常適合用并行處理進行加速。因此,與通用處理器相比,采用專門架構的處理器可以輕松實現100倍的性能和效率。處理器效率的巨大提升使得在數千個新應用中部署計算機視覺成為可能。” ? 在過去,所有這些都必須從零開始開發。但這些系統正在成熟。如今,半導體和AI公司正在提供現成的視覺處理模型和訓練過的數據集的平臺,開發者可以將其作為新系統的基礎。這在醫學領域很明顯,例如,計算機視覺正在幫助放射科醫生解讀X光片。

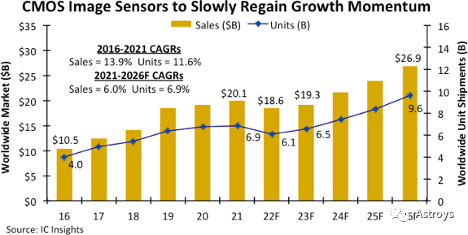

Flex Logix的高級營銷總監Sam Fuller說:“AI的出現使人們能夠理解圖像,并開始減輕人們的負擔,比如放射科醫生,使他們更有效率。在算法開發及產品轉化方面,還有很多工作要做。” ? Mixel的創始人兼CEO Ashraf Takla表示:“AI/ML和邊緣計算的應用發展勢頭良好,可以最小化視頻數據的傳輸量,從而降低功耗并提高系統效率。” ? 更小、更智能、更高效的攝像頭隨處可見。視覺系統涵蓋了從手機攝像頭到工業自動化、汽車、醫療、安全、監控、無人機、機器人、AR/VR等各個領域。對視覺和圖像系統組件的需求在逐年增加。 ? 視覺處理半導體市場分為視覺處理器(VPU)和圖像信號處理器(ISP)。Mordor Intelligence的數據顯示,這兩個市場的CAGR預計都為7%。亞太地區的需求量最大,其次是北美和歐洲。ST、TI、Sigma、Semiconductor Components Industries和Fujitsu是一些較大的半導體公司,但許多新老玩家都在視覺處理市場。Flex Logix、Ambarella、SiMa.ai、Hailo.ai和Brainchip都取得了長足進步。一些EDA公司正在提供具有視覺和AI功能的IP。 ? IC Insights預測,圖像傳感器的需求也不能忽視,但由于智能手機需求的下滑,CMOS可能會遭遇暫時的需求放緩。 ?

圖1:由于在家辦公的需求有所緩解,智能手機和筆記本銷量下滑,預計CMOS圖像傳感器的需求將放緩。(數據來源:IC Insights) ? 與此同時,根據SkyQuest技術咨詢公司的數據,全球圖像傳感器市場預計將在2022-2028年期間以8.43%的CAGR增長,到2028年將達到301.2億美元。圖像傳感器市場占有率排名前六的公司是Sony、Samsung、OmniVision、ST、ONSemi和Panasonic。 ?

新型圖像傳感器??

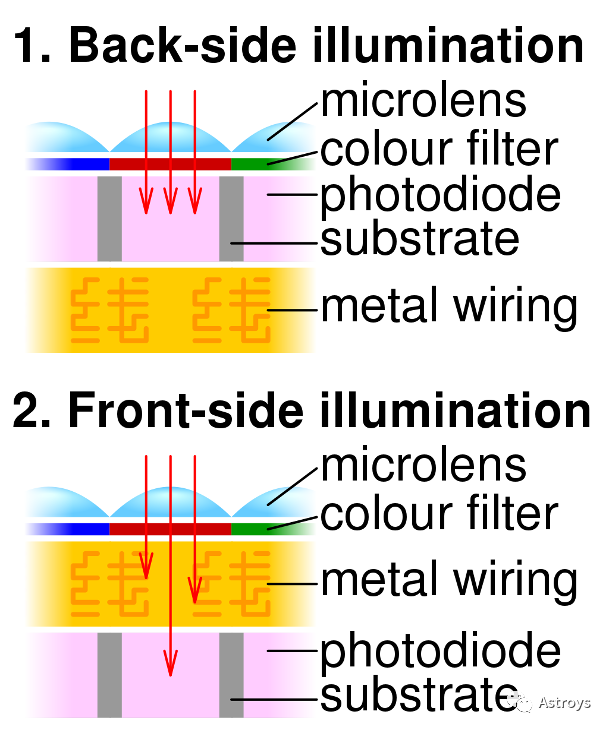

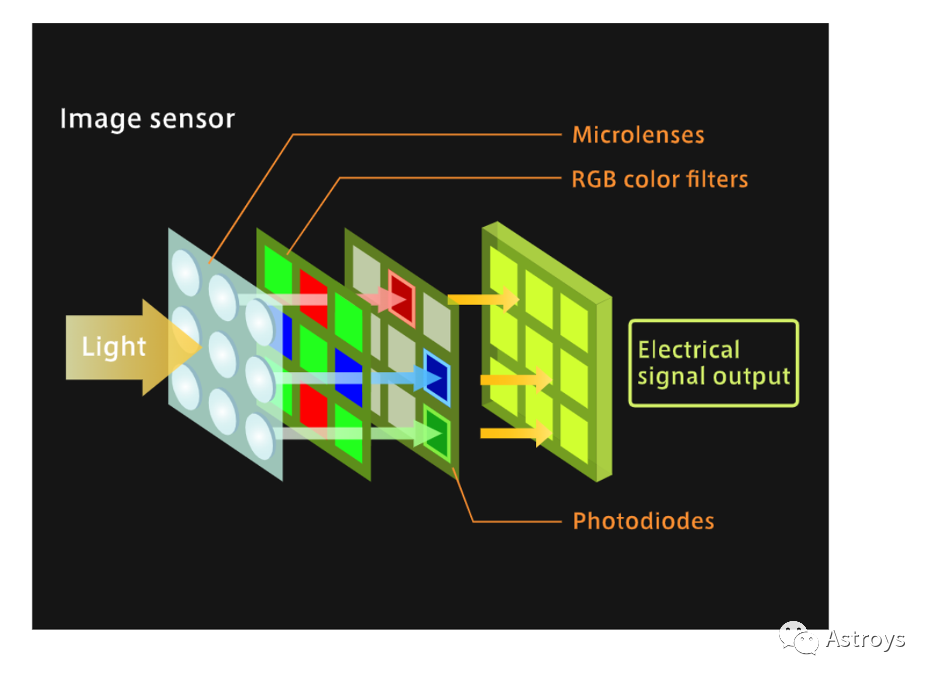

在電子視覺系統中,圖像傳感器使用光學、像素和感光元件(光電二極管或光電門)將光轉換為電信號或比特。然后,數據pipeline將信號發送到處理器,在處理器中將信號轉換為數字圖像。 ? 圖像傳感器在傳感器上有一層光學器件來聚焦光線,但根據用例,還可以在上面添加另一層更復雜的光學器件。OmniVision的IoT/新興部門營銷總監Devang Patel說:“這意味著基本上傳感器只發送原始數據,然后有一個主處理器。例如,Qualcomm或ambarella處理器將完成所有后端處理,轉換為YUV、JPEG進行視頻錄制,” ? 兩種常見的圖像傳感器類型,CMOS(complementary metal oxide semiconductor)和CCD(charge coupled device)將光轉換成電荷,并將其處理成電信號。CCD使用的是高壓模擬電路,正如TEL所描述的,它的像素陣列有一個桶狀結構,將電荷移動到頂層行,作為一個讀數寄存器。然后,讀數寄存器將電荷輸出到傳感器外的處理器。 ? CCD有兩種類型,FSI(frontside illumination)和BSI(backside illumination)傳感器。區別在于光電二極管襯底在傳感器中的位置。 ? OmniVision的Patel說:“所有高性能傳感器幾乎都是BSI。” ?

圖2: BSI和FSI圖像傳感器示意圖(來源:Cmglee)

? CMOS傳感器的生產成本比CCD低,因為CMOS可以在現有的半導體制造設備上制造。CMOS的能耗也更低。CMOS圖像傳感器中的每個像素都有自己的光電二極管直接輸出信號。 ? 相比之下,CCD基于NMOS,被認為比CMOS噪聲更小。因此,它們是科學設備和高分辨率掃描儀的首選。CMOS被用于大多數其他應用,因為它在功耗和成本上占優,且一直在提高精度或分辨率。 ?

捕獲圖像數據的基本單位是像素。增加圖像傳感器的像素是提高圖像分辨率的一種方法。較小的像素意味著在提高分辨率的同時,可以在相同的區域內放入更多的像素,這稱為像素間距,目前圖像傳感器上的像素密度在增加。 ? 但增加像素會影響圖像傳感器的測試。近年來,CMOS圖像傳感器(CIS)設備的像素數呈爆炸式增長,結果是CIS設備的測試往往需要更長時間。 ?

真正影響測試的是傳感器的縮小。OmniVision多年來一直在銷售微型2層圖像傳感器。“當你做得越來越小的時候,測試就會面臨挑戰,因為測試設備和硬件隨之面臨著挑戰。” ? 圖像的使用者可以是人、計算機或某種機器。因此,圖像傳感器的選擇取決于最終用途和最終用戶。如果終端使用者不是人類,或者目的是檢測特定的事件,則正在考慮使用諸如事件傳感器之類的新型視覺傳感器。在光線較暗的情況下和車內監控,事件傳感器只檢測到強度的變化,像素會被變化激活。否則,不需要收集其他圖像數據。 ?

圖3:CMOS圖像傳感器(CIS)

將光通過像素,通過光電二極管轉換成電信號輸出(來源:TEL Nanotec Museum) ? 圖像傳感器在200mm和300mm晶圓廠的成熟節點上制造。一些圖像和視頻傳感器包括圖像或視頻處理模塊。這些是SoC。另一種沒有視頻處理器的圖像傳感器被稱為RAW。 ? OmniVision的Patel表示:“就普及程度而言,RAW傳感器代表了全球大多數(視覺)傳感器。視頻處理器是很多公司的專利,他們有自己的算法、配方和操作方法。由于這些原因,使用外部VPU總是更好。你還可以使用高級處理節點來集成更高級的圖像處理算法。這就是你所看到的,但市場上仍有一些SoC傳感器可用。” ? 有時,由于其他原因,最好將圖像傳感器與處理元件分離。Patel說:“在汽車領域,有一些用例更傾向于將視頻處理分開。汽車的后視攝像頭在后備箱的位置,但可以在中控上顯示視頻。那是一段很長的距離。設計師更愿意使用數字輸出,或傳統的模擬輸出,如NTSC或PAL視頻輸出,這樣你就可以使用較長的線束來顯示。”

? 信號/圖像數據是使用并行和串行輸出從圖像傳感器上移走的。這似乎違反直覺,但串行輸出正變得比并行更受歡迎,其中MIPI占主導地位。 ? Mixel的Takla說:“在大多數視覺應用中,功率和延遲是關鍵參數。MIPI的最初目標是傳感器、處理器和顯示器之間的視頻數據通信,因此我們針對這類應用進行了優化。正因為如此,MIPI標準的發展使得功耗、延遲最小化,并解決了典型視頻鏈接的不對稱特性。我們看到C-PHY正在普及,主要是在傳感器中。顯示器方面的應用正在增長,但卻滯后于傳感器。” ? 串行接口在視覺上勝過并行接口。Patel說:“對于并行接口,如果是8位或10位輸出,基本上有12行,然后一些其他的信號,這是傳統的數據總線。串行接口大致是MIPI聯盟的。它們基本上使用串行差分引腳和輸出。一條線路包括兩個數據對,然后是時鐘對,所以是四個引腳,但實際上,與并行相比,這四個引腳能夠輸出更高的吞吐量。” ? 并行輸出有一個TTL(transistor-transistor logic)擺動,增加了傳輸時間。Patel說:“當你從零電壓切換到更高的電壓時,無論是1.2還是1.5,信號的上升和下降都需要時間。

挑戰在于你能達到的速度,但從簡單的角度來看,并行是最簡單的輸出方式,因為行業中的大多數微控制器都有某種類型的并行輸入數據總線。你可以直接把這些連接起來。” ? 當涉及到高分辨率、高幀輸出時,當速度提高時,并行又出現了不足。“如果你想在高分辨率下輸出高幀率,比如在30幀或60幀下輸出4K或2K,并行端口將很難輸出如此高的幀率。那會是很大的功率。所以這些都是通過串行接口,也就是MIPI接口來處理的。我們看到越來越多的新微控制器也加入了MIPI接口。” ?

在視覺或圖像信號處理器內部,數據處理可能與SoC內部不同。Arteris IP的CMO Michal Siwinski說:“你將視覺作為一種傳感器,這實際上是非常數據密集型的,能夠獲取這種信息,并確保能夠捕獲它,信息是連接的,數據從芯片的這部分流向其他部分,這樣你就可以計算它,解析它,并從中學習。視覺可能比其他類型的傳感器產生更多的數據。

由于我們能夠很好地處理這個問題,其他的事情基本上都很簡單。我們基本上提供了底層的SoC基礎設施。” ? VPU和ISP,視覺IP?? 電信號一旦離開圖像傳感器,就在VPU或ISP或兩者中進行處理。 ? 典型的計算機視覺應用就是攝像頭(帶圖像傳感器)。攝像頭有一些預處理。它捕獲數據幀,檢測對象,跟蹤識別,然后進行一些后處理。系統設計者已經使用MPU、CPU和GPU來處理圖像。圖形處理器是為3D和游戲圖形設計的,最初在處理圖像方面有一些優勢。但現在有VPU,利用AI加速器處理圖像。AI只從信號中提取必要的數據,并可以為圖像識別編程,或幫助終端用戶找到有意義的數據或提高其用例的圖像質量。 ? VPU的例子有: ?

Flex Logix的InterX內置了AI模型。圖像處理是Flex Logix AI推理產品的細分市場之一。該公司的營銷高管說:“我們非常專注于高清實時圖像處理。我們已經開發了針對這一領域優化的芯片(機器視覺、計算機視覺)。”

Renesas的RZ/V系列是MPU,使用Renesas的專有AI加速器,低功耗DRP-AI(Dynamically Reconfigurable Processor)加速器。RZ/V2M具有支持4K/30fps的高性能ISP;RZ/V2L有一個3D圖形引擎。OpenCV加速器使它與各種圖像處理設備兼容。兩個主要的64位CPU是Arm的Cortex-A55(1.2GHz)或Arm Cortex-A53(1.0GHz)Dual。子CPU是Arm Cortex-M33(200MHz)Single。Renesas的企業基礎設施事業部副總裁Shigeki Kato在一份聲明中表示:“對于想要實現機器學習的嵌入式系統開發者來說,挑戰之一是要跟上不斷發展的最新AI模型。通過新的DRP-AI TVM工具,我們為設計師提供了擴展AI框架和AI模型的選項,這些AI框架和AI模型可以轉換為可執行格式,允許他們使用新的AI模型為嵌入式設備帶來最新的圖像識別能力。”

英特爾的Movidius(VPU)包括一個神經計算引擎。

ST為STM32Cube提供了AI和計算機視覺功能包。FP-AI-VISION1功能包運行在基于Arm核的STM32 MCU上。

傳統上,ISP用于數碼相機中處理為人類觀看而優化的數字圖像。ISP可以應用白平衡過濾器、原始數據校正、鏡頭校正、動態范圍校正、降噪、銳化、數字圖像穩定和各種其他調整。ISP也正在適應計算機視覺應用。ISP可以是將用于SoC或圖像傳感器本身的IC或IP核,通常與VPU結合使用。一個ISP的例子是Arm的Mali-C52和Mali-C32 ISP,用于IoT設備的實時、更高的圖像質量。 ? VPU和ISP一起使用,可以產生比單獨使用VPU更高效的計算機視覺處理。 ? 此外,EDA行業還提供視覺系統的IP和創建和測試視覺系統設計的工具。按供應商分類,應用包括: ?

Cadence:Tensilica Vision DSP用于汽車SoC和其他用例。

Synopsis:DesignWare ARC EV處理器,用于嵌入式視覺應用的可編程和可配置IP核。

Ansys:用于檢查計算機視覺系統的工具,例如它的SCADE vision,它可以檢測視覺系統的問題。在汽車領域,SCADE Vision|Driving Perception Software Testing可自動識別自動駕駛汽車基于AI的感知系統的脆弱性。Ansys AVxcelerate Sensors|AV Sensor Simulation Software測試自動駕駛汽車中的ADAS傳感器。

預先訓練的AI圖像推理模型是提取圖像意義的一種經濟有效的方法。Flex Logix為完成特定任務的視覺應用提供預先訓練的模型,如硬帽檢測、車牌讀取、車輛檢測、無人機、PCB缺陷檢測等。這種名為EasyVision的AI模型與Flex Logix的InferX AI邊緣加速器協同工作。 ? Fuller說:“算法已經存在,訓練也已經進行,但你還想把它構建成一種健壯且具有成本效益的東西。這就是這種服務非常有意義的地方,因為科學開發轉化為工程產品,是一個仍然需要完成的過程,也是我們真正專注于幫助客戶完成的事情。” ?

邊緣視覺處理??

雖然圖像傳感器可能不會內置在邊緣的處理器中,但圖像傳感器正在與新的處理器和SoC組合,在邊緣使用AI進行圖像處理。如前所述,Flex Logix是開發邊緣圖像處理能力的初創公司之一。其他還有SiMa.ai,該公司利用Synopsys的DesignWare ARC嵌入式視覺處理器和Arm的計算IP,創建了計算機視覺的MLSoC平臺。其他致力于視覺前沿AI的初創公司包括Ambarella、Brainchip和Hailo。

帶有AI的視覺邊緣設備的一個例子是Au-Zone的微型AR/VR相機,采用了NXP的i.MX?RT1064 MCU(基于Arm Cortex-M7視覺),最高可達600MHz。Au-Zone的攝像頭也是為IoT設計的。NXP的i.MX?RT1064 MCU是NXP用于IoT和邊緣AI的RT Crossover系列的一部分,其中包括音頻和視覺應用。

但終極邊緣仍然是AR/VR。經過20多年的研發,這一市場才剛剛開始進入消費電子行業的視野,這在很大程度上是由于其所用芯片在速度、功耗和價格開始進入合理區間。

小型化,多層堆疊????

攝像頭及其集成電路正變得越來越小、越來越復雜,圖像傳感器也變得更多層。其中一個驅動力是眼鏡或頭戴式設備中的AR/VR。例如,需要多個微型攝像頭聚焦于人類互動的某個特定方面。可能需要一臺單獨的攝像頭來聚焦一個人的嘴唇、眼睛和手勢。

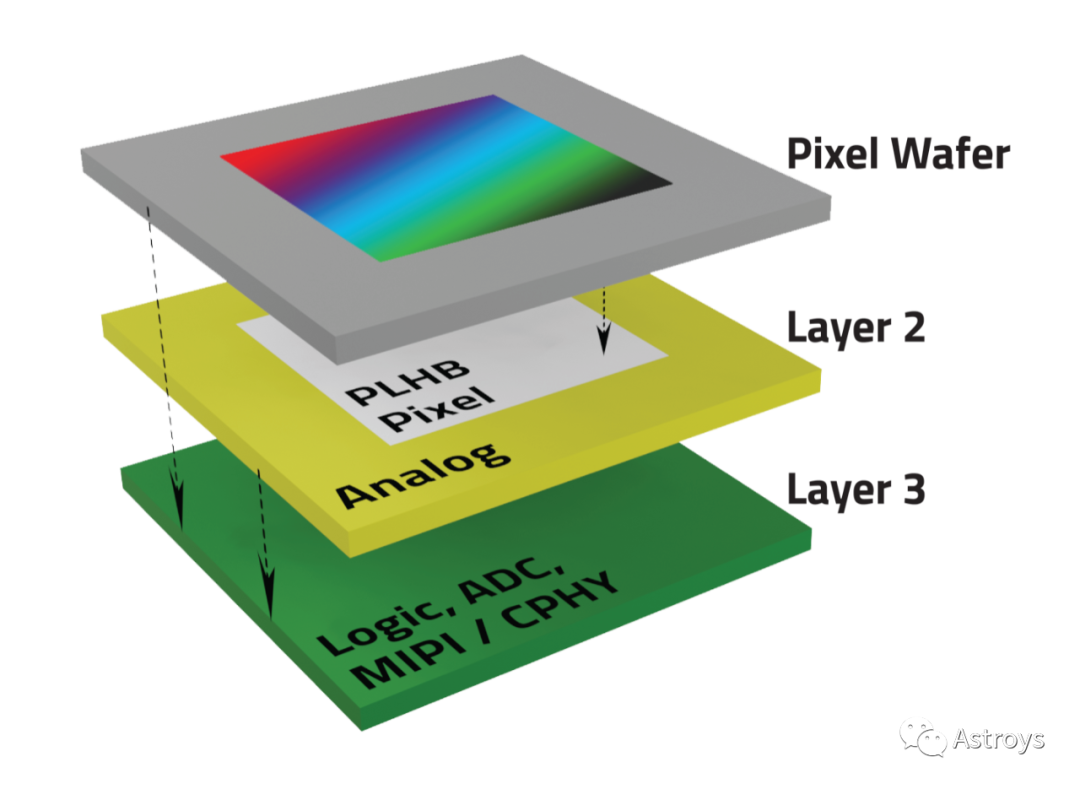

隨著AR/VR技術的發展,眼鏡的邊框需要多個攝像頭。OmniVision的Patel說:“性能和尺寸的需求非常重要。我們正在對OG0TB的全球快門圖像傳感器進行采樣,該傳感器使用三層疊加。”

圖4:OmniVision的三層圖像傳感器OG0TB,除了像素晶圓,它還具有模擬、邏輯、ADC、MIPI/CPHY(來源:OmniVision)

OmniVision的Patel說:“通過三層堆疊,我們可以制作1.6*1.6毫米的攝像頭,而這種尺寸可以讓你把它們放在下一代AR/VR設備中。在未來,這些層可能使傳感器避免傳輸不需要的數據。長期愿景是我們經歷層層疊加的原因之一。你可以想象,在未來,我們可以把一些模塊、CNN網絡,或其他一些數字功能,你需要把所有的原始數據發送給他們。但如果目的只是為了眼球追蹤,為什么要發送所有的原始數據。相反,只發送x、y坐標。如果傳感器本身有這個處理模塊,我們就能實現這個目標,這將有助于使用主機上的帶寬,因為你可以想象有多少攝像頭在爭奪這個接口。”

處理多攝像頭數據的AI正在被設計成芯片。Renesas剛剛在其RZ/V系列中推出了一款支持AI的微處理器,可以對來自多個攝像頭的圖像數據進行AI處理,以提高視覺AI應用的圖像識別精度,如配有AI的網關、視頻服務器、安檢門、POS終端和機械臂。

在更大的系統中,比如汽車、無人機、機器人,多攝像頭和視覺系統是常態,盡管它們并不總是微型的。Arteris IP的高級技術營銷經理Paul Graykowski表示,“通常有不止一個視覺系統。通常情況下,你是通過一系列攝像頭等方式傳送數據,你必須確保有足夠的帶寬和延遲來處理這種情況。”

如果是無人機,它使用攝像頭作為視覺傳感器來避障。“如果它在飛行,處理數據的速度不夠快,就會發生碰撞。我們必須確保在數據路徑中有緊密耦合,以確保我們為這些處理器提供實時數據。我們顯然也不希望他們被閑置。當你在處理視覺時,優化性能是關鍵,及時地獲得數據,這樣你就可以對數據進行機器學習,然后做出相應的反應。無論是ADAS、無人機還是機器人,在任何類型的視覺系統中,獲得實時數據是非常重要的。”

盡可能接近實時的反應是系統的理想和目的。

Graykowski說:“它能夠優化NoC的配置,并具有靈活性,可以指定‘我必須將數據從A點移動到B點,它必須在這個時間到達那里’,以及所有這些服務質量參數,以確保實現目標。”

但實時并不總是必需的。有時候讓系統“思考”是可以的。系統設計師需要知道什么數據需要被感知、通過AI加速器移動、通過CPU進行響應,所有這些都是近乎實時的。無人機就是一個很好的例子。無人機可能需要一段時間來改變路線,因為它會考慮各種可能性。不過,一架在空中的無人機可能不會像一輛在地面上的汽車那樣面臨迫在眉睫的危險,它在ADAS中做實時處理以避免碰撞。

“視覺擁有來自多個來源的大量數據。它基本上是從所有這些來源獲取數據,并很快將其送到處理單元或AI單元,這樣它們就可以對其進行分析。一旦他們有了分析并確定了發生了什么,這將被傳遞給CPU去做一些思考。你需要一個非常快速的數據鏈來及時移動數據,因為大多數視覺系統都是實時對事物做出反應。這是圍繞視覺進行優化的關鍵,及時移動數據。顯然,面積、功率和性能總是要考慮的因素,但現實情況是,你必須確保你設計的NoC不會耗盡你的AI引擎,這樣它們才能進行所需的計算。”

圖像傳感器越來越小,像素和層數越來越多,而視覺處理SoC現在增加了AI加速器和邊緣AI處理。攝像頭越來越多、越來越小、越來越智能和高效。視覺系統涵蓋了從手機攝像頭到工業自動化、汽車、醫療、安全等各個領域。

但是,系統使用者是計算機、機器還是人對系統設計有很大的影響,因為系統設計可以舍棄不必要的數據。此外,傳感器、AI和ML視覺處理的新選擇將幫助團隊進行更精簡的視覺系統設計,并獲得更多更高質量的圖像。

[參考文章]

AI Feeds Vision Processor, Image Sensor Boom — Susan Rambo

編輯:黃飛

電子發燒友App

電子發燒友App

評論