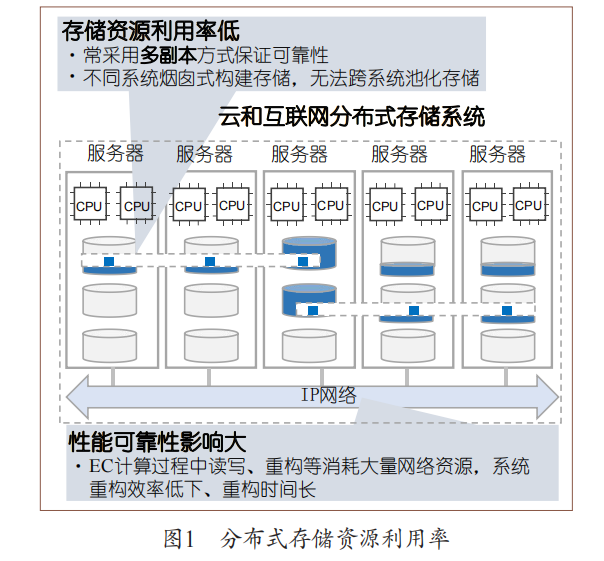

從云和互聯(lián)網(wǎng)的業(yè)務(wù)場景來看,其存儲域主要采用基于服務(wù)器部署分布式存儲服務(wù)的融合方式,它面臨如下挑戰(zhàn) : 1.?dāng)?shù)據(jù)保存周期與服務(wù)器更新周期不匹配。大數(shù)據(jù)、人工智能等新興業(yè)務(wù)催生出海量數(shù)據(jù),大量數(shù)據(jù)需按照其生命周期策略(例如?8~10?年)進(jìn)行保存。 2.性能可靠與資源利用率難以兼得。支撐業(yè)務(wù)的分布式存儲系統(tǒng)大致可以分為性能型存儲和容量型存儲,它們均無法同時實(shí)現(xiàn)高性能可靠與高資源利用率。具體地,性能型存儲主要運(yùn)行數(shù)據(jù)庫、虛擬化等關(guān)鍵業(yè)務(wù),通常采用三副本或兩副本并配合獨(dú)立冗余磁盤陣列卡模式 ;這類方案雖兼顧了性能和可靠性,但其大約?30%?的空間利用率卻是對存儲資源的極大浪費(fèi)。

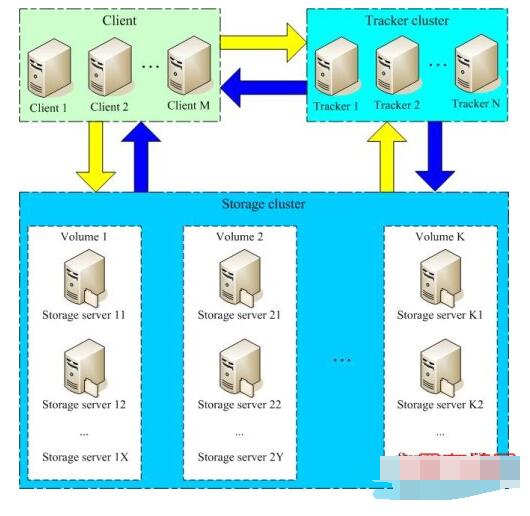

容量型系統(tǒng)為了提升空間利用率,采用糾刪碼(Erasure Code,EC)方式,然而,EC計算過程中的讀寫、重構(gòu)等會消耗大量網(wǎng)絡(luò)資源,導(dǎo)致系統(tǒng)重構(gòu)效率低下、重構(gòu)時間長,給系統(tǒng)可靠性帶來風(fēng)險(如圖?1?所示)。

3.新型分布式應(yīng)用的極簡高效共享存儲訴求。

以無服務(wù)器(serverless)應(yīng)用為代表的新型分布式應(yīng)用在近些年涌現(xiàn),這類應(yīng)用從無狀態(tài)化向有狀態(tài)化擴(kuò)展,比如數(shù)據(jù)庫、消息總線等組件紛紛容器化,數(shù)據(jù)共享訪問的訴求不斷增多。與此同時,人工智能和機(jī)器學(xué)習(xí)等應(yīng)用需要大量異構(gòu)算力協(xié)同,甚至產(chǎn)生共享內(nèi)存訪問的訴求,它們關(guān)注高帶寬、低時延的訪問能力,僅需要輕量、便捷的共享存儲系統(tǒng)即可,不需要搭載具有復(fù)雜企業(yè)特性的傳統(tǒng)存儲。

4.?dāng)?shù)據(jù)中心稅導(dǎo)致數(shù)據(jù)密集型應(yīng)用效率低下。

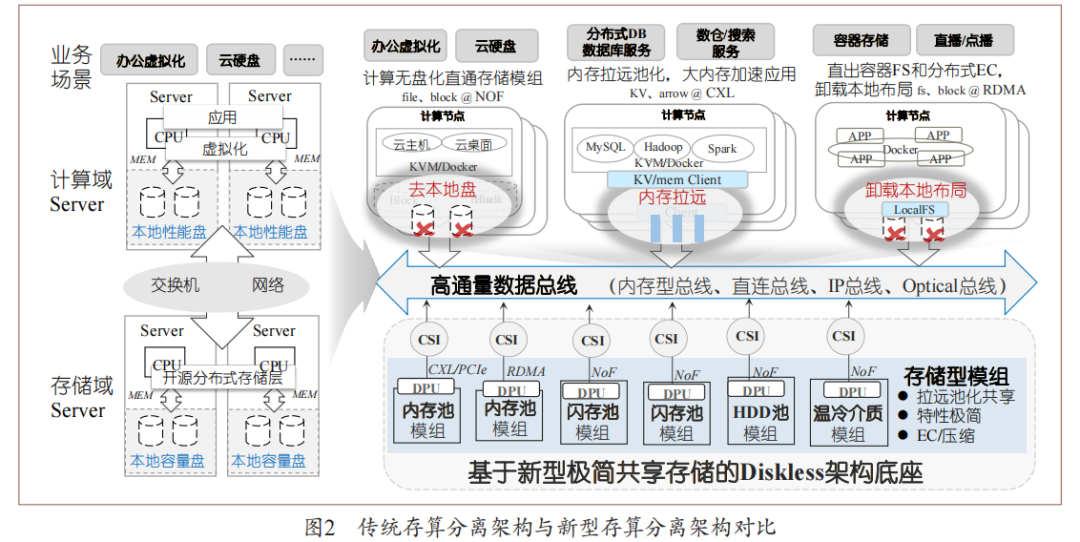

面向數(shù)據(jù)密集型場景,在基于以?CPU?為中心的服務(wù)器架構(gòu)下,應(yīng)用為獲取數(shù)據(jù)所繳納的“數(shù)據(jù)中心稅”(datacenter tax)日益加重。例如,服務(wù)器內(nèi)的?CPU為處理網(wǎng)絡(luò)及存儲?IO?請求,需要消耗高達(dá)?30%?的算力?[3]?;此外,由于通用?CPU?并不擅長數(shù)據(jù)處理運(yùn)算,導(dǎo)致其能效比低下。 傳統(tǒng)存算分離架構(gòu)將算力資源和存儲資源(機(jī)械硬盤、固態(tài)硬盤等)分離至彼此獨(dú)立的計算域和存儲域,并通過以太網(wǎng)或?qū)S么鎯W(wǎng)絡(luò)(例如光纖通道)將二者互連,實(shí)現(xiàn)了存儲資源的靈活擴(kuò)展和高效共享(如圖?2?左側(cè)所示);該架構(gòu)主要為復(fù)雜的傳統(tǒng)企業(yè)特性設(shè)計,難以應(yīng)對上述挑戰(zhàn),為了讓云和互聯(lián)網(wǎng)存儲域服務(wù)兼顧資源利用率、可靠性、性能、效率等眾多訴求,亟須基于新型軟硬件技術(shù)構(gòu)建新型存算分離架構(gòu)。

一、硬件技術(shù)趨勢

面對數(shù)據(jù)中心在容量利用率、存力效率等方面的挑戰(zhàn),近年來,專用數(shù)據(jù)處理器、新型網(wǎng)絡(luò)等技術(shù)快速發(fā)展,為數(shù)據(jù)中心基礎(chǔ)設(shè)施的重構(gòu)提供了技術(shù)基礎(chǔ)。 首先,為取代服務(wù)器本地盤,很多廠商推出以太網(wǎng)閃存簇(Ethernet Bunch of Flash,EBOF)高性能盤框(例如,近期陸續(xù)發(fā)布的西數(shù)?OpenFlex、Vast Data Ceres?高性能盤框等)。這類盤框不再具有復(fù)雜企業(yè)特性,而是注重采用新型的數(shù)據(jù)訪問標(biāo)準(zhǔn),比如支持?NoF(NVM Express over Fabric)等接口,以提供高性能存儲實(shí)現(xiàn)對本地盤的替換。NoF?協(xié)議由?NVM Express?(NVMe)標(biāo)準(zhǔn)組織在?2016?年發(fā)布,提供了?NVMe?命令到多種網(wǎng)絡(luò)傳輸協(xié)議的映射,使一臺計算機(jī)能夠訪問另一臺計算機(jī)的塊存儲設(shè)備。同時,一些研究機(jī)構(gòu)進(jìn)一步探索遠(yuǎn)程內(nèi)存池化技術(shù),例如,韓國?KAIST?實(shí)驗室實(shí)現(xiàn)了基于?FPGA的?CXL(Compute Express Link)互連協(xié)議?;CXL為英特爾于?2019?年?3?月在?Interconnect Day 2019?上推出的一種開放性互聯(lián)協(xié)議,能夠讓?CPU?與?GPU、FPGA?或其他加速器之間實(shí)現(xiàn)高速高效互聯(lián),從而滿足高性能異構(gòu)計算的要求。 其次,業(yè)界涌現(xiàn)出越來越多的數(shù)據(jù)處理單元(Data Processing Unit,DPU)和基礎(chǔ)設(shè)施處理單元(Infrastructure Processing Unit,IPU)專用芯片,在數(shù)據(jù)流處理路徑上取代通用處理器,提升算力能效比。

同時,基于可編程交換機(jī)的網(wǎng)存協(xié)同也是研究熱點(diǎn),例如在網(wǎng)數(shù)據(jù)緩存的?NetCache、KV-Direct,在網(wǎng)數(shù)據(jù)協(xié)調(diào)的?NetLock、SwitchTx,在網(wǎng)數(shù)據(jù)聚合的?SwitchML、NetEC,在網(wǎng)數(shù)據(jù)調(diào)度的?FLAIR、AlNiCo等。 最后,數(shù)據(jù)訪問網(wǎng)絡(luò)標(biāo)準(zhǔn)也在持續(xù)增強(qiáng),比如CXL?協(xié)議新版本加強(qiáng)了內(nèi)存池化方向的技術(shù)特性,同時吸收了?Gen-Z(由?AMD、ARM、HPE?等公司發(fā)起定義的面向內(nèi)存語義的技術(shù))、OpenCAP(Open Coherent Accelerator Processor Interface,最早由IBM?提出的異構(gòu)計算接口)等技術(shù)的成果,正逐步成為業(yè)界主流高速互聯(lián)標(biāo)準(zhǔn)。NVMe 2.0?也在向著語義統(tǒng)一、Fabric?統(tǒng)一和介質(zhì)統(tǒng)一方向演進(jìn)。 這些新型存儲、計算和網(wǎng)絡(luò)硬件為構(gòu)建面向云和互聯(lián)網(wǎng)場景的新型存算分離架構(gòu)帶來了諸多機(jī)遇,譬如使用?DPU?等專用芯片能夠打破傳統(tǒng)以CPU?為中心的服務(wù)器架構(gòu),由此提升數(shù)據(jù)密集型應(yīng)用的效率。

二、新型存算分離架構(gòu)的特征

隨著遠(yuǎn)程直接內(nèi)存訪問(Remote Direct Memory?Access,RDMA)、CXL、可編程網(wǎng)絡(luò)設(shè)備、高性能NVMe SSD、持久性內(nèi)存等新型硬件技術(shù)的發(fā)展,需要構(gòu)建新型存算分離架構(gòu),以確保云和互聯(lián)網(wǎng)存儲域服務(wù)能夠兼顧資源利用率、可靠性、性能、效率等眾多訴求。相較于傳統(tǒng)架構(gòu),新型存算分離架構(gòu)最為顯著的區(qū)別在于 : (1)更為徹底的存算解耦,該架構(gòu)不再局限于將?CPU?和外存解耦,而是徹底打破各類存算硬件資源的邊界,將其組建為彼此獨(dú)立的硬件資源池(例如處理器池、內(nèi)存池、機(jī)械硬盤(HDD)/?固態(tài)硬盤(SSD)池等),從真正意義上實(shí)現(xiàn)各類硬件的獨(dú)立擴(kuò)展及靈活共享 ; (2)更為細(xì)粒度的處理分工,即打破了傳統(tǒng)以通用?CPU?為中心的處理邏輯,使數(shù)據(jù)處理、聚合等原本?CPU?不擅長的任務(wù)被專用加速器、DPU?等替代,從全局角度實(shí)現(xiàn)硬件資源的最優(yōu)組合,進(jìn)而提供極致的能效比。 總結(jié)來說,新型存算分離架構(gòu)具有如下特征 : 1.無盤化的服務(wù)器。新型存算分離架構(gòu)將服務(wù)器本地盤拉遠(yuǎn)構(gòu)成無盤化(diskless)服務(wù)器和遠(yuǎn)端存儲池,同時還通過遠(yuǎn)程內(nèi)存池擴(kuò)展本地內(nèi)存,實(shí)現(xiàn)了真正意義上的存算解耦,可極大提升存儲資源利用率。

業(yè)務(wù)使用時,可根據(jù)應(yīng)用需求選擇配置不同性能、容量的虛擬盤及池化內(nèi)存空間,這樣一方面可以避免由于不同服務(wù)器本地存儲空間利用率過低導(dǎo)致超配造成的浪費(fèi) ;另一方面,當(dāng)服務(wù)器出現(xiàn)故障或者更新?lián)Q代時,也不影響數(shù)據(jù)的保存,不需要額外的數(shù)據(jù)遷移。 2.多樣化的網(wǎng)絡(luò)協(xié)議。連接計算和存儲間的網(wǎng)絡(luò)協(xié)議從當(dāng)前的?IP?或光纖通道(Fibre Channel,F(xiàn)C)協(xié)議擴(kuò)展到?CXL+NoF+IP?協(xié)議組合。CXL?協(xié)議使得網(wǎng)絡(luò)時延降低到亞微秒級別,有助于內(nèi)存型介質(zhì)的池化 ;NoF?協(xié)議加速?SSD?池化 ;IP?協(xié)議可滿足?HDD?等慢速介質(zhì)訪問訴求。通過這幾類協(xié)議組合構(gòu)建的高通量網(wǎng)絡(luò),滿足了多種場景池化接入訴求。 3.專用化的數(shù)據(jù)處理器。數(shù)據(jù)存儲、訪問等操作不再由通用處理器負(fù)責(zé),而是卸載到專用數(shù)據(jù)處理器。此外,特定的數(shù)據(jù)操作可由專用硬件加速器進(jìn)行進(jìn)一步加速,如糾刪碼、加密壓縮、網(wǎng)絡(luò)通信等。通過專用數(shù)據(jù)處理器,可以釋放通用處理器算力,用于服務(wù)更適合的場景,顯著提升系統(tǒng)整體能效比。

4.極高存力密度的存儲系統(tǒng)。分離式存儲系統(tǒng)(disaggregate storage)是新型架構(gòu)的重要組件,作為持久化數(shù)據(jù)的底座,在存儲介質(zhì)的集約化管理基礎(chǔ)上,結(jié)合芯片、介質(zhì)的深度協(xié)同設(shè)計,整合當(dāng)前系統(tǒng)、盤兩級的空間管理,通過大比例糾刪碼算法減少冗余資源開銷比例。此外,還可通過基于芯片加速的場景化數(shù)據(jù)縮減技術(shù)提供更多的數(shù)據(jù)可用空間。

三、面向云和互聯(lián)網(wǎng)場景的存算分離架構(gòu)

新型存算分離架構(gòu)意在解決前文所提的當(dāng)前架構(gòu)面臨的幾大痛點(diǎn)挑戰(zhàn),通過將原有架構(gòu)的多級分層資源進(jìn)行徹底解耦池化和重組整合,形成新的三大簡化分層 :存儲模組、總線網(wǎng)絡(luò)和算力模組,從而提供服務(wù)器本地存儲拉遠(yuǎn)池化、新型網(wǎng)絡(luò)靈活組裝、以數(shù)據(jù)為中心的多元處理、高容量極簡盤框等幾大新興能力。

1、存儲模組

面向云和互聯(lián)網(wǎng)數(shù)據(jù)中心,需要以更專業(yè)的存儲能力重新定義云和互聯(lián)網(wǎng)的存儲架構(gòu)。新型存算分離架構(gòu)中,存儲型模組主要以?EBOF、以太網(wǎng)內(nèi)存簇(Ethernet Bunch of Memory,EBOM)、以太網(wǎng)磁盤簇(Ethernet Bunch of Disk,EBOD)等新型盤框形態(tài)存在,RAID/EC/?壓縮等傳統(tǒng)存儲能力下沉到新型盤框中,構(gòu)成“盤即存儲”的大盤技術(shù),對外通過NoF?等高速共享網(wǎng)絡(luò)提供塊、文件等標(biāo)準(zhǔn)存儲服務(wù)。這一類新型盤框?qū)鹘y(tǒng)磁盤陣列的冗余池化技術(shù)和數(shù)據(jù)縮減技術(shù)進(jìn)行了高度集約化和小型化。

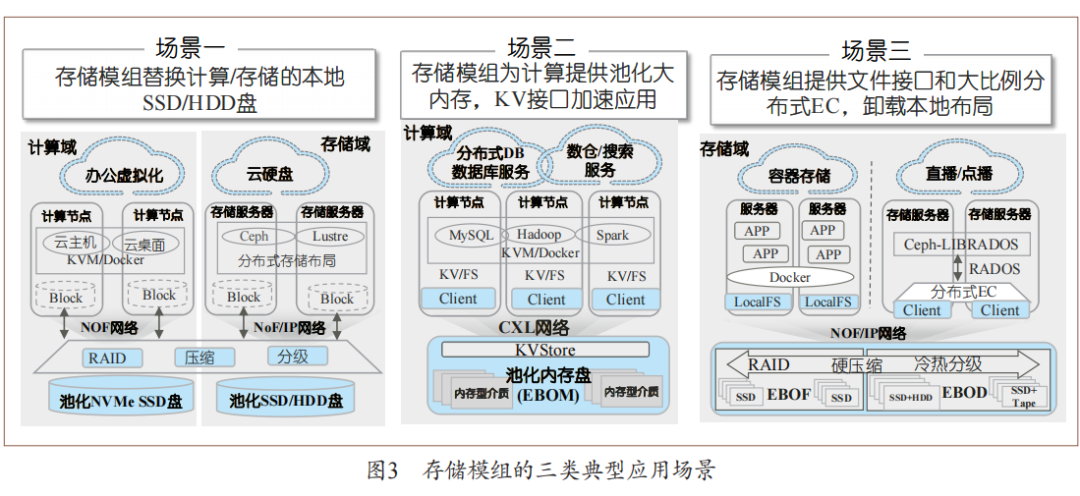

云和互聯(lián)網(wǎng)的多樣業(yè)務(wù)主要分為三種典型的應(yīng)用場景(如圖?3?所示)。第一種場景是針對虛擬化業(yè)務(wù),直接將數(shù)據(jù)中心存儲域服務(wù)器的本地盤拉遠(yuǎn),對分布式開源存儲集群的物理硬盤層形成替代。第二種場景是為數(shù)據(jù)庫、大數(shù)據(jù)服務(wù)等需要極熱數(shù)據(jù)處理的業(yè)務(wù)提供大內(nèi)存、鍵?-?值(Key-Value,KV)接口,加速數(shù)據(jù)處理效率 ;第三種場景是針對容器等新業(yè)務(wù)場景,為?Ceph、Lustre?等分布式應(yīng)用直接提供文件語義,卸載本地數(shù)據(jù)布局,并支持將溫?zé)釘?shù)據(jù)分級到更冷的?EBOD?等機(jī)械硬盤或磁帶型存儲模組中,提升整系統(tǒng)資源使用效率。

2、算力模組

當(dāng)前,摩爾定律演進(jìn)變緩,只有采用專用處理器才能進(jìn)一步以異構(gòu)方式發(fā)揮出下一階段的算力。引入專用處理器后,算力池化是必然選擇 ;否則,如果為每臺服務(wù)器配置異構(gòu)算力卡,不僅使整機(jī)功耗巨大,還會導(dǎo)致資源利用率十分低下。

以?DPU?為代表的專業(yè)數(shù)據(jù)處理器具備成本更低、功耗更低、即插即用、即換即用等獨(dú)特優(yōu)勢,并且在運(yùn)行狀態(tài)下不與業(yè)務(wù)應(yīng)用發(fā)生資源爭搶,保證用戶業(yè)務(wù)正常運(yùn)行的同時也保障了基礎(chǔ)設(shè)施的服務(wù)質(zhì)量。

3、高通量數(shù)據(jù)總線

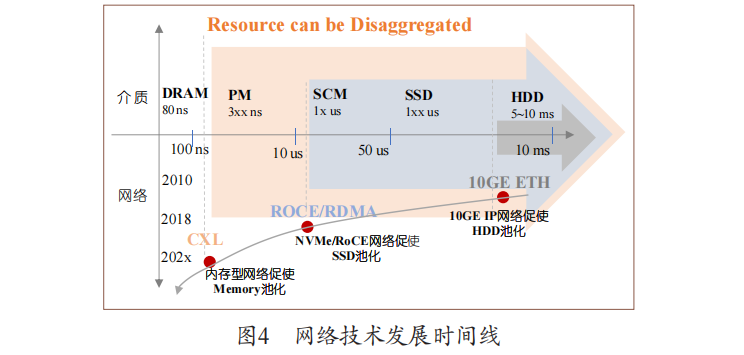

存算分離架構(gòu)中,網(wǎng)絡(luò)技術(shù)非常重要,它決定了系統(tǒng)的響應(yīng)速度以及吞吐能力,也決定了系統(tǒng)資源池化的能力范圍。過去?10?年,萬兆?IP?網(wǎng)絡(luò)促使?HDD?池化,基于?IP?網(wǎng)絡(luò)發(fā)展了支持塊、文件、對象共享的訪問協(xié)議。當(dāng)前,面向熱數(shù)據(jù)處理,NVMe/RoCE(RDMA over Converged Ethernet,RDMA?融合以太網(wǎng) ) 促 使?SSD?池 化 ;并 且,NVMe?協(xié)議快速發(fā)展使其開始收編煙囪式協(xié)議規(guī)范。下一步,面向極熱數(shù)據(jù)處理,內(nèi)存型網(wǎng)絡(luò)(例如?CXL Fabric)將促使內(nèi)存資源池化,為業(yè)務(wù)提供更大的共享內(nèi)存空間(如圖?4?所示)。

編輯:黃飛

電子發(fā)燒友App

電子發(fā)燒友App

評論