盡管早期的消費型智能眼鏡也嘗試過使用觸控板和手持或可穿戴控制器用于信息輸入,但實際上HoloLens 2的手勢控制界面和Magic Leap One代表著智能眼鏡輸入的未來。

谷歌的研究部門開發了一種新的機器學習模型,可以在輕量智能眼鏡中實現高端AR系統中的復雜手勢控制,無需額外的體積或者深度感測和運動傳感器的成本。

本周,谷歌人工智能團隊公布了手掌/手指追蹤的最新方法。新方法使用了開源、跨平臺的MediaPipe框架,在移動設備上(而不是在云端)即時處理視頻,通過機器學習模型映射多達21個手部和手指點。

“我們希望向更廣泛的研究和開發團隊提供這種手感功能,帶來更多創造性案例,刺激新的應用程序和研究途徑的產生,”谷歌團隊在一篇詳博客文章中寫道。

手掌/手指追蹤方法實際上把任務劃分成為三個機器學習模型。谷歌的研究人員沒有使用機器學習模型來識別手掌本身,而是用的手掌檢測算法,平均準確率接近96%。

檢測到手掌后,另一個機器學習模型識別出了相機視圖中手掌的21個關節坐標點。第三種算法通過記錄每個手指的手勢,與預定義的手勢進行匹配,學習模型支持分辨計數和其他各種手勢。

換句話說,這種機器學習方法可以直接應用在Android或iOS設備上,無需專門的運動或深度傳感器。谷歌團隊還在研發開放源代碼方式的模型,以便其他開發人員和研究人員使用。團隊的計劃也會不斷提高機器學習模型的準確性和性能。

在不久的將來,這款手控跟蹤系統將幫助開發者打造類似于Snapchat和Facebook的AR體驗,將手控識別和跟蹤技術融入自拍中。

谷歌還可以利用這項技術與Pixel 4上的Soli雷達傳感器合作,打造一些獨特的AR體驗,類似于iPhone X系列上的Animojis,后者把蘋果的ARKit和TrueDepth相機組合使用。

然而,通過這一進步,我們更要思考機器學習方法可以給智能眼鏡帶來什么。硬件制造商不再使用運動深度傳感器,更接近HoloLens 2和Magic Leap One上的用戶輸入方法。

越來越多的科技公司需要人工智能來解決AR可穿戴設備在外形和功能方面的問題。甚至微軟也在混合使用ARKit和ARcore的人工智能方法來檢測界面瑕疵,以更好地實現HoloLens 2的新場景理解能力。軟件應該是研發智能眼鏡的關鍵。只能眼鏡足夠輕薄,可以每天佩戴,而不僅限于家里或辦公室區域。

-

谷歌

+關注

關注

27文章

6142瀏覽量

105100 -

手勢識別

+關注

關注

8文章

225瀏覽量

47772 -

AI

+關注

關注

87文章

30146瀏覽量

268414

發布評論請先 登錄

相關推薦

Cortex-A55國產處理器_教學實驗箱_操作案例分享:5-21 手勢識別實驗

谷歌Pixel 9系列AI功能搶眼,蘋果被指AI領域落后

谷歌:聚焦AI與技術創新,攜手中國開發者共筑未來

基于毫米波雷達的手勢識別算法

基于毫米波雷達的手勢識別神經網絡

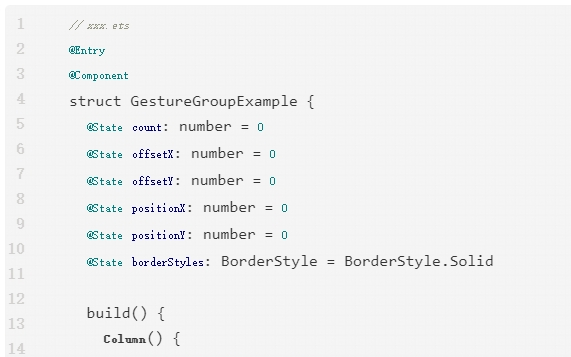

OpenHarmony實戰開發-手勢事件

基于FPGA技術的手勢識別控制型多功能機械臂系統

開發者手機 AI - 目標識別 demo

【開源獲獎案例】隔空手勢識別測試系統

紫光展銳在MWC 2024展示AI領域的最新成果

我用全志V851s做了一個魔法棒,使用Keras訓練手勢識別模型控制一切電子設備

基于ADUX1020的手勢識別實現方案

谷歌公布AI手勢識別新成果

谷歌公布AI手勢識別新成果

評論