TL; DR-許多ML應用程序在理論上很有用,但在實踐中卻變得毫無用處。 讓我們看一個真實的案例研究,重點介紹兩種類型的偏見,以及如何理解"信任時刻"可以如何通過一個具體例子提供幫助。 最后,我要考慮三個小動作。

故事

我內心的聲音:"她有外遇嗎? 她一定是。 **我!" 當你美麗的妻子突然在離家那么多夜晚的時候,你不能怪我這么想。她從此不必工作太多。

因此,我問:"怎么回事? 你最近怎么這么忙 一切都好嗎?"

杰西:"我不知道你們為什么再繼續制作這些無用的AI東西! 他們不斷使我們做更多的工作。" 好吧,我完全沒有看到那件事。 還有哦 作為一個充滿愛心的丈夫,正確的做法是給她一個擁抱并承擔更多的家務勞動(是的,我做到了。)

更重要的是,為了滿足我的自私好奇心,追求更好地完成自己的工作以及促進機器學習社區的進步,我需要傾聽。

因此,我進行了調查:"告訴我更多。 發生了什么? 你為什么這么說?"

兩種類型的偏見和不同的問題

杰西繼續說:"我們有了這個新的Next Best Action應用程序[ML應用程序]。 每個星期,它會向我們提供要致電的客戶列表和要提供的產品。 真是無用 我看清單。 我與大多數客戶一起工作; 我知道他們不會購買該產品……這是浪費時間,但是我們仍然必須這樣做才能使KPI看起來更好。"

Jess剛剛描述了每個ML應用程序都面臨的兩個獨特問題。 讓我們打開包裝:

1.機器偏差。 機器錯誤; 我們人類是正確的。 機器學習模型不是也不是完美的,即使我們希望并認為它們是完美的。 人們在進行日常工作時會看到大量數據,隨后將其內部化為直覺和知識。 但是此類數據可能無法在數據庫中正確收集或表示。 結果,機器無法充分分析并做出更好的預測。

2.人的偏見。 機器是對的; 我們錯了。 人類有過分自信的偏見。 換句話說,我們通常會高估預測的準確性,尤其是在我們的專業領域。 也許,機器實際上比我們了解更多和最新的信息。 因此可以產生更好的預測。 但是我們比機器更信任自己。

ML社區中的我們許多人可能會立即問:我們如何修復機器(例如模型)? 公司正在招聘更好的數據科學人才,實施更嚴格的ML Ops實踐,并升級到更好的工具。 但是,這樣做只能解決機器偏差問題。 一條鏈與最薄弱的鏈接一樣牢固:ML應用程序的用戶。

我們無法消除人為的內在偏見,但我們可以為信任而設計。 有了信任,用戶就更愿意與機器進行協作。 那么,我們如何在用戶和ML應用程序之間建立信任? -這是我們應該問的問題。

讓我們來看一個具體的示例,并討論如何使用"信任時刻"分析和簡單的UX技術進行信任設計。

一步一步來

實際上,"無用的機器學習經驗"是一個反復出現的主題。 我和杰西在不同的場合遇到了類似的問題。 正如我在《人工智能的最后一英里問題》中所述,歸結為人與人工智能協作的脫節。 解決問題需要采用綜合方法來解決三個方面的問題。

> Author's Analysis, The Last Mile Problems of AI

如果我們不解決這個問題怎么辦? 如果我們不解決信任問題,每個人都會感到沮喪。 像Jess這樣的用戶將不斷抱怨" AI事物"是無用的,并且由于自偏而無法從驚人的技術中受益。 數據科學家可能會失去工作,因為模型的實際結果將永遠與理想的估計不符; 企業將永遠無法實現AI的承諾價值; 最重要的是,我將不得不繼續聽Jess,我在數據科學領域的朋友以及我的客戶互相抱怨。

要構建有用的ML應用程序,我們需要采取許多步驟。 為信任而設計是偉大而簡單的第一步。 現在就采取行動。

建議的動作:

· 在公司中識別面向用戶的ML用例

· 將用戶旅程和信任時刻分析整合到您的ML設計工作流程中

· 主持基于信任時刻的協作設計會議,與來自數據科學,工程和用戶組(例如前線)的代表進行交流。

更深層次的問題與解決方案

信任的時刻#1:讓我們看一下步驟4。這是用戶看到預測,了解預測的含義并決定是否應該以及如何采取行動的那一刻。

問題:用戶沒有根據預測采取行動。 通常,用戶會看到提供或要做的事情的簡單描述(請參見左側的插圖)。 當用戶需要決定是否要遵循時,他們會盲目相信或傾向于當前的判斷。 考慮到我們的過度自信偏見,我們傾向于選擇后者。

換句話說,許多預測(數據科學家們全心全意地做出的預測)從來沒有真正"進入市場"。 它們只是在用戶的屏幕上閃爍,然后消失。

這導致了另外兩個問題。 首先,由于錯誤的原因,用戶與機器的交互將在數據庫中被捕獲為"失敗"。 機器認為由于數學錯誤,交互失敗。 但實際上,它失敗是因為用戶沒有采取行動或未正確執行。 其次,當機器學習時,他們會學習錯誤的現實。 這就是所謂的反饋回路問題(我們將在下面討論)。 結果,它造成了產生不合情理的預測的惡性循環,并最終破壞了用戶的信任。

這些不是預測問題。 他們是UX問題。

目標:此步驟的主要目標應該有兩個:1)增加采取的行動的百分比,2)提高行動的質量。

解決方案:考慮到這一點,我建議用上下文提示代替上下文脫離的建議。 上下文提示應突出顯示使用人類可讀語言執行ML預測的"為什么","什么"和"如何"(左圖)。 根據算法的類型,有多種方法可以將機器決策轉換為人類可讀的語言。

> Step 4 — Presenting Suggestions: The Problem (Left) and The Fix (Right); Author's analysis & expe

信任時刻#2:讓我們看一下用戶共享筆記的第7步。

問題:用戶無法提供良好的反饋。 通常,此界面允許用戶跟蹤進度并與其他成員進行協調。 但是,它通常不是為了捕獲ML應用程序的反饋而設計的(也沒有激勵用戶這樣做)。 如前所述,損壞的反饋回路或不良的反饋回路都會為ML模型從錯誤中學習造成問題。 就像人類一樣,良好的反饋使我們能夠更快更好地學習。

目標:在此步驟中,主要目標是鼓勵用戶為自己和機器分享更好的反饋。

解決方案:最簡單的解決方案是使用大多數人熟悉的UI元素。 這些UI元素可以幫助標準化輸入并縮短輸入信息的時間。

> Step 7 — Collecting Feedback: The Problem (Left) and The Fix (Right); Author's analysis & experie

ML應用程序除了提供用于捕獲反饋的UX外,還可以共享其如何使用反饋來改進未來的預測。 這可以給用戶帶來參與感和獎勵。

注意:所有截圖均已保密。 它們代表具有類似應用程序的組織中的常見元素。

信任時刻

注意:以下示例受Jess作為前線工作的啟發,該工作需要親自為客戶提供服務。 盡管它只關注一個用例,但是這些原理適用于人類需要從ML應用程序中獲取信息并決定如何采取行動的許多過程。

為了更清楚,更具體地了解問題,首先,我們應該看一下"信任時刻",即人們需要基于對機器的信任進行判斷時的瞬間。 我們可以通過使用用戶旅程分析來突出顯示這些時刻。

想象一下,當您去一家銀行的分行與一名顧問會面時,這是從顧問的角度來看的典型旅程-ML應用程序的用戶:

> Moments of Trust Analysis, Author's Experience

了解信任的時刻有助于我們找到用戶可能無法接受機器學習系統的預測時的特定壓力點。 讓我們解開每個信任時刻揭示的問題。

結論

許多ML應用程序被用戶認為是無用的,不是因為預測的準確性,而是因為人為偏見。 作為ML應用程序的設計者和開發者,我們有責任進行信任設計。

解決方案通常很簡單。 通過確定信任時刻,我們可以設計有效的用戶體驗,以提供更多的上下文預測,并閉合反饋循環,從而實現持續改進。

實際上,我們,人類和機器都不完美。 為信任而設計不僅提供快速解決方案,還為人類和機器架起了一座橋梁,以校準我們的信任并共同提高。

-

機器學習

+關注

關注

66文章

8377瀏覽量

132410

發布評論請先 登錄

相關推薦

防雷器件一般有哪兩種類型

兩種電纜類型的特點及優勢

根據電流類型薄膜電容有哪幾種類型

邊沿觸發器主要有哪兩種類型

深度學習與傳統機器學習的對比

cpu控制器的兩種類型和特點

各種類型溫度傳感器介紹

充電樁為什么有直流與交流兩種接口?

800G光模塊的兩種主流封裝

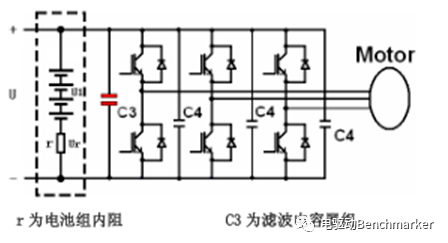

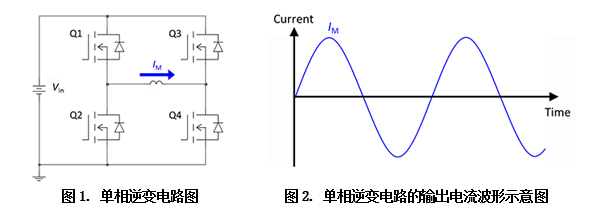

逆變電路分為哪兩種類型

常見的socket三種類型

雷達天線的兩種類型和原理

機器學習兩種類型的偏見

機器學習兩種類型的偏見

評論