監(jiān)督學(xué)習(xí)

監(jiān)督學(xué)習(xí),小編有個簡單的理解方式,按照這個順序來理解

1、有兩撥人,一撥人是好人,一撥是壞人

2、好人的行為特征有:扶老奶奶過馬路,撿到一分錢交給警察叔叔,當(dāng)志愿者等等

3、壞人的行為特征有:偷東西,搶劫,欺負(fù)好人等等

4、有個審判官,根據(jù)你的行為來進(jìn)行判斷是好人還是壞人

5、新進(jìn)來一個小伙伴,由于此人經(jīng)常扶老奶奶過馬路,當(dāng)志愿者等等,因此審判官就把你判斷為好人

這五點(diǎn),融入到機(jī)器學(xué)習(xí)里面,用機(jī)器學(xué)習(xí)的話來說

好人與壞人:標(biāo)簽

好人或者壞人的行為:特征值

審判官:訓(xùn)練好的模型

新來的小伙伴:未知類別,待打上標(biāo)簽的數(shù)據(jù)

這樣子是不是就比較好理解了,機(jī)器學(xué)習(xí)里面,先根據(jù)已有數(shù)據(jù)進(jìn)行模型訓(xùn)練從而得到一個函數(shù),當(dāng)有新的數(shù)據(jù)到來的時候,根據(jù)這個函數(shù)預(yù)測結(jié)果。

監(jiān)督學(xué)習(xí)里面的訓(xùn)練集合包含了輸入與輸出,代表著特征值與標(biāo)簽值。

在一般情況下,用來訓(xùn)練的訓(xùn)練集的標(biāo)簽都是由業(yè)務(wù)方來標(biāo)記,在工作中,最常見的其實(shí)就是數(shù)據(jù)分類了,通過已有的訓(xùn)練的樣本去訓(xùn)練得到一個模型,我們會采用K折交叉驗(yàn)證來進(jìn)行調(diào)參,從而得到參數(shù)的局部最優(yōu)解,再根據(jù)這個模型去預(yù)測數(shù)據(jù)。

在監(jiān)督學(xué)些中,最常見的是回歸與分類,常見的算法有KNN,SVM,隨機(jī)森林等

無監(jiān)督學(xué)習(xí)

相比于監(jiān)督學(xué)習(xí),無監(jiān)督學(xué)習(xí),其實(shí)就是少了這個監(jiān)督,也就是沒有標(biāo)簽。

還是那兩撥人,但是這兩撥人沒有實(shí)現(xiàn)標(biāo)記誰是好人,誰是壞人,他們聚在一起,這時候,上帝之手出現(xiàn)了,它讓這些人喜歡干嘛就去干吧,不要猶豫,于是乎,好人們開始去扶老奶奶過馬路,壞人們開始去當(dāng)小偷,上帝之手成功把這兩撥人給分離開來,接著,給他們分別打上標(biāo)簽:好人,壞人。

這個上帝之手,就是計算機(jī)。

無監(jiān)督學(xué)習(xí)中,有兩種方法

1、基于概率密度函數(shù)直接評估:其實(shí)就是根據(jù)每一個類別的特征在空間的分布情況得到分布參數(shù),根據(jù)這些分布參數(shù)來進(jìn)行分類。

2、基于數(shù)據(jù)樣本之間的相似性進(jìn)行度量的聚類方式:假定每一個類別都有核心(當(dāng)成黑幫老大來理解),以這個核心的特征為標(biāo)準(zhǔn),把其他樣本的特征與這個核心的特征進(jìn)行比較,當(dāng)發(fā)現(xiàn)這是一類人的時候,就整合在一起好了,這樣子,不同類別就出來了。

這就是聚類,算法中,K-Mean,PCA,很多深度學(xué)習(xí)的算法,都是無監(jiān)督學(xué)習(xí)。

兩者的區(qū)別

1、監(jiān)督學(xué)習(xí)必須有訓(xùn)練樣本及測試樣本,對訓(xùn)練樣本進(jìn)行訓(xùn)練得到規(guī)律,再用這個規(guī)律來運(yùn)用在測試樣本上;當(dāng)時無監(jiān)督學(xué)習(xí)就不用,一組數(shù)據(jù),啥都沒有,直接就扔給計算機(jī),讓它自己算。

2、監(jiān)督學(xué)習(xí)必須有標(biāo)簽,無監(jiān)督學(xué)習(xí)不用標(biāo)簽,讓計算機(jī)自己去分類,然后我們?nèi)斯じ鶕?jù)業(yè)務(wù)情況打上標(biāo)簽。

兩者的使用場景

這個說簡單也挺簡單,根據(jù)業(yè)務(wù)方來定,如果業(yè)務(wù)方給了一組數(shù)據(jù),然后還告知了類別,那就用監(jiān)督學(xué)習(xí),反著,則用無監(jiān)督學(xué)習(xí)。

-

函數(shù)

+關(guān)注

關(guān)注

3文章

4306瀏覽量

62431 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8377瀏覽量

132409 -

無監(jiān)督學(xué)習(xí)

+關(guān)注

關(guān)注

1文章

16瀏覽量

2752

發(fā)布評論請先 登錄

相關(guān)推薦

時空引導(dǎo)下的時間序列自監(jiān)督學(xué)習(xí)框架

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識學(xué)習(xí)

【《大語言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)篇

神經(jīng)網(wǎng)絡(luò)如何用無監(jiān)督算法訓(xùn)練

深度學(xué)習(xí)中的無監(jiān)督學(xué)習(xí)方法綜述

基于FPGA的類腦計算平臺 —PYNQ 集群的無監(jiān)督圖像識別類腦計算系統(tǒng)

CVPR'24 Highlight!跟蹤3D空間中的一切!

機(jī)器學(xué)習(xí)基礎(chǔ)知識全攻略

OpenAI推出Sora:AI領(lǐng)域的革命性突破

Meta發(fā)布新型無監(jiān)督視頻預(yù)測模型“V-JEPA”

2024年AI領(lǐng)域?qū)心男┬峦黄颇兀?/a>

使用自監(jiān)督學(xué)習(xí)重建動態(tài)駕駛場景

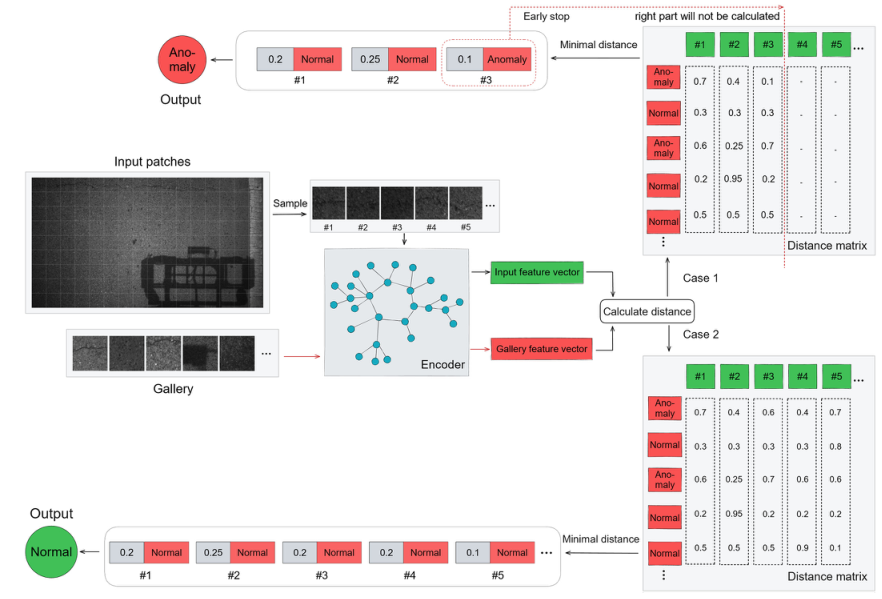

基于transformer和自監(jiān)督學(xué)習(xí)的路面異常檢測方法分享

無監(jiān)督域自適應(yīng)場景:基于檢索增強(qiáng)的情境學(xué)習(xí)實(shí)現(xiàn)知識遷移

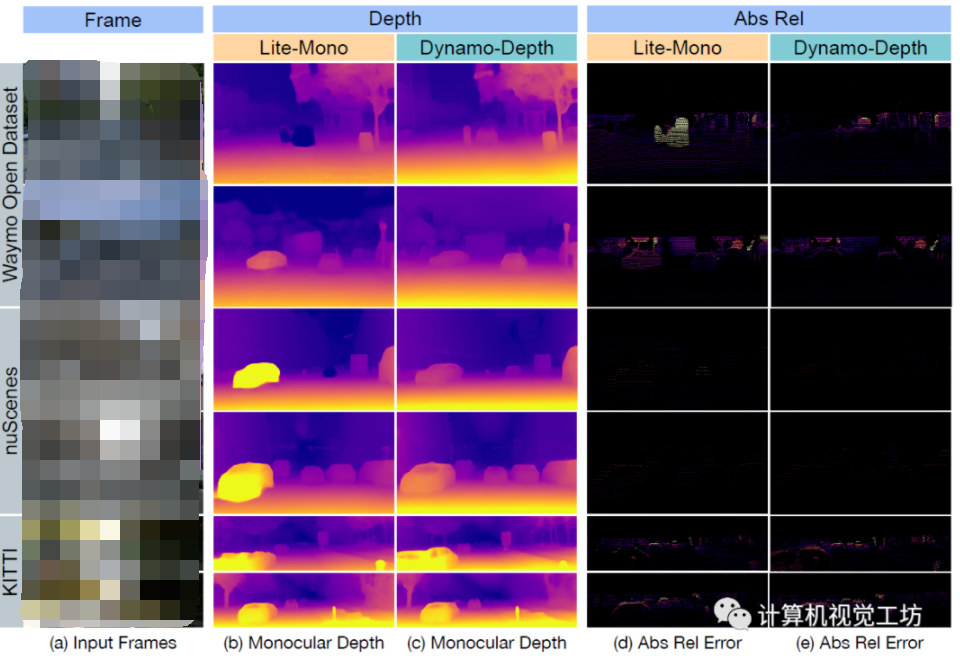

動態(tài)場景下的自監(jiān)督單目深度估計方案

監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)

監(jiān)督學(xué)習(xí)和無監(jiān)督學(xué)習(xí)

評論