開宗明義,三句話認識深度學習。

深度學習是一種機器學習

深度學習首先是一種機器學習。深度學習的基礎,叫做神經網絡,這本身就是一種機器學習算法。近年來,隨著深度學習的火熱和深入人心,人們漸漸將這一概念獨立出來,由此有了深度學習和傳統機器學習的區分。

如今神經網絡快速發展,傳統的機器學習何去何從?

其實,都只是算法,一種解決問題的辦法,而已。

關于算法,關于機器學習,我們引用卡內基梅隆大學(Carnegie Mellon University)Tom Michael Mitchell教授在其1997年出版的書籍Machine Learning中的定義, —— “如果一個程序可以在任務T上,隨著經驗E的增加,效果P也可以隨之增加,則稱這個程序可以從經驗中學習”[1]

怎么理解這句話呢?以推薦系統為例,我們使用某一類機器學習算法(“一個程序”),根據用戶的過往記錄做推薦(“任務T”),那么隨著用戶的過往記錄不斷積累(“經驗E”),能夠做的推薦就更準確(“效果P”)。

簡而言之,機器的“學習”,是通過以往的經驗,即數據,學習數據內部的邏輯,并將學到的邏輯應用在新數據上,進行預測。

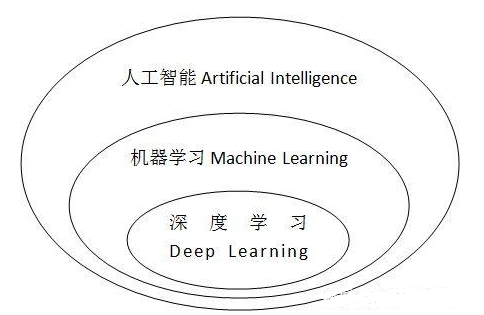

深度學習是一種機器學習,要真的追究起來,人工智能、機器學習和深度學習,三者大概是下面這個關系。

人工智能、機器學習和深度學習三者的關系

深度學習是一個數學問題

機器學習和數學,是深度學習的一體兩面。

機器學習是深度學習的方法論,數學是其背后的理論支撐。

其實每一種算法,究其根本,都是一種數學表達。無論是機器學習,還是深度學習,都是試圖找到一個函數,這個函數可以簡單,可以復雜,函數的表達并不重要,只是一個工具,重要的是這個函數能夠盡可能準確的擬合出輸入數據和輸出結果間的關系。就像我們在各個任務中做的那樣,比如語音識別、圖像識別、下圍棋,人機問答系統:

機器學習在找輸入和輸出之間的關系

這就是機器學習要做到的事,找到一個數學表達,即上述例子中的函數f。

而深度學習的魅力在于,它的數學表達特別的強!

深度學習的強大是有數學原理支撐的,這個原理叫做“萬能近似定理”(Universal approximation theorem)。這個定理的道理很簡單 —— 神經網絡可以擬合任何函數,不管這個函數的表達是多么的復雜。

因為這個定理,深度學習在擬合函數這一方面的能力十分強大、暴力和神秘。

但是,哪有免費的午餐,深度學習的強大也帶來了對應的問題 —— 黑箱化

深度學習是一個黑箱

黑箱的意思是,深度學習的中間過程不可知,深度學習產生的結果不可控。

一方面,我們比較難知道網絡具體在做些什么;另一方面,我們很難解釋神經網絡在解決問題的時候,為什么要這么做,為什么有效果。

在傳統的機器學習中,算法的結構大多充滿了邏輯,這種結構可以被人分析,最終抽象為某種流程圖或者一個代數上的公式,最典型的比如決策樹,具有非常高的可解釋性。

一個決策樹的例子

到了深度學習,這樣子的直觀就不見了。簡單來說,深度學習的工作原理,是通過一層層神經網絡,使得輸入的信息在經過每一層時,都做一個數學擬合,這樣每一層都提供了一個函數。因為深度學習有好多層,通過這每一層的函數的疊加,深度學習網絡的輸出就無限逼近目標輸出了。這樣一種“萬能近似”,很多時候是輸入和輸出在數值上的一種耦合,而不是真的找到了一種代數上的表達式。當我們在說”擬合“、”函數“這一類詞的時候,你或許認為我們會像寫公式一樣把輸入和輸出之間的關系列在黑板上。但事實并不是這樣,深度學習擬合出來的函數,一般人還真寫不出來……

所以,很多時候,你的深度學習網絡能很好的完成你的任務,可是你并不知道網絡學習到了什么,也不知道網絡為什么做出了特定的選擇。知其然而不知其所以然,這可以看作是深度學習的常態,也是深度學習工作中的一大挑戰。

盡管如此,深度學習還是好用的……

誰用誰知道!

所以 ——

擁抱不確定性,愛上深度學習。

-

機器學習

+關注

關注

66文章

8382瀏覽量

132444 -

深度學習

+關注

關注

73文章

5493瀏覽量

120999

發布評論請先 登錄

相關推薦

文生視頻Pika 1.0爆火!一句話生成視頻,普通人也能當“導演”

NPU在深度學習中的應用

開關電源布線 一句話:要運行最穩定、波形最漂亮、電磁兼容性最好

求助,關于AIC3254寄存器的問題求解

FPGA做深度學習能走多遠?

簡單認識深度神經網絡

一句話讓你理解線程和進程

三句話讓你認識深度學習

三句話讓你認識深度學習

評論