(文章來源:千家網)

盡管現今IBM的硬件業務僅限于POWER和Mainframe芯片和系統,但這家技術巨頭正在悄悄地建立自己在AI硬件方面的專業知識和能力。所有人都肯會猜測IBM接下來要干嘛,今天我們主要探討一些關于IBM所做的事情的思考以及對背后原因的猜測。

IBM于2019年初成立了IBM AI硬件研究中心,中心位于紐約州,與紐約州立大學理工學院以及Mellanox、Samsung和Synopsys等技術公司合作進行AI 芯片研究。據介紹,該中心對AI硬件采取整體,端到端的方法,朝著其雄心勃勃的目標努力,即在未來10年內將AI性能提高1000倍。同時,該中心還在開發新的數字和模擬AI內核。

上圖是IBM AI硬件研發中心發布的實現AI性能提升1000倍的概念性路線圖。該路線圖還展示了將采用不同于目前半導體制造使用的全新材料制成新內核的方式。

IBM最近發表了兩篇論文,描述了其降低精度的方法,這些方法旨在提高AI處理效率,同時保留預期的準確性。基本上,在NVIDIA和Google的帶領下,人工智能研究在過去4-5年中一直在利用降低的精度數字和數學運算。如果“降低精度”聽起來好像不是什么好事,但是我們要記住,更高的精度會帶來巨大的成本,使用數字的位長的平方也會增加。因此,從32位到16位成本降低了4倍。

Google最近提出了一種新的16位格式,稱為Bfloat,該格式使用的位數更多,指數尾數更少。高于IEEE 16位浮點標準。與傳統的32位格式相比,這可以在保留精度的同時使用更少的功率和芯片空間。英特爾就是其中之一。但是,研究人員在努力爭取8位浮點數下保持準確性。

IBM本周提出了一種“混合8位浮點數”格式,該格式可以提高性能或將成本降低多達4倍。就是說,如果有人(IBM?)生產出可以執行這些計算進行訓練的芯片,則該芯片將使用已經“量化”為那些8位格式的DNN。這些操作的“混合”性質來自于前向和后向傳播計算所需的不同精度要求。通過將用于指數和尾數的位數調整為向前和向后傳遞計算,IBM證明了確實可以僅使用8位權重和激活來訓練用于視覺、語音和語言處理的神經網絡。此外,這些較小的數字可以更有效地在芯片上進行通信,從而將訓練時間進一步減少了30-60%。

如果所有這些數學運算聽起來很復雜,但其帶來的好處非常簡單。從理論上講,這種方法可以讓人打造用于訓練深度神經網絡的芯片,芯片面積僅為原來的四分之一,或者以相同的成本實現4倍的性能提升。

在AI的推理方面,出于相同的原因,芯片公司和模型開發人員正在轉向8位。但是,有人還能降得更低嗎?迄今為止,使用較低精度的努力未能達到8位模型提供的精度。但是,IBM最近發表了一篇論文,該論文提議使用稱為參數化限幅激活(PACT)和統計感知權重合并(SAWB)的兩種技術,當結合使用時,它們已經演示了2位推理處理,可實現與8位相當的準確性。

如果有人在CPU或AI芯片中使用這些技術,答案可能是“所有人”。 IBM的路線圖肯定意味著該公司將做到這一點,但是就目前而言,這一切都是在IBM研發而非產品部門完成的。IBM經常有一些研究項目從未變成最終產品。IBM通過AI硬件研究成果獲利基本上有三種途徑。首先,它可以將該技術授權可給其他半導體公司用于移動、邊緣和數據中心應用。其次,IBM可以將該技術應用到IBM POWER或大型機處理器中,尤其是2位推理處理。第三,IBM可以生產用于數據中心培訓和推理處理的加速器,直接與NVIDIA,Intel等競爭。

最后一種途徑可能會解決更大的市場需要,但會帶來業務問題,如IBM需要建立一個渠道,以覆蓋其POWER和Mainframe安裝基礎之外的數據中心客戶。例如,IBM可以通過Lenovo出售給正在構建數據中心服務器的ODM。當然,這三種途徑并不是互相排斥的。

(責任編輯:fqj)

-

IBM

+關注

關注

3文章

1749瀏覽量

74631 -

AI

+關注

關注

87文章

30239瀏覽量

268481

發布評論請先 登錄

相關推薦

NPU技術如何提升AI性能

特斯拉加大AI投資,緯創成AI服務器市場贏家

高通CEO:未來五年內將具備AI手機

IBM Cloud將部署英特爾Gaudi 3 AI芯片

成都匯陽投資關于跨越帶寬增長極限,HBM 賦能AI新紀元

三星預計2028年AI相關收入將增長九倍

思科將向AI初創公司投資10億美元

智譜AI劉江:5-10年內AGI會達到普通人水平

軟銀集團將向“AI革命”投資10萬億日元

日本Sakura互聯網投資英偉達B200芯片 助力AI計算及數據中心發展

微軟和OpenAI計劃投資1000億美元建造“星際之門”AI超級計算機

蘋果加碼印度制造,計劃5年內將產量提高5倍

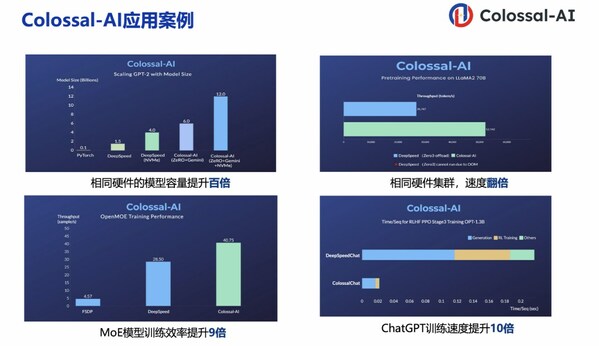

潞晨科技Colossal-AI + 浪潮信息AIStation,大模型開發效率提升10倍

IBM投資AI硬件,計劃10年內將AI性能提升1000倍

IBM投資AI硬件,計劃10年內將AI性能提升1000倍

評論