Apache Spark作為全球最流行的數據分析應用,現已通過此前發布的Spark 3.0版本為超過50萬用戶提供革命性的GPU加速。

Databricks為用戶提供了先進的企業云平臺Spark,每天有超過100萬臺虛擬機運行該平臺。在Spark + AI Summit峰會上,Databricks宣布其用于機器學習的Databricks Runtime 7.0將配備內置Spark 3.0的GPU加速器感知調度功能。該功能由Databricks與NVIDIA和其他社區成員合作開發。

Google Cloud近期宣布在Dataproc image 2.0版本上提供Spark 3.0預覽版,同時指出在開源社區的協作下,現在已獲得強大的NVIDIA GPU加速。NVIDIA將于7月16日與Google Cloud共同舉辦一場網絡研討會,深入探討這些令數據科學家感到興奮的新功能。

此外,用于Apache Spark的新開源RAPIDS 加速器現在可以加速ETL(提取、轉換、加載)和數據傳輸,在無需更改任何代碼的情況下提高端到端分析性能。

Spark性能的加速不僅意味著能夠更快獲得洞見,而且由于企業可以使用更少的基礎設施來完成工作負載,因此還可以幫助企業降低成本。

加速數據分析:科學計算賦予AI更強大的力量

Spark有充分的理由成為新聞媒體報導的焦點。

數據對于幫助企業機構應對不斷變化的機遇和潛在威脅至關重要。為此,他們需要破譯隱藏在數據中的關鍵線索。

每當客戶點擊網站、撥打客戶服務電話或生成每日銷售報告時,就會給企業機構貢獻大量的信息。隨著AI的興起,數據分析對于幫助公司發現趨勢并保持市場領先地位所起到的作用日益重要。

前不久,數據分析還依靠小型數據集來收集歷史數據和洞見,通過ETL對存儲在傳統數據倉庫中的高度結構化數據進行分析。

ETL常常成為數據科學家在獲取AI預測和建議時的瓶頸。ETL預計會占用數據科學家70%至90%的時間,這會減慢工作流程并將炙手可熱的人才束縛在最普通的工作上。

當數據科學家在等待ETL時,他們無法重新訓練模型來獲取更好的商業洞見。傳統的CPU基礎設施無法通過有效的擴展來適應這些工作任務,這通常會大幅增加成本。

憑借GPU加速的Spark,ETL就不會再產生這樣的麻煩。醫療、娛樂、能源、金融、零售等行業現在可以經濟、高效地為其數據分析提速,更快地獲取洞見。

并行處理助力數據分析

GPU并行處理使計算機可以一次執行多項操作。數據中心通過大規模橫向擴展這些功能來支持復雜的數據分析項目。隨著運用AI和機器學習工具的企業機構日益增加,并行處理已成為加速海量數據分析和ETL管道,進而驅動這些工作負載的關鍵。

比如有一家零售商希望預測下一個季節的庫存。該零售商需要檢查近期的銷售量以及去年的數據。數據科學家還可可以此分析中添加天氣模型,從而了解雨季或旱季對結果產生的影響。零售商還可以整合情緒分析數據,評估今年最流行的趨勢。

由于需要分析的數據源太多,因此在對不同變量可能對銷售量產生的影響進行建模時,速度就顯得尤為重要。這就需要將分析加入到機器學習中,而且GPU也因此變得十分重要。

RAPIDS加速器為Apache Spark 3.0提速

隨著數據科學家從使用傳統的分析轉而采用可以更好地對復雜市場需求進行建模的AI應用,如果繼續采用CPU,則必須犧牲速度或增加成本才能跟上由此產生的處理需求。而隨著AI在分析中的應用日益增加,需要有新的框架來通過GPU快速、經濟高效地處理數據。

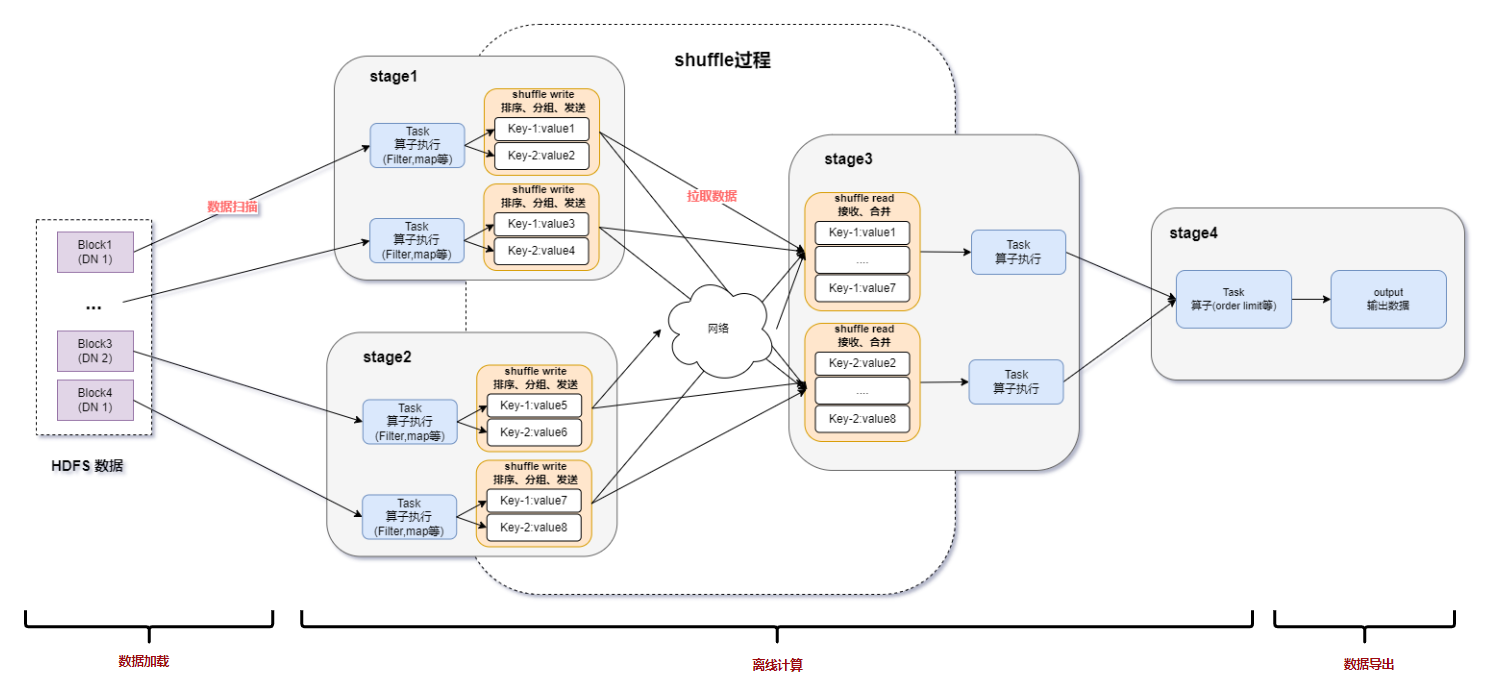

用于Apache Spark的全新RAPIDS加速器將Spark分布式計算框架與功能強大的RAPIDS cuDF庫相連接,實現了GPU對Spark DataFrame和Spark SQL的運行提速。RAPIDS加速器還通過搜索在Spark節點之間移動數據的最快路徑來加快Spark Shuffle的運行速度。

責任編輯:tzh

-

醫療

+關注

關注

8文章

1801瀏覽量

58660 -

AI

+關注

關注

87文章

30166瀏覽量

268428

發布評論請先 登錄

相關推薦

LLM在數據分析中的作用

eda與傳統數據分析的區別

raid 在大數據分析中的應用

SUMIF函數在數據分析中的應用

智能制造中的數據分析應用

數據分析除了spss還有什么

數據分析的工具有哪些

數據分析有哪些分析方法

機器學習在數據分析中的應用

Spark基于DPU的Native引擎算子卸載方案

求助,關于AD采集到的數據分析問題

Spark基于DPU Snappy壓縮算法的異構加速方案

基于DPU和HADOS-RACE加速Spark 3.x

Apache Spark作為全球最流行的數據分析應用

Apache Spark作為全球最流行的數據分析應用

評論