在這篇文章中,將教大家實現(xiàn)一個網(wǎng)頁應(yīng)用程序,該程序可以接收狗的圖片,然后輸出其品種,其準確率超過80%!

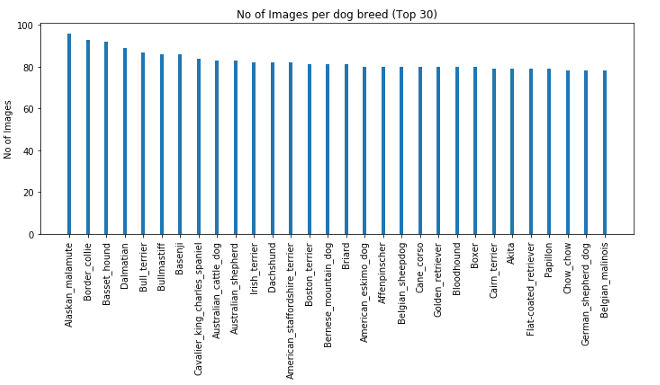

我們將使用深度學(xué)習(xí)來訓(xùn)練一個識別狗品種的模型,數(shù)據(jù)集是狗圖像與他們的品種信息,通過學(xué)習(xí)圖像的特征來區(qū)分狗的品種。數(shù)據(jù)分析數(shù)據(jù)集可以從這里下載(https://s3-us-west-1.a(chǎn)mazonaws.com/udacity-aind/dog-project/dogImages.zip)。以下是關(guān)于數(shù)據(jù)的一些介紹:犬種總數(shù):133狗圖片總數(shù):8351(訓(xùn)練集:6680,驗證集:835,測試集:836)最受歡迎的品種:阿拉斯加對應(yīng)96個樣本,博德牧羊犬對應(yīng)93個樣本按圖片數(shù)量排序的前30個品種如下:

我們還可以在這里看到一些狗的圖片和它們的品種:

數(shù)據(jù)預(yù)處理我們會把每個圖像作為一個numpy數(shù)組進行加載,并將它們的大小調(diào)整為224x224,這是大多數(shù)傳統(tǒng)神經(jīng)網(wǎng)絡(luò)接受圖像的默認大小,另外我們?yōu)閳D像的數(shù)量添加為另一個維度。from keras.preprocessing import image from tqdm import tqdm

def path_to_tensor(img_path): '''將給定路徑下的圖像轉(zhuǎn)換為張量''' img = image.load_img(img_path, target_size=(224, 224)) x = image.img_to_array(img) return np.expand_dims(x, axis=0)

def paths_to_tensor(img_paths): '''將給定路徑中的所有圖像轉(zhuǎn)換為張量''' list_of_tensors = [path_to_tensor(img_path) for img_path in tqdm(img_paths)] return np.vstack(list_of_tensors)最后,我們使用ImageDataGenerator對圖像進行動態(tài)縮放和增強train_datagen = tf.keras.preprocessing.image.ImageDataGenerator(rescale=1./255, horizontal_flip=True, vertical_flip=True, rotation_range=20)

valid_datagen = tf.keras.preprocessing.image.ImageDataGenerator(rescale=1./255.)

test_datagen = tf.keras.preprocessing.image.ImageDataGenerator(rescale=1./255.)

train_generator = train_datagen.flow(train_tensors, train_targets, batch_size=32)valid_generator = train_datagen.flow(valid_tensors, valid_targets, batch_size=32)test_generator = train_datagen.flow(test_tensors, test_targets, batch_size=32)CNN我們將在預(yù)處理數(shù)據(jù)集上從頭開始訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò)(CNN),如下所示:model = tf.keras.models.Sequential([ tf.keras.layers.Conv2D(16, (3,3), activation='relu', input_shape=(224, 224, 3)), tf.keras.layers.MaxPooling2D(2, 2), tf.keras.layers.Conv2D(32, (3,3), activation='relu'), tf.keras.layers.MaxPooling2D(2,2), tf.keras.layers.Conv2D(64, (3,3), activation='relu'), tf.keras.layers.MaxPooling2D(2,2), tf.keras.layers.Conv2D(128, (3,3), activation='relu'), tf.keras.layers.MaxPooling2D(2,2), tf.keras.layers.Conv2D(256, (3,3), activation='relu'), tf.keras.layers.MaxPooling2D(2,2), tf.keras.layers.Flatten(), tf.keras.layers.Dense(2048, activation='softmax'), tf.keras.layers.Dropout(0.5), tf.keras.layers.Dense(1024, activation='softmax'), tf.keras.layers.Dropout(0.5), tf.keras.layers.Dense(133, activation='softmax')])

model.compile(optimizer='rmsprop', loss='categorical_crossentropy', metrics=['accuracy'])

checkpointer = tf.keras.callbacks.ModelCheckpoint(filepath='../saved_models/weights_best_custom.hdf5', verbose=1, save_best_only=True)

model.fit(train_generator, epochs=5, validation_data=valid_generator, callbacks=[checkpointer])我們使用一個ModelCheckpoint的回調(diào)來保存驗證分數(shù)較高的模型。通過測試模型,我們得到的準確率只有1%左右使用遷移學(xué)習(xí)現(xiàn)在,我們使用遷移學(xué)習(xí)來實現(xiàn)更高的準確率。首先我們下載ResNet-50,可以通過運行下面的代碼來提取相應(yīng)的訓(xùn)練集、測試和驗證集:bottleneck_features = np.load('Data/bottleneck_features/DogResnet50Data.npz')train_Resnet50 = bottleneck_features['train']valid_Resnet50 = bottleneck_features['valid']test_Resnet50 = bottleneck_features['test']我們現(xiàn)在再次定義模型,并對提取的特征使用GlobalAveragePooling2D,它將一組特征平均為一個值。最后,如果驗證損失在兩個連續(xù)的epoch內(nèi)沒有增加,我們使用額外的回調(diào)來降低學(xué)習(xí)率;如果驗證損失在連續(xù)的5個epoch內(nèi)沒有增加,可以提前停止訓(xùn)練。Resnet50_model = tf.keras.models.Sequential()Resnet50_model.a(chǎn)dd(tf.keras.layers.GlobalAveragePooling2D(input_shape=train_Resnet50.shape[1:]))Resnet50_model.a(chǎn)dd(tf.keras.layers.Dense(1024, activation='relu'))Resnet50_model.a(chǎn)dd(tf.keras.layers.Dense(133, activation='softmax'))

Resnet50_model.compile(loss='categorical_crossentropy', optimizer='rmsprop', metrics=['accuracy'])

checkpointer = tf.keras.callbacks.ModelCheckpoint(filepath='saved_models/weights_best_Resnet50.hdf5', verbose=1, save_best_only=True)early_stopping = tf.keras.callbacks.EarlyStopping(patience=5, monitor='val_loss')

reduce_lr = tf.keras.callbacks.ReduceLROnPlateau(patience=2, monitor='val_loss')Resnet50_model.fit(train_Resnet50, train_targets, validation_data=(valid_Resnet50, valid_targets), epochs=50, batch_size=20, callbacks=[checkpointer, early_stopping, reduce_lr], verbose=1)### 訓(xùn)練模型最后在測試集上的準確率為82.65%,這與我們白手起家訓(xùn)練的模型相比,是一個巨大的進步。構(gòu)建web應(yīng)用程序?qū)τ趙eb應(yīng)用程序,我們首先編寫了一個helper函數(shù),該函數(shù)接受圖像路徑并返回品種。label_to_cat字典將每個數(shù)字標簽映射到它的狗品種。def predict_breed(img_path): '''預(yù)測給定圖像的品種''' # 提取特征 bottleneck_feature = extract_Resnet50(path_to_tensor(img_path)) bottleneck_feature = tf.keras.models.Sequential([ tf.keras.layers.GlobalAveragePooling2D(input_shape=bottleneck_feature.shape[1:]) ]).predict(bottleneck_feature).reshape(1, 1, 1, 2048) # 獲得預(yù)測向量 predicted_vector = Resnet50_model.predict(bottleneck_feature) # 模型預(yù)測的犬種 return label_to_cat[np.a(chǎn)rgmax(predicted_vector)]對于web應(yīng)用程序,我們將使用flaskweb框架來幫助我們用最少的代碼創(chuàng)建web應(yīng)用程序。我們定義一個接受圖像的路由,并用狗的品種呈現(xiàn)一個輸出模板@app.route('/upload', methods=['POST','GET'])def upload_file(): if request.method == 'GET': return render_template('index.html') else: file = request.files['image'] full_name = os.path.join(UPLOAD_FOLDER, file.filename) file.save(full_name) dog_breed = dog_breed_classifier(full_name) return render_template('predict.html', image_file_name = file.filename, label = dog_breed)predict.html是分別顯示圖像及其犬種的模板。

結(jié)論

祝賀你!你已經(jīng)成功地實現(xiàn)了一個狗品種分類器,并且可以準確地分辨出狗的品種。讓我們總結(jié)一下我們在這里學(xué)到的知識:我們對數(shù)據(jù)集進行了分析和預(yù)處理。機器學(xué)習(xí)算法需要單獨的訓(xùn)練集、測試集和驗證集來進行置信預(yù)測。我們從零開始使用CNN,由于未能提取特征,所以表現(xiàn)不佳。然后我們使用了遷移學(xué)習(xí),準確度大大提高最后,我們構(gòu)建了一個Flask web應(yīng)用程序來實現(xiàn)我們的項目封裝我們確實學(xué)到了很多東西,但你還可以嘗試很多其他的事情。你可以在heroku上部署web應(yīng)用程序,也可以嘗試使用不同的層(如Dropout層)來提高準確性。

參考鏈接:https://towardsdatascience.com/dont-know-the-breed-of-your-dog-ml-can-h(huán)elp-6558eb5f7f05

責(zé)編AJX

-

算法

+關(guān)注

關(guān)注

23文章

4599瀏覽量

92639 -

應(yīng)用程序

+關(guān)注

關(guān)注

37文章

3240瀏覽量

57600 -

python

+關(guān)注

關(guān)注

56文章

4782瀏覽量

84449

發(fā)布評論請先 登錄

相關(guān)推薦

用C#編寫一個抓網(wǎng)頁的應(yīng)用程序

python實現(xiàn)網(wǎng)頁爬蟲爬取圖片

在線客服源碼C++、ASP、PHP等的比較

利用FTP實現(xiàn)應(yīng)用程序的遠程更新

奧迪quattro coaster AR應(yīng)用程序可“識別”具體的奧迪電視廣告

STM32和TFT彩屏顯示圖片程序(附取模軟件)免費下載

python3.3抓取網(wǎng)頁數(shù)據(jù)的程序資料免費下載

如何利用Python和函數(shù)庫進行簡單的人臉識別?(附源碼)

使用Python實現(xiàn)車牌識別的程序免費下載

不同應(yīng)用程序的存儲IO類型解析

python v3.8.0應(yīng)用程序免費下載

利用Python實現(xiàn)網(wǎng)頁應(yīng)用程序,可圖片識別狗的類型(附源碼)

利用Python實現(xiàn)網(wǎng)頁應(yīng)用程序,可圖片識別狗的類型(附源碼)

評論