Speech2Video 是一種從語(yǔ)音音頻輸入合成人體全身運(yùn)動(dòng)(包括頭、口、臂等)視頻的任務(wù),其產(chǎn)生的視頻應(yīng)該在視覺(jué)上是自然的,并且與給定的語(yǔ)音一致。傳統(tǒng)的 Speech2Video 方法一般會(huì)使用專(zhuān)用設(shè)備和專(zhuān)業(yè)操作員進(jìn)行性能捕獲,且大多數(shù)語(yǔ)音和渲染任務(wù)是由動(dòng)畫(huà)師完成的,定制使用的成本通常比較昂貴。

近年來(lái),隨著深度神經(jīng)網(wǎng)絡(luò)的成功應(yīng)用,數(shù)據(jù)驅(qū)動(dòng)的方法已經(jīng)成為現(xiàn)實(shí)。例如,SythesisObama 或 MouthEditing 通過(guò)使用 RNN 通過(guò)語(yǔ)音驅(qū)動(dòng)嘴部運(yùn)動(dòng)來(lái)合成說(shuō)話(huà)的嘴部。泰勒 提出使用音頻來(lái)驅(qū)動(dòng)高保真圖形模型,該模型不僅可以將嘴部動(dòng)畫(huà)化,而且還可以對(duì)面部的其他部分進(jìn)行動(dòng)畫(huà)處理以獲得更豐富的語(yǔ)音表達(dá)。

然而,嘴部運(yùn)動(dòng)的合成大部分是確定性的:給定發(fā)音,在不同的人和環(huán)境中嘴部的運(yùn)動(dòng)或形狀是相似的。但現(xiàn)實(shí)生活中,相同情況下的全身手勢(shì)運(yùn)動(dòng)具有更高的生成力和更多的變異性,這些手勢(shì)高度依賴(lài)于當(dāng)前的上下文和正在執(zhí)行語(yǔ)音的人類(lèi)。傳遞重要信息時(shí),個(gè)性化的手勢(shì)會(huì)在特定時(shí)刻出現(xiàn)。因此,有用的信息僅稀疏地存在于視頻中,這為簡(jiǎn)單的端到端學(xué)習(xí)算法 有限的錄制視頻中捕獲這種多樣性帶來(lái)了困難。

近日,百度提出了一種新的方法,將給定文字或音頻轉(zhuǎn)換為具有同步、逼真、富表現(xiàn)力的肢體語(yǔ)言的實(shí)感視頻。該方法首先使用遞歸神經(jīng)網(wǎng)絡(luò)(recursive neural network,RNN)從音頻序列生成 3D 骨骼運(yùn)動(dòng),然后通過(guò)條件生成對(duì)抗網(wǎng)絡(luò)(GAN)合成輸出視頻。

為了使骨骼運(yùn)動(dòng)逼真并富有表現(xiàn)力,研究者將關(guān)節(jié) 3D 人體骨骼的知識(shí)和學(xué)習(xí)過(guò)的個(gè)性化語(yǔ)音手勢(shì)字典嵌入到學(xué)習(xí)和測(cè)試過(guò)程中。前者可以防止產(chǎn)生不合理的身體變形,而后者通過(guò)一些有意義的身體運(yùn)動(dòng)視頻幫助模型快速學(xué)習(xí)。為了制作富有運(yùn)動(dòng)細(xì)節(jié)的逼真高分辨率視頻,研究者提出一種有條件的 GAN,其中每個(gè)細(xì)節(jié)部分,例如頭和手,是自動(dòng)放大過(guò)的以擁有自己的判別器。該方法與以前處理類(lèi)似任務(wù)的 SOTA 方法相比效果更好。

方法

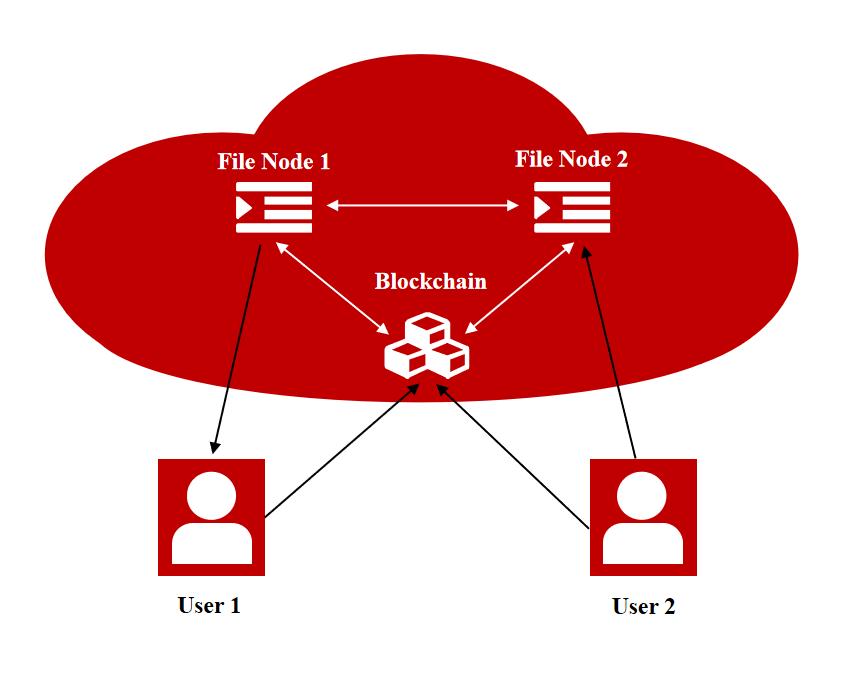

圖 1:Speech2Video 系統(tǒng) pipeline

如圖 1 所示,根據(jù)用于訓(xùn)練 LSTM 網(wǎng)絡(luò)的內(nèi)容,系統(tǒng)的輸入是音頻或文本。考慮到文本到語(yǔ)音(TTS)和語(yǔ)音到文本(STT)技術(shù)都已經(jīng)成熟并且可商用,此處假定音頻和 text 是可互換的。即使從最先進(jìn)的 STT 引擎中得到一些錯(cuò)誤識(shí)別的單詞 / 字符,系統(tǒng)也可以容忍這些錯(cuò)誤,LSTM 網(wǎng)絡(luò)的主要目的是將文本 / 音頻映射到身體形狀。錯(cuò)誤的 STT 輸出通常是與真實(shí)發(fā)音相似的單詞,這意味著它們的拼寫(xiě)也很可能是相似的。因此,它們最終將映射的身體形狀或多或少相似。

LSTM 的輸出是由 SMPL-X 參數(shù)化的一系列人體姿勢(shì)。SMPL-X 是一個(gè)人體、面部和手部的 3D 聯(lián)合模型,這一動(dòng)態(tài)關(guān)節(jié) 3D 模型是由一個(gè) 2D 彩色骨架圖像序列可視化的。這些 2D 圖像被進(jìn)一步輸入到 vid2vid 生成網(wǎng)絡(luò)中,以生成最終的現(xiàn)實(shí)人物圖像。

在成功同步語(yǔ)音和動(dòng)作的同時(shí),LSTM 大部分時(shí)間只能學(xué)習(xí)重復(fù)的人類(lèi)動(dòng)作,這會(huì)使視頻看起來(lái)很無(wú)聊。為了使人體動(dòng)作更具表現(xiàn)力和變化性,研究者在一些關(guān)鍵詞出現(xiàn)時(shí)將特定姿勢(shì)加入 LSTM 的輸出動(dòng)作中,例如,巨大、微小、高、低等。研究者建立了一個(gè)字典,將這些關(guān)鍵詞映射到它們相應(yīng)的姿勢(shì)。

模特站在相機(jī)和屏幕的前面,當(dāng)他 / 她在屏幕上閱讀腳本時(shí),研究者會(huì)捕獲這些視頻。最后再要求模特?cái)[一些關(guān)鍵詞的動(dòng)作,例如巨大、微小、向上、向下、我、你等等。

人體模型擬合

研究者首先將這些 2D 關(guān)鍵點(diǎn)作為人體模型的表示,并訓(xùn)練了 LSTM 網(wǎng)絡(luò),但結(jié)果不能令人滿(mǎn)意。

最后采用了 SMPL-X,這是一種關(guān)節(jié)式 3D 人體模型。SMPL-X 使用運(yùn)動(dòng)學(xué)骨架模型對(duì)人體動(dòng)力學(xué)進(jìn)行建模,具有 54 個(gè)關(guān)節(jié),包括脖子、手指、手臂、腿和腳。

詞典構(gòu)建和關(guān)鍵姿勢(shì)插入

研究者從錄制的視頻中手動(dòng)選擇關(guān)鍵姿勢(shì),并建立一個(gè)單詞 - 姿勢(shì)查詢(xún)字典。同樣,該姿勢(shì)表示為 106 個(gè) SMPL-X 參數(shù)。關(guān)鍵姿勢(shì)可以是靜止的單幀姿勢(shì)或多幀運(yùn)動(dòng),可以通過(guò)相同的方法將兩者插入到現(xiàn)有的人體骨骼視頻中。

訓(xùn)練視頻生成網(wǎng)絡(luò)

研究者采用 vid2vid 提出的生成網(wǎng)絡(luò),將骨架圖像轉(zhuǎn)換為真實(shí)的人像。

用于訓(xùn)練 vid2vid 的示例圖像對(duì)。雙手均帶有特殊的色環(huán)標(biāo)記。

運(yùn)行時(shí)間和硬件方面,系統(tǒng)中最耗時(shí)和最耗內(nèi)存的階段是訓(xùn)練 vid2vid 網(wǎng)絡(luò)。在 8 個(gè) NVIDIA Tesla M40 24G GPU 集群上完成 20 個(gè)時(shí)期的訓(xùn)練大約需要一周;測(cè)試階段要快得多,在單個(gè) GPU 上生成一幀僅需約 0.5 秒。

結(jié)果

評(píng)估與分析

研究者將使用用戶(hù)研究的結(jié)果與 4 種 SOTA 方法進(jìn)行比較,結(jié)果顯示,本文方法獲得了最佳的總體質(zhì)量得分。

此外,研究者使用 Inception 分?jǐn)?shù)評(píng)估圖像生成結(jié)果,包括兩個(gè)方面:圖像質(zhì)量和圖像多樣性。

為了評(píng)估最終輸出的視頻,研究者在 Amazon Mechanical Turk(AMT)上進(jìn)行了人類(lèi)主觀(guān)測(cè)試,共有 112 名參與者。研究者向參與者展示了總共五個(gè)視頻,其中四個(gè)是合成視頻,兩個(gè)由真實(shí)人的音頻生成,兩個(gè)由 TTS 音頻生成;剩下的是一個(gè)真實(shí)人物的短片。參與者以李克特量表(從 1(強(qiáng)烈不同意)到 5(強(qiáng)烈同意))對(duì)這些視頻的質(zhì)量進(jìn)行評(píng)分。其中包括:1)人體的完整性(沒(méi)有遺漏的身體部位或手指);2)視頻中人臉清晰;3)視頻中的人體動(dòng)作(手臂,手,身體手勢(shì))看起來(lái)自然流暢。4)身體的動(dòng)作和手勢(shì)與聲音同步;5)視頻的整體視覺(jué)質(zhì)量。

總結(jié)

Speech2Video 是一種新穎的框架,可以使用 3D 驅(qū)動(dòng)的方法生成逼真的語(yǔ)音視頻,同時(shí)避免構(gòu)建 3D 網(wǎng)格模型。作者在框架內(nèi)建立了個(gè)性化關(guān)鍵手勢(shì)表,以處理數(shù)據(jù)稀疏性和多樣性的問(wèn)題。更重要的是,作者利用 3D 骨骼約束來(lái)生成身體動(dòng)力學(xué),從而保證其姿勢(shì)在物理上是合理的。

責(zé)任編輯:pj

-

3D

+關(guān)注

關(guān)注

9文章

2863瀏覽量

107331 -

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4764瀏覽量

100545 -

數(shù)據(jù)驅(qū)動(dòng)

+關(guān)注

關(guān)注

0文章

124瀏覽量

12319

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

數(shù)字王國(guó)與AWS達(dá)成合作,推動(dòng)自主虛擬人技術(shù)云端發(fā)展

發(fā)掘3D文件格式的無(wú)限潛力:打造沉浸式虛擬世界

微軟Azure AI語(yǔ)音服務(wù)革新:引入虛擬人形象,文本一鍵轉(zhuǎn)生動(dòng)視頻

使用NVIDIA Edify助力的服務(wù)創(chuàng)建3D資產(chǎn)和虛擬環(huán)境照明

英倫科技10.1寸裸眼3D平板電腦的五大特點(diǎn)

什么是光場(chǎng)裸眼3D?

3D建模的特點(diǎn)和優(yōu)勢(shì)都有哪些?

VR虛擬空間中的3D 技術(shù)

抖音嚴(yán)打不當(dāng)虛擬人物AI生成行為,優(yōu)化平臺(tái)生態(tài)環(huán)境

搶灘賽道先機(jī)走出科創(chuàng)新路,布局AI+虛擬人驅(qū)動(dòng)微美全息(WIMI.US)快速搶占市場(chǎng)新空間

AI克隆技術(shù)可用于創(chuàng)建虛擬人物形象!它的技術(shù)原理和發(fā)展趨勢(shì)

子曰教育大模型加速落地應(yīng)用:推出虛擬人AI產(chǎn)品,新增口語(yǔ)定級(jí)等功能

提供3D打印材料與解決方案,助力3D打印產(chǎn)業(yè)發(fā)展

虛擬人產(chǎn)業(yè)鏈及市場(chǎng)前景報(bào)告

關(guān)于語(yǔ)音驅(qū)動(dòng)3D虛擬人性能介紹

關(guān)于語(yǔ)音驅(qū)動(dòng)3D虛擬人性能介紹

評(píng)論