首發(fā):AIWalker

標題&作者團隊

1. 論文簡要

在這項工作中,視頻中的3D姿態(tài)可以通過全卷積模型來估計,具體是在二維關(guān)鍵點上通過空洞時間卷積的模型得到3D姿態(tài)。我們還介紹了一種不帶標簽(反向投影)的半監(jiān)督式訓練方法。我們先從未標注視頻中得到2D姿態(tài),然后估計3D姿態(tài)和最后反向投影到輸入的2D關(guān)鍵點。在實驗中,全卷積模型相比之前state-of-arts,在Human3.6 M上平均每個關(guān)節(jié)位置誤差小6mm,對應(yīng)誤差降低11%,模型在HumanEva-I中也有顯著改進。

代碼和模型的下載地址:https://github.com/facebookre...

2. 背景介紹

我們的工作重點是視頻中的三維人體姿態(tài)估計。我們以最先進的方法為基礎(chǔ),然后將問題描述為2D關(guān)鍵點檢測三維姿態(tài)估計,這種方法可能導(dǎo)致不同的3D姿態(tài)對應(yīng)相同的2D關(guān)鍵點。早期為解決這一問題主要通過RNN構(gòu)建時序信息,但是由于RNN的串行結(jié)構(gòu)無法多幀并行處理,因此本文提出一個完整的卷積架構(gòu),在二維關(guān)鍵點上執(zhí)行時序卷積用于視頻中準確的三維姿態(tài)預(yù)測,該方法兼容任何二維關(guān)鍵點檢測器,并能通過空洞卷積有效地處理較大的上下文信息。與依賴RNNs的方法相比,它在計算復(fù)雜度和參數(shù)數(shù)量方面都提供了更高的精度、簡單性和效率。

在構(gòu)建一個高度精確和高效的架構(gòu)之后,接下來需要關(guān)注訓練數(shù)據(jù),本文引入了半監(jiān)督訓練的方案,因為3D姿態(tài)的監(jiān)督學習需要大量的帶標簽的訓練數(shù)據(jù),收集3D人體姿態(tài)標簽需要昂貴的動作捕捉設(shè)備和長時間錄制。本文的方法的靈感來自于無監(jiān)督機器翻譯中的循環(huán)一致性,即翻譯到中間語言和翻譯回原始語言的往返應(yīng)該接近恒等函數(shù)。具體地說,使用現(xiàn)有的2D關(guān)鍵點檢測器為未標記的視頻預(yù)測2D關(guān)鍵點,然后預(yù)測3D姿態(tài),最后將它們映射回2D空間中。

本文創(chuàng)新點有兩個:(1)在網(wǎng)絡(luò)結(jié)構(gòu)方面,基于空洞時序卷積將2D關(guān)鍵點軌跡推理出3D人體姿態(tài),在計算量和模型參數(shù)量上遠小于基于RNN的模型;(2)在訓練數(shù)據(jù)方面,采用半監(jiān)督學習解決數(shù)據(jù)量不足的問題,相比于其他方法,該方法僅僅需要相機內(nèi)部參數(shù)(數(shù)據(jù)增強的過程中需要相機參數(shù)對ground-truth姿態(tài)進行幾何變換),不需要2D標簽或帶有外部攝像機參數(shù)的多視圖圖像。

image-20201126105219606

3. 相關(guān)工作

在深度學習成功之前,大部分的三維姿態(tài)估計方法都是基于特征工程和骨骼和關(guān)節(jié)靈活性的假設(shè)。目前大多數(shù)的姿態(tài)估計方法是在二維姿態(tài)估計器的基礎(chǔ)上,建立了一種新的三維姿態(tài)估計器,然后 被提升到3D空間中。

視頻姿態(tài)估計,大多數(shù)以前的工作都是在單幀的背景下進行的,但最近幾年利用視頻的時間信息來產(chǎn)生更可靠的預(yù)測,并降低對噪音的敏感性。最近,有人提出了LSTM序列到序列學習模型,該模型將視頻中的二維姿態(tài)序列編碼為固定大小的向量,然后解碼為三維姿態(tài)序列。然而,輸入和輸出序列具有相同的長度,2D姿態(tài)的確定性轉(zhuǎn)換是更自然的選擇。用seq2seq模型進行的實驗表明,輸出姿勢在較長的序列上容易產(chǎn)生漂移。

4. 本文方法

4.1 時序空洞卷積模型

image-20201126112311029

我們的模型是一個具有殘差結(jié)構(gòu)的完全卷積的架構(gòu),它將一個2D姿態(tài)序列作為輸入,并通過時間卷積對其進行轉(zhuǎn)換。卷積模型允許在批處理維度和時間維度上并行化,而RNNs不能在時間維度上并行化。在卷積模型中,無論序列長度如何,輸出和輸入之間的梯度路徑都是固定長度的,這可以緩解影響RNN的消失和爆炸梯度。卷積架構(gòu)也提供了對時間感受域的精確控制,這有利于建立三維姿態(tài)估計任務(wù)的時間依賴模型。此外,使用空洞卷積能夠?qū)﹂L期依賴關(guān)系進行建模,同時也保持較高計算效率。(上圖表示帶有2D關(guān)鍵點的243幀圖像,經(jīng)過網(wǎng)絡(luò)推理得到3D關(guān)節(jié)點)

4.2 半監(jiān)督訓練方法

image-20201126113555405

本文引入了一種半監(jiān)督訓練方法,以提高真實的標記數(shù)據(jù)不足的情況下的模型的準確性。我們利用未標記的視頻,然后結(jié)合一個現(xiàn)成的2D關(guān)鍵點檢測器,來擴展監(jiān)督損失函數(shù)一個反向投影損失項。解決了未標記數(shù)據(jù)的自動編碼問題:編碼器(位姿估計器)根據(jù)二維關(guān)節(jié)坐標進行三維位姿估計,解碼器(投影層)將三維位姿投影回二維關(guān)節(jié)坐標。當來自解碼器的二維關(guān)節(jié)坐標遠離原始輸入時,訓練就會受到懲罰。

上圖將監(jiān)督組件與充當正則化器的非監(jiān)督組件組合在一起。這兩個目標是共同優(yōu)化的,標記數(shù)據(jù)占據(jù)Batch的前半部分,未標記數(shù)據(jù)占據(jù)Batch的后半部分一半。對于標記數(shù)據(jù),我們使用真實三維姿態(tài)作為目標,訓練一個監(jiān)督損失。未標記的數(shù)據(jù)用于實現(xiàn)自動編碼器損失,其中預(yù)測的3D姿態(tài)被投影回2D,然后檢查與輸入的一致性。

軌跡模型,由于透視投影,屏幕上的2D姿態(tài)都取決于軌跡(人體根節(jié)點整體位置,可以理解成人體中心點)和3D姿態(tài)(所有關(guān)節(jié)點相對于根關(guān)節(jié)的位置)。目標函數(shù)為每個關(guān)節(jié)的加權(quán)平均軌跡的位置誤差(WMPJPE)。

骨骼長度損失,添加一個軟約束來近似匹配未標記batch的受試者與已標記batch的受試者的平均骨長度。

5. 實驗論證

5.1 數(shù)據(jù)集與評價標準

數(shù)據(jù)集有兩個分別是Human3.6M,HumanEva-I,評價標準是Protocol 1: MPJPE(每個關(guān)節(jié)點的平均誤差), Protocol 2:P-MPJPE(與標簽數(shù)據(jù)對準后的平移、旋轉(zhuǎn)、縮放誤差),Protocol 3:N-MPJPE(只在比例上與真實標簽相匹配)

5.2 2D姿態(tài)估計

2D姿態(tài)估計網(wǎng)絡(luò)模型:stacked hourglass detector, Mask R-CNN with ResNet-101-FPN,CPN

5.3 3D姿態(tài)估計

image-20201126140916717

image-20201126141002629

image-20201126141144006

6. 總結(jié)

介紹了一個簡單的完全卷積模型用于視頻中三維人體姿態(tài)估計。網(wǎng)絡(luò)結(jié)構(gòu)利用時間信息在2D關(guān)鍵點軌跡上進行空洞卷積。這項工作的第二個貢獻是反向投影,這是一種半監(jiān)督訓練方法,在標記數(shù)據(jù)稀缺的情況下提高性能。該方法適用于未標記的視頻,只需要內(nèi)在的攝像機參數(shù),使其在運動捕捉具有挑戰(zhàn)性的場景中切實可行。

7. 論文復(fù)現(xiàn)

推薦閱讀

本文章著作權(quán)歸作者所有,任何形式的轉(zhuǎn)載都請注明出處。更多動態(tài)濾波,圖像質(zhì)量,超分辨相關(guān)請關(guān)注我的專欄深度學習從入門到精通。

審核編輯:符乾江

-

編碼器

+關(guān)注

關(guān)注

45文章

3601瀏覽量

134205 -

深度學習

+關(guān)注

關(guān)注

73文章

5493瀏覽量

120999

發(fā)布評論請先 登錄

相關(guān)推薦

居然還有這樣的10.1寸光場裸眼3D視覺訓練平板電腦?

裸眼3D筆記本電腦——先進的光場裸眼3D技術(shù)

神經(jīng)網(wǎng)絡(luò)如何用無監(jiān)督算法訓練

卷積神經(jīng)網(wǎng)絡(luò)訓練的是什么

卷積神經(jīng)網(wǎng)絡(luò)的基本原理、結(jié)構(gòu)及訓練過程

英倫科技裸眼3D視覺訓練一體機的出現(xiàn)

除了令人驚嘆的裸眼3D顯示技術(shù),英倫科技裸眼3D視覺訓練一體機還具備哪些特點?

機器人3D視覺引導(dǎo)系統(tǒng)框架介紹

【愛芯派 Pro 開發(fā)板試用體驗】人體姿態(tài)估計模型部署前期準備

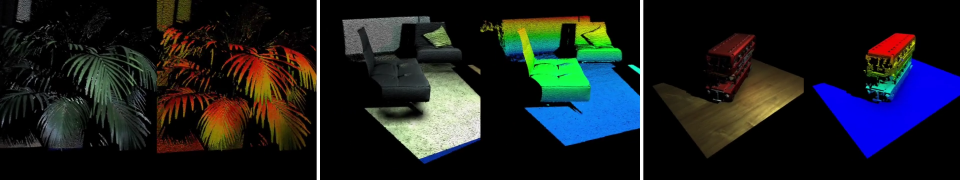

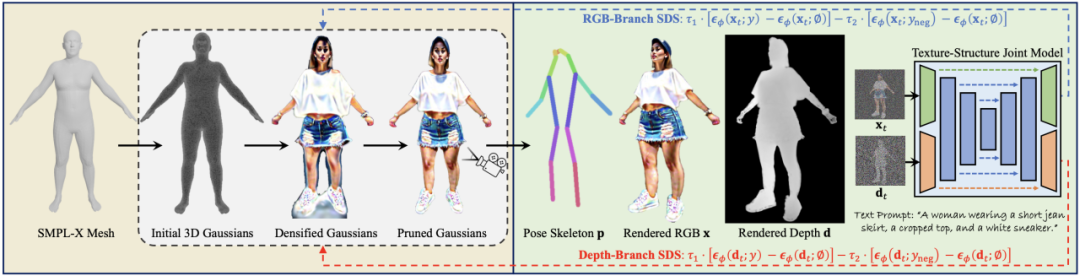

3D人體生成模型HumanGaussian實現(xiàn)原理

一個用于6D姿態(tài)估計和跟蹤的統(tǒng)一基礎(chǔ)模型

3D姿態(tài)估計 時序卷積+半監(jiān)督訓練

3D姿態(tài)估計 時序卷積+半監(jiān)督訓練

評論