人類善于利用手指觸覺來感知物體的物理特性(包括質量、重心、轉動慣量、表面摩擦等),從而完成高難度的控制任務。在不遠的將來,機器人也會擁有觸覺分析能力。在剛剛結束的機器人頂會 IROS 2020 上,上海交大 & MIT 聯(lián)合項目 SwingBot 為我們展示了如何讓機器人通過觸覺傳感器來學習感知物體復雜的物理特性(tactile exploration),從而完成一個高難度的甩筆任務(in-hand object swing-up)。該工作也摘得此次大會的最佳論文獎項。

IROS2020 最佳論文獎項。來源 iros2020.org (http://iros2020.org/) 下圖為機器人觸覺分析的流程通過握著物體旋轉一定角度和抖動物體來感知物理特性,從而推斷出最佳的控制策略實現(xiàn)甩筆。

該項目通過對多種觸覺探索動作的信息融合,讓機器人端到端的去學習概括手中物體的物理特性,并依靠這個物理特征來實現(xiàn)高難度的手上控制任務(in-hand swing-up)。更多的詳細內容可以訪問論文原文和項目主頁:

論文鏈接:http://gelsight.csail.mit.edu/swingbot/IROS2020_SwingBot.pdf

項目地址:http://gelsight.csail.mit.edu/swingbot/

高精度、低成本的觸覺傳感器 研究人員使用的是一款名為 GelSight 的機器人觸覺傳感器,該傳感器也發(fā)明于此 MIT 項目組(指導教授:Edward Adelson)。區(qū)別于傳統(tǒng)觸覺傳感器依賴于稀疏的電極陣列(基于電阻 / 電容 ),GelSight 是一個基于光學的觸覺傳感器,通過一個微型相機來拍攝接觸面的三維幾何形變,可以返回高精度的觸覺信息(見下圖是 GelSight 重建的奧利奧餅干表面)。 更值得一提的是,因為只需要一個低成本的微型攝像頭和一個樹莓派控制器,GelSight 的制作總成本只有 100 美金(700 元),遠低于市面上的其他觸覺傳感器。

GelSight 觸覺信息效果圖。來源:[2] 在本篇工作中,研究人員將 GelSight 安裝在了機器人二爪夾具的一側,通過在傳感器上標定靶點和重建三維信息,高密度的力學反饋可以以每秒60幀的速度實時傳輸出來。

基于多種觸覺探索動作的物理特性分析能力 人類可以通過多種觸覺探索動作(觸摸、甩、掂量)來概括手上物體的物理特性(重量、光滑程度、重心位置等)[1],而且人類并不需要測量這些物理參數(shù)的精確數(shù)值,而是用自己的經(jīng)驗結合觸覺手感來實現(xiàn)對手中物體高難度的控制。 受這個觀察的啟發(fā),該項目的研究人員首先提出了一個多觸覺探索的信息融合模型(Information fusion model for multiple tactile exploration actions),該模型的目的是整合不同的機器人觸覺探索動作信息到一個共同的物理特性特征空間(Physical embedding)中,從而實現(xiàn)對物體多種物理特性(質量、重心位置、轉動慣量和摩擦力)的概括能力。

多觸覺探索動作的信息融合模型。來源:論文 研究人員為機器人設計了兩種基礎的探索動作:(1)緊握物體并旋轉一定角度(in-hand tilting)和(2)放松緊握狀態(tài)并抖動物體(in-hand shaking)。動作(1)的觸覺反饋信息會通過一個卷積神經(jīng)網(wǎng)絡(CNN)來輸出一個一維的特征向量;動作(2)的抖動因為是時序信息,會用一個循環(huán)神經(jīng)網(wǎng)絡(RNN)來處理獲得相應的特征。這兩個特征信息通過拼接和一個由若干多層感知器(MLP)組成的融合模型進行整合,得到一個低維的物理特征概括(physical feature embedding)。 區(qū)別于逐個測量每種不同的物理特性,這種信息整合模型的一大優(yōu)勢是可以根據(jù)任務來自主調節(jié)對不同物理信息的關注程度,因為很多任務是無法明確分析出是哪一種物理特性起到了主導作用,而使用該方法可以讓機器人自主地學習并選擇需要的物理信息。此外,這兩個觸覺探索動作加起來只需要 7 秒的時間,相比于用精密的儀器來逐個測量物體的質量和摩擦力等,該方法的效率也有很大的提升,并且不需要額外的測量儀器的輔助,更接近人類的觸覺感知能力。 此外,為了讓機器人自主學習選擇最需要的物理信息,研究人員接著提出了一個控制預測模型,該模型通過輸入先前獲得的物理特征向量和機器人控制參數(shù),來預測最終物體會被甩到的角度。在訓練過程中,整個流程是用一個端到端(end-to-end)的訓練算法來實現(xiàn)的。研究人員設計了一個機器人自動采集數(shù)據(jù)的系統(tǒng),并且 3D 打印了可以隨意調節(jié)物理特性的模型來采集數(shù)據(jù),具體如下兩個動圖所示:

可變物理特性的模板物體。

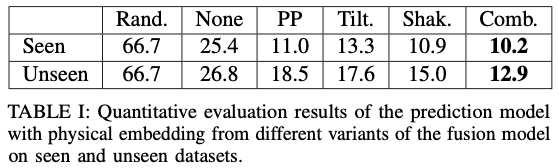

數(shù)據(jù)收集流程。 研究人員讓機器人自主采集了1350次甩筆的數(shù)據(jù),其中包含了27個不同物理特性的物體。在測試的時候,研究人員額外選擇了6個訓練數(shù)據(jù)中不包含(unseen)的新物體,機器人需要通過觸覺探索模型來確定未知物體的物理特性,并根據(jù)任務要求的最終甩到的角度,來選擇一套成功率最高的控制參數(shù)。 實驗成果 研究人員首先對比了使用和不使用多觸覺探索融合算法對預測控制模型準確率的影響(數(shù)值越低,準確度越高),其中融合算法(Comb.)在已知和未知物體上的預測誤差率都遠低于不使用觸覺信息(None)。此外融合算法(Comb.)的表現(xiàn)也比單一使用一種觸覺探索動作(Tilt.: tilting-only, Shak.:shaking-only)的算法效果好。

以下是機器人在測試過程中,通過使用多觸覺探索融合算法來實現(xiàn)對未知物體(unseen objects)的物理特性探索和上甩效果(swing-up)。第一個任務要求將物體上甩至相對于傳感器 90 度的角度位置:

第二個任務要求將物體上甩至相對于傳感器 180 度的位置:

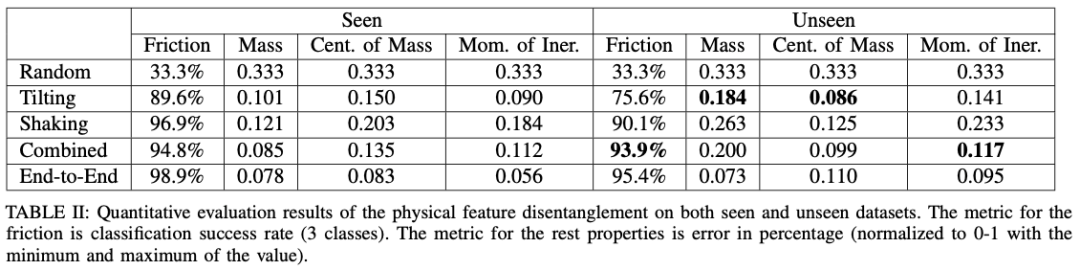

研究人員緊接著探索融合算法學習到的物理特征空間到底包含哪些信息。他們用一組額外的多層感知器來回歸(regression)每一個物理特性的具體參數(shù),并計算誤差百分比(數(shù)值越低,準確度越高)。 如下表所示,可以發(fā)現(xiàn)第一個旋轉動作(Tilting)對物體的質量(Mass)、重心(Center of mass)和轉動慣量(Moment of inertia)的信息捕捉更準確。而第二個搖晃動作(Shaking)對物體接觸部分的摩擦力(Friction)的把握更準。將兩種探索動作融合的算法(Combined)取得了最好的回歸準確率。

最后研究人員進一步探索所學習到的物理特征空間是如何能夠做到對未知物體依然適用的。他們可視化了6個未知物體的數(shù)據(jù)分布并展示在了下圖 (b) 中,其中 x 軸表示控制參數(shù),y 軸表示最終上甩的角度。在圖 (a) 中,研究人員用 PCA 提取了每個采樣中網(wǎng)絡輸出的物理特征向量的主成分(2 維)并可視化在這個二維點圖中。觀察可以發(fā)現(xiàn),如果兩個物體的控制策略相近(例如物體 5 和物體 6),他們的物理特征間距也會越近,而兩個物體的控制策略相差較大(例如物體 1 和物體 4),則在特征空間上的間距也會更大。

物理特征可視化。來源:論文 作者介紹

本項目的共同第一作者是:

王辰(Chen Wang): 本科畢業(yè)于上海交通大學,師從盧策吾教授。他即將前往 Stanford 攻讀計算機博士學位,該項目是其在 MIT 暑研期間完成的。個人主頁:http://www.chenwangjeremy.net

王少雄(Shaoxiong Wang):MIT CSAIL 博士生四年級,師從 Prof. Edward Adelson(此項目指導教授),本科畢業(yè)于清華大學。個人主頁:http://shaoxiongwang.com/

責任編輯:lq

-

控制器

+關注

關注

112文章

16203瀏覽量

177414 -

機器人

+關注

關注

210文章

28205瀏覽量

206532 -

觸覺傳感器

+關注

關注

4文章

82瀏覽量

9319

原文標題:機器人也能「甩筆」,擁有觸覺分析能力,上交&MIT獲IROS 2020最佳論文獎

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

這批中國企業(yè),在做人形機器人觸覺傳感器

【書籍評測活動NO.51】具身智能機器人系統(tǒng) | 了解AI的下一個浪潮!

觸覺傳感器的發(fā)展,對機器人產(chǎn)業(yè)有什么影響?

解鎖機器人視覺與人工智能的潛力,從“盲人機器”改造成有視覺能力的機器人(上)

開源項目!用ESP32做一個可愛的無用機器人

開源項目!用ESP32做一個可愛的無用機器人

人形機器人感知變化的未來

Al大模型機器人

其利天下技術·搭載無刷電機的掃地機器人的前景如何?

工業(yè)機器人的觸覺傳感器有哪些?傳感器作用是什么?

新技術讓水下機器人擁有“觸覺”

人形機器人柔性觸覺傳感器的關鍵技術分析

機器人也會擁有觸覺分析能力

機器人也會擁有觸覺分析能力

評論