如今,深度學習已經不僅局限于識別支票與信封上的手寫文字。比如,深度神經網絡已成為許多CV應用的關鍵組成部分,包括照片與視頻編輯器、醫療軟件與自動駕駛汽車等。神經網絡的結構與人類大腦相似,觀察世界的方式也與人類更相近。但是,神經網絡還是會犯一些人類根本不會犯的錯誤,改進空間仍很大。

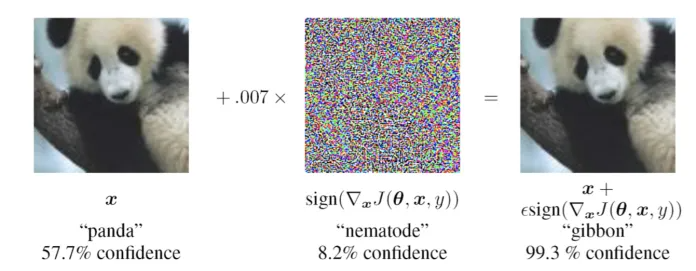

對抗樣本:如果在這張熊貓圖片上添加一個不可察覺的噪聲層,會導致卷積神經網絡將熊貓誤識別為長臂猿。這些情況通常被稱為“對抗樣本”(adversarial examples),不經意就改變AI模型的行為。對抗機器學習是當前人工智能體系的最大挑戰之一。對抗樣本可能會導致機器學習模型的意外失敗,或使模型容易受到網絡攻擊。因此,構建可抵御對抗攻擊的AI系統,已成為AI研究的熱門話題之一。在CV中,保護深度學習系統免受對抗攻擊的方法之一,是應用神經科學領域的研究發現,來縮小神經網絡與哺乳動物視覺系統之間的差距。使用這一方法,MIT與MIT-IBM Watson AI Lab的研究人員發現,若將哺乳動物視覺皮層的特征直接映射到深度神經網絡上,則能夠創建行為可預測、且面對對抗干擾(adversarial perturbation)時更“魯棒”的AI系統。在論文“Simulating a Primary Visual Cortex at the Front of CNNs Improves Robustness to Image Perturbations”中,研究人員介紹了一種叫做“VOneNet”的架構,將當前的深度學習技術與受神經科學啟發的神經網絡相結合。

這項工作是由來自慕尼黑大學、路德維希·馬克西米利安大學和奧格斯堡大學的科學家的幫助下完成的,已被NeurIPS 2020接收。1

關于卷積神經網絡

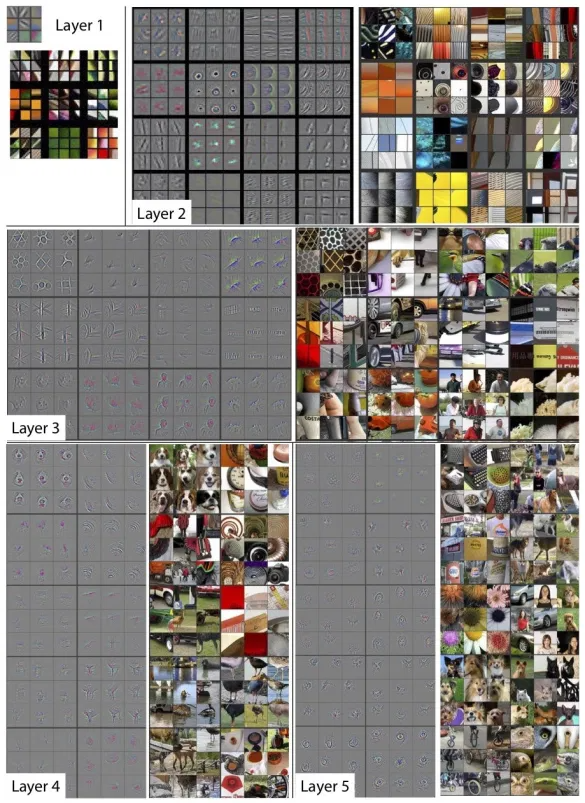

目前,計算機視覺所使用的主要架構是卷積神經網絡(CNN)。當多個卷積層堆疊在一起時,卷積層可訓練于從圖像中學習和提取層次特征。疊得較低的層可以發現角、邊等常規圖案,疊得較高的層則會越來越擅長發現圖像上的具體事物,比如物體與人。

圖注:神經網絡的每一層都會從輸入圖像中提取特定特征。與傳統的全連接網絡相比,ConvNet更“魯棒”、計算效率也更高。但是,CNN和人類視覺系統處理信息的方式之間仍然存在根本差異。“深度神經網絡(尤其是CNN)已經成長為出色的視覺皮層模型,更令人驚訝的是,與專門用于解釋神經科學數據的計算模型相比,它們更擬合從大腦中收集的實驗數據 。”MIT-IBM Watson AI Lab的IBM總監David Cox介紹道。“但并不是每個深度神經網絡都能很好地匹配大腦數據,且大腦與DNN之間一直都存在差距。”自2000年開始,Cox進入MIT師從神經科學教授James DiCarlo以來,他就一直在探索神經科學和人工智能的交叉領域。

“但是,能夠欺騙DNN的圖像卻永遠也不可能欺騙人類的視覺系統,” Cox說。“同時,DNN難以抵抗圖像的自然退化(比如增加噪音),因此,魯棒性通常是DNN的一個開放問題。考慮到這一點,我們認為可以從這個角度去尋找大腦和DNN之間的差異。”“大腦是一個功能強大且高效的信息處理機器。那么,我們是否能從大腦中學習可以實際有用的新技巧呢?同時,我們可以利用對人工系統的了解來提供指導理論和假設,幫助我們進行了解人類大腦的實驗。” Cox說。2

類腦神經網絡

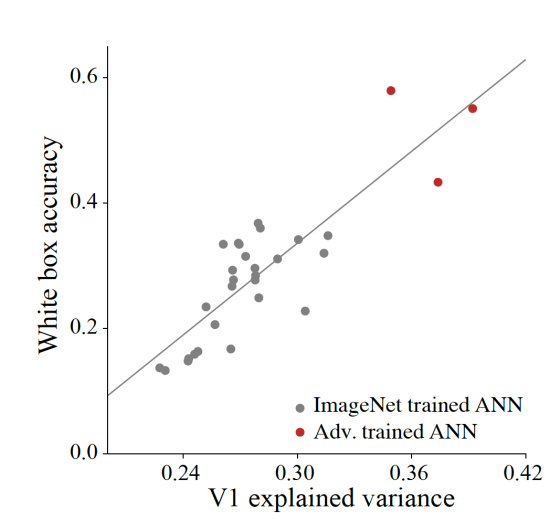

這篇論文的主要作者是Joel Dapello和Tiago Marques,Cox和導師DiCarlo加入他們,主要研究當神經網絡的激活與大腦活動相似時,神經網絡是否對對抗攻擊更具有“魯棒性”。AI研究人員測試了在ImageNet數據集上訓練的幾種流行的CNN架構,包括AlexNet,VGG和ResNet的各種變體。此外,他們還測試了一些已經過“對抗訓練”的深度學習模型,在這個過程中,神經網絡在對抗樣本中進行訓練,以避免分類錯誤。科學家使用“ BrainScore”指標評估了AI模型,該指標比較了深度神經網絡的激活和大腦的神經反應。然后,他們通過白盒對抗攻擊測試來測量每個模型的魯棒性,在測試中,攻擊者對目標神經網絡的結構和參數有充分了解。“令我們驚訝的是,模型越像大腦,系統對抗對抗攻擊的魯棒性就越強,” Cox說。“受此啟發,我們好奇,是否有可能通過在網絡輸入階段添加基于神經科學實驗的視覺皮層模擬來提高魯棒性(包括對抗性魯棒性)。”

圖注:研究表明,BrainScores更高的神經網絡,對白盒對抗攻擊也具有更強的魯棒性。3

VOneNet與VOneBlock

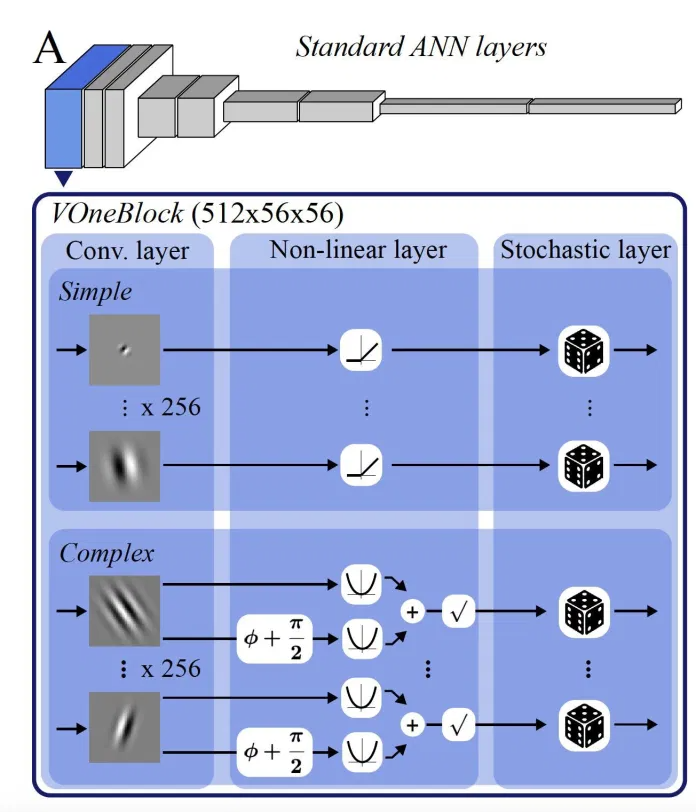

為了進一步驗證他們的發現,研究人員開發了一個叫做“VOneNet”的混合深度學習架構,將標準的CNN與一層以神經科學為靈感的神經網絡相結合。VOneNet用VOneBlock代替了CNN的前幾層。VOneBlock是一種根據靈長類動物的初級視覺皮層(也稱為V1區域)所形成的神經網絡架構。也就是說,圖像數據首先由VOneBlock處理,然后再傳遞到網絡的其余部分。VOneBlock本身由Gabor filter bank(GFB)、簡單和復雜的細胞非線性、神經元隨機性(neuronal stochasticity)組成。GFB與其他神經網絡中的卷積層相似。但是,盡管經典的神經網絡具有隨機參數值,在訓練期間也會對參數進行調整,但GFB參數的值是根據初級視覺皮層的激活來確定和調整的。

圖注:VOneBlock是一種模仿初級視覺皮層功能的神經網絡架構。“ GFB的權重與VOneBlock的架構選擇是根據生物學來設計的。這意味著,我們為VOneBlock所做的所有選擇都受到了神經生理學的限制。換句話說,我們設計了VOneBlock來盡可能地模仿靈長類動物的初級視覺皮層(V1 區域)。我們考慮了過去四十年中從幾項研究中收集到的可用數據,以確定VOneBlock參數。”論文的共同作者之一Tiago Marques介紹道。

盡管不同靈長類動物的視覺皮層存在一定差異,但也有許多共同特征,尤其是在V1區域。“大量研究表明,猴子的物體識別能力接近人類。我們的模型使用了已發布的可用數據來表征猴子的V1神經元的反應。盡管我們的模型仍只是靈長類動物V1的近似值(它不包括所有已知數據,這些數據甚至在某種程度上受到了限制——我們對V1處理信息的過程了解還不夠),但這是一個很好的近似值。”Marques解釋。除了GFB層之外,VOneBlock的簡單和復雜細胞還為神經網絡提供了在不同條件下檢測特征的靈活性。“最終,物體識別的目標是不依賴物體的確切形狀、大小、位置和其他低層特征來識別物體的存在,”Marques說。“在VOneBlock中,簡單和復雜的單元在不同圖像擾動下的支持性能方面似乎起到互補的作用。簡單單元對于處理常見的損壞特別重要,而復雜單元則擅長處理白盒對抗性攻擊。”4

VOneNet的運作

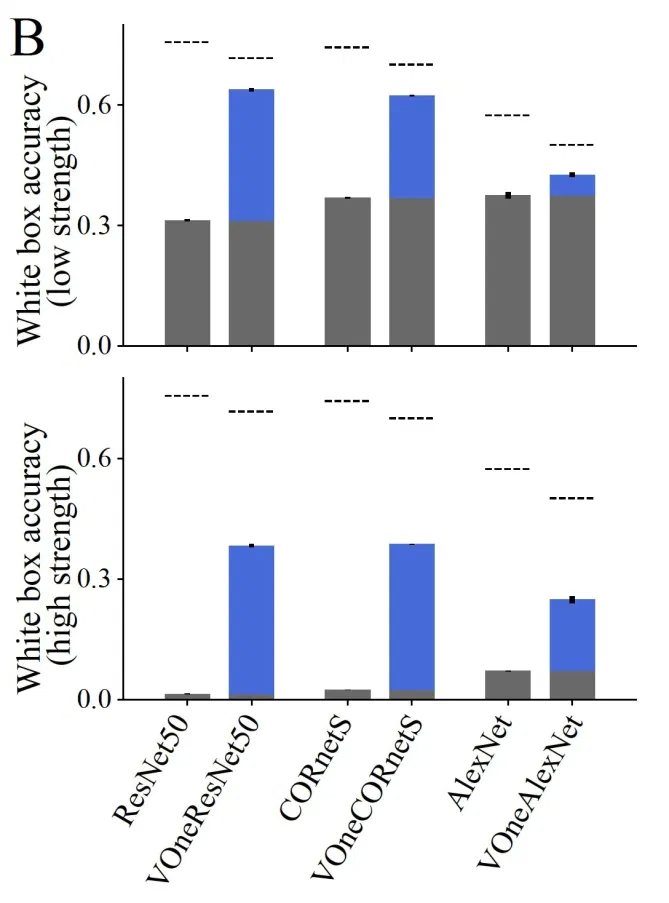

VOneBlock的優勢之一是與當前CNN架構的兼容性。VOneBlock在設計時專門設置了即插即用功能,這意味著它可以直接替代標準CNN結構的輸入層。緊隨VOneBlock核心的過渡層則可以確保其輸出與CNN架構的其余部分兼容。研究人員將VOneBlock插入幾個在ImageNet數據集上表現良好的CNN架構。有趣的是,添加了簡單的塊后,白盒對抗攻擊的魯棒性得到了顯著提高,且性能優于基于訓練的防御方法。研究人員在論文中寫道:“在標準CNN架構的前端模擬靈長類初級視覺皮層的圖像處理,可以顯著提高其對圖像擾動的魯棒性,甚至使它們的性能優于最新的防御方法。”

圖注:實驗表明,包括VOneBlock的卷積神經網絡在抵抗白盒對抗攻擊時更具有靈活性。“添加了V1的模型實際上非常簡單。我們只是更改系統的第一階段,同時保持網絡的其余部分不變,且此V1模型的生物保真度也仍然非常簡單。”Cox 說,并提到可以將更多細節和細微差別添加到這個模型中,使其與人類大腦更接近。Cox認為:“在某些方面,簡單是一種優勢,因為它隔離了可能重要的較小原則集,但有趣的是,它探索了生物保真度的其他方面是否重要。”該論文挑戰了過去幾年中在AI研究領域越來越普遍的一種趨勢。許多AI科學家在研究中沒有應用關于腦機制的最新發現,而是專注于利用可用的龐大計算資源和大數據集來訓練越來越大規模的神經網絡,來推動AI領域的進步。但這種方法給人工智能研究帶來了許多挑戰。VOneNet證明,生物智能仍然有很大的發展潛力,可以解決AI研究正面臨的一些基本問題。論文所介紹的模型直接采自靈長類動物神經生物學,只需要較少的訓練便能實現更類人的行為。這是良性循環的新轉折:神經科學和人工智能相互促進并增強了對方的理解和能力。在未來,本文的研究人員將進一步探索VOneNet的特性,以及神經科學和AI研究發現的進一步融合。據Cox介紹,這項工作目前只有一個局限性,即雖然已經證明了添加V1塊可以帶來改進,但他們卻無法很好地理解為什么會有這樣的改進。發展理論,以找到改善的原因,能夠幫助AI研究人員最終了解真正重要的步驟,并建立更高效的系統。原文鏈接:https://bdtechtalks.com/2020/12/07/vonenet-neurscience-inspired-deep-learning/

原文標題:即插即用:把仿生模塊和CNN拼接,對抗攻擊魯棒性顯著提高!

文章出處:【微信公眾號:通信信號處理研究所】歡迎添加關注!文章轉載請注明出處。

責任編輯:haq

-

神經網絡

+關注

關注

42文章

4762瀏覽量

100541 -

人工智能

+關注

關注

1791文章

46859瀏覽量

237584 -

自動駕駛

+關注

關注

783文章

13684瀏覽量

166148

原文標題:即插即用:把仿生模塊和CNN拼接,對抗攻擊魯棒性顯著提高!

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

C++新手容易犯的十個編程錯誤

BP神經網絡和人工神經網絡的區別

rnn是遞歸神經網絡還是循環神經網絡

遞歸神經網絡與循環神經網絡一樣嗎

遞歸神經網絡是循環神經網絡嗎

循環神經網絡和卷積神經網絡的區別

循環神經網絡和遞歸神經網絡的區別

bp神經網絡和反向傳播神經網絡區別在哪

反向傳播神經網絡優點和缺點有哪些

反向傳播神經網絡和bp神經網絡的區別

bp神經網絡是深度神經網絡嗎

bp神經網絡和卷積神經網絡區別是什么

卷積神經網絡和bp神經網絡的區別

深度神經網絡模型有哪些

詳解深度學習、神經網絡與卷積神經網絡的應用

神經網絡會犯一些人類根本不會犯的錯誤

神經網絡會犯一些人類根本不會犯的錯誤

評論