論文名稱:C2C-GenDA: Cluster-to-Cluster Generation for Data Augmentation of Slot Filling 論文作者:侯宇泰、陳三元、車萬翔、陳成、劉挺 原創(chuàng)作者:侯宇泰 論文鏈接:https://arxiv.org/abs/2012.07004 出處:哈工大SCIR

1. 簡介

1.1 研究背景

對話語言理解(Spoken Language Understanding,SLU)[1]經(jīng)常面臨領(lǐng)域和需求的頻繁切換,這常常會導(dǎo)致訓(xùn)練數(shù)據(jù)在數(shù)量和質(zhì)量上的不足。

數(shù)據(jù)增強(qiáng)(Data Augmentation)是一種自動生成新數(shù)據(jù)擴(kuò)充訓(xùn)練集的技術(shù),能夠有效地緩解上述數(shù)據(jù)不足的帶來的挑戰(zhàn) [2,3]。

1.2 研究動機(jī)

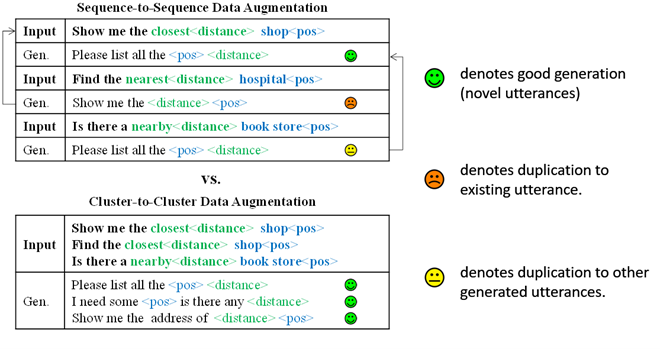

如圖1(上)所示,現(xiàn)有數(shù)據(jù)增強(qiáng),如基于Seq2Seq 的句子復(fù)述(re-phrasing)方法 [4,5,6],經(jīng)常無法避免地生成沒有意義的重復(fù)數(shù)據(jù)。這很大程度要歸咎于現(xiàn)有的one-by-one數(shù)據(jù)生成模式。

相較之下,如圖1(下)所示,one-by-one數(shù)據(jù)生成弊病可以天然地通過多到多(cluster-to-cluster)生成方式得到緩解。

圖1 示例:從已有句子生成新表述,現(xiàn)有one-by-one復(fù)述方法無法避免生成重復(fù)數(shù)據(jù)

1.3 我們的貢獻(xiàn)

我們提出了一種全新的Cluster-to-Cluster生成范式來生成新數(shù)據(jù),并基于此提出了一個全新的數(shù)據(jù)增強(qiáng)框架,稱為C2C-GenDA。C2C-GenDA通過將現(xiàn)有句子重構(gòu)為表達(dá)方式不同但語義相同的新句子,來擴(kuò)大訓(xùn)練集。與過往的Data Augmentation(DA)方法逐句(One-by-one)構(gòu)造新句子的做法不同,C2C-GenDA采用一種多到多(Cluster-to-Cluster)的全新的新語料生成方式。

具體的,C2C-GenDA聯(lián)合地編碼具有相同語義的多個現(xiàn)有句子,并同時解碼出多個未見表達(dá)方式的新句子。

這樣種的生成方式會直接帶來如下好處:

(1)同時生成多個新話語可以讓模型建模生成的新句子之間的關(guān)系,減少新句子間內(nèi)部重復(fù)。

(2)聯(lián)合地對多個現(xiàn)有句子進(jìn)行編碼讓模型可以更廣泛地看到已有的現(xiàn)有表達(dá)式,從而減少無意義的對已有數(shù)據(jù)的重復(fù)。

1.4實驗效果

當(dāng)只有數(shù)百句訓(xùn)練語料時,C2C-GenDA數(shù)據(jù)增強(qiáng)方法在了兩個公開的槽位提取(slot filling)數(shù)據(jù)集上分別帶來了 7.99 (11.9%↑) and 5.76 (13.6%↑) F-scores 的提升。

2. 方法

2.1 Cluster2Cluster 生成模型

給定具有相同語義框架(semantic frame)的一組多個句子,即input cluster, 模型一次性生成多個新句子,即output cluster。這些輸出與輸入的語義框架相同,但是具有不同的表達(dá)方式。

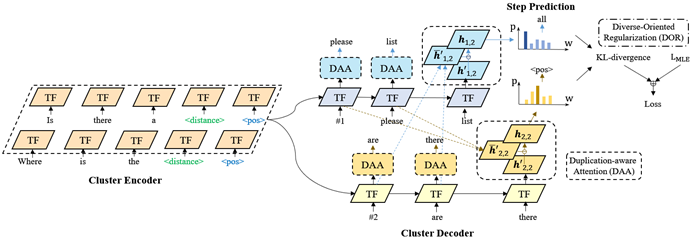

圖2 Cluster2Cluster 生成模型

如圖2所示,Cluster2Cluster模型采用基于Transformer的Encoder和Decoder。具體的,我們用特殊分割Token拼接input cluster中的句子,作為模型輸入。在解碼時,模型用多個共享參數(shù)的decoder同步解碼多個新句子。

我們采用了前人添加Rank Token作為解碼起步的方法[5]來讓模型區(qū)分不同的輸出句子。

同時,為了進(jìn)一步提升句子的多樣性,我們提出Duplication-aware Attention和Diverse-Oriented Regularization來進(jìn)一步強(qiáng)化模型,如圖2所示:

(1)Duplication-aware Attention(DAA):通過Attention為模型提供兩方面的信息,即Input Cluster中已有的表達(dá)方式,和其他正在解碼的句子中的表達(dá)方法。根據(jù)這些信息,我們采用一種類似Coverage Attention的方式對重復(fù)的表達(dá)生成進(jìn)行懲罰。

(2)Diverse-Oriented Regularization(DOR):我們提出DOR來從Loss層面引導(dǎo)模型生成多樣的句子。具體的,我們用不同句子,解碼詞分布之間的KL-散度作為loss,來約束模型避免在不同的句子中的相同step解碼出相同的詞。

2.2 Cluster2Cluster 模型訓(xùn)練

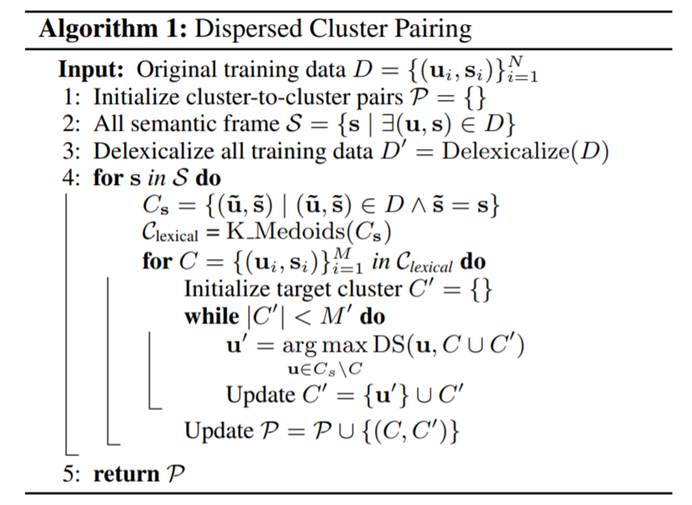

僅有多到多的生成模型顯然不足以生成新的數(shù)據(jù)。為了讓Cluster2Cluster模型具有生成新表述的能力,我們提出了Dispersed Cluster Pairing算法來構(gòu)造多到多的復(fù)寫(Paraphrase)訓(xùn)練數(shù)據(jù)。

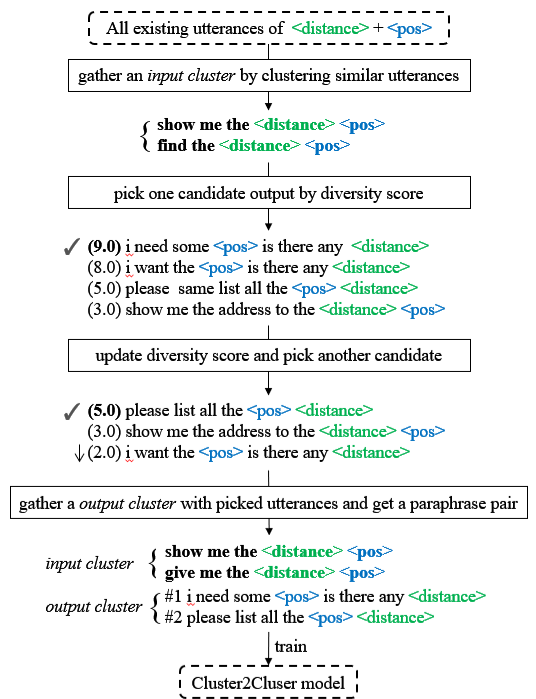

具體的,如圖3 和圖4所示,給定具有相同語義的一組數(shù)據(jù),我們首先找到一組表述相近的句子作為Input Cluster,然后貪心地構(gòu)造Output Cluster:每次添加一句和Input Cluster以及現(xiàn)有Output Cluster表述差異最大的句子到 Output Cluster。

這樣的作法旨在模擬從少量說法有限的句子生成多樣的未見表述的過程。

圖3構(gòu)造多到多的Paraphrase訓(xùn)練數(shù)據(jù)

圖4多到多的Paraphrase訓(xùn)練數(shù)據(jù)構(gòu)造算法

2.3 數(shù)據(jù)增強(qiáng)實現(xiàn)

我們將原有的訓(xùn)練數(shù)據(jù)分為兩份,一份訓(xùn)練C2C-GenDA模型,一份用來做數(shù)據(jù)增強(qiáng)的輸入。

最后我們用所有新生成的句子和原有的句子作為增強(qiáng)后的訓(xùn)練集。

3. 實驗:

3.1 主實驗結(jié)果

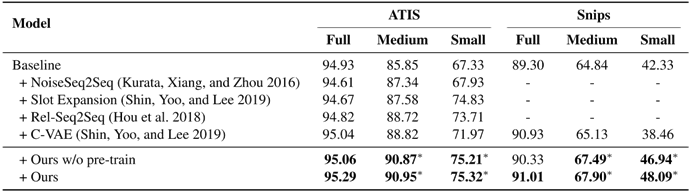

如表1所示,我們的方法能夠大幅地提升Slot Filling模型效果(Baseline),并優(yōu)于現(xiàn)有的數(shù)據(jù)增強(qiáng)方法。

表1 主實驗結(jié)果

3.2 分析實驗

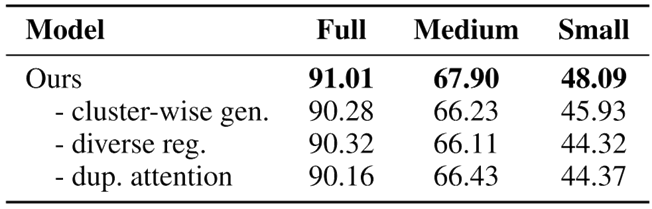

如表2所示,在消融實驗中,我們提出的各個模塊都對最終的實驗效果起到了作用。

表2 消融實驗

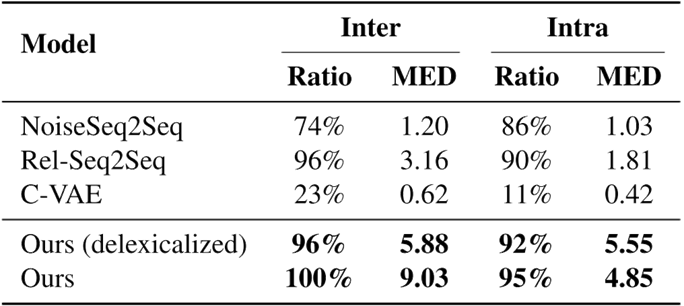

表3展示不同生成模型的生成數(shù)據(jù)和Inter和Intra多樣性,結(jié)果顯示采用Cluster2Cluster的生成方法可以讓新數(shù)據(jù)的多樣性產(chǎn)生巨大的提升。

表3 多樣性分析實驗

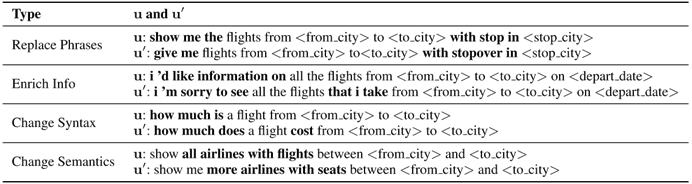

表4展示了由Cluster2Cluster模型生成的一些樣例,可以看到Cluster2Cluster模型可以從多個角度生成一些有趣的新表述方式。

表4 樣例分析

4.參考文獻(xiàn)

[1] Young, S.; Gasiˇ c, M.; Thomson, B.; and Williams, J. D. ′ 2013. Pomdp-based statistical spoken dialog systems: A review. Proc. of the IEEE 101(5): 1160–1179.

[2] Kim, H.-Y.; Roh, Y.-H.; and Kim, Y.-G. 2019. Data Augmentation by Data Noising for Open-vocabulary Slots in Spoken Language Understanding. In Proc. of NAACL, 97– 102.

[3] Shin, Y.; Yoo, K. M.; and Lee, S.-G. 2019. Utterance Generation With Variational Auto-Encoder for Slot Filling in Spoken Language Understanding. IEEE Signal Processing Letters 26(3): 505–509.

[4] Yoo, K. M. 2020. Deep Generative Data Augmentation for Natural Language Processing. Ph.D. thesis, Seoul National University

[5] Hou, Y.; Liu, Y.; Che, W.; and Liu, T. 2018. Sequence-to-Sequence Data Augmentation for Dialogue Language Understanding. In Proc. of COLING, 1234–1245.

[6] Kurata, G.; Xiang, B.; and Zhou, B. 2016. Labeled Data Generation with Encoder-Decoder LSTM for Semantic Slot Filling. In Proc. of INTERSPEECH, 725–729.

責(zé)任編輯:xj

原文標(biāo)題:【SCIR AAAI2021】數(shù)據(jù)增強(qiáng)沒效果?試試用Cluster-to-Cluster生成更多樣化的新數(shù)據(jù)吧

文章出處:【微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

6899瀏覽量

88845 -

自然語言

+關(guān)注

關(guān)注

1文章

287瀏覽量

13332 -

nlp

+關(guān)注

關(guān)注

1文章

487瀏覽量

22015

原文標(biāo)題:【SCIR AAAI2021】數(shù)據(jù)增強(qiáng)沒效果?試試用Cluster-to-Cluster生成更多樣化的新數(shù)據(jù)吧

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

NVIDIA Isaac Sim滿足模型的多樣化訓(xùn)練需求

博科測試IPO上市觀察:產(chǎn)品布局完善,可滿足多樣化檢測需求

室內(nèi)人行與導(dǎo)航系統(tǒng)有哪些多樣化的功能?

雙路設(shè)計,滿足光伏電站與充電樁多樣化計量需求——安科瑞丁佳雯

潤和軟件星閃業(yè)務(wù)閃耀海外,亮相“面向智能社會的技術(shù)多樣化與產(chǎn)品戰(zhàn)略論壇”

DC/AC電源模塊:實現(xiàn)電力系統(tǒng)的多樣化應(yīng)用

長電科技為自動駕駛芯片客戶提供多樣化高可靠性的封裝測試解決方案

聯(lián)合電子攜多樣化解決方案和創(chuàng)新技術(shù)亮相2024北京車展

【TE Connectivity】泰科電子低溫升 Cluster Block連接器,無懼高溫,“清新”來襲!

三星半導(dǎo)體分享了面向PC、移動端和服務(wù)器的多樣化創(chuàng)新存儲解決方案

中國電信攜手中興通訊聯(lián)合發(fā)布Cluster DRS創(chuàng)新技術(shù)和成果

中國電信聯(lián)合中興通訊推出Cluster DRS解決方案

psci電源管理拓?fù)浣Y(jié)構(gòu)介紹

錄音模塊:WT588FM01高性能錄音語音芯片IC,功能豐富,音質(zhì)卓越,滿足多樣化需求

錄音模塊:WT588FM01高性能錄音語音芯片IC,功能豐富,音質(zhì)卓越,滿足多樣化需求

NLP:用Cluster-to-Cluster生成更多樣化的新數(shù)據(jù)

NLP:用Cluster-to-Cluster生成更多樣化的新數(shù)據(jù)

評論