本系列文章主要分享近年來事件抽取方法總結(jié),包括中文事件抽取、開放域事件抽取、事件數(shù)據(jù)生成、跨語言事件抽取、小樣本事件抽取、零樣本事件抽取等。主要包括以下幾大部分:

定義(Define)

綜述(Survey)

模型(Models)

數(shù)據(jù)集(Datasets)

挑戰(zhàn)與展望(Future Research Challenges)

Github地址:https://github.com/xiaoqian19940510/Event-Extraction

Few-shot or zero-shot

2020

Meta-Learning with Dynamic-Memory-Based Prototypical Network for Few-Shot Event Detection, WSDM 2020[1]

事件檢測(ED)是事件抽取的一個子任務(wù),涉及到識別觸發(fā)器和對提到的事件進(jìn)行分類。現(xiàn)有的方法主要依賴于監(jiān)督學(xué)習(xí),并需要大規(guī)模的標(biāo)記事件數(shù)據(jù)集,不幸的是,這些數(shù)據(jù)集在許多實(shí)際應(yīng)用中并不容易獲得。

在這篇論文中,考慮并重新制定了一個有限標(biāo)記數(shù)據(jù)的教育任務(wù)作為一個少樣本的學(xué)習(xí)問題。提出了一個基于動態(tài)記憶的原型網(wǎng)絡(luò)(DMB-PN),它利用動態(tài)記憶網(wǎng)絡(luò)(DMN)不僅可以更好地學(xué)習(xí)事件類型的原型,還可以為提到事件生成更健壯的句子編碼。傳統(tǒng)的原型網(wǎng)絡(luò)只使用一次事件提及次數(shù),通過平均計算事件原型,與之不同的是,由于DMNs的多跳機(jī)制,我們的模型更加健壯,能夠從多次提及的事件中提取上下文信息。

實(shí)驗表明,與一系列基線模型相比,DMB-PN不僅能更好地解決樣本稀缺問題,而且在事件類型變化較大、實(shí)例數(shù)量極小的情況下性能更強(qiáng)。

Exploiting the Matching Information in the Support Set for Few Shot Event Classification, PAKDD 2020[2]

現(xiàn)有的事件分類(EC)的工作主要集中在傳統(tǒng)的監(jiān)督學(xué)習(xí)設(shè)置,其中模型無法提取的事件提到新的/看不見的事件類型。盡管EC模型能夠?qū)⑵洳僮鲾U(kuò)展到未觀察到的事件類型,但在這一領(lǐng)域還沒有研究過少樣本習(xí)。為了填補(bǔ)這一空白,在本研究中,我們調(diào)查了在少樣本學(xué)習(xí)設(shè)置下的事件分類。

針對這一問題們提出了一種新的訓(xùn)練方法,即在訓(xùn)練過程中擴(kuò)展利用支持集。特別地,除了將查詢示例與用于訓(xùn)練的支持集中的示例進(jìn)行匹配之外,我們還試圖進(jìn)一步匹配支持集中本身的示例。該方法為模型提供了更多的訓(xùn)練信息,可應(yīng)用于各種基于度量學(xué)習(xí)的少樣本學(xué)習(xí)方法。我們在兩個EC基準(zhǔn)數(shù)據(jù)集上的廣泛實(shí)驗表明,該方法可以提高事件分類準(zhǔn)確率達(dá)10%

Towards Few-Shot Event Mention Retrieval : An Evaluation Framework and A Siamese Network Approach, LREC 2020[3]

在大量的文本中自動分析事件對于情境意識和決策是至關(guān)重要的。以前的方法將事件抽取視為“一刀切”,并預(yù)先定義了本體。所建立的提取模型用于提取本體中的類型。這些方法不能很容易地適應(yīng)新的事件類型或感興趣的新領(lǐng)域。

為了滿足以事件為中心的個性化信息需求,本文引入了少樣本事件提及檢索(EMR)任務(wù):給定一個由少量事件提及組成的用戶提供的查詢,返回在語料庫中找到的相關(guān)事件提及。這個公式支持“按例查詢”,這大大降低了指定以事件為中心的信息需求的門檻。檢索設(shè)置還支持模糊搜索。我們提供了一個利用現(xiàn)有事件數(shù)據(jù)集(如ACE)的評估框架。

2018

Zero-Shot Transfer Learning for Event Extraction, ACL 2018[4]

以前的大多數(shù)事件抽取研究都嚴(yán)重依賴于從標(biāo)注的事件提及中衍生出來的特性,因此如果不進(jìn)行注釋就不能應(yīng)用于新的事件類型。在這項工作中,我們重新審視事件抽取,并將其建模為一個接地問題。我們設(shè)計一個Transfer的神經(jīng)結(jié)構(gòu),映射事件提及和類型共同到一個共享語義空間使用神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)和組成,每個事件提及的類型可以由所有候選人的最親密的類型。

通過利用一組現(xiàn)有事件類型可用的手工標(biāo)注和現(xiàn)有事件本體,我們的框架應(yīng)用于新的事件類型而不需要額外的標(biāo)注。在現(xiàn)有事件類型(如ACE、ERE)和新事件類型(如FrameNet)上的實(shí)驗證明了我們的方法的有效性。對于23種新的事件類型,我們的zero-shot框架實(shí)現(xiàn)了可以與最先進(jìn)的監(jiān)督模型相比較的性能,該模型是從500個事件提及的標(biāo)注數(shù)據(jù)中訓(xùn)練出來的。

中文事件抽取

2019

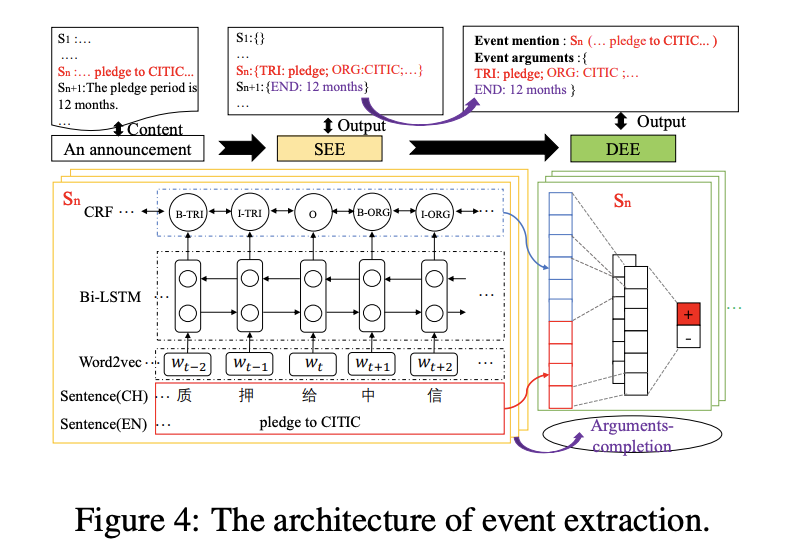

Doc2EDAG: An End-to-End Document-level Framework for Chinese Financial Event Extraction, EMNLP2019 [5]

任務(wù): 與其他研究不同,該任務(wù)被定義為:事件框架填充:也就是論元檢測+識別

不同點(diǎn)有:不需要觸發(fā)詞檢測;文檔級的抽取;論元有重疊

動機(jī): 解碼論元需要一定順序,先后有關(guān)

主要思想:發(fā)布數(shù)據(jù)集,具有特性:arguments-scattering and multi-event,先對事件是否觸發(fā)進(jìn)行預(yù)測;然后,按照一定順序先后來分別解碼論元

數(shù)據(jù)集:ten years (2008-2018) Chinese financial announcements:ChFinAnn;

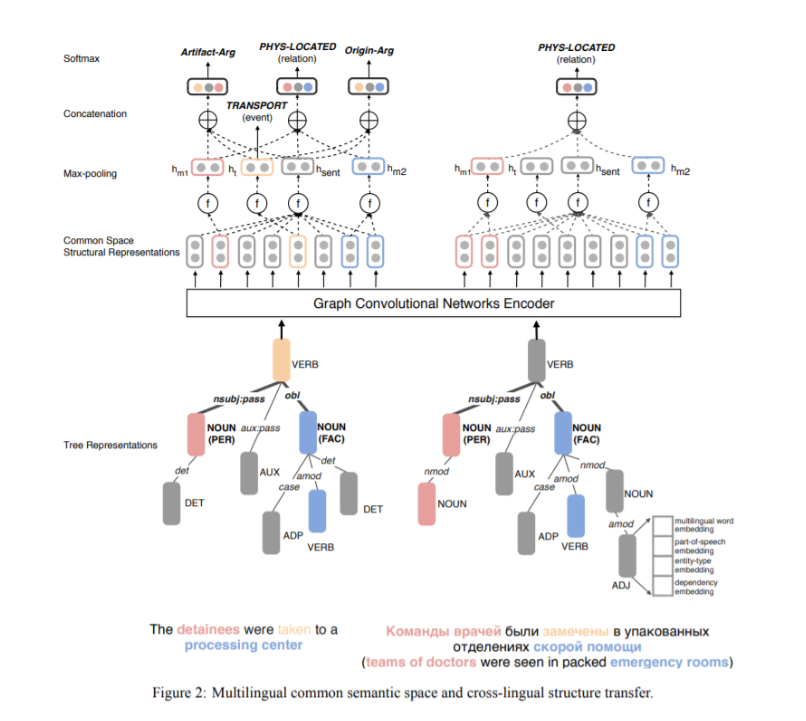

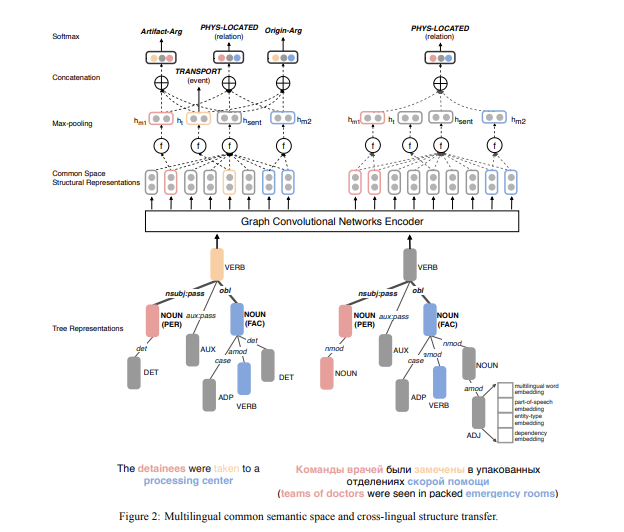

Cross-lingual Structure Transfer for Relation and Event Extraction, EMNLP 2019) [6]

動機(jī):從資源不足以及注釋不足的語料庫中進(jìn)行復(fù)雜語義結(jié)構(gòu)的識別(例如事件和實(shí)體關(guān)系)是很困難的,這已經(jīng)變成了一個很有挑戰(zhàn)性的信息抽取任務(wù)。

主要思想:通過使用卷積神經(jīng)網(wǎng)絡(luò),將所有實(shí)體信息片段、事件觸發(fā)詞、事件背景放入一個復(fù)雜的、結(jié)構(gòu)化的多語言公共空間,然后我們可以從源語言注釋中訓(xùn)練一個事件抽取器,并將它應(yīng)用于目標(biāo)語言。

數(shù)據(jù)集:ACE2005

2018

DCFFE: A Document-level Chinese Financial Event Extraction System based on Automatically Labelled Training Data, ACL 2018 [7]

動機(jī):在某些特定領(lǐng)域,例如金融,醫(yī)療和司法領(lǐng)域,由于數(shù)據(jù)標(biāo)記過程的成本很高,因此標(biāo)記數(shù)據(jù)不足。此外,當(dāng)前大多數(shù)方法都關(guān)注于從一個句子中提取事件,但通常在一個文檔中,一個事件由多個句子表示。我們提出一種方法來解決這個問題。

主要思想:我們提供了一個名為DCFEE的框架,該框架可以從被自動標(biāo)記過的訓(xùn)練數(shù)據(jù)中抽取文檔級事件。我們使用一個序列標(biāo)記模型來自動抽取句子級事件,并且提出了一個關(guān)鍵事件檢測模型和一個論元填充策略,進(jìn)而從文檔中提取整個事件。

數(shù)據(jù)集:Chinese financial event dataset

2016

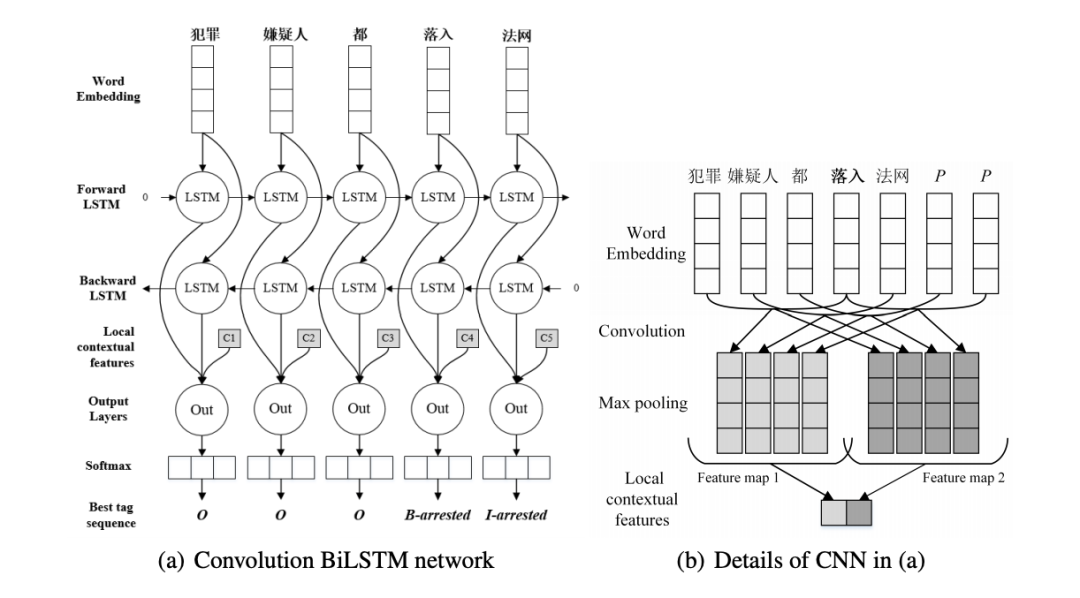

A convolution bilstm neural network model for chinese event extraction, NLPCC 2016 [8]

動機(jī):在中文的事件抽取中,以前的方法非常依賴復(fù)雜的特征工程以及復(fù)雜的自然語言處理工具。本文提出了一種卷積雙向LSTM神經(jīng)網(wǎng)絡(luò),該神經(jīng)網(wǎng)絡(luò)將LSTM和CNN結(jié)合起來,可以捕獲句子級和詞匯信息,而無需任何人為提供的特征。

主要思想:首先使用雙向LSTM將整個句子中的單詞的語義編碼為句子級特征,不做任何句法分析。然后,我們利用卷積神經(jīng)網(wǎng)絡(luò)來捕獲突出的局部詞法特征來消除觸發(fā)器的歧義,整個過程無需來自POS標(biāo)簽或NER的任何幫助。

數(shù)據(jù)集:ACE2005, KBP2017 Corpus

半監(jiān)督遠(yuǎn)程監(jiān)督事件抽取

2018

Semi-supervised event extraction with paraphrase clusters, NAACL 2018[9]

動機(jī):受監(jiān)督的事件抽取系統(tǒng)由于缺乏可用的訓(xùn)練數(shù)據(jù)而其準(zhǔn)確性受到限制。我們提出了一種通過對額外的訓(xùn)練數(shù)據(jù)進(jìn)行重復(fù)抽樣來使事件抽取系統(tǒng)自我訓(xùn)練的方法。這種方法避免了訓(xùn)練數(shù)據(jù)缺乏導(dǎo)致的問題。

主要思想:我們通過詳細(xì)的事件描述自動生成被標(biāo)記過的訓(xùn)練數(shù)據(jù),然后用這些數(shù)據(jù)進(jìn)行事件觸發(fā)詞識別。具體來說,首先,將提及該事件的片段聚集在一起,形成一個聚類。然后用每個聚類中的簡單示例來給整個聚類貼一個標(biāo)簽。最后,我們將新示例與原始訓(xùn)練集結(jié)合在一起,重新訓(xùn)練事件抽取器。

數(shù)據(jù)集:ACE2005, TAC-KBP 2015

開放域事件抽取

2020

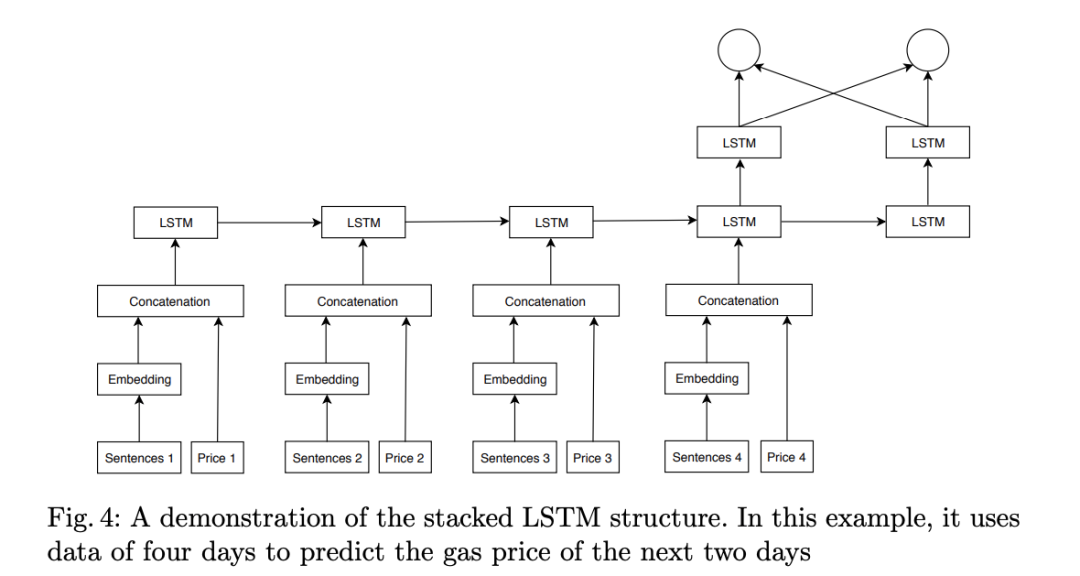

Open-domain Event Extraction and Embedding for Natural Gas Market Prediction, arxiv 2020

動機(jī):以前的方法大多數(shù)都將價格視為可推斷的時間序列,那些分析價格和新聞之間的關(guān)系的方法是根據(jù)公共新聞數(shù)據(jù)集相應(yīng)地修正其價格數(shù)據(jù)、手動注釋標(biāo)題或使用現(xiàn)成的工具。與現(xiàn)成的工具相比,我們的事件抽取方法不僅可以檢測現(xiàn)象的發(fā)生,還可以由公共來源檢測變化的歸因和特征。

主要思想:依靠公共新聞API的標(biāo)題,我們提出一種方法來過濾不相關(guān)的標(biāo)題并初步進(jìn)行事件抽取。價格和文本均被反饋到3D卷積神經(jīng)網(wǎng)絡(luò),以學(xué)習(xí)事件與市場動向之間的相關(guān)性。

數(shù)據(jù)集:NYTf、FT、TG

2019

Open Domain Event Extraction Using Neural Latent Variable Models, ACL2019 [10]

動機(jī):我們考慮開放領(lǐng)域的事件抽取,即從新聞集群中抽取無約束的事件類型的任務(wù)。結(jié)果表明,與最新的事件模式歸納方法相比,這種無監(jiān)督模型具有更好的性能。

主要思想:以前關(guān)于生成模式歸納的研究非常依賴人工生成的指標(biāo)特征,而我們引入了由神經(jīng)網(wǎng)絡(luò)產(chǎn)生的潛在變量來獲得更好的表示能力。我們設(shè)計了一種新穎的圖模型,該模型具有潛在的事件類型矢量以及實(shí)體的文本冗余特征,而這些潛在的事件類型矢量來自全局參數(shù)化正態(tài)分布的新聞聚類。

數(shù)據(jù)集:GNBusiness

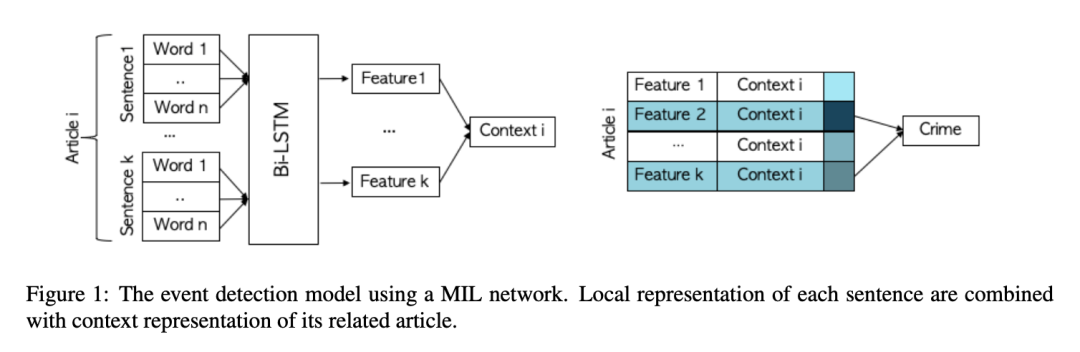

Reporting the unreported: Event Extraction for Analyzing the Local Representation of Hate Crimes, EMNLP 2019[11]

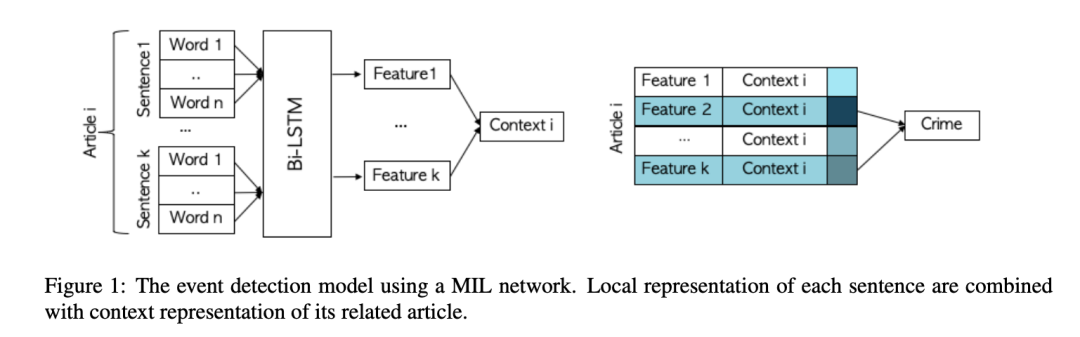

動機(jī):將事件抽取和多實(shí)例學(xué)習(xí)應(yīng)用于本地新聞文章的語料庫,可以用來預(yù)測仇恨犯罪的發(fā)生。

主要思想:根據(jù)是否為仇恨罪標(biāo)記每篇文章的任務(wù)被定義為多實(shí)例學(xué)習(xí)(MIL)問題。我們通過使用文章所有句子中嵌入的信息來確定文章是否報道了仇恨犯罪。在一組帶注釋的文章上測試了模型之后,我們將被訓(xùn)練過的模型應(yīng)用于聯(lián)邦調(diào)查局沒有報道過的城市,并對這些城市中仇恨犯罪的發(fā)生頻率進(jìn)行了下界估計。

多語言事件抽取

2019

Cross-lingual Structure Transfer for Relation and Event Extraction, EMNLP 2019) [12]

動機(jī):從資源不足以及標(biāo)注不足的語料庫中進(jìn)行復(fù)雜語義結(jié)構(gòu)的識別(例如事件和實(shí)體關(guān)系)是很困難的,這已經(jīng)變成了一個很有挑戰(zhàn)性的信息抽取任務(wù)。

主要思想:通過使用卷積神經(jīng)網(wǎng)絡(luò),將所有實(shí)體信息片段、事件觸發(fā)詞、事件背景放入一個復(fù)雜的、結(jié)構(gòu)化的多語言公共空間,然后我們可以從源語言標(biāo)注數(shù)據(jù)中訓(xùn)練一個事件抽取器,并將它應(yīng)用于目標(biāo)語言。

數(shù)據(jù)集:ACE2005

2016

Leveraging Multilingual Training for Limited Resource Event Extraction, COLING 2016[13]

動機(jī):迄今為止,利用跨語言訓(xùn)練來提高性能的工作非常有限。因此我們提出了一種新的事件抽取方法。

主要思想:在本文中,我們提出了一種新穎的跨語言事件抽取方法,該方法可在多種語言上進(jìn)行訓(xùn)練,并利用依賴于語言的特征和不依賴于語言的特征來提高性能。使用這種系統(tǒng),我們旨在同時利用可用的多語言資源(帶標(biāo)注的數(shù)據(jù)和引入的特征)來克服目標(biāo)語言中的標(biāo)注數(shù)據(jù)稀缺性問題。從經(jīng)驗上我們認(rèn)為,我們的方法可以極大地提高單語系統(tǒng)對中文事件論元提取任務(wù)的性能。與現(xiàn)有工作相比,我們的方法是新穎的,我們不依賴于使用高質(zhì)量的機(jī)器翻譯的或手動對齊的文檔,這因為這種需求對于給定的目標(biāo)語言可能是無法滿足的。

數(shù)據(jù)集:ACE2005

數(shù)據(jù)生成

2019

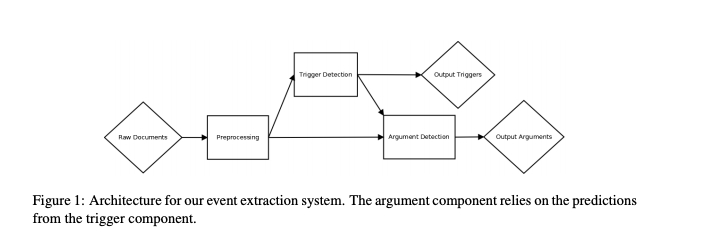

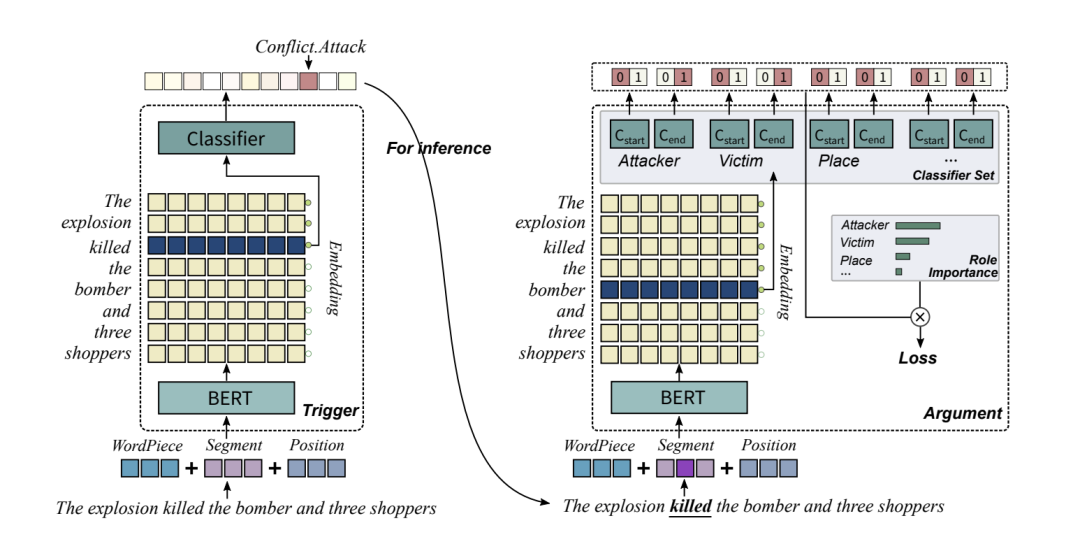

Exploring Pre-trained Language Models for Event Extraction and Geenration, ACL 2019[14]

動機(jī):ACE事件抽取任務(wù)的傳統(tǒng)方法通常依賴被手動標(biāo)注過的數(shù)據(jù),但是手動標(biāo)注數(shù)據(jù)非常耗費(fèi)精力并且也限制了數(shù)據(jù)集的規(guī)模。我們提出了一個方法來克服這個問題。

主要思想:本文提出了一個基于預(yù)訓(xùn)練語言模型的框架,該框架包含一個作為基礎(chǔ)的事件抽取模型以及一種生成被標(biāo)注事件的方法。我們提出的事件抽取模型由觸發(fā)詞抽取器和論元抽取器組成,論元抽取器用前者的結(jié)果進(jìn)行推理。此外,我們根據(jù)角色的重要性對損失函數(shù)重新進(jìn)行加權(quán),從而提高了論元抽取器的性能。

數(shù)據(jù)集:ACE2005

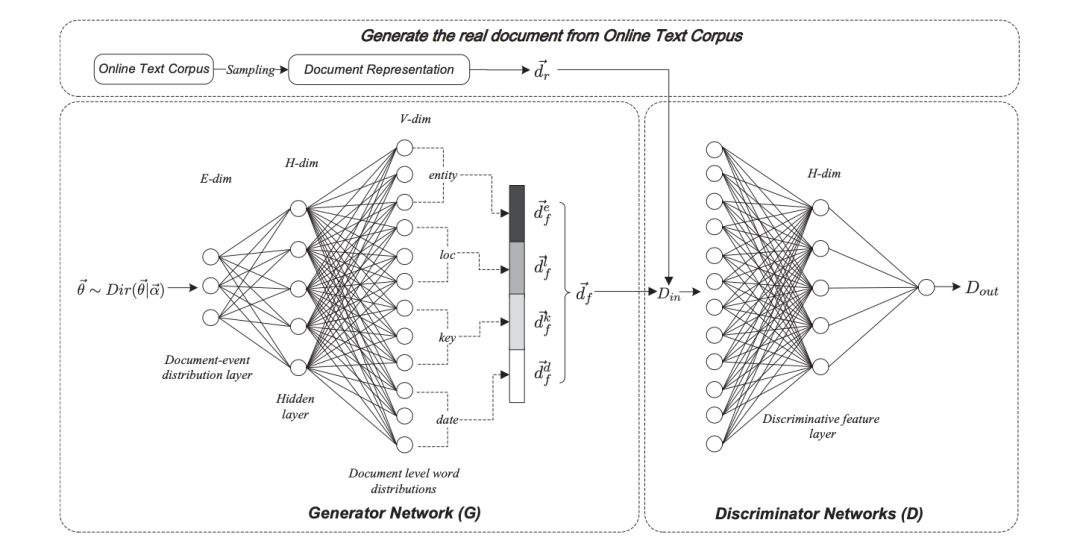

Open Event Extraction from Online Text using a Generative Adversarial Network, EMNLP 2019 [15]

動機(jī):提取開放域事件的結(jié)構(gòu)化表示的方法通常假定文檔中的所有單詞都是從單個事件中生成的,因此他們通常不適用于諸如新聞文章之類的長文本。為了解決這些局限性,我們提出了一種基于生成對抗網(wǎng)絡(luò)的事件抽取模型,稱為對抗神經(jīng)事件模型(AEM)。

主要思想:AEM使用Dirichlet先驗對事件建模,并使用生成器網(wǎng)絡(luò)來捕獲潛在事件的模式。鑒別符用于區(qū)分原始文檔和從潛在事件中重建的文檔。鑒別器的副產(chǎn)品是鑒別器網(wǎng)絡(luò)生成的特征允許事件抽取的可視化。

數(shù)據(jù)集:Twitter, and Google datasets

Reporting the unreported: Event Extraction for Analyzing the Local Representation of Hate Crimes, EMNLP 2019[16]

動機(jī):將事件抽取和多實(shí)例學(xué)習(xí)應(yīng)用于本地新聞文章的語料庫,可以用來預(yù)測仇恨犯罪的發(fā)生。

主要思想:根據(jù)是否為仇恨罪標(biāo)記每篇文章的任務(wù)被定義為多實(shí)例學(xué)習(xí)(MIL)問題。我們通過使用文章所有句子中嵌入的信息來確定文章是否報道了仇恨犯罪。在一組帶標(biāo)注數(shù)據(jù)的文章上測試了模型之后,我們將被訓(xùn)練過的模型應(yīng)用于聯(lián)邦調(diào)查局沒有報道過的城市,并對這些城市中仇恨犯罪的發(fā)生頻率進(jìn)行了下界估計。

2017

Automatically Labeled Data Generation for Large Scale Event Extraction, ACL 2017 [17]

動機(jī):手動標(biāo)記的訓(xùn)練數(shù)據(jù)成本太高,事件類型覆蓋率低且規(guī)模有限,這種監(jiān)督的方法很難從知識庫中抽取大量事件。

主要思想:1)提出了一種按重要性排列論元并且為每種事件類型選取關(guān)鍵論元或代表論元方法。2)僅僅使用關(guān)鍵論元來標(biāo)注事件,并找出關(guān)鍵詞。3)用外部語言知識庫FrameNet來過濾噪聲觸發(fā)詞并且擴(kuò)展觸發(fā)詞庫。

數(shù)據(jù)集:ACE2005

閱讀理解式事件抽取

2020

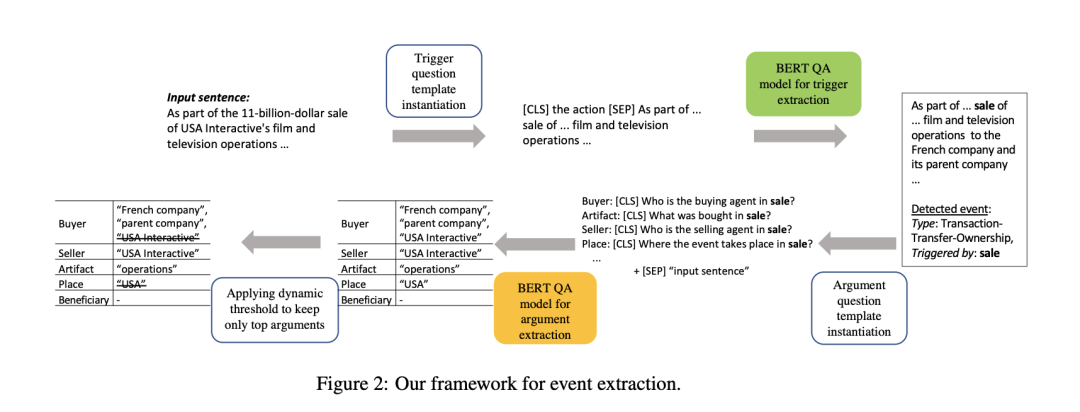

Event Extraction by Answering (Almost) Natural Questions, EMNLP 2020 [18]

主要思想:事件抽取問題需要檢測事件觸發(fā)并提取其相應(yīng)的參數(shù)。事件參數(shù)抽取中的現(xiàn)有工作通常嚴(yán)重依賴于作為預(yù)處理/并發(fā)步驟的實(shí)體識別,這導(dǎo)致了眾所周知的錯誤傳播問題。為了避免這個問題,我們引入了一種新的事件抽取范式,將其形式化為問答(QA)任務(wù),該任務(wù)以端到端的方式抽取事件論元。實(shí)證結(jié)果表明,我們的框架優(yōu)于現(xiàn)有的方法; 此外,它還能夠抽取訓(xùn)練時未見角色的事件論元。

數(shù)據(jù)集:ACE

2019

Neural Cross-Lingual Event Detection with Minimal Parallel Resources, EMNLP2019[19]

標(biāo)注數(shù)據(jù)的缺乏給事件檢測帶來了巨大的挑戰(zhàn)。跨語言教育旨在解決這一挑戰(zhàn),通過在不同語言之間傳遞知識,提高性能。但是,以前用于ED的跨語言方法對并行資源有嚴(yán)重依賴,這可能限制了它們的適用性。

在本文中,我們提出了一種跨語言的ED的新方法,證明了并行資源的最小依賴性。具體來說,為了構(gòu)建不同語言之間的詞匯映射,我們設(shè)計了一種上下文依賴的翻譯方法; 為了解決語序差異問題,我們提出了一種用于多語言聯(lián)合訓(xùn)練的共享句法順序事件檢測器。通過在兩個標(biāo)準(zhǔn)數(shù)據(jù)集上的大量實(shí)驗,研究了該方法的有效性。實(shí)證結(jié)果表明,我們的方法在執(zhí)行不同方向的跨語言遷移和解決注解不足的情況下是有效的。

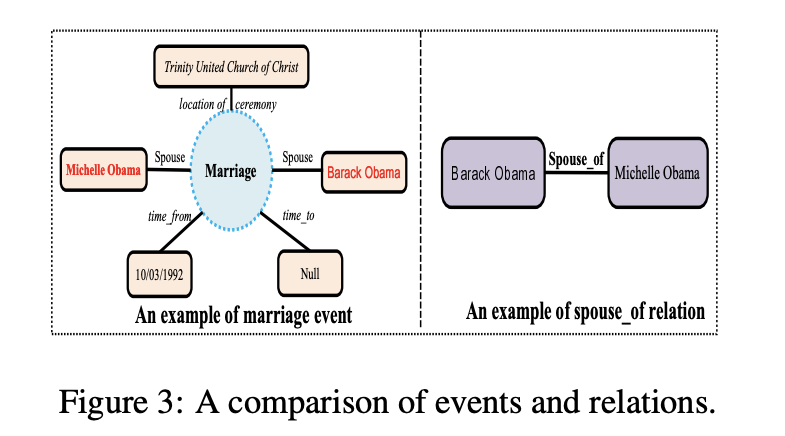

Entity-relation extraction as multi-turn question answering, ACL2019[20]

提出了一種新的實(shí)體-關(guān)系抽取的范式。我們把任務(wù)作為多向問答的問題,也就是說,實(shí)體和關(guān)系的抽取轉(zhuǎn)化為確定答案的任務(wù)。這種多輪QA形式化有幾個關(guān)鍵的優(yōu)點(diǎn):

首先,問題查詢?yōu)槲覀兿胍R別的實(shí)體/關(guān)系類編碼重要的信息;

其次,QA為實(shí)體與關(guān)系的聯(lián)合建模提供了一種自然的方式;

第三,它允許我們開發(fā)良好的機(jī)器閱讀理解(MRC)模型。

在ACE和CoNLL04語料庫上的實(shí)驗表明,提出的范式顯著優(yōu)于之前的最佳模型。我們能夠在所有的ACE04、ACE05和CoNLL04數(shù)據(jù)集上獲得最先進(jìn)的結(jié)果,將這三個數(shù)據(jù)集上的SOTA結(jié)果分別提高到49.4(+1.0)、60.2(+0.6)和68.9(+2.1)。此外,我們構(gòu)建了一個新開發(fā)的中文數(shù)據(jù)集恢復(fù),它需要多步推理來構(gòu)建實(shí)體依賴關(guān)系,而不是以往數(shù)據(jù)集的三元提取的單步依賴關(guān)系抽取。提出的多輪質(zhì)量保證模型在簡歷數(shù)據(jù)集上也取得了最好的效果。

2017

Zero-shot relation extraction via reading comprehension, CoNLL 2017[21]

通過將一個或多個自然語言問題與每個關(guān)系槽相關(guān)聯(lián),可以將關(guān)系提取簡化為回答簡單的閱讀理解問題。減少有幾個好處:我們可以

學(xué)習(xí)relation-extraction模型通過擴(kuò)展最近神經(jīng)閱讀理解技術(shù)

為這些模型相結(jié)合構(gòu)建大訓(xùn)練集關(guān)系專用眾包與遠(yuǎn)方監(jiān)督問題,

zero-shot學(xué)習(xí)通過提取新關(guān)系類型,只有指定的測試時間,我們沒有標(biāo)簽的訓(xùn)練例子。

在Wikipedia填槽任務(wù)上的實(shí)驗表明,該方法可以高精度地將已知關(guān)系類型的新問題概括為新問題,并且在較低的精度水平下,Zero-shot地概括為不可見的關(guān)系類型是可能的,這為該任務(wù)的未來工作設(shè)置了標(biāo)準(zhǔn)。

責(zé)任編輯:xj

原文標(biāo)題:超全必讀!NLP 事件抽取綜述(下)

文章出處:【微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

事件

+關(guān)注

關(guān)注

0文章

12瀏覽量

9919 -

自然語言處理

+關(guān)注

關(guān)注

1文章

614瀏覽量

13511 -

nlp

+關(guān)注

關(guān)注

1文章

487瀏覽量

22015

原文標(biāo)題:超全必讀!NLP 事件抽取綜述(下)

文章出處:【微信號:zenRRan,微信公眾號:深度學(xué)習(xí)自然語言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

語義分割25種損失函數(shù)綜述和展望

NLP事件抽取綜述之挑戰(zhàn)與展望

NLP事件抽取綜述之挑戰(zhàn)與展望

評論