開發人工智能的語言模型,一直是人工智能的重要細分領域。人工智能語言模型應用包括搜索引擎、文字生成、個性化的對話工具以及軟件生成等。

2020年5月,OpenAI的一組研究人員發布了具有里程碑意義的AI模型GPT-3。GPT-3就是在570 GB的文本數據上訓練的語言模型,因此,就訓練數據和生成能力而言,GPT-3截至2020年都是最龐大的公開發布的語言模型。

此外,OpenAI的GPT-3一反之前死守基礎研究的思路,將 GPT-3 做成了一個服務,提供可以調用的 OpenAI API,并且向開放了少量體驗資格,使得拿到體驗資格的業界人士或學者等,開發出了一眾驚人的演示。

包括答題、翻譯、寫文章,甚至是數學計算和編寫代碼。而由GPT-3所寫的文章幾乎達到了以假亂真的地步,在 OpenAI 的測試中,人類評估人員也很難判斷出這篇新聞的真假,檢測準確率僅為 12%。

但現在,谷歌研究人員開發出一個新的語言模型,它包含了超過 1.6 萬億個參數,遠超 Open AI 開發的 GTP-3 的規模(1750 億個參數),成為迄今為止最大規模的人工智能語言模型,比之前谷歌開發過最大的語言模型 T5-XXL 的效率提高了 4 倍。

該語言模型使用 Switch Transformer 方法進行大規模訓練,這是一種“稀疏激活”技術,它只使用模型權重的子集或在模型中轉換輸入數據的參數,以有效降低計算密集度。

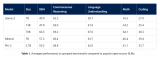

盡管在部分實驗中,該模型相比規模更小的模型得到了較低分數。但在相同的計算資源下,預訓練速度提高了7倍。這些改進擴展到多語言設置中,我們在所有101種語言中測量mT5基本版本的增益。最后,我們通過在“巨大的干凈的爬蟲語料庫”上預先訓練多達萬億個參數的模型,提高了語言模型的當前規模,并實現了比T5-XXL模型4倍的加速。

研究人員認為,稀疏性可以在未來賦予該模型在一系列不同媒體下多模態的優勢。這也為人工智能語言模型的深入研究提供了更多方向的參考。

責任編輯:xj

-

AI

+關注

關注

87文章

30239瀏覽量

268480 -

人工智能

+關注

關注

1791文章

46896瀏覽量

237672 -

語言模型

+關注

關注

0文章

508瀏覽量

10247

發布評論請先 登錄

相關推薦

聯發科新一代天璣旗艦芯片針對谷歌大語言模型Gemini Nano優化

谷歌發布新型大語言模型Gemma 2

【大語言模型:原理與工程實踐】大語言模型的應用

【大語言模型:原理與工程實踐】大語言模型的基礎技術

名單公布!【書籍評測活動NO.30】大規模語言模型:從理論到實踐

谷歌模型框架是什么軟件?谷歌模型框架怎么用?

谷歌模型軟件有哪些功能

【飛騰派4G版免費試用】仙女姐姐的嵌入式實驗室之五~LLaMA.cpp及3B“小模型”OpenBuddy-StableLM-3B

微軟宣布推出一個27億參數的語言模型Phi-2

谷歌開發出一個新的語言模型,包含了超過1.6萬億個參數

谷歌開發出一個新的語言模型,包含了超過1.6萬億個參數

評論