智東西1月20日消息,近日,麻省理工學(xué)院(MIT)的研究人員進行了一項研究,旨在在機器人身上,復(fù)制人類觸摸獲取物體位置的能力。

研究人員將他們的論文預(yù)先發(fā)表在arXiv上,強調(diào)他們的研發(fā)成果可以讓機器人僅通過觸摸,而無需通過視覺和音頻處理,就能與其周圍環(huán)境進行交互,甚至可以在第一次接觸物體時對物體進行準確定位。

一、不依賴外部傳感方式,僅通過模擬訓(xùn)練實現(xiàn)物體行為

研究人員之一Maria Bauza 在接受外媒Tech Xplore采訪時說:“我們此次研究的方法相比以往的觸覺定位工作取得了重要飛躍,因為我們可以不依賴例如視覺等其他任何外部傳感方式,也不依賴以前收集的與被操縱物體相關(guān)的觸覺數(shù)據(jù)。”

“相反,我們的技術(shù)是直接在模擬中訓(xùn)練出來的,機器人能在第一次觸摸時就定位物體,這在機器人領(lǐng)域的應(yīng)用中是至關(guān)重要的。”

在現(xiàn)實情況中,數(shù)據(jù)收集價格高昂,甚至有些數(shù)據(jù)無法被收集。而由于這個新技術(shù)是經(jīng)過模擬訓(xùn)練的,也就是說,無需真實的機器人訓(xùn)練,只需在計算機上訓(xùn)練就可完成操作。因此,Bauza和她的同事在設(shè)計的時候就不用進行復(fù)雜的數(shù)據(jù)收集工作了。

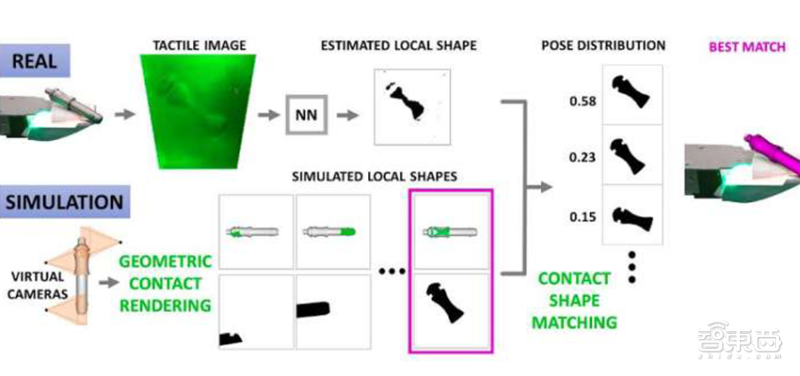

研究人員最初開發(fā)了一個框架,模擬給定物體和觸覺傳感器之間的接觸,從而假設(shè)機器人可以訪問與其交互的物體的數(shù)據(jù)(例如,物體的三維形狀、特征等)。這些接觸行為以深度圖像的形式呈現(xiàn),它顯示了物體擠壓觸覺傳感器的程度。

隨后,Bauza和她的同事們使用最先進的機器學(xué)習(xí)技術(shù)進行計算機視覺和表示學(xué)習(xí)(representation learning),觀察機器人收集的真實觸覺數(shù)據(jù),并將這些數(shù)據(jù)與模擬生成的觸點數(shù)據(jù)集進行匹配。

▲研究人員使用的觸覺傳感器

Bauza說:“我們的方法是,將表示為深度圖像的接觸編碼到一個嵌入式空間中,這極大地簡化了計算成本,使任務(wù)能夠?qū)崟r執(zhí)行。”

“在我們的工作中,我們在多接觸場景中對這一點進行了演示,其中在多個觸覺傳感器同時接觸一個物體的情況下,我們必須將所有觀察結(jié)果整合到對物體姿態(tài)的估計中。”

從本質(zhì)上講,這個研究小組設(shè)計的方法可以簡單基于物體的三維形狀來模擬接觸信息。因此,它不需要在仔細檢查物體時收集任何以前的觸覺數(shù)據(jù)。這使得該技術(shù)能夠通過機器人的觸覺傳感器,在它第一次接觸到物體時,就對物體產(chǎn)生姿態(tài)估計。

Bauza說:“我們意識到觸覺傳感具有很強的鑒別力,并可以產(chǎn)生高度精確的姿勢估計。視覺有時候會受到遮擋的影響,但觸覺不會。因此,如果一個機器人接觸到一個少見且獨特物體的某一部分,那么我們的算法可以輕易識別出機器人接觸的物體,從而識別物體的姿態(tài)。”

二、“多手指”感觸提高操作精度,適用工業(yè)領(lǐng)域

許多物體不同側(cè)面的觸感相似,而Bauza和她的同事開發(fā)的方法可以預(yù)測姿勢分布,而不止對單個姿態(tài)進行估計。這一特征非常特殊,與此前只收集單一姿態(tài)估計的目標姿態(tài)估計方法形成鮮明對比。此外,麻省理工學(xué)院研究小組的框架所預(yù)測的分布可以直接與外部信息整合,以進一步減少物體姿態(tài)的不確定性。

Bauza說:“值得注意的是,我們還觀察到,像用幾個手指接觸一個物體一樣同時進行多個接觸行為,可以很大程度上減少對物體姿勢判斷的不確定性。這證實了我們的預(yù)測,即在一個對象上添加接觸會限制其姿態(tài)并簡化姿態(tài)檢測過程。”

▲方法運作流程:接觸→ 觸覺觀察→觸覺深度→匹配使用研究人員的最佳算法→結(jié)果姿勢

為了輔助人類進行日常活動,機器人必須能夠高精度、高可靠性地完成任務(wù)。由于對物體的操縱意味著機器人需要直接接觸物體,因此開發(fā)能有效使機器人進行觸覺傳感的技術(shù)至關(guān)重要。

另一位參與這一項目的研究人員Alberto Rodriguez在接受媒體采訪時說,觸覺能力最近受到了工業(yè)領(lǐng)域的極大關(guān)注,我們通過對三個因素的結(jié)合實現(xiàn)了觸覺能力技術(shù)的突破:

1、 使用具有高分辨率的小型攝像機,捕捉觸摸表面變形的狀態(tài),這一傳感技術(shù)成本較低。例如:GelSight 傳感。

2、 將上述第一點中提到的傳感技術(shù)與機器人手指進行結(jié)合。例如:GelSlim 手指。

3、 一種基于深度學(xué)習(xí)的計算框架,它可以有效處理高分辨率觸覺圖像,實現(xiàn)已知部位的觸覺定位。例如:本文提到的研究。

Rodriguez說:“這類技術(shù)正在逐漸成熟,行業(yè)正在看到自動化任務(wù)的價值。比如,在裝配自動化領(lǐng)域,觸摸任務(wù)的實施就對精確度有要求。”

這組研究人員設(shè)計的技術(shù),使機器人能實時估計他們正在操縱的物體的姿態(tài),而且精確度很高。這使工作人員有機會對機器人的動作或行為影響做出更準確的預(yù)測,從而提高機器人在操作任務(wù)中的表現(xiàn)。

這一研究或許能夠證明其在工業(yè)領(lǐng)域應(yīng)用中的價值。在工業(yè)領(lǐng)域,制造商可以依此根據(jù)產(chǎn)品形狀的清晰模型組裝產(chǎn)品。

未來,研究人員計劃擴展他們的框架,使其同時包含有關(guān)物體的視覺信息。他們希望將現(xiàn)有的技術(shù)轉(zhuǎn)化為一個視覺-觸覺傳感系統(tǒng),可以更精準地估計物體的姿態(tài)。

此外,他們還將研發(fā)讓機器人進行精確拾取和放置操作的技術(shù)。他們的目標是,讓機器人能進行穩(wěn)定抓取任務(wù)的同時,還能幫助其進行感知,提高其觸覺定位能力。

結(jié)語:為機器人提供更多感官

視覺、音頻技術(shù)是機器人定位常用的方式,這次,MIT的研究人員從觸覺方面為機器人確認物體位置的方式提供了一個新的切口。

人類通過各種感官確認物體的形狀和位置,未來,機器人或許也能像人類一樣,通過眼睛鎖定,耳朵聽見,皮膚觸摸,鼻子嗅聞來準確鎖定物體位置、形狀及狀態(tài)。

責(zé)任編輯:xj

原文標題:MIT新研究:讓機器人像人一樣有觸覺,觸摸可識別姿態(tài)位置

文章出處:【微信公眾號:天津機器人】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

機器人

+關(guān)注

關(guān)注

210文章

28205瀏覽量

206532 -

觸覺

+關(guān)注

關(guān)注

0文章

19瀏覽量

9456

原文標題:MIT新研究:讓機器人像人一樣有觸覺,觸摸可識別姿態(tài)位置

文章出處:【微信號:tjrobot,微信公眾號:天津機器人】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

麻省理工學(xué)院對光子集成的量子發(fā)射器的光譜特性研究

麻省理工學(xué)院研發(fā)全新納米級3D晶體管,突破性能極限

麻省理工學(xué)院推出新型機器人訓(xùn)練模型

美國佐治亞理工學(xué)院一行蒞臨達實智能調(diào)研

麻省理工學(xué)院研發(fā)RoboGrocery系統(tǒng),雜貨店自動化裝袋新篇章

感謝東莞理工學(xué)院對我司導(dǎo)熱系數(shù)測試儀的認可

蘇黎世聯(lián)邦理工學(xué)院報告:Rowhammer攻擊對高端RISC-V CPU的潛在風(fēng)險

指南車機器人攜同南昌工學(xué)院參觀南京熊貓電子

一種用于化學(xué)和生物材料識別的便攜式拉曼光譜解決方案

麻省理工與Adobe新技術(shù)DMD提升圖像生成速度

霍尼韋爾與南方泵業(yè)開展戰(zhàn)略合作,四川成都一家紅外熱成像專用圖像處理芯片服務(wù)商完成A+輪融資

瑞士蘇黎世聯(lián)邦理工學(xué)院新型四足機器人單腿完成開關(guān)門、移動任務(wù)

麻省理工學(xué)院開發(fā)出新的RFID標簽防篡改技術(shù)

迷思科技獲數(shù)千萬Pre A輪融資,安森美和理想汽車續(xù)簽長期供貨協(xié)議

Innovusion駛?cè)氤掷m(xù)增長快車道,消息稱中國特供版英偉達 H20 AI 芯片推遲到明年一季度發(fā)布

麻省理工學(xué)院新研究:讓機器人像人一樣有觸覺

麻省理工學(xué)院新研究:讓機器人像人一樣有觸覺

評論