概述

深度學習中CNN網絡是核心,對CNN網絡來說卷積層與池化層的計算至關重要,不同的步長、填充方式、卷積核大小、池化層策略等都會對最終輸出模型與參數、計算復雜度產生重要影響,本文將從卷積層與池化層計算這些相關參數出發,演示一下不同步長、填充方式、卷積核大小計算結果差異。

一:卷積層

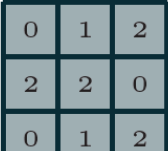

卷積神經網絡(CNN)第一次提出是在1997年,楊樂春(LeNet)大神的一篇關于數字OCR識別的論文,在2012年的ImageNet競賽中CNN網絡成功擊敗其它非DNN模型算法,從此獲得學術界的關注與工業界的興趣。毫無疑問學習深度學習必須要學習CNN網絡,學習CNN就必須明白卷積層,池化層等這些基礎各層,以及它們的參數意義,從本質上來說,圖像卷積都是離散卷積,圖像數據一般都是多維度數據(至少兩維),離散卷積本質上是線性變換、具有稀疏與參數重用特征即相同參數可以應用輸入圖像的不同小分塊,假設有3x3離散卷積核如下:

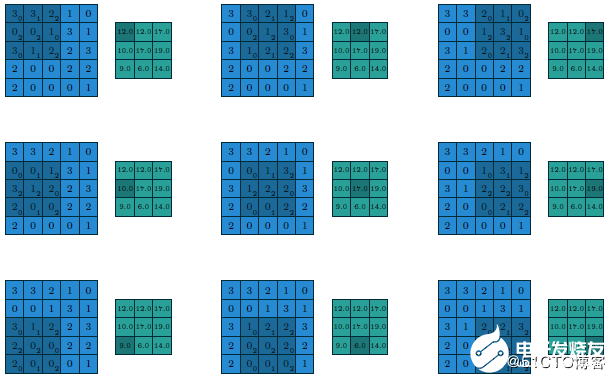

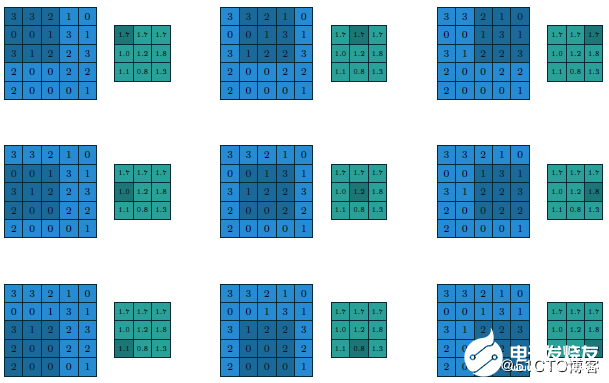

假設有

5x5的圖像輸入塊

步長為1(strides=1)

填充方式為VALID(Padding=VALID)

卷積核大小filter size=3x3

則它們的計算過程與輸出如下

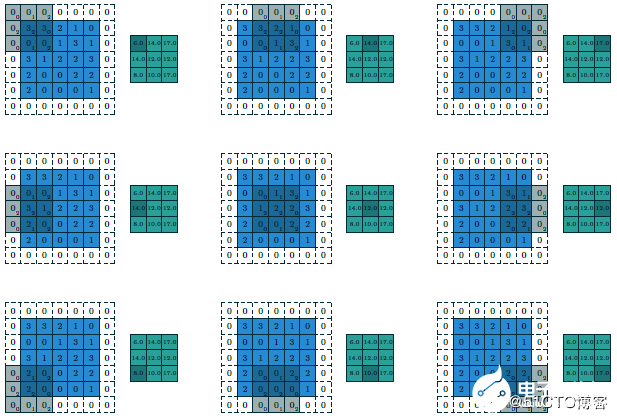

假設這個時候我們修改步長為2、填充方式為SAME,卷積核大小不變(strides=2 Padding=SAME filter size=3x3),則計算過程與輸出變為如下:

最終輸出得到的結果我們可以稱為featuremap,CNN的深度多數時候是指featuremap的個數,對多維度的輸入圖像計算多個卷積核,得到多個featuremap輸出疊加,顯示如下:

上述輸入為5x5x2,使用卷積核3x3,輸出3x3x3,填充方式為VALID,計算如果填充方式改為SAME則輸出為5x5x3。可以看出填充方式對輸出結果的影響。

二:小卷積核VS大卷積核

在AlexNet中有有11x11的卷積核與5x5的卷積核,但是在VGG網絡中因為層數增加,卷積核都變成3x3與1x1的大小啦,這樣的好處是可以減少訓練時候的計算量,有利于降低總的參數數目。關于如何把大卷積核替換為小卷積核,本質上有兩種方法。

1. 將二維卷積差分為兩個連續一維卷積

二維卷積都可以拆分為兩個一維的卷積,這個是有數學依據的,所以11x11的卷積可以轉換為1x11與11x1兩個連續的卷積核計算,總的運算次數:

11x11 = 121次

1x11+ 11x1 = 22次

2.將大二維卷積用多個連續小二維卷積替代

可見把大的二維卷積核在計算環節改成兩個連續的小卷積核可以極大降低計算次數、減少計算復雜度。同樣大的二維卷積核還可以通過幾個小的二維卷積核替代得到。比如:5x5的卷積,我們可以通過兩個連續的3x3的卷積替代,比較計算次數

5x5= 25次

3x3+ 3x3=18次

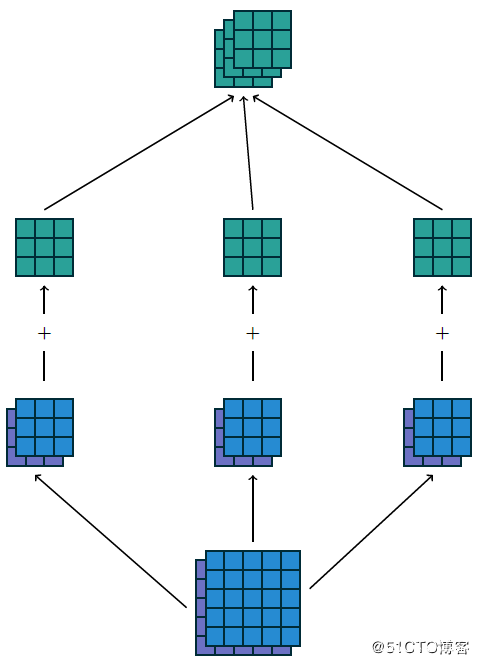

三:池化層

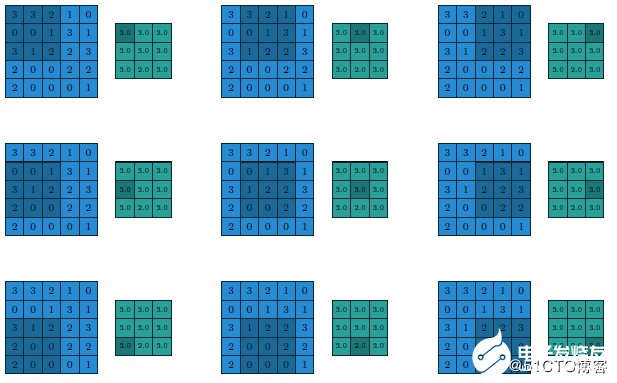

在CNN網絡中卷積池之后會跟上一個池化層,池化層的作用是提取局部均值與最大值,根據計算出來的值不一樣就分為均值池化層與最大值池化層,一般常見的多為最大值池化層。池化的時候同樣需要提供filter的大小、步長、下面就是3x3步長為1的filter在5x5的輸入圖像上均值池化計算過程與輸出結果

改用最大值做池化的過程與結果如下:

編輯:jq

-

卷積

+關注

關注

0文章

95瀏覽量

18499 -

cnn

+關注

關注

3文章

351瀏覽量

22169 -

vgg

+關注

關注

1文章

11瀏覽量

5185 -

池化

+關注

關注

0文章

4瀏覽量

1100

發布評論請先 登錄

相關推薦

如何去理解CNN卷積層與池化層計算?

如何去理解CNN卷積層與池化層計算?

評論