引言

知識圖譜嵌入 knowledge graph embedding是將包含實體和關系的知識圖譜三元組嵌入到高維向量空間中,獲得實體和關系的數值表示,提取圖中相關信息,并進行后續運算推斷。常用于知識圖譜補全 (KG completion),關系提取 (relation extraction),實體分類 (entity classification),實體決議 (entity resolution)等等。

本次Fudan DISC實驗室將分享三篇關于知識圖譜嵌入模型的論文,分別介紹其訓練策略、概率校準、模型設計三個方面取得的進展。

文章概覽

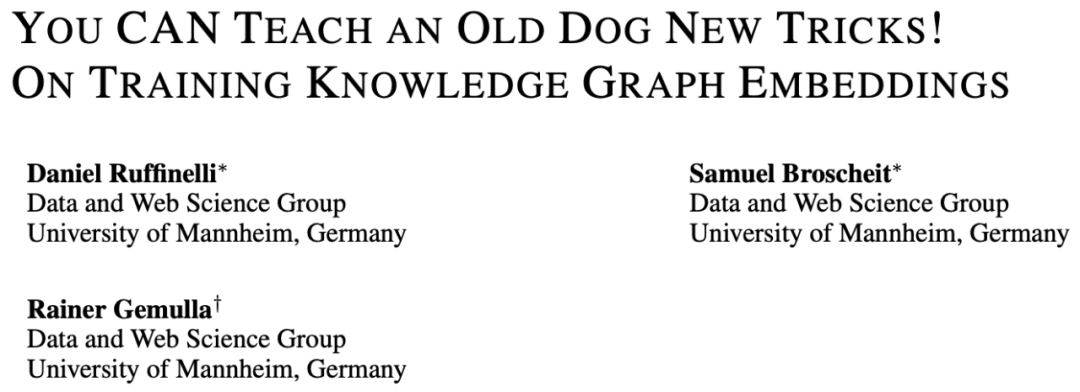

知識圖譜嵌入模型的訓練策略(You CAN Teach an Old Dog New Tricks! On Training Knowledge Graph Embeddings)

論文地址:https://openreview.net/pdf?id=BkxSmlBFvr

該篇文章在兩個常見數據集上對比了五種知識圖譜嵌入 (Knowledge Graph Embedding) 方法在同樣的訓練框架和參數設置下的性能,總結并評測了不同模型架構和不同訓練策略對模型的影響,正如文章標題所說“你可以教給老狗新的技巧”,訓練策略對模型的性能有重大影響,并且可能占最近幾年進展的很大一部分。

知識圖譜嵌入模型的概率校準(Probability Calibration for Knowledge Graph Embedding Models)

論文地址:https://openreview.net/pdf?id=S1g8K1BFwS

該篇文章將概率校準的兩種方法運用到知識圖譜嵌入模型中,解決了當前知識圖譜嵌入模型對于實體推斷的打分不是概率的問題。

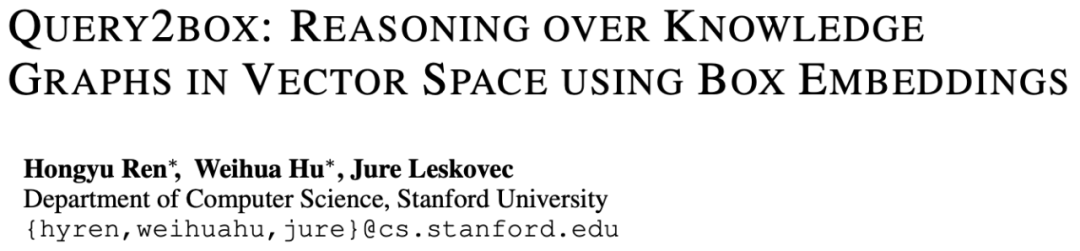

使用盒嵌入在知識圖譜上推斷(Query2box: Reasoning over Knowledge Graphs in Vector Space Using Box Embeddings)

論文地址:https://openreview.net/pdf?id=BJgr4kSFDS

該篇文章將盒嵌入引入知識圖譜推斷中,將原有的基于點嵌入的模型升級為基于高維矩形嵌入的模型,解決推斷過程中“一推多”、合取、析取的問題。

論文細節

1

論文動機

目前有很多知識圖譜嵌入模型,是近期的熱點;

這些模型缺少統一的訓練策略消融對比;

通常沒有考慮最先進的基線。

以此帶來的問題是難以評估模型和訓練的貢獻。因此文章將熱門的5個模型在2個廣泛使用的數據集上控制訓練策略進行實驗對比。

方法

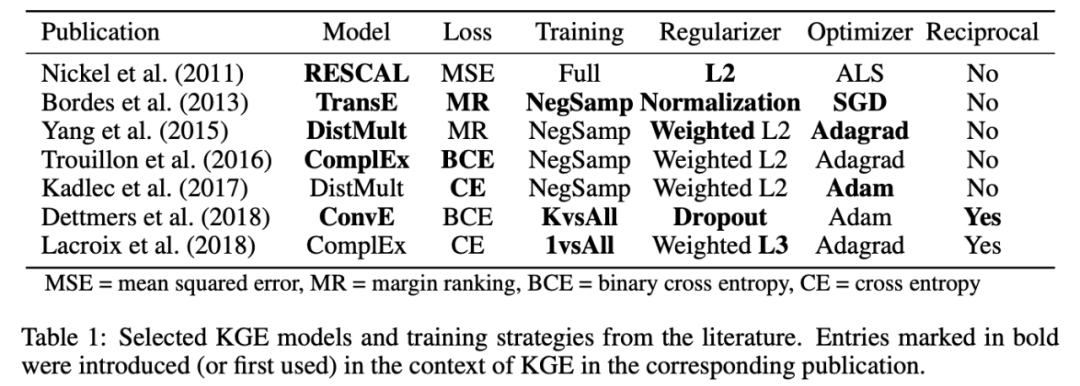

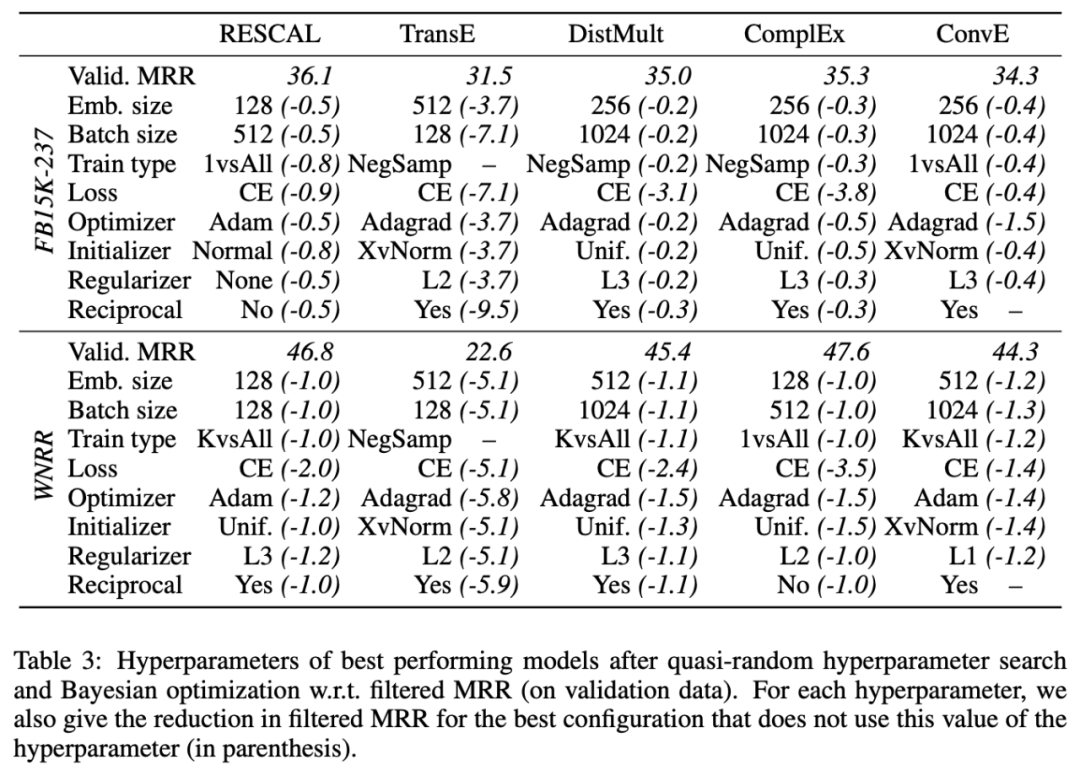

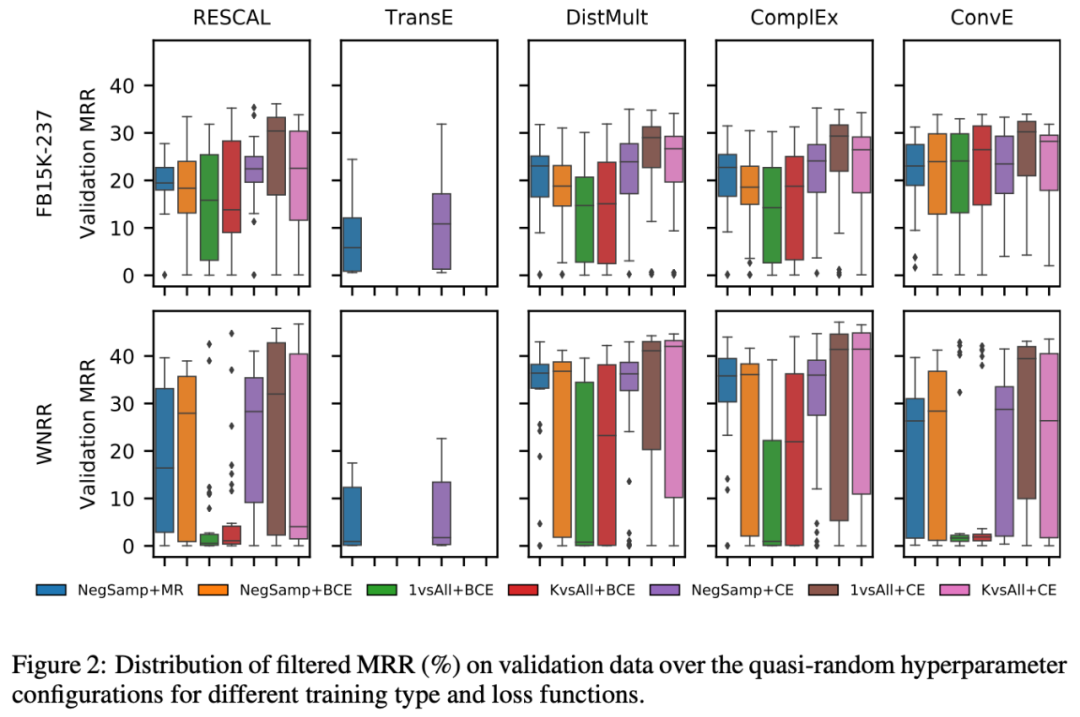

本文使用上表中的5個模型對比了如下的訓練參數設置,篇幅有限不做過多介紹。

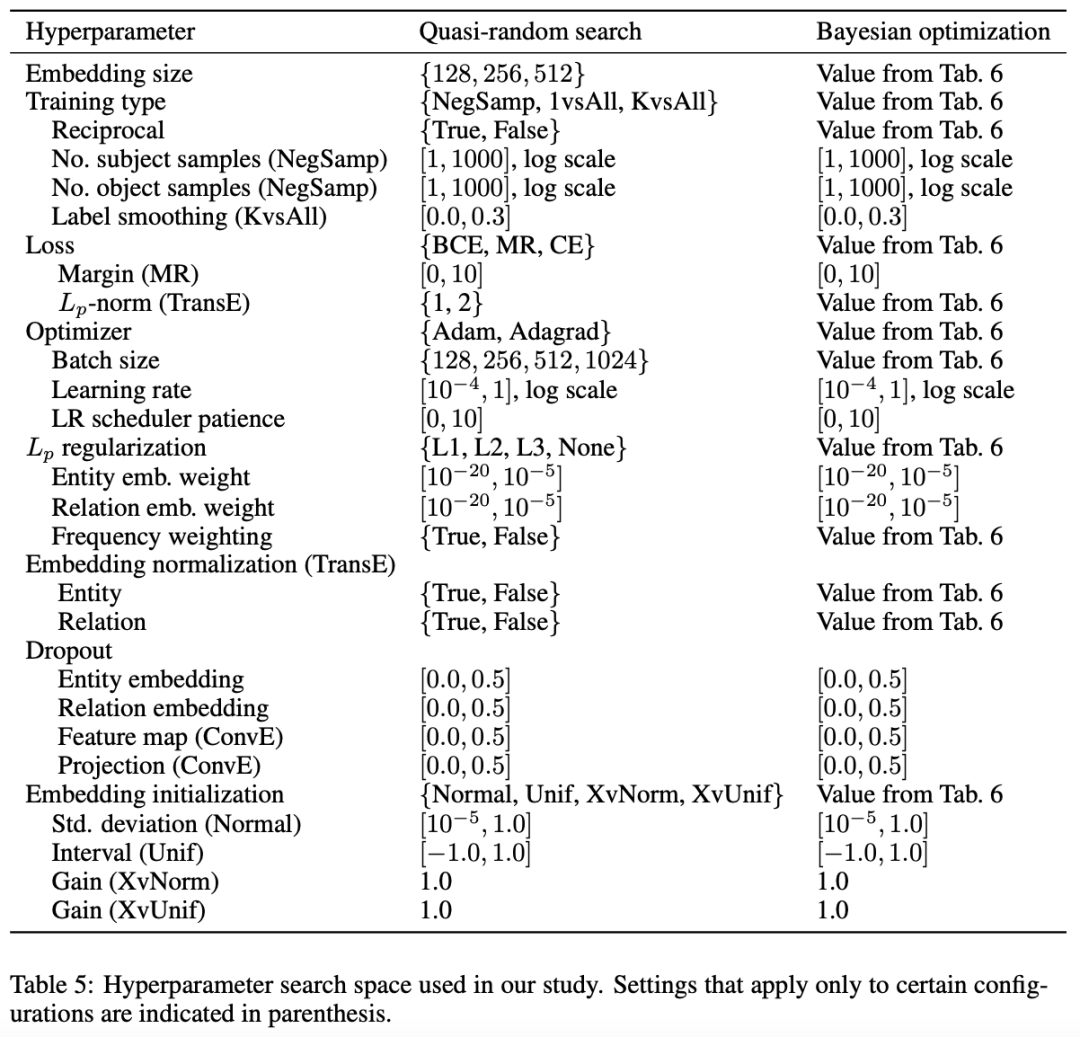

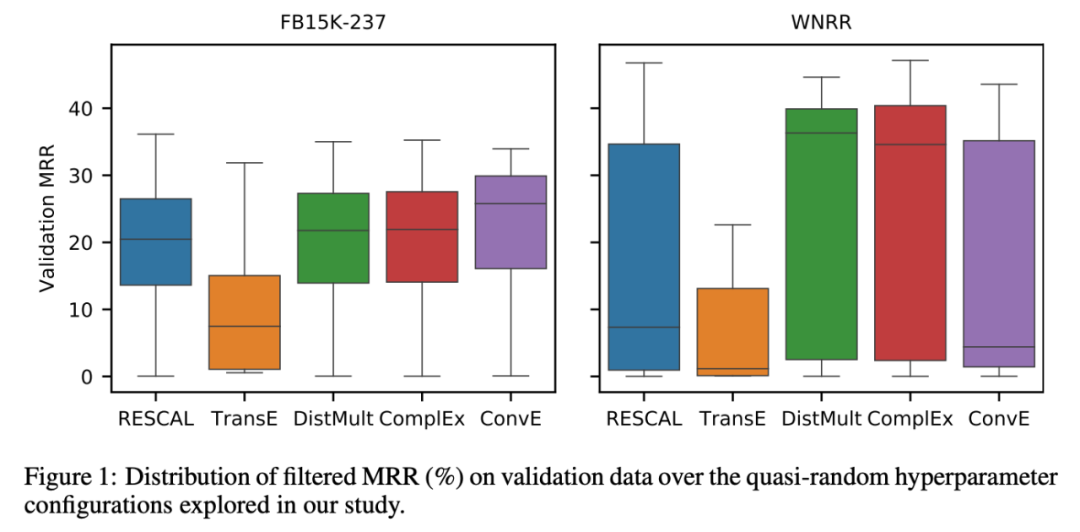

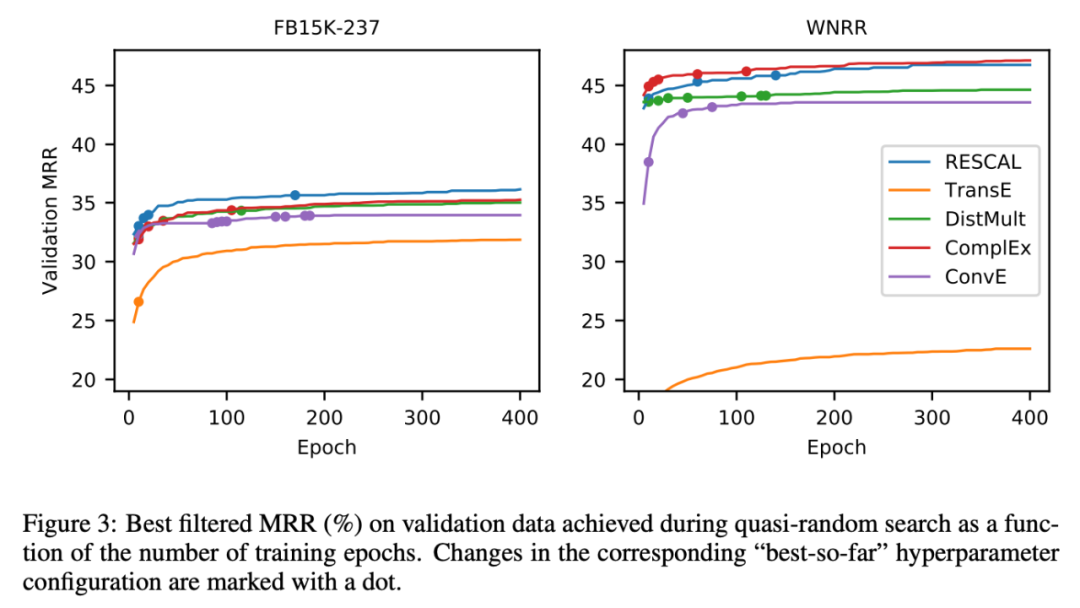

實驗結果

結果表明通過好的訓練策略,熱門模型都比他們論文剛發表時發布的性能有所提升,甚至有些模型可以超過后來提出的模型,如RESCAL;同時,文中也對比了重新實現的模型與更新的模型性能,發現最新的模型并沒有比之前的模型在訓練策略調優后的效果上有明顯提升。

同時,每個模型在不同訓練策略下的方差都比較大,并沒有完全特別好的模型。

此外,文章還對比了不同參數的作用,以及訓練的過程。

2

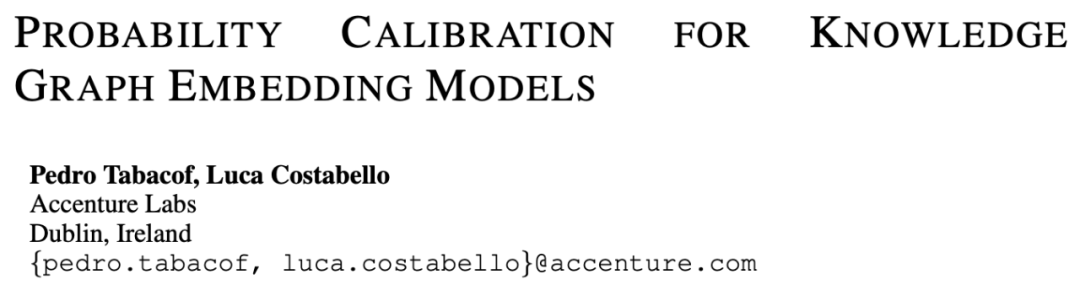

論文動機

知識圖譜嵌入研究忽略了概率標定問題。

流行的知識圖譜嵌入模型沒有校準。

知識圖譜嵌入得到分數的概率都是不可靠的。

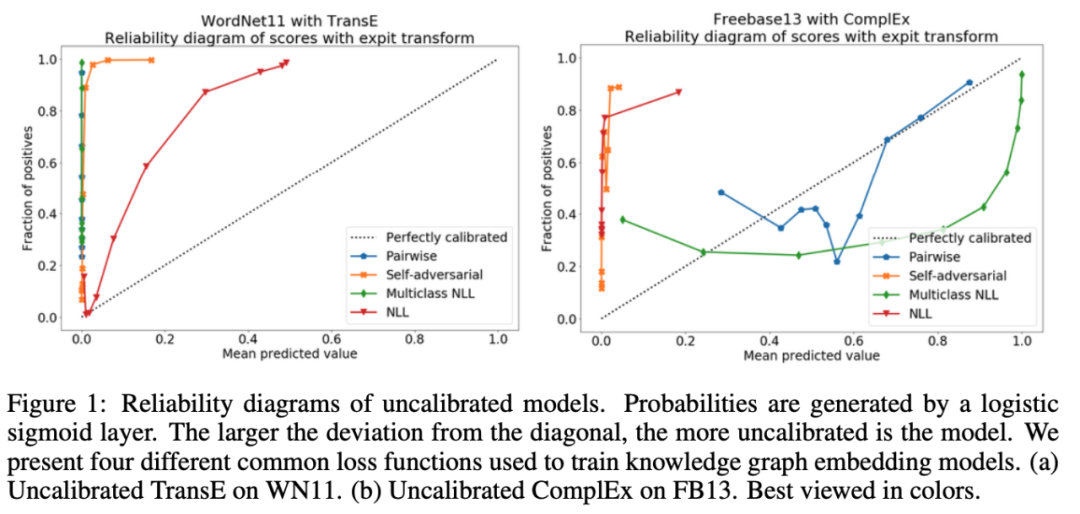

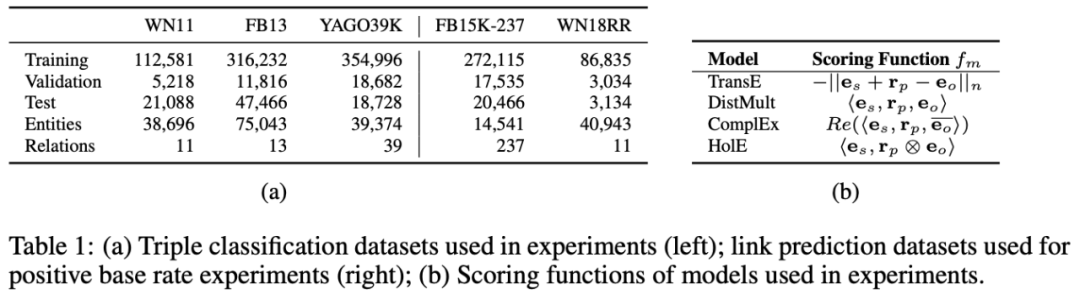

因此,本文提出了一種知識圖嵌入模型的標定方法,使用Platt標度和等滲回歸,對概率進行了校準。

方法

論文主要的研究對象是基于知識圖譜嵌入的評分,使用Platt標度和等滲回歸,對評分概率進行了校準。

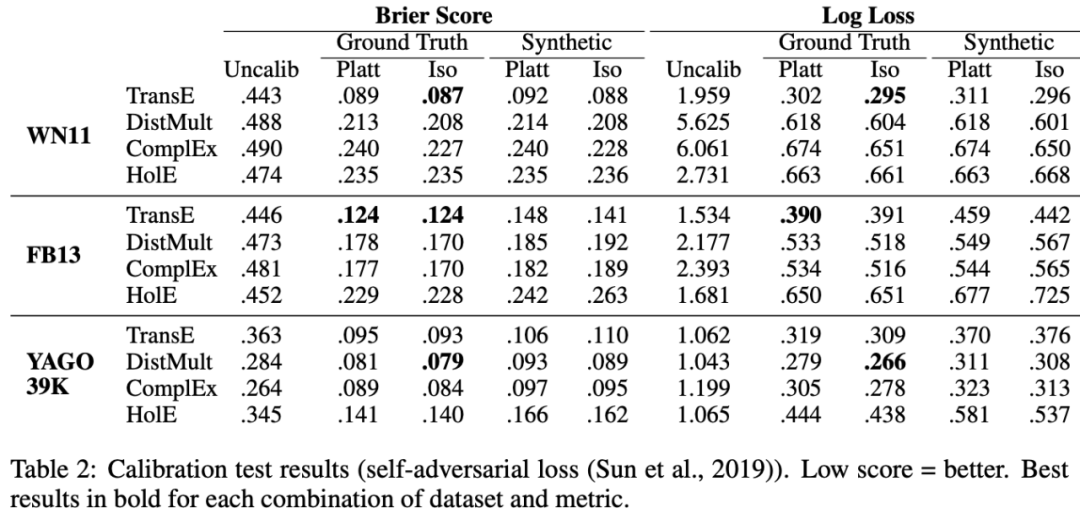

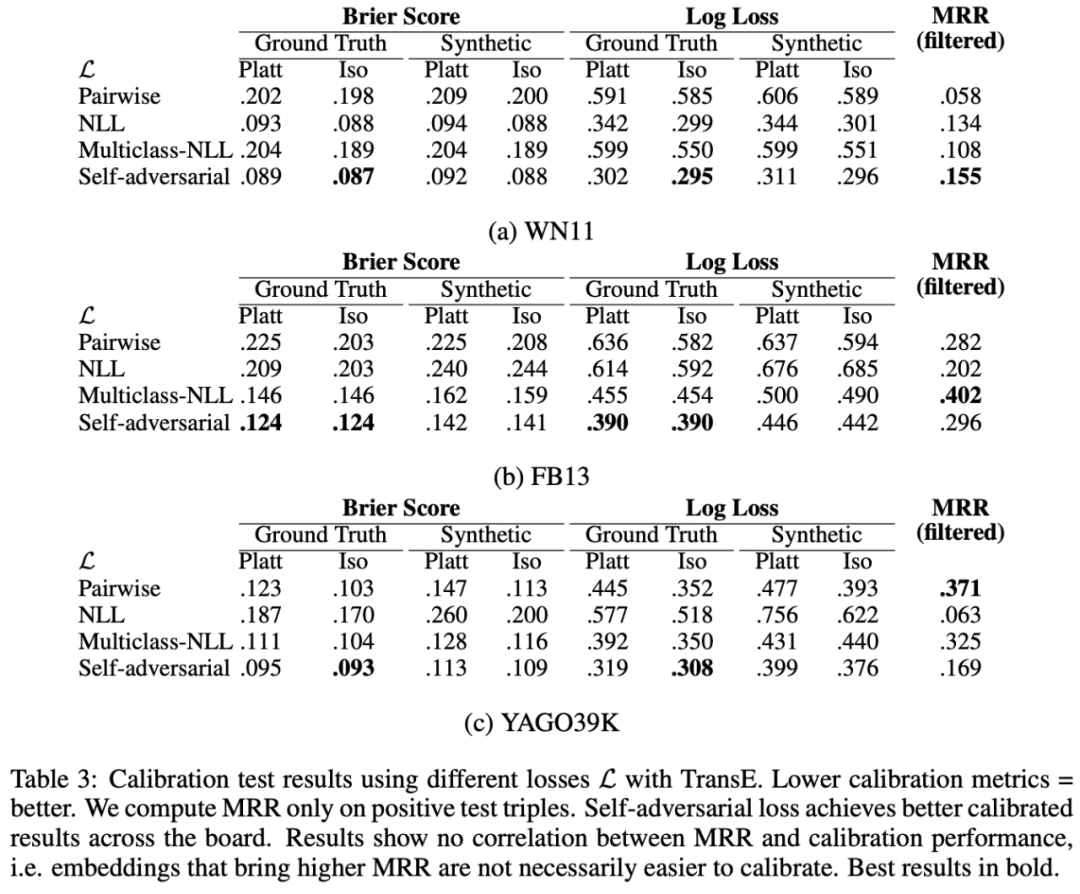

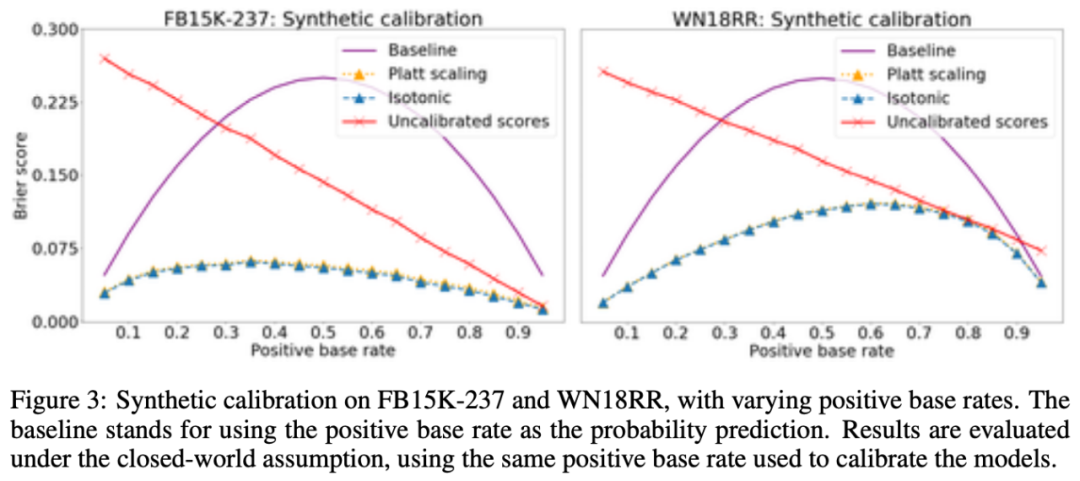

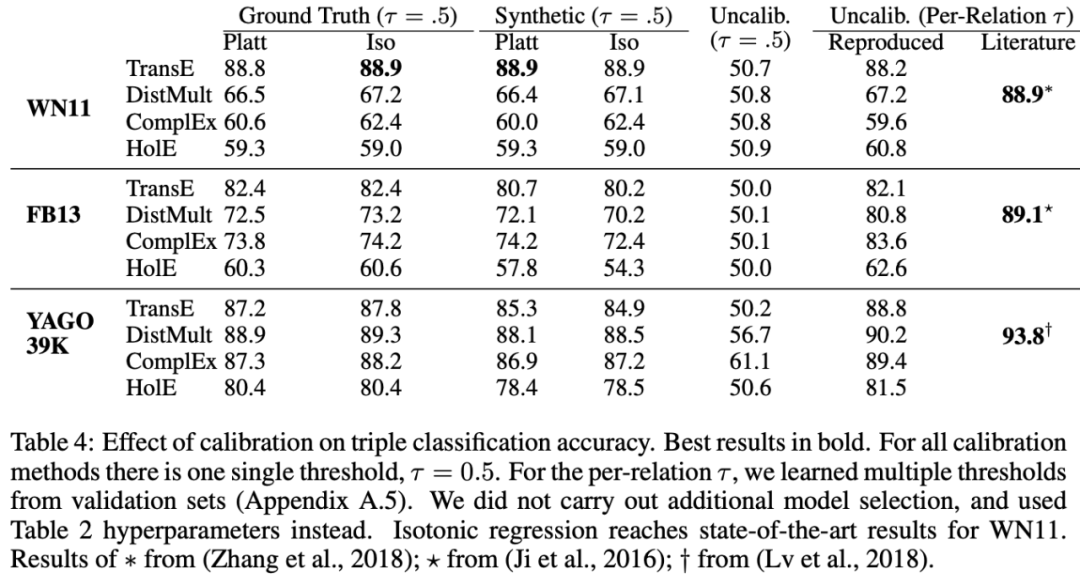

實驗結果

實驗結果表明,Platt標度和等滲回歸的校準效果良好。

3

論文動機

在知識圖譜的鏈接預測(link prediction)中,存在多步推理的情況,以及有的時候推理并不是一一對應,而是存在同樣滿足條件的多個實體集合的情況。當前的研究主要關注于單步的點推理,也沒有考慮推理中集合的操作。因此,本文提出將盒嵌入模型用于回答知識圖譜的推理問題,從而解決推理中多步集合推理的問題。

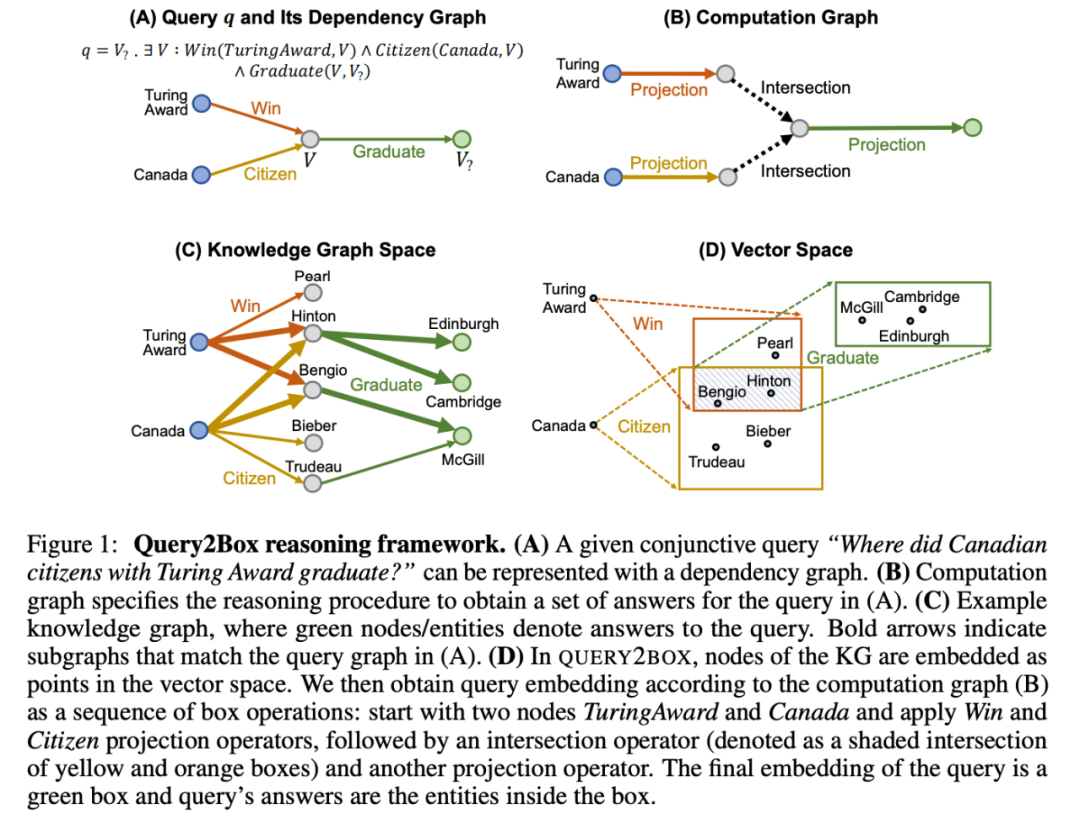

方法

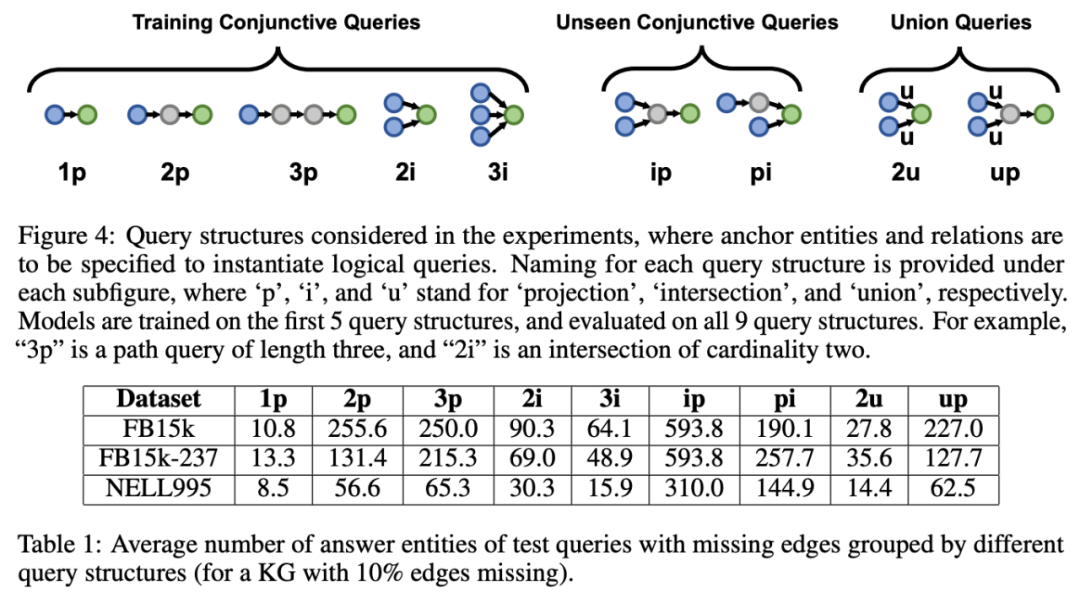

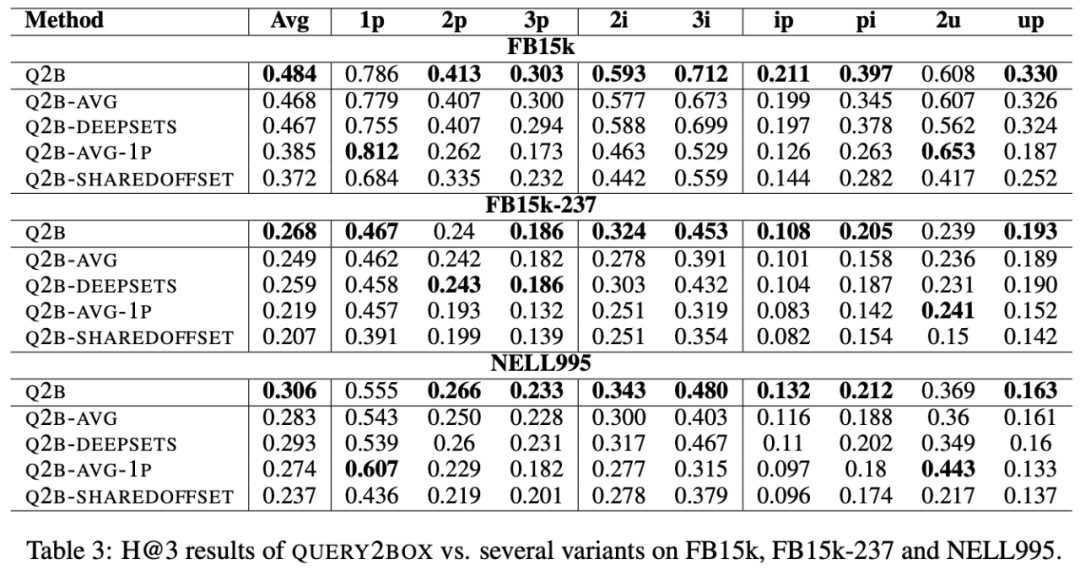

文中定義了盒嵌入向量的構造和投影合取的操作,以及距離的計算方式。

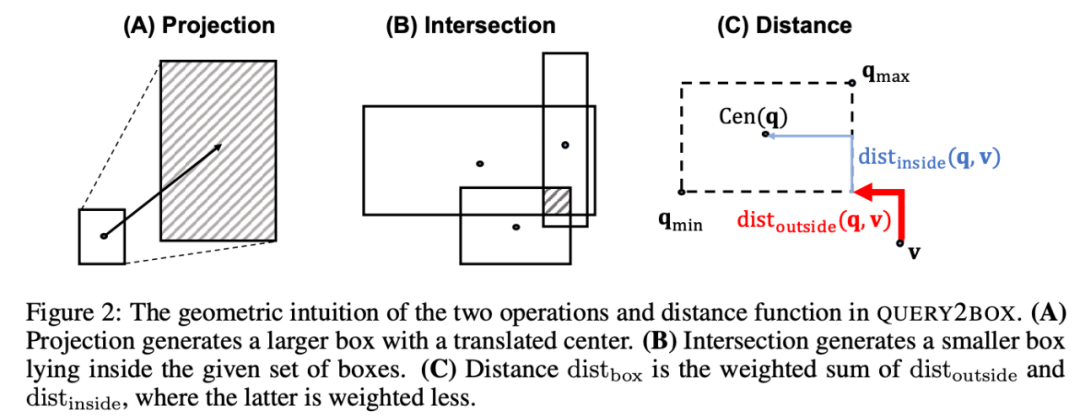

此外,文中還證明了任何一個命題都可以轉化為標準形式。

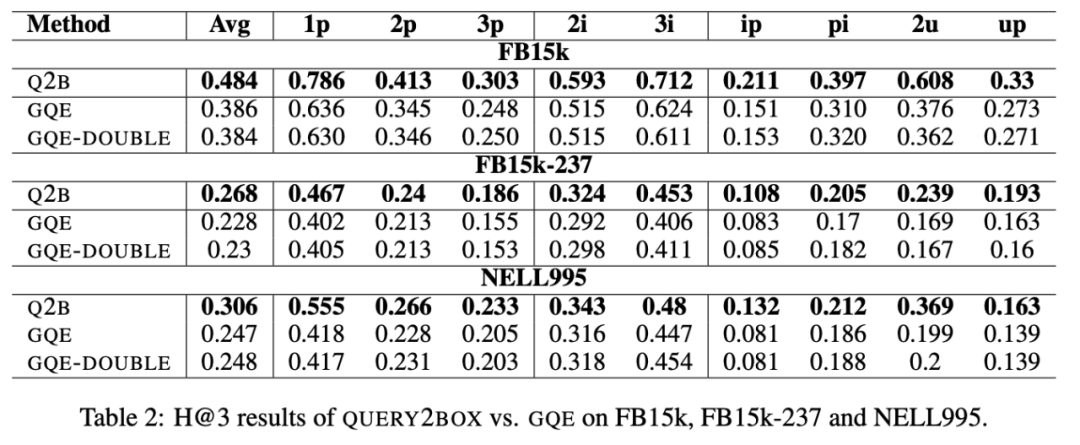

實驗結果

實驗結果表明盒嵌入模型相比于點嵌入模型擁有更好的推理效果。

總結

此次 Fudan DISC 解讀的三篇論文圍繞知識圖譜嵌入模型展開,訓練策略對于嵌入模型的訓練影響很大,由知識圖譜嵌入模型得到的打分可以通過概率校準的手段使其變成概率,盒嵌入模型的引入解決了復雜集合推斷的問題。

責任編輯:lq

-

模型

+關注

關注

1文章

3172瀏覽量

48713 -

數據集

+關注

關注

4文章

1205瀏覽量

24643 -

知識圖譜

+關注

關注

2文章

132瀏覽量

7694

原文標題:知識圖譜嵌入的一點小事 - ICLR2021

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

LIMS系統在芯片實驗室中的應用

三星自主研發知識圖譜技術,強化Galaxy AI用戶體驗與數據安全

LIMS實驗室管理平臺的實施步驟

榮耀與智譜攜手共建AI大模型聯合實驗室

三星電子將收購英國知識圖譜技術初創企業

知識圖譜與大模型之間的關系

DEKRA德凱為Hisense海信實驗室授予CTF實驗室資質

要讓量子計算走出實驗室

利用知識圖譜與Llama-Index技術構建大模型驅動的RAG系統(下)

上海AI實驗室發布新一代書生·視覺大模型

三星在硅谷建立3D DRAM研發實驗室

三星計劃在硅谷開設實驗室

實驗室設備定位管理系統

知識圖譜基礎知識應用和學術前沿趨勢

三維天地助力計量實驗室全方位資源管理

Fudan DISC實驗室將分享三篇關于知識圖譜嵌入模型的論文

Fudan DISC實驗室將分享三篇關于知識圖譜嵌入模型的論文

評論