【導讀】模型好就能碾壓一切嗎?吳恩達潑冷水,機器學習發展80%依靠數據集的進步!這也激起了業內對MLOps工具鏈的關注。

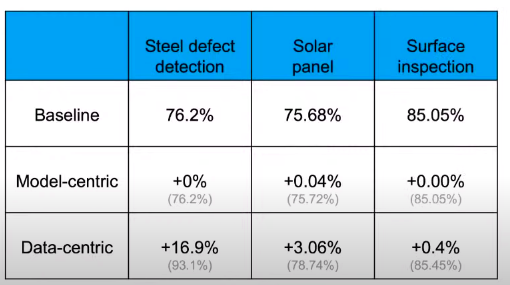

機器學習的進步是模型帶來的還是數據帶來的,這可能是一個世紀辯題。 吳恩達對此的想法是,一個機器學習團隊80%的工作應該放在數據準備上,確保數據質量是最重要的工作,每個人都知道應該如此做,但沒人在乎。如果更多地強調以數據為中心而不是以模型為中心,那么機器學習的發展會更快。

當去arxiv上查找機器學習相關的研究時,所有模型都在圍繞基準測試展示自己模型的能力,例如Google有BERT,OpenAI有GPT-3,這些模型僅解決了業務問題的20%,在業務場景中取得更好的效果需要更好的數據。 傳統軟件由代碼提供動力,而AI系統是同時使用代碼(模型+算法)和數據構建的。以前的工作方式是,當模型效果不理想,我們就會去修改模型,而沒有想過可能是數據的問題。 機器學習的進步一直是由提高基準數據集性能的努力所推動的。研究人員的常見做法是在嘗試改進代碼的同時保持數據固定,以模型改進為中心對模型性能的提升實際上效率是很低的。但是,當數據集大小適中(<10,000個示例)時,則需要在代碼上進行嘗試改進。 ?

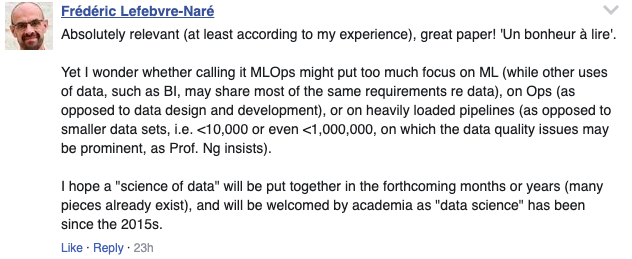

根據劍橋研究人員所做的一項研究,最重要但仍經常被忽略的問題是數據的格式不統一。當數據從不同的源流式傳輸時,這些源可能具有不同的架構,不同的約定及其存儲和訪問數據的方式。對于機器學習工程師來說,這是一個繁瑣的過程,需要將信息組合成適合機器學習的單個數據集。 小數據的劣勢在于少量的噪聲數據就會影響模型效果,而大數據量則會使標注工作變得很困難,高質量的標簽也是機器學習模型的瓶頸所在。 這番話也引起機器學習界對MLOps的重新思索。

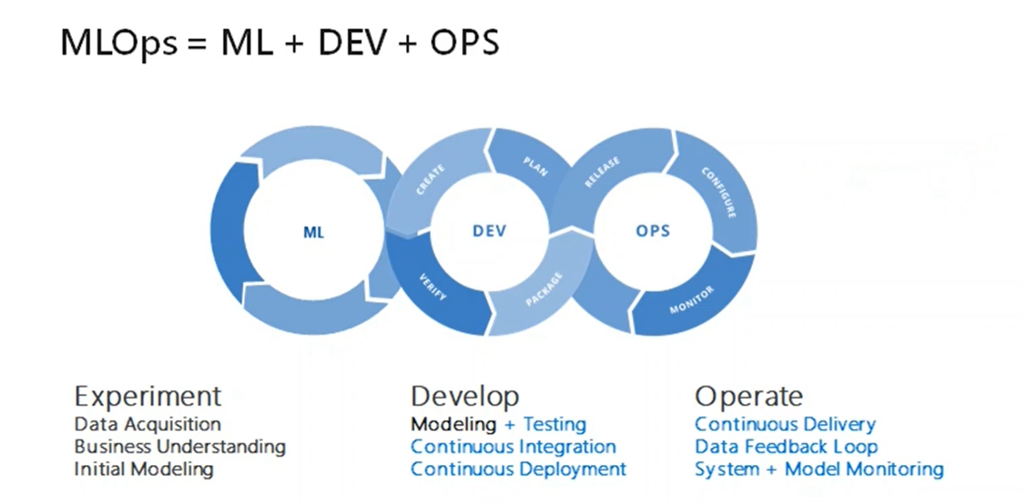

MLOps是什么? MLOps,即Machine Learning和Operations的組合,是ModelOps的子集,是數據科學家與操作專業人員之間進行協作和交流以幫助管理機器學習任務生命周期的一種實踐。

與DevOps或DataOps方法類似,MLOps希望提高自動化程度并提高生產ML的質量,同時還要關注業務和法規要求。 互聯網公司通常用有大量的數據,而如果在缺少數據的應用場景中進行部署AI時,例如農業場景 ,你不能指望自己有一百萬臺拖拉機為自己收集數據。 基于MLOps,吳恩達也提出幾點建議:

MLOps的最重要任務是提供高質量數據。

標簽的一致性也很重要。檢驗標簽是否有自己所管轄的明確界限,即使標簽的定義是好的,缺乏一致性也會導致模型效果不佳。

系統地改善baseline模型上的數據質量要比追求具有低質量數據的最新模型要好。

如果訓練期間出現錯誤,那么應當采取以數據為中心的方法。

如果以數據為中心,對于較小的數據集(<10,000個樣本),則數據容量上存在很大的改進空間。

當使用較小的數據集時,提高數據質量的工具和服務至關重要。

一致性的數據定義,涵蓋所有邊界情況,從生產數據中得到及時的反饋,數據集大小合適。 吳恩達同時建議不要指望工程師去嘗試改善數據集。相反,他希望ML社區開發更多MLOps工具,以幫助產生高質量的數據集和AI系統,并使他們具有可重復性。除此之外,MLOps是一個新生領域,MLOps團隊的最重要目標應該是確保整個項目各個階段的高質量和一致的數據流。

一些MLOps的工具已經取得了不錯的成績。 Alteryx處于自助數據分析運動的最前沿。公司的平臺“ Designer”旨在快速發現、準備和分析客戶的詳細信息。該工具用于易于使用的界面,用戶可以連接和清除數據倉庫。Alteryx的工具還包括空間文件的數據混合,可以將其附加到其他第三方數據。

Paxata提供自適應的信息平臺,它具有靈活的部署和自助操作。它使分析人員和數據科學家可以收集多個原始數據集,并將它們轉換成有價值的信息,這些信息可以立即轉換為執行模型訓練所需要的格式。該平臺是基于所見即所得設計,具有電子表格風格的數據展示,因此用戶無需學習新工具。此外,該平臺能夠提供算法協助以推斷所收集數據的含義。 TIBCO軟件最近在這個快速發展的領域中嶄露頭角。它允許用戶連接、清理、合并和整理來自不同來源的數據,其中還包括大數據存儲。該軟件使用戶可以通過簡單的在線數據整理進行數據分析,并且提供完整的API支持,可以根據自己的個性化需求進行更改。

網友表示,吳恩達老師說的太真實了!

也有網友表示,機器學習更像是數據分析,模型的搭建就是構建pipelines。

責任編輯:lq

-

機器學習

+關注

關注

66文章

8382瀏覽量

132439 -

數據集

+關注

關注

4文章

1205瀏覽量

24649 -

吳恩達

+關注

關注

0文章

26瀏覽量

7089

原文標題:吳恩達的二八定律:80%的數據+20%的模型=更好的機器學習

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

eda在機器學習中的應用

恩智浦eIQ AI和機器學習開發軟件增加兩款新工具

英偉達股價一個月內上漲25%

AMD贊助多支FIRST機器人競賽團隊

機器學習中的數據分割方法

機器學習中的數據預處理與特征工程

尹建偉教授團隊榮獲「2023年度吳文俊人工智能科技進步獎一等獎」

NVIDIA TAO工具套件功能與恩智浦eIQ機器學習開發環境的集成

谷歌模型框架是什么軟件?谷歌模型框架怎么用?

ADUC360 I2Cmaster.c中master handler與實際傳送的數據什么關系?需要傳送的數據是要放在數組里嗎?

未來十年不變的AI是什么?吳恩達等專家關于2024年AI發展趨勢的預測

吳恩達:一個機器學習團隊80%的工作應該放在數據準備上

吳恩達:一個機器學習團隊80%的工作應該放在數據準備上

評論