論文提出Dynamic Memory Induction Networks (DMIN) 網(wǎng)絡(luò)處理小樣本文本分類(lèi)。

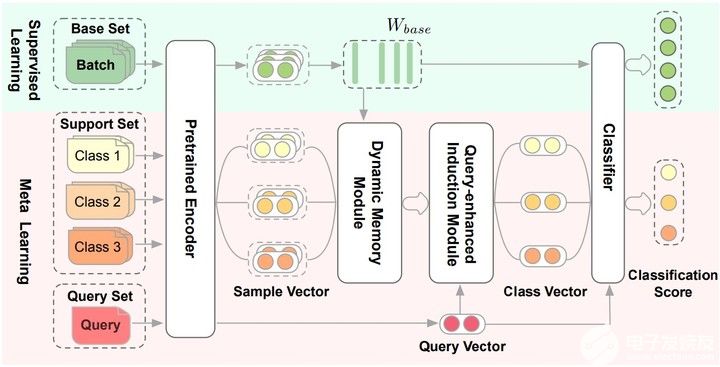

兩階段的(two-stage)few-shot模型:

在監(jiān)督學(xué)習(xí)階段(綠色的部分),訓(xùn)練數(shù)據(jù)中的部分類(lèi)別被選為base set,用于finetune預(yù)訓(xùn)練Encoder和分類(lèi)器也就是Pretrained Encoder和Classfiier圖中的部分。

在元學(xué)習(xí)階段(紅色的部分),數(shù)據(jù)被構(gòu)造成一個(gè)個(gè)episode的形式用于計(jì)算梯度和更新模型參數(shù)。對(duì)于C-way K-shot,一個(gè)訓(xùn)練episode中的Support Set是從訓(xùn)練數(shù)據(jù)中隨機(jī)選擇C個(gè)類(lèi)別,每個(gè)類(lèi)別選擇K個(gè)實(shí)例構(gòu)成的。每個(gè)類(lèi)別剩下的樣本就構(gòu)成Query Set。也就是在Support Set上訓(xùn)練模型,在Query Set上計(jì)算損失更新參數(shù)。

Pretrained Encoder

用[CLS]預(yù)訓(xùn)練的句子的Bert-base Embedding來(lái)做fine-tune。$W_{base}$ 就作為元學(xué)習(xí)的base特征記憶矩陣,監(jiān)督學(xué)習(xí)得到的。

Dynamic Memory Module

在元學(xué)習(xí)階段,為了從給定的Support Set中歸納出類(lèi)級(jí)別的向量表示,根據(jù)記憶矩陣 $W_{base}$ 學(xué)習(xí)Dynamic Memory Module(動(dòng)態(tài)記憶模塊)。

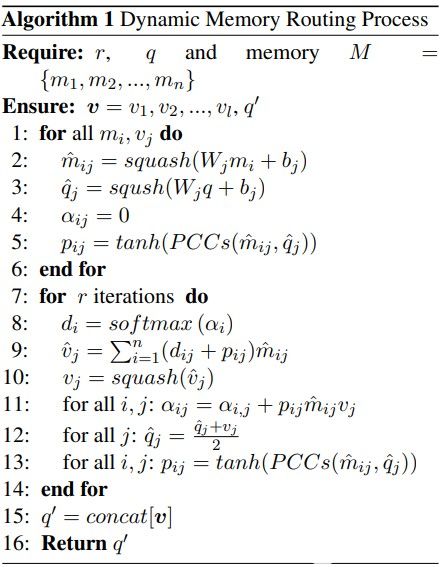

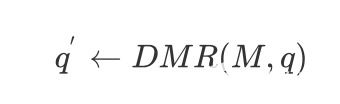

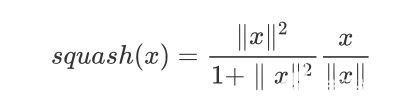

給定一個(gè) $M$ ( $W_{base}$ )和樣本向量 q , q 就是一個(gè)特征膠囊,所以動(dòng)態(tài)記憶路由算法就是為了得到適應(yīng)監(jiān)督信息 $ W_{base} $ 的向量 $q^{'}$ ,

$$ q^{'} \leftarrow DMR(M, q) $$ 學(xué)習(xí)記憶矩陣 $M$ 中的每個(gè)類(lèi)別向量 $M^{'} $ 進(jìn)行更新,

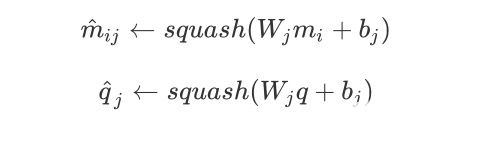

其中

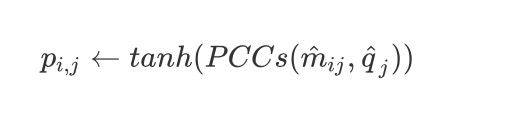

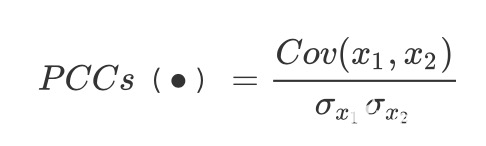

這里的 $W_j$ 就是一個(gè)權(quán)重。因此變換權(quán)重 $W_j$ 和偏差 $b_j$ 在輸入時(shí)候是可以共享的, 因此計(jì)算 $\hat{m}{ij}$ 和 $\hat{q}_j$ 之間的皮爾遜相關(guān)系數(shù)

其中

接下來(lái)就是進(jìn)行動(dòng)態(tài)路由算法學(xué)習(xí)最佳的特征映射(這里添加了$p_{ij}$到路由協(xié)議中),到第11行為止。從第12行開(kāi)始也會(huì)根據(jù)監(jiān)督學(xué)習(xí)的記憶矩陣和膠囊的皮爾遜相關(guān)系數(shù)來(lái)更新$p_{ij}$,最后把部分膠囊

編輯:jq

-

數(shù)據(jù)

+關(guān)注

關(guān)注

8文章

6898瀏覽量

88839 -

Query

+關(guān)注

關(guān)注

0文章

11瀏覽量

9334 -

小樣本

+關(guān)注

關(guān)注

0文章

7瀏覽量

6812 -

動(dòng)態(tài)路由

+關(guān)注

關(guān)注

0文章

16瀏覽量

23111 -

網(wǎng)絡(luò)處理

+關(guān)注

關(guān)注

0文章

5瀏覽量

6333

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AFE4960如何正確的從FIFO中讀取樣本呢?

RK3588 技術(shù)分享 | 在Android系統(tǒng)中使用NPU實(shí)現(xiàn)Yolov5分類(lèi)檢測(cè)

RK3588 技術(shù)分享 | 在Android系統(tǒng)中使用NPU實(shí)現(xiàn)Yolov5分類(lèi)檢測(cè)

利用TensorFlow實(shí)現(xiàn)基于深度神經(jīng)網(wǎng)絡(luò)的文本分類(lèi)模型

BP神經(jīng)網(wǎng)絡(luò)樣本的獲取方法

BP神經(jīng)網(wǎng)絡(luò)在語(yǔ)言特征信號(hào)分類(lèi)中的應(yīng)用

卷積神經(jīng)網(wǎng)絡(luò)在文本分類(lèi)領(lǐng)域的應(yīng)用

交換機(jī)的基本分類(lèi)

基于神經(jīng)網(wǎng)絡(luò)的呼吸音分類(lèi)算法

了解如何使用PyTorch構(gòu)建圖神經(jīng)網(wǎng)絡(luò)

基于微流控技術(shù)的滅火微膠囊研究

新技術(shù)在生物樣本冷凍中的應(yīng)用案例分析

人工智能中文本分類(lèi)的基本原理和關(guān)鍵技術(shù)

異構(gòu)信號(hào)驅(qū)動(dòng)下小樣本跨域軸承故障診斷的GMAML算法

膠囊網(wǎng)絡(luò)在小樣本做文本分類(lèi)中的應(yīng)用(下)

膠囊網(wǎng)絡(luò)在小樣本做文本分類(lèi)中的應(yīng)用(下)

評(píng)論