隨著注意力機制在自然語言處理和計算機視覺等多個人工智能領域風靡,計算機視覺領域刷榜之爭可謂是進入白熱化階段。

近期大量工作刷新現有各項任務SOTA:前腳谷歌剛在圖像識別ImageNet上準確度超過90,緊接著微軟又在目標檢測COCO上AP超過60。

在一篇CVPR 2021 論文中,來自微軟的研究者提出多重注意力機制統一目標檢測頭方法Dynamic Head, 可插拔特性提高多種目標檢測框架的性能。

在Transformer骨干和額外數據加持下,COCO單模型測試取得新紀錄:60.6 AP。

方法概述

本文首先對現有目標檢測頭的改進工作進行了總結,發現近期方法主要通過三個不同的角度出發進行目標檢測性能的提升:

尺度感知:目標尺度的差異對應了不同尺度的特征,改進不同級的表達能力可以有效提升目標檢測器的尺度感知能力;

空間位置:不相似目標形狀的不同幾何變換對應了特征的不同空間位置,改進不同空間位置的表達能力可以有效提升目標檢測器的空間位置感知能力;

多任務:目標表達與任務的多樣性對應了不同通道特征,改進不同通道的表達能力可以有效提升目標檢測的任務感知能力。

本文提出一種新穎的動態頭框架,它采用多注意力機制將不同的目標檢測頭進行統一。

通過特征層次之間的注意力機制用于尺度感知,空間位置之間的注意力機制用于空間感知,輸出通道內的注意力機制用于任務感知,該方法可以在不增加計算量的情況顯著提升模型目標檢測頭的表達能力。

為了達成以上目的,本文對特征金字塔進行重構,將不同層級的特征統一到一個3D張量,并發現在不同維度引入注意力機制可以提高對尺度,空間位置和多任務的感知能力。

因此上述方向可以統一到一個高效注意力學習問題中。本文也是首個嘗試采用多注意力機制將三個維度組合構建統一頭并最大化其性能的工作。

作者將注意力函數轉換為三個序列子注意力函數來解決傳統注意力函數在高維度導致計算量激增的問題。

每個注意力函數僅聚焦一個維度:基于SE模塊的尺度自注意函數π_L, 基于可變形卷積的空間自注意函數π_S 和 基于動態ReLU激活函數的多任務的自注意函數π_C。

作者將三種自注意函數進行堆疊,形成一個可輕易插拔的模塊DyHead,并將其應用于多種目標檢測框架中。

實驗結果

作者首先分析了的計算效率。當采用6個模塊時,模型性能提升達到最大,而計算量提升相比骨干網絡可以忽略。

作者將DyHead集成到不同檢測器進行性能對比,發現所提DyHead可以一致性提升所有主流目標檢測器性能:1.2~3.2AP,展示了優異的可插拔擴展性能。

在與其他目標檢測方法的對比中,所提方案以較大的優勢超越了流行方案。相比僅采用多尺度尋覽的方法,所提方案僅需2x訓練即可取得新的SOTA指標52.3AP。相對于谷歌提出的EfficientDet與SpineNet,所提方法訓練時間更少(僅1/20);

當同時采用多尺度訓練與測試時,所提方法取得了新的SOTA指標54.0AP,以1.3AP指標優于此前最佳。

當引入更優異的Transformer骨干網絡、以及通過類似于谷歌自我學習方法生成的額外偽框的ImageNet數據后,所提方案取得了COCO新的記錄:60.6 AP,成為首個超過60的單模型方法。

責任編輯:lq6

-

計算機視覺

+關注

關注

8文章

1696瀏覽量

45928 -

自然語言處理

+關注

關注

1文章

614瀏覽量

13507

原文標題:刷新記錄! CVPR2021全新目標檢測機制達到SOTA!

文章出處:【微信號:vision263com,微信公眾號:新機器視覺】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

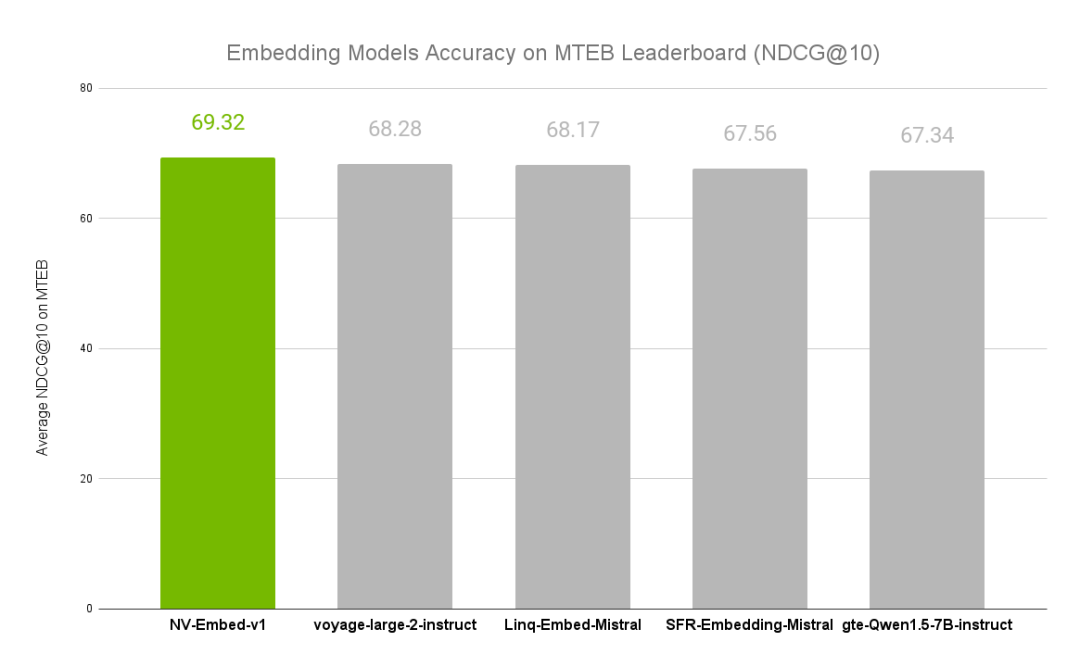

NVIDIA文本嵌入模型NV-Embed的精度基準

單模單纖與單模雙纖的哪個穩定?

單模單纖與單模雙纖的優缺點是什么

單模鎧裝光纜與室外單模光纜區別

如何不用wifi_station_scan() 取得當前已經連線AP的BSSID?

如何使用AP525測試泰凌硬件的音頻指標(二)— AP525測試平臺介紹

ESP8266 STA+AP模式下丟包如何解決?

多模光纖和單模光纖能混用嗎為什么

單模光纖和多模光纖有什么區別?單模、多模能混合使用嗎?

單模單纖和單模雙纖有什么區別

捷報頻傳!諾安智能以智能傳感器項目強勢入選“深圳企業創新紀錄”

COCO單模型測試取得新紀錄:60.6 AP

COCO單模型測試取得新紀錄:60.6 AP

評論