大數(shù)據(jù)建模、分析、挖掘技術(shù)應(yīng)用研修班的通知

隨著2015年9月國(guó)務(wù)院發(fā)布了《關(guān)于印發(fā)促進(jìn)大數(shù)據(jù)發(fā)展行動(dòng)綱要的通知》,各類型數(shù)據(jù)呈現(xiàn)出了指數(shù)級(jí)增長(zhǎng),數(shù)據(jù)成了每個(gè)組織的命脈。今天所產(chǎn)生的數(shù)據(jù)比過(guò)去幾年所產(chǎn)生的數(shù)據(jù)大好幾個(gè)數(shù)量級(jí),企業(yè)有了能夠輕松訪問(wèn)和分析數(shù)據(jù)以提高性能的新機(jī)會(huì),如何從數(shù)據(jù)中獲取價(jià)值顯得尤為重要,也是大數(shù)據(jù)相關(guān)技術(shù)急需要解決的問(wèn)題。大數(shù)據(jù)是需要新處理模式才能具有更強(qiáng)的決策力、洞察發(fā)現(xiàn)力和流程優(yōu)化能力來(lái)適應(yīng)海量、高增長(zhǎng)率和多樣化的信息資產(chǎn)。數(shù)據(jù)建模不僅僅是任意組織數(shù)據(jù)結(jié)構(gòu)和關(guān)系,還必須與最終用戶的需求和問(wèn)題聯(lián)系起來(lái),并提供指導(dǎo),幫助確保正確的數(shù)據(jù)正確使用正確的方法獲得正確的結(jié)果。

為響應(yīng)科研及工作人員需求,根據(jù)《國(guó)務(wù)院關(guān)于推行終身職業(yè)技能培訓(xùn)制度的意見(jiàn)》提出的“緊跟新技術(shù)、新職業(yè)發(fā)展變化,建立職業(yè)分類動(dòng)態(tài)調(diào)整機(jī)制,加快職業(yè)標(biāo)準(zhǔn)開(kāi)發(fā)工作”要求,特舉辦“大數(shù)據(jù)建模、分析、挖掘技術(shù)應(yīng)用研修班”。本次培訓(xùn)采用實(shí)戰(zhàn)培訓(xùn)模式。

2022年3月10日 — 2022年3月14日 北京(同時(shí)轉(zhuǎn)線上直播)

聯(lián)系人:任老師 13331040142

一、大數(shù)據(jù)概述

1.大數(shù)據(jù)及特點(diǎn)分析

2.大數(shù)據(jù)關(guān)健技術(shù)

3.大數(shù)據(jù)計(jì)算模式

4.大數(shù)據(jù)應(yīng)用實(shí)例

二、大數(shù)據(jù)處理架構(gòu)Hadoop

1.Hadoop項(xiàng)目結(jié)構(gòu)

2.Hadoop安裝與使用

3.Hadoop集群的部署與使用

4.Hadoop 代表性組件

三、分布式文件系統(tǒng)HDFS

1.HDFS體系結(jié)構(gòu)

2.HDFS存儲(chǔ)

3.HDFS數(shù)據(jù)讀寫(xiě)過(guò)程

四、分布式數(shù)據(jù)庫(kù)HBase

1.HBase訪問(wèn)接口

2.HBase數(shù)據(jù)類型

3.HBase實(shí)現(xiàn)原理

4.HBase運(yùn)行機(jī)制

5.HBase應(yīng)用

五、MapReduce

1.MapReduce體系結(jié)構(gòu)

2.MapReduce工作流程

3.資源管理調(diào)度框架YARN

4.MapReduce應(yīng)用

六、Spark

1.Spark生態(tài)與運(yùn)行架構(gòu)

2.Spark SQL

3.Spark部署與應(yīng)用方式

案例:

1.Python Spark 安裝

2.本地運(yùn)行pyspark程序

3.在Hadoop YARN 運(yùn)行pyspark

4.Spark Web UI

七、IPython Notebook運(yùn)行Python Spark程序

1.Anaconda

2.IPython Notebook使用Spark

3.使用IPython Notebook在Hadoop YARN模式運(yùn)行

案例:

1.在不同模式運(yùn)行IPython Notebook運(yùn)行Python Spark命令

2.Python 程序開(kāi)發(fā)

八、Python Spark集成開(kāi)發(fā)環(huán)境

1.Python Spark集成開(kāi)發(fā)環(huán)境部署配置

2.Spark數(shù)據(jù)分析庫(kù)MLlib的開(kāi)發(fā)部署

九、Python Spark決策樹(shù)二分類與多分類

1.決策樹(shù)原理

2.大數(shù)據(jù)問(wèn)題

3.決策樹(shù)二分類

4.決策樹(shù)多分類

案例:

1.搜集數(shù)據(jù)

2.數(shù)據(jù)準(zhǔn)備:導(dǎo)入并轉(zhuǎn)換數(shù)據(jù)、提取特征字段、提取標(biāo)簽

3. Python Spark建模,訓(xùn)練模型

4.預(yù)測(cè)數(shù)據(jù)

5.評(píng)估數(shù)據(jù),給出評(píng)價(jià)指標(biāo)并得到評(píng)估結(jié)果

十、Python Spark支持向量機(jī)

1.支持向量機(jī)SVM 原理與算法

2.Python Spark SVM程序設(shè)計(jì)

案例:

1.數(shù)據(jù)準(zhǔn)備

2.建立SVM模型,訓(xùn)練模型

3.評(píng)估參數(shù)并找出最優(yōu)參數(shù)

4.根據(jù)模型進(jìn)行預(yù)測(cè)

十一、Python Spark 貝葉斯模型

1.樸素貝葉斯模型原理

2.Python Spark貝葉斯模型程序設(shè)計(jì)

案例:

1.建模貝葉斯模型,并進(jìn)行對(duì)參數(shù)估計(jì)

2.訓(xùn)練模型,得到最優(yōu)參數(shù)

3.根據(jù)模型進(jìn)行預(yù)測(cè)

十二、Python Spark邏輯回歸

1.邏輯回歸原理

2.Python Spark邏輯回歸程序設(shè)計(jì)

案例:

1.Python Spark邏輯回歸建模

2.根據(jù)模型進(jìn)行分類

十三、Python Spark回歸分析

1.大數(shù)據(jù)分析

2.數(shù)據(jù)集介紹

3.Python Spark回歸程序設(shè)計(jì)

案例:

1.數(shù)據(jù)準(zhǔn)備

2.訓(xùn)練回歸模型

3.建立評(píng)估指標(biāo)

4.訓(xùn)練回歸模型,并找到最優(yōu)參數(shù)

5.根據(jù)模型進(jìn)行預(yù)測(cè)

十四、Spark ML Pipeline 機(jī)器學(xué)習(xí)流程分類

1.機(jī)器學(xué)習(xí)流程組件:StringIndexer、OneHotEncoder、VectorAssembler等

2.使用Spark ML Pipeline 機(jī)器學(xué)習(xí)流程分類程序設(shè)計(jì)

案例:

1.數(shù)據(jù)準(zhǔn)備

2.建立機(jī)器學(xué)習(xí)Pipeline流程

3.使用Pipeline流程訓(xùn)練

4.使用PipelineModel預(yù)測(cè)

5.評(píng)估模型準(zhǔn)備率

審核編輯:湯梓紅

-

建模

+關(guān)注

關(guān)注

1文章

300瀏覽量

60740 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8382瀏覽量

132444 -

大數(shù)據(jù)

+關(guān)注

關(guān)注

64文章

8864瀏覽量

137310

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

華為助力數(shù)字人社建設(shè)與數(shù)字人才培養(yǎng)

raid 在大數(shù)據(jù)分析中的應(yīng)用

emc技術(shù)在大數(shù)據(jù)分析中的角色

云計(jì)算在大數(shù)據(jù)分析中的應(yīng)用

IP 地址大數(shù)據(jù)分析如何進(jìn)行網(wǎng)絡(luò)優(yōu)化?

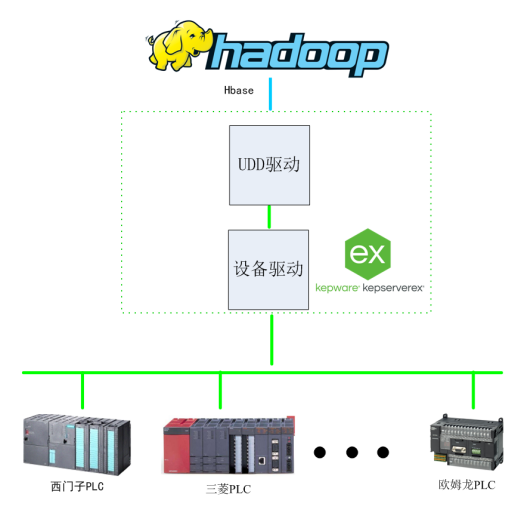

基于Kepware的Hadoop大數(shù)據(jù)應(yīng)用構(gòu)建-提升數(shù)據(jù)價(jià)值利用效能

龍芯中科成功舉辦全國(guó)高校教師教學(xué)能力培養(yǎng)高級(jí)研修班

2024年新能源車載磁性元件研修班成功開(kāi)班!

gis建模與空間分析的區(qū)別

【電磁兼容技術(shù)案例分享】某顯示屏因結(jié)構(gòu)縫隙泄漏導(dǎo)致輻射發(fā)射超標(biāo)案例

大數(shù)據(jù)建模、分析、挖掘技術(shù)應(yīng)用研修班的通知

大數(shù)據(jù)建模、分析、挖掘技術(shù)應(yīng)用研修班的通知

評(píng)論