越來越多的要求制造商在其生產(chǎn)過程中達(dá)到高質(zhì)量控制標(biāo)準(zhǔn)。傳統(tǒng)上,制造商依靠人工檢查來保證產(chǎn)品質(zhì)量。然而,手動檢查成本高昂,通常只覆蓋一小部分生產(chǎn)樣本,最終導(dǎo)致生產(chǎn)瓶頸、生產(chǎn)率降低和效率降低。

通過人工智能和計算機(jī)視覺實現(xiàn)缺陷檢測自動化,制造商可以徹底改變其質(zhì)量控制流程。然而,制造商和全自動化之間存在一個主要障礙。構(gòu)建一個 AI 系統(tǒng)和生產(chǎn)就緒的應(yīng)用程序是困難的,通常需要一個熟練的 AI 團(tuán)隊來訓(xùn)練和微調(diào)模型。一般制造商不采用這種專業(yè)技術(shù),而是采用手動檢查。

本項目的目標(biāo)是展示如何使用NVIDIA轉(zhuǎn)移學(xué)習(xí)工具包( TLT )和預(yù)訓(xùn)練模型快速建立制造過程中更精確的質(zhì)量控制。這個項目是在沒有人工智能專家或數(shù)據(jù)科學(xué)家的情況下完成的。為了了解 NVIDIA TLT 在為商業(yè)質(zhì)量控制目的培訓(xùn)人工智能系統(tǒng)方面的有效性,使用公開的 dataset 鋼焊接工藝,從 NGC 目錄(一個 GPU 優(yōu)化的人工智能和 HPC 軟件中心)重新培訓(xùn)預(yù)培訓(xùn)的 ResNet-18 模型,使用 TLT 。我們比較了人工智能研究團(tuán)隊先前發(fā)表的一項工作中,在數(shù)據(jù)集上從頭開始構(gòu)建的模型和由此產(chǎn)生的模型的準(zhǔn)確性。

NVIDIA TLT 操作簡便、速度快,不具備人工智能專業(yè)知識的工程師可以輕松使用。我們觀察到 NVIDIA TLT 的設(shè)置速度更快,結(jié)果更準(zhǔn)確,宏觀平均 F1 成績 為 97% ,而之前發(fā)布的數(shù)據(jù)集“從頭開始構(gòu)建”的結(jié)果為 78% 。

這篇文章探討了 NVIDIA TLT 如何快速準(zhǔn)確地訓(xùn)練 AI 模型,展示了 AI 和轉(zhuǎn)移學(xué)習(xí)如何改變圖像和視頻分析以及工業(yè)流程的部署方式。

具有 NVIDIA TLT 的工作流

NVIDIA TLT 是 NVIDIA 訓(xùn)練、調(diào)整和優(yōu)化( TAO )平臺 的核心組件,遵循零編碼范式快速跟蹤 AI 開發(fā)。 TLT 附帶了一套隨時可用的 Jupyter 筆記本、 Python 腳本和配置規(guī)范以及默認(rèn)參數(shù)值,使您能夠快速輕松地開始培訓(xùn)和微調(diào)數(shù)據(jù)集。

為了開始使用 NVIDIA TLT ,我們遵循了以下 快速入門指南說明 。

我們下載了 Docker 容器和 TLT Jupyter 筆記本。

我們將數(shù)據(jù)集映射到 Docker 容器上。

我們開始了第一次培訓(xùn),調(diào)整了默認(rèn)的培訓(xùn)參數(shù),如網(wǎng)絡(luò)結(jié)構(gòu)、網(wǎng)絡(luò)大小、優(yōu)化器等,直到我們對結(jié)果感到滿意。

數(shù)據(jù)集

這個項目中使用的數(shù)據(jù)集是由伯明翰大學(xué)的研究人員為他們的論文 基于可見 spectrum 攝像機(jī)和機(jī)器學(xué)習(xí)的 SS304 TIG 焊接過程缺陷自動分類 創(chuàng)建的。

該數(shù)據(jù)集由超過 45K 的灰度焊接圖像組成,可通過 Kaggle 獲得。數(shù)據(jù)集描述了一類正確執(zhí)行: good_weld 。鎢極惰性氣體( TIG )焊接過程中可能出現(xiàn)五類缺陷: 燒穿、污染、未熔合、未保護(hù)氣體、, 和 high_travel_speed 。

圖 1 來自培訓(xùn)數(shù)據(jù)集的焊接圖像示例

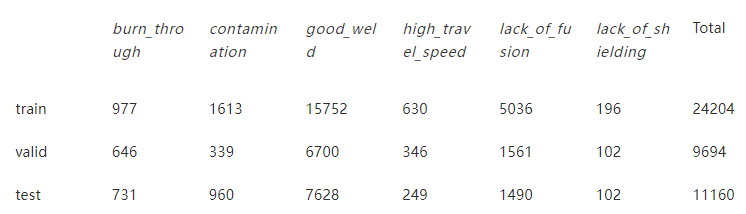

表 1 列車、驗證和測試數(shù)據(jù)集的圖像分布

與許多工業(yè)數(shù)據(jù)集一樣,該數(shù)據(jù)集是相當(dāng)不平衡的,因為很難收集低可能性出現(xiàn)的缺陷的數(shù)據(jù)。表 1 顯示了列車、驗證和測試數(shù)據(jù)集的類別分布。

圖 2 顯示了測試數(shù)據(jù)集中的不平衡。測試數(shù)據(jù)集包含的 good_weld 圖像比 lack_of_shielding 多 75 倍。

圖 2 TIG 鋼焊接試驗數(shù)據(jù)集的類別分布 。

使用 NVIDIA TLT

所采用的方法側(cè)重于最小化開發(fā)時間和調(diào)優(yōu)時間,同時確保精度適用于生產(chǎn)環(huán)境。 TLT 與示例筆記本附帶的標(biāo)準(zhǔn)配置文件結(jié)合使用。設(shè)置、培訓(xùn)和調(diào)整在 8 小時內(nèi)完成。

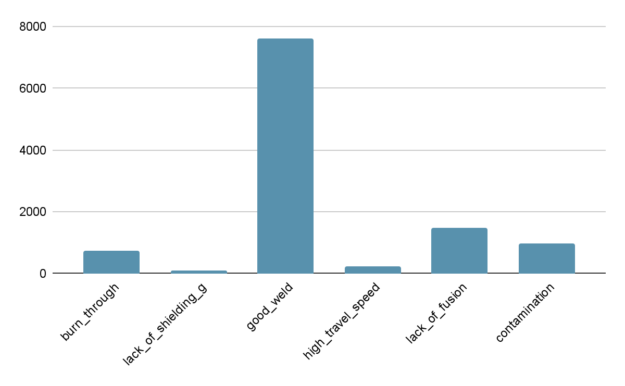

我們進(jìn)行了有關(guān)網(wǎng)絡(luò)深度和訓(xùn)練次數(shù)的參數(shù)掃描。我們觀察到,改變默認(rèn)的學(xué)習(xí)率并不能改善結(jié)果,因此我們沒有進(jìn)一步研究這一點,而是將其保留在默認(rèn)值。經(jīng)過 30 個階段的訓(xùn)練,學(xué)習(xí)率為 0 。 006 ,從 NGC 目錄中獲得的預(yù)訓(xùn)練 ResNet-18 模型獲得了最佳結(jié)果。

查看 krygol/304SteelWeldingClassification GitHub repo 中的逐步方法。

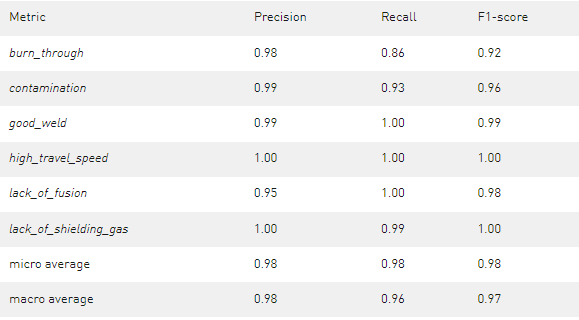

表 2 經(jīng)過 30 個時期的訓(xùn)練,學(xué)習(xí)率為 0 。 006 ,預(yù)訓(xùn)練的 ResNet-18 獲得的結(jié)果

獲得的結(jié)果在所有班級中都相當(dāng)好。一些 lack_of_fusion 氣體圖像被錯誤分類為 burn_through 和 污染 圖像。在訓(xùn)練更深層次的 ResNet50 時也觀察到了這種效果,這更容易將 lack_of_fusion 誤分類為另一個缺陷類。

與原始方法的比較

伯明翰大學(xué)的研究人員選擇了不同的人工智能工作流。他們手動準(zhǔn)備數(shù)據(jù)集,通過欠采樣來減少不平衡。他們還將圖像重新縮放到不同的大小,并選擇自定義網(wǎng)絡(luò)結(jié)構(gòu)。

他們使用了一個完全連接的神經(jīng)網(wǎng)絡(luò)( Full-con6 ),即具有兩個隱藏層的神經(jīng)網(wǎng)絡(luò)。他們還實現(xiàn)了一個卷積神經(jīng)網(wǎng)絡(luò)( Conv6 ),其中有三個卷積層,每個卷積層后跟一個最大池層和一個完全連接層作為最終隱藏層。他們沒有像 ResNet 那樣使用跳過連接。

TLT 獲得的結(jié)果與伯明翰大學(xué)研究人員定制實施的結(jié)果相比更令人印象深刻。

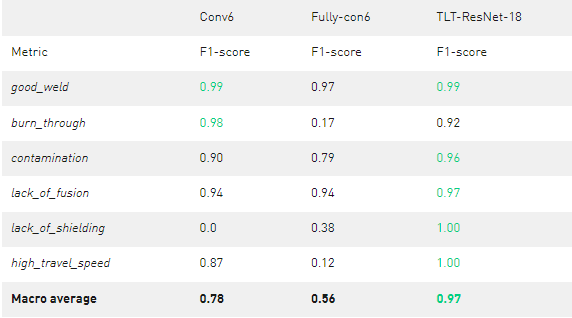

表 3 定制網(wǎng)絡(luò)與 TLT ResNet-18 的比較

Conv6 的平均表現(xiàn)較好,宏觀平均 F1 為 0 。 78 ,但在識別 lack_of_shielding 氣體缺陷方面完全失敗 。 con6 的平均表現(xiàn)較差,宏觀平均 F1 為 0 。 56 。 FULL-con6 可以對一些 lack_of_shielding 氣體圖像進(jìn)行分類,但是 burn_through 和 高速行駛 圖像存在問題。 FULL-con6 和 Conv6 都有明顯的弱點,這將使它們無法獲得生產(chǎn)準(zhǔn)備就緒的資格。

每個班級的最佳 F1 成績在表中以綠色標(biāo)出。如您所見, TLT 訓(xùn)練的 ResNet-18 模型提供了更好的結(jié)果,宏觀平均值為 0 。 97 。

結(jié)論

我們在 TLT 方面有著豐富的經(jīng)驗,總體而言, TLT 是用戶友好且有效的。它設(shè)置速度快,易于使用,并且在較短的計算時間內(nèi)產(chǎn)生可接受的結(jié)果。根據(jù)我們的經(jīng)驗,我們相信 TLT 為不是 AI 專家但希望在生產(chǎn)環(huán)境中使用 AI 的工程師提供了巨大的優(yōu)勢。在制造環(huán)境中使用 TLT 自動化質(zhì)量控制不會帶來性能成本,應(yīng)用程序通常可以與默認(rèn)設(shè)置一起使用,并進(jìn)行一些小的調(diào)整,以超越自定義體系結(jié)構(gòu)。

利用 NVIDIA TLT 快速準(zhǔn)確地訓(xùn)練人工智能模型的探索表明,人工智能在工業(yè)過程中具有巨大的潛力。

關(guān)于作者

Konstantin Rygol 是 AI 和 HPC 在波士頓存儲和服務(wù)器解決方案有限公司的首席工程師。他擁有挪威卑爾根大學(xué)的物理碩士學(xué)位。在研究原子物理學(xué)期間,他對 HPC 和 AI 產(chǎn)生了濃厚的熱情。他現(xiàn)在是 NVIDIA 深度學(xué)習(xí)培訓(xùn)中心的講師,致力于將人工智能引入德國市場。

審核編輯:郭婷

-

NVIDIA

+關(guān)注

關(guān)注

14文章

4793瀏覽量

102421 -

服務(wù)器

+關(guān)注

關(guān)注

12文章

8700瀏覽量

84528 -

AI

+關(guān)注

關(guān)注

87文章

28866瀏覽量

266188

發(fā)布評論請先 登錄

相關(guān)推薦

NVIDIA Nemotron-4 340B模型幫助開發(fā)者生成合成訓(xùn)練數(shù)據(jù)

NVIDIA AI Foundry 為全球企業(yè)打造自定義 Llama 3.1 生成式 AI 模型

ai大模型訓(xùn)練方法有哪些?

ai大模型和ai框架的關(guān)系是什么

深度學(xué)習(xí)模型訓(xùn)練過程詳解

MediaTek與NVIDIA TAO加速物聯(lián)網(wǎng)邊緣AI應(yīng)用發(fā)展

【大語言模型:原理與工程實踐】大語言模型的預(yù)訓(xùn)練

NVIDIA在加速識因智能AI大模型落地應(yīng)用方面的重要作用介紹

Edge Impulse發(fā)布新工具,助 NVIDIA 模型大規(guī)模部署

NVIDIA TAO工具套件功能與恩智浦eIQ機(jī)器學(xué)習(xí)開發(fā)環(huán)境的集成

NVIDIA TAO 5.2版本發(fā)布

在線研討會 | 大模型時代語音 AI 模型的訓(xùn)練、優(yōu)化與應(yīng)用

怎樣使用NVIDIA TAO為數(shù)萬億臺設(shè)備開發(fā)和優(yōu)化視覺AI模型呢?

NVIDIA 為部分大型亞馬遜 Titan 基礎(chǔ)模型提供訓(xùn)練支持

NVIDIA 加快企業(yè)自定義生成式 AI 模型開發(fā)

如何使用NVIDIA TAO快速準(zhǔn)確地訓(xùn)練AI模型

如何使用NVIDIA TAO快速準(zhǔn)確地訓(xùn)練AI模型

評論