電子發(fā)燒友網(wǎng)報道(文/周凱揚)多芯片模塊(MCM)技術(shù)的應用在半導體業(yè)界已經(jīng)不是什么新鮮事了,但隨著Chiplet、2.5D/3D封裝技術(shù)日趨火熱,MCM正在滲透進更多的芯片設計中,無論是GPU、光模塊還是AI芯片,都在慢慢引入這類封裝技術(shù)。

MCM GPU成為趨勢

以去年AMD發(fā)布的首個MCM GPU Instinct MI250X為例,這款GPU集成了兩個GPU Chiplet和128GB的超大HBM2e內(nèi)存,在算力和帶寬上都做到了極致,實現(xiàn)了383TFLOPS(FP16)和3.2TB/s的可怕成績,無疑是專注AI的各大超算中心夢寐以求的加速器了。同樣,英特爾也在其Ponte Vecchio GPU上采用了MCM。

雖然MCM已經(jīng)由AMD和英特爾兩家GPU廠商開始推進了,但目前來看英偉達的動作比較小,雖然有相關(guān)的研究,但還未拿出商用的MCM產(chǎn)品。不過以上都是面向HPC/AI市場的GPU,消費級的GPU是否也會迎來MCM的GPU呢?據(jù)現(xiàn)在的傳聞,AMD極有可能在下一代RDNA3架構(gòu)的高端GPU中用上MCM。

但消費級應用與HPC/AI應用又屬于截然不同的場景,后者使用多個GPU跑負載是很常見的情況。但消費場景中多GPU已經(jīng)相當少見了,在兼容性上肯定會大打折扣,所以邁出這一步很可能會帶來一定的風險。

IP公司眼中的MCM

MCM不僅為GPU公司帶來了更多設計靈活性,也讓一眾IP公司找到了新的商業(yè)模式。比如IP公司Credo就提供混合信號DSP IP,用于客戶的ASIC設計,以Chiplet的形式集成到SoC上,打造更低功耗更高性能的MCM。隨著數(shù)據(jù)中心的網(wǎng)絡架構(gòu)慢慢趨向于400G以上,芯片連接性的要求也在逐步升高。為此,Credo在去年底推出了全新的3.2Tbps BlueJay重定時器chiplet,通過64通道56Gbps PAM4 LR的DSP,提供了強大的系統(tǒng)級連接性。

BlueJay雖然只是以臺積電28nm工藝打造,但保證了性能和功耗的要求,與其先進工藝方案Nutcracker相比也降低了成本。此外,由于BlueJay與主機端MCM中SoC核心的通信是通過超低功耗的BoW D2D接口實現(xiàn)的,其接口已經(jīng)針對臺積電的CoWoS封裝技術(shù)做了優(yōu)化。這種將SerDes功能從片上(on-die)轉(zhuǎn)向片外(off-chip)的做法,顯著增加了ASIC的可使用面積,設計者可以將這一部分多出來的面積用于實現(xiàn)更高的計算性能。

AI在MCM上的創(chuàng)新

同樣,AI也在MCM上找到了新的解決方案。我們已經(jīng)看到了大的機器學習模型通過訓練大數(shù)據(jù)在多個領(lǐng)域展示了驚人的成果,比如計算機視覺、語音識別和自然語言處理等。為了減少機器學習加速器的成本,業(yè)界引入了不少設計創(chuàng)新,其中之一就是MCM。

英偉達的Simba,谷歌的TPU,都用到了MCM的設計。谷歌的Coral TPU是一個用于邊緣端的機器學習推理加速器,在極小的占用面積下可以實現(xiàn)4 TOPS(INT8)的峰值性能,能效比可達2 TOPS/W。英偉達的Simba同樣是一個用于推理的芯片,但規(guī)模比谷歌的Coral更大,整個MCM由36個Chiplet組成,每個都能實現(xiàn)4 TOPS的峰值性能,將整個芯片算力提升至最高128 TOPS,能效比更是高達6.1 TOPS/W。

一來在設計上,設計小芯片的難度比一整塊芯片要低,二來小芯片由于面積較小,生產(chǎn)良率也更高。這都證明了這種方案既可以減少設計和生產(chǎn)成本,也能達到與單個大芯片近似的性能與能效。

但正如我們上文提到的MCM GPU兼容問題一樣,機器學習中MCM也并非毫無痛點。由于MCM中單個Chiplet的內(nèi)存遠比單個大芯片要小,所以大型機器學習模型的訓練與推理都需要將矢量計算的數(shù)據(jù)流圖在Chiplet上進行劃分。多芯片進行劃分就是為了將運算分配給Chiplet,從而將某個性能指標最大化,比如說吞吐量。但與單芯片不一樣,MCM中小芯片的數(shù)量以及神經(jīng)網(wǎng)絡的節(jié)點數(shù)量增加,都會讓搜索空間成指數(shù)級增長,從而降低效率,更不用說因為MCM的硬件特性,可用的劃分方案并不多。所以這種劃分的質(zhì)量,直接影響到了MCM芯片設計的優(yōu)化。

為了解決這個問題,谷歌的研究員們開發(fā)了一種深度強化學習的劃分方案,同時利用一個約束求解器來專門解決MCM封裝的機器學習模型劃分問題。他們的方案可以通過預訓練來普及到未知的輸入圖,通過對生產(chǎn)級BERT模型的硬件評估,他們得到了超過隨機搜索和模擬退火等現(xiàn)有方案5%以上的吞吐量。更重要的是,這種方案具備極佳的遷移學習性能,使用預訓練的模型可以有效提升樣本效率,將搜索時間從3個小時減少到了9分鐘。

原文標題:MCM正在潛移默化地改變芯片設計

文章出處:【微信公眾號:電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

審核編輯:湯梓紅

-

gpu

+關(guān)注

關(guān)注

28文章

4701瀏覽量

128705 -

芯片設計

+關(guān)注

關(guān)注

15文章

1001瀏覽量

54812 -

MCM

+關(guān)注

關(guān)注

1文章

67瀏覽量

22323

原文標題:MCM正在潛移默化地改變芯片設計

文章出處:【微信號:elecfans,微信公眾號:電子發(fā)燒友網(wǎng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

什么是滲透作用_金屬封裝又是如何發(fā)生滲透

SOC芯片在汽車電子中的應用

電動重卡加速滲透,鋰電行業(yè)迎來新機遇

維信諾推動AMOLED加快向中尺寸應用滲透

聯(lián)發(fā)科正在開發(fā)Arm架構(gòu)Windows PC芯片

蘋果正在研發(fā)全新數(shù)據(jù)中心AI芯片

BLDC加速滲透,國產(chǎn)主控如何優(yōu)化芯片性能?

汽車價格戰(zhàn)對芯片供應鏈的影響

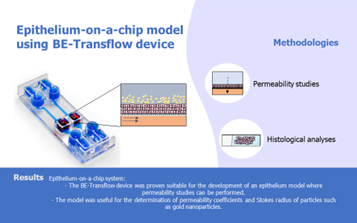

點成案例|BE-Transflow芯片構(gòu)建上皮模型用于滲透性研究

電子膠行業(yè)中的芯片膠用在什么領(lǐng)域?

MCM正在滲透進更多的芯片設計中

MCM正在滲透進更多的芯片設計中

評論