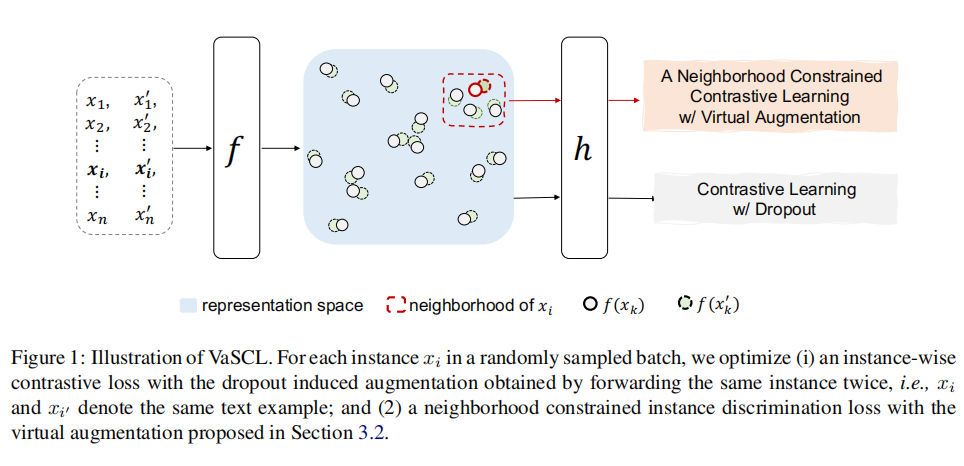

在本文中,我們將介紹亞馬遜團隊在ACL2022中的一篇論文VaSCL,該論文在SimCSE的基礎上,提出了一種基于k近鄰與高斯噪聲的虛擬困難樣本增強方法。作者在無監督訓練中,進行困難樣本增強,從而提高了模型的性能,并且超過了SimCSE。

論文標題:

Virtual Augmentation Supported Contrastive Learning of Sentence Representations

論文鏈接:

https://arxiv.org/abs/2110.08552

01

引言

在ACL2021中,陳丹琦團隊提出了使用Dropout進行正樣本增強的對比學習方法SimCSE,該方法操作簡單卻十分有效,在無監督對比學習中取得了非常好的效果。在有監督SimCSE中,作者對困難負樣本的作用進行了探究實驗,實驗結果證明,引入困難負樣本后,有監督SimCSE的指標從84.9提升至86.2。這說明,在對比學習中,引入困難樣本是能夠提升模型效果的。

然而在無監督SimCSE中,作者僅使用dropout的方式進行了正樣本增強,沒有額外引入困難樣本,這在一定程度上限制了模型的能力。基于這個動機,亞馬遜提出了一種基于k近鄰與高斯噪聲的虛擬困難樣本增強的無監督對比學習方法VaSCL。

02

論文解讀

基于Dropout的對比損失

在介紹VaSCL模型之前,我們先簡單回顧一下無監督SimCSE。假設訓練時的batch size為N,將一個batch的數據記作,將同一個樣本分別輸入模型中兩次,使用不同的dropout mask編碼得到兩個向量和。則在規模為N的batch中,與的InfoNCE損失為:

基于k近鄰的虛擬增強對比損失

在無監督SimCSE的損失函數的基礎上,作者還設計了一種基于k近鄰的虛擬困難樣本增強的損失函數。

將通過模型編碼之后得到向量序列。

作者通過以下方式獲得第i個句向量的虛擬困難樣本:

正樣本增強:對添加高斯噪聲,得到,其中就是經過高斯增強后的正樣本。

獲得k近鄰:獲得在中距離最近的k個負樣本,在本文中我們稱之為k近鄰,記作。

對于來說,是正樣本,是負樣本集合。則對于,k近鄰虛擬增強的對比損失如下。分子表示拉近與的距離,分母表示拉遠與負樣本之間的距離。

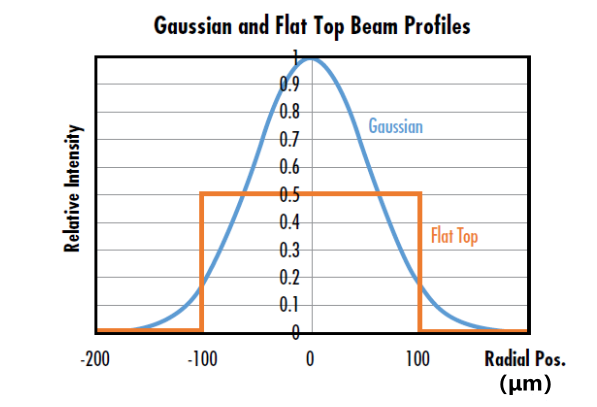

在CV中,我們會為輸入的圖片添加高斯噪聲以增加模型的泛化性。添加了高斯噪聲的圖片,肉眼能看出微小的區別,但不會影響整張圖片的語義信息。所以為句向量添加合適的高斯噪聲,理論上也不會對句向量的語義信息產生很大的改變。

在的k近鄰中,存放的是距離最近的k個負樣本,也就是與最相似的k個負樣本。只要batch size足夠大,我們可以近似認為,就是的困難負樣本集合,同樣也是的困難負樣本集合。

如何獲得上述的高斯噪聲呢?最容易想到的做法便是隨機生成一個高斯噪聲,直接添加到句向量中。但是為了提高模型的訓練難度,生成更高質量的高斯噪聲,作者生成若干個候選高斯噪聲,然后選出一個使得最大化的高斯噪聲。

從上述操作可以看出,對于最優的高斯噪聲,作者希望它增強后的正樣本與的距離盡可能遠,與負樣本的距離盡可能近,作者希望這個高斯噪聲能夠對模型產生盡可能大的迷惑性。通過這個高斯噪聲,我們就可以得到困難正樣本,并且從某種意義來說,也使得與的距離盡可能拉近,達到了增強負樣本難度的目的,做法確實挺巧妙。

VaSCL對比損失

將上述兩種對比損失進行組合,得到最終的VaSCL損失函數:

這個損失函數的含義如下:

對于每個句子,拉近同一個句子經過dropout之后的兩個句向量之間的距離,拉遠它們與其他句子的距離。

對于每個句子,拉近原句向量與高斯噪聲增強之后的句向量的距離,拉遠它們與k近鄰負樣本之間的距離。

03

實驗結果

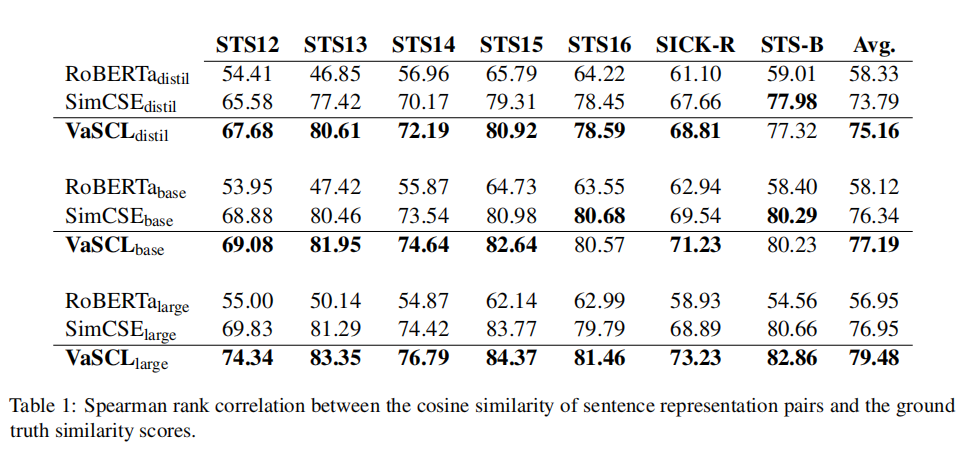

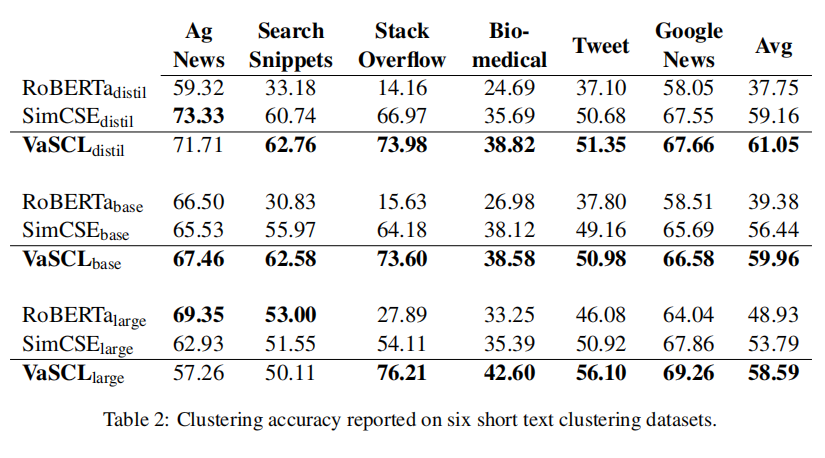

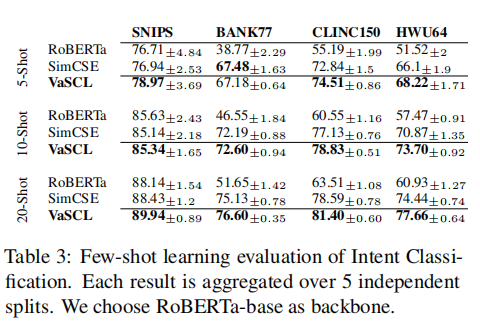

作者分別在STS任務、短文本聚類、意圖識別等任務中進行了實驗,實驗結果如下表所示。可以看到,在三種任務中,絕大部分數據集上,VaSCL的表現都要優于SimCSE,這表明了基于k近鄰與高斯噪聲的困難樣本增強的有效性。

04

總結

SimCSE通過dropout mask這種簡單的方法,避免了人工進行正樣本增強所帶來的語義改變的問題,并且在無監督訓練中取得了不錯的效果。而VaSCL論文延續了SimCSE這種思想,引入了高斯噪聲進行正樣本增強,有著異曲同工之妙。

VaSCL在SimCSE的基礎上,也進行了困難樣本的增強。在進行高斯噪聲增強時,使得增強的樣本與原始樣本盡可能不相似,與負樣本盡可能相似,已達到【混淆視聽】的效果。通過這種方式,VaSCL在絕大多數據集上的表現,也超過了SimCSE。

審核編輯 :李倩

-

噪聲

+關注

關注

13文章

1118瀏覽量

47369 -

函數

+關注

關注

3文章

4306瀏覽量

62431 -

模型

+關注

關注

1文章

3172瀏覽量

48714

原文標題:ACL'22 | VaSCL:基于k近鄰與高斯噪聲的困難樣本增強的對比學習方法,超越SimCSE

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

高斯濾波和均值濾波的區別

高斯濾波和雙邊濾波的區別

高斯濾波的特點有哪些

高斯卷積核函數在圖像采樣中的意義

高斯濾波的基本原理有哪些

增強現實和虛擬現實的聯系和區別

增強現實技術(AR)和虛擬現實技術(VR)的區別?

什么是高斯光束

基于k近鄰與高斯噪聲的虛擬困難樣本增強方法

基于k近鄰與高斯噪聲的虛擬困難樣本增強方法

評論