在今年最重要的圖形學大會(SIGGRAPH 2022)上, NVIDIA 的論文合著者將發表創紀錄的 16 篇研究論文,推動神經渲染、3D 模擬、全息技術等領域的發展。

NVIDIA 在圖形學研究領域的最新學術合作取得了豐碩的成果,包括能夠順利模擬運動動作的強化學習模型、用于虛擬現實的超薄全息眼鏡以及隱藏式光源照明條件下的物體實時渲染技術。

上述學術成果及其他項目將在 8 月 8 日 至 11 日于溫哥華舉行的 SIGGRAPH 2022 上發表。本次大會以線上線下結合的方式舉辦, NVIDIA 研究人員將在此次大會上發表 16 篇技術論文,包含了與達特茅斯學院、斯坦福大學、瑞士洛桑聯邦理工學院和特拉維夫大學等 14 所大學合作完成的研究。

這些論文覆蓋整個圖形學研究領域,將帶來神經內容創建工具、顯示和人類感知、計算機圖形學數學基礎以及神經渲染方面的進展。

可模擬多技能角色的神經工具

當使用強化學習模型開發基于物理的動畫角色時, AI 通常一次只能學習一種技能,比如走路、跑步或翻跟頭。但來自加州大學伯克利分校、多倫多大學和 NVIDIA 的研究人員創建了一個使 AI 能夠學習一整套技能的框架。上圖中便展示了一個能夠揮劍、使用盾牌并在摔倒后爬起來的戰士角色。

為動畫角色實現這些流暢、栩栩如生的動作通常是一項乏味又費力的工作,因為開發者需要為每項新任務重新訓練 AI。正如這篇論文所述,研究團隊使強化學習 AI 能夠重復利用已有技能來應對新場景,從而提高效率并減少額外需要的運動數據。

動畫、機器人、游戲和治療學領域的創作者都可以使用這樣的工具。NVIDIA 研究人員還將在 SIGGRAPH 大會上發表多篇其他論文,介紹用于點云表面重建和交互式形狀編輯的 3D 神經工具以及讓 AI 能夠更好理解矢量草圖誤差并提高延時視頻視覺質量的 2D 工具。

將虛擬現實技術集成到輕型眼鏡中

大多數虛擬現實用戶需要佩戴笨重的頭戴式顯示器才能進入 3D 數字世界,但研究人員正在研究重量更輕、類似于普通眼鏡的替代品。

NVIDIA 與斯坦福大學的研究人員合作,將 3D 全息圖像所需的技術集成到一個只有幾毫米厚的穿戴式顯示器中。這種顯示器的厚度僅 2.5 毫米,還不到其他被稱為“餅干鏡”的薄型 VR 顯示器的一半,而且后者使用的是只支持 2D 圖像的折疊光學技術。

研究人員將顯示器的質量和尺寸作為一種計算問題,并使用 AI 算法,共同對光學器件進行設計,完成了這項難度極大的工作。

之前, VR 顯示器的放大鏡和顯示面板之間需要隔開一段距離以創建全息影像,而新型顯示器采用空間光調制器,使得不需要隔開距離就可以在用戶眼前創建全息影像。瞳孔復制波導和幾何相位透鏡等其他部件進一步縮小了設備的體積。

除了這篇論文之外,斯坦福大學和 NVIDIA 在大會上還發表了另一篇 VR 領域的合著論文,提出了一種新的計算機生成全息技術框架,該框架能夠優化帶寬的使用,并提高圖像的質量。此外, NVIDIA 與紐約大學和普林斯頓大學的科學家還將發表一篇顯示和感知研究領域的合著論文,該論文測量了渲染質量如何影響用戶對屏幕信息的反應速度。

“高光”一刻:樹立復雜實時照明的新標桿

準確地實時模擬場景中的光線路徑一直是圖形學領域的重中之重。猶他大學計算機學院和 NVIDIA 在一篇論文中詳細介紹了一種路徑重采樣算法,能夠對包括隱藏光源在內的復雜照明場景進行實時渲染,為該領域樹立了新標桿。

想象一下,一個昏暗房間中的桌子上有一個玻璃花瓶,屋外路燈的燈光照射在上面。光滑的表面形成了一條長長的光路,光線在光源和觀眾的眼睛之間多次反射。一般情況下,計算此類光線路徑對于像游戲這樣的實時應用來說過于復雜,所以大多用于電影或其他離線渲染應用。

這篇論文著重介紹了在渲染過程中使用統計重采樣技術(算法在追蹤這些復雜的光路時重復進行數千次計算)實時、高效地模擬這些光路。研究人員將該算法應用于計算機圖形學領域具有挑戰性的一個典型場景:間接照明條件下的一套金屬、陶瓷和玻璃茶壺。

NVIDIA 在 SIGGRAPH 上發布的相關論文還包括:用于逆向體積渲染的新采樣策略、用于 2D 形狀操控的新數學表示法、為渲染和其他應用創建具有更高均勻性的采樣器的軟件以及將有偏渲染算法轉化為更高效的無偏算法的方法。

神經渲染:NeRF 和 GAN 推動合成場景的發展

神經渲染算法可以從真實世界的數據中學習,然后創建合成圖像。為了在 2D 和 3D 領域做到這一點, NVIDIA 的多個研究項目正致力于開發最先進的工具。

在 2D 領域,與特拉維夫大學合作開發的 StyleGAN-NADA 模型可以根據用戶的文字提示來生成具有特定風格的圖像,而且無需參考示例。例如用戶可以直接生成復古的汽車圖像,生成愛犬的畫像,或者把大房子變成小屋。

在 3D 領域,NVIDIA 和多倫多大學的研究人員正在開發能夠支持創建大型虛擬世界的工具。在 SIGGRAPH 大會上,他們將發表一篇名為《基于多分辨率哈希編碼的即時神經圖形基元》的論文,介紹 NVIDIA 在使用 Instant NeRF 訓練模型方面實現的重大技術突破。

NeRF,即基于 2D 圖像集合的 3D 場景,僅僅是神經圖形基元技術的功能之一。它可以用來展示任何復雜的空間信息,目前已被應用于圖像壓縮、三維形狀高精度展示和超高分辨率圖像等領域。

這項工作與多倫多大學的一個合作項目不謀而合。就像是將 JPEG 用于壓縮 2D 圖像一樣,該合作項目壓縮 3D 神經圖形基元,幫助用戶在手機和機器人等小型設備之間存儲和分享 3D 地圖與娛樂體驗。

NVIDIA 在全球有 300 多名研究人員,這些團隊專注于 AI、計算機圖形學、計算機視覺、自動駕駛汽車和機器人技術等領域。點擊“閱讀原文”,進一步了解 NVIDIA Research。

原文標題:AI 在 SIGGRAPH 上大放異彩:頂尖學術研究者與 NVIDIA 合作,共同解決圖形學領域的最大挑戰

文章出處:【微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

審核編輯:湯梓紅

-

NVIDIA

+關注

關注

14文章

4946瀏覽量

102823 -

虛擬現實

+關注

關注

15文章

2285瀏覽量

94846 -

AI

+關注

關注

87文章

30212瀏覽量

268463

原文標題:AI 在 SIGGRAPH 上大放異彩:頂尖學術研究者與 NVIDIA 合作,共同解決圖形學領域的最大挑戰

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

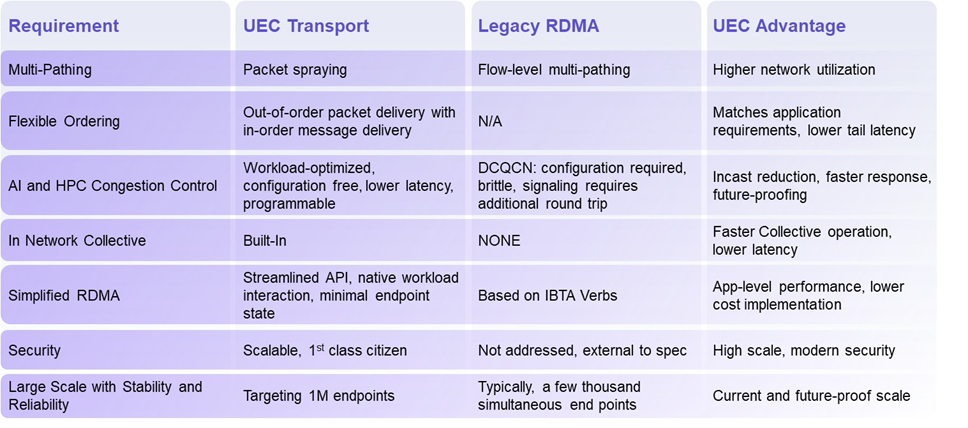

揭秘超以太網聯盟(UEC)1.0 規范最新進展(2024Q4)

Qorvo在射頻和電源管理領域的最新進展

芯片和封裝級互連技術的最新進展

AI大模型的最新研究進展

5G新通話技術取得新進展

NVIDIA視覺生成式AI的最新進展

NVIDIA NIM:打造AI領域的AI-in-a-Box,提高AI開發與部署的高效性

百度首席技術官王海峰解讀文心大模型的關鍵技術和最新進展

從原子到超級計算機:NVIDIA與合作伙伴擴展量子計算應用

NVIDIA發布生成式AI微服務,推動藥物研發、醫療科技和數字醫療發展

四個50億+,多個半導體項目最新進展!

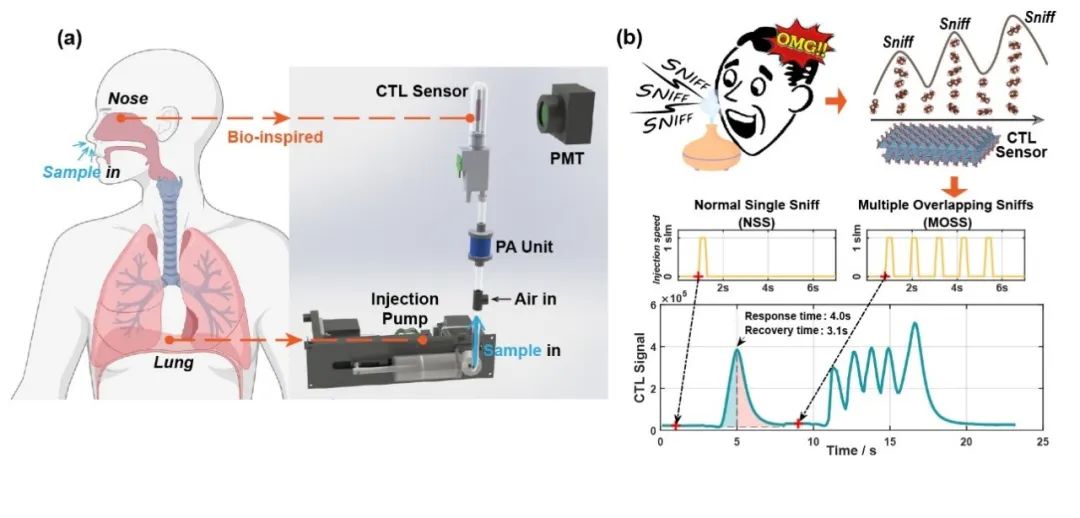

清華大學在電子鼻傳感器仿生嗅聞方向取得新進展

NVIDIA在圖形學研究領域的最新進展

NVIDIA在圖形學研究領域的最新進展

評論