案例簡介

本案例中通過NVIDIA T4 GPU,通過Ronda平臺調用Triton以及TensorRT, 整體提升開發和推理效能, 幫助騰訊PCG的多個服務整體效能提升2倍,吞吐量最大提升6倍,同時降低了40%的延時。本案例主要應用到 NVIDIA T4 GPU、TensorRT和Triton。

本案例主要應用到 NVIDIA T4 GPU、TensorRT和Triton。

客戶簡介及應用背景

騰訊平臺與內容事業群(簡稱 騰訊PCG)負責公司互聯網平臺和內容文化生態融合發展,整合QQ、QQ空間等社交平臺,和應用寶、瀏覽器等流量平臺,以及新聞資訊、視頻、體育、直播、動漫、影業等內容業務,推動IP跨平臺、多形態發展,為更多用戶創造海量的優質數字內容體驗。

騰訊PCG機器學習平臺部旨在構建和持續優化符合PCG技術中臺戰略的機器學習平臺和系統,提升PCG機器學習技術應用效率和價值。建設業務領先的模型訓練系統和算法框架;提供涵蓋數據標注、模型訓練、評測、上線的全流程平臺服務,實現高效率迭代;在內容理解和處理領域,輸出業界領先的元能力和智能策略庫。機器學習平臺部正服務于PCG所有業務產品。

客戶挑戰

業務繁多,場景復雜

模型格式繁多,包括ONNX、Pytorch、TensorFlow、TensorRT等

多模型融合流程比教復雜,涉及循環調用

支持異構推理

模型推理結果異常時,難以方便地調試定位問題

需要與公司內現有協議/框架/平臺進行融合

應用方案

基于以上挑戰,騰訊PCG選擇了采用NVIDIA 的Triton推理服務器,以解決新場景下模型推理引擎面臨的挑戰,在提升用戶研效的同時,大幅降低了服務成本。

NVIDIA Triton 是一款開源軟件,對于所有推理模式都可以簡化模型在任一框架中以及任何 GPU 或 CPU 上的運行方式,從而在生產環境中使用 AI。Triton 支持多模型ensemble,以及 TensorFlow、PyTorch、ONNX 等多種深度學習模型框架,可以很好的支持多模型聯合推理的場景,構建起視頻、圖片、語音、文本整個推理服務過程,大大降低多個模型服務的開發和維護成本。

基于C++ 的基礎架構、Dynamic-batch、以及對 TensorRT 的支持,同時配合 T4 的 GPU,將整體推理服務的吞吐能力最大提升 6 倍,延遲最大降低 40%,既滿足了業務的低延時需求,成本也降低了20%-66%。

通過將Triton編譯為動態鏈接庫,可以方便地鏈入公司內部框架,對接公司的平臺治理體系。符合C語言規范的API也極大降低了用戶的接入成本。

借助Python Backend和Custom Backend,用戶可以自由選擇使用C++/Python語言進行二次開發。

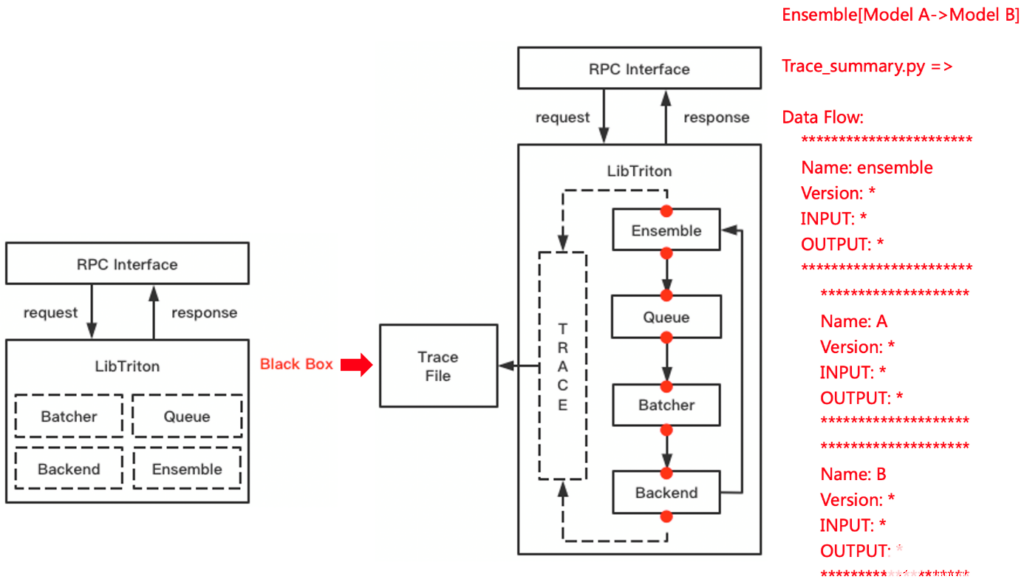

Triton的Tracing能力可以方便地捕捉執行過程中的數據流狀態。結合Metrics 和 Perf Analysis等組件,可以快速定位開發調試,甚至是線上問題,對于開發和定位問題的效率有很大提升。

NVIDIA DALI 是 GPU 加速的數據增強和圖像加載庫。DALI Backend可以用于替換掉原來的圖片解碼、resize等操作。FIL Backend也可以替代Python XGBoost模型推理,進一步提升服務端推理性能。

方案效果及影響

借助NVIDIA Triton 推理框架,配合 DALI/FIL/Python 等Backend,以及 TensorRT,整體推理服務的吞吐能力最大提升 6 倍,延遲最大降低 40%。幫助騰訊PCG各業務場景中,以更低的成本構建了高性能的推理服務,同時更低的延遲降低了整條系統鏈路的響應時間,優化了用戶體驗。

審核編輯:郭婷

-

NVIDIA

+關注

關注

14文章

4949瀏覽量

102826 -

C++

+關注

關注

22文章

2104瀏覽量

73503 -

python

+關注

關注

56文章

4783瀏覽量

84473

發布評論請先 登錄

相關推薦

NVIDIA助力Figure發布新一代對話式人形機器人

FPGA和ASIC在大模型推理加速中的應用

NVIDIA助力麗蟾科技打造AI訓練與推理加速解決方案

NVIDIA與思科合作打造企業級生成式AI基礎設施

NVIDIA助力提供多樣、靈活的模型選擇

英偉達推出全新NVIDIA AI Foundry服務和NVIDIA NIM推理微服務

LLM大模型推理加速的關鍵技術

NVIDIA加速計算和 AI助力數字銀行揭穿金融欺詐騙局

NVIDIA加速微軟最新的Phi-3 Mini開源語言模型

利用NVIDIA組件提升GPU推理的吞吐

使用NVIDIA Triton推理服務器來加速AI預測

利用NVIDIA產品技術組合提升用戶體驗

什么是Triton-shared?Triton-shared的安裝和使用

NVIDIA 初創加速計劃 Omniverse 加速營

NVIDIA Triton助力騰訊PCG加速在線推理

NVIDIA Triton助力騰訊PCG加速在線推理

評論