前面我們花了很多力氣在 TAO 上面訓練模型,其最終目的就是要部署到推理設備上發揮功能。除了將模型訓練過程進行非常大幅度的簡化,以及整合遷移學習等功能之外,TAO 還有一個非常重要的任務,就是讓我們更輕松獲得 TensorRT 加速引擎。

將一般框架訓練的模型轉換成 TensorRT 引擎的過程并不輕松,但是 TensorRT 所帶來的性能紅利又是如此吸引人,如果能避開麻煩又能享受成果,這是多么好的福利!

-

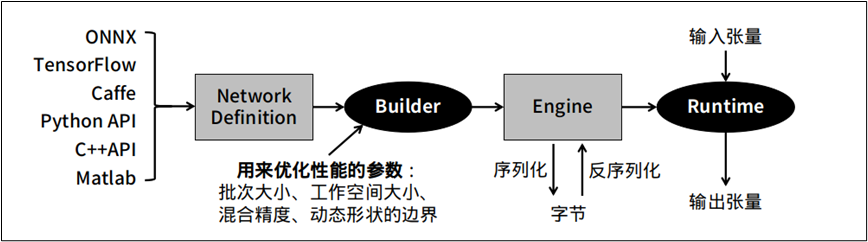

一般深度學習模型轉成 TensorRT 引擎的流程

下圖是將一般模型轉成 TesnorRT 的標準步驟,在中間 “Builder” 右邊的環節是相對單純的,比較復雜的是 “Builder” 左邊的操作過程。

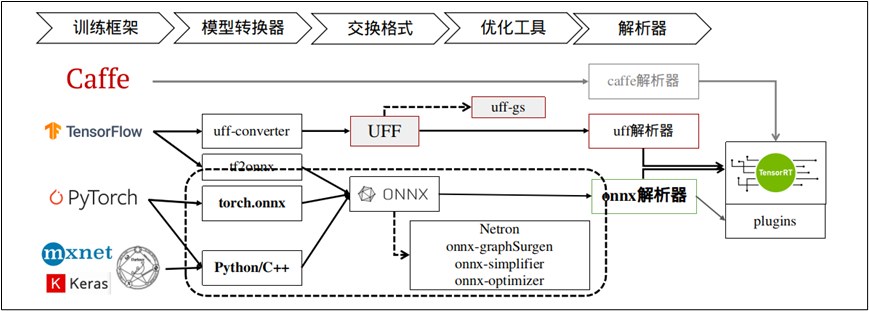

下圖就上圖 “NetworkDefinition” 比較深入的內容,TensorRT 提供 Caffe、uff 與 ONNX 三種解析器,其中 Caffe 框架已淡出市場、uff 僅支持 TensorFlow 框架,其他的模型就需要透過 ONNX 交換格式進行轉換。

這里以 TensorRT 所提供的 YOLOv3 范例來做范例,在安裝 Jetpack 4.6 版本的 Jetson Nano 設備上進行體驗,請進入到 TesnorRT 的 YOLOv3 范例中:

cd /usr/src/tensorrt/samples/python/yolov3_onnx

?

根據項目的 README.md 指示,我們需要先為工作環境添加依賴庫,不過由于部分庫的版本關系,請先將 requirements.txt 的第 1、3 行進行以下的修改:

numpy==1.19.4protobuf>=3.11.3onnx==1.10.1Pillow; python_version<"3.6"Pillow==8.1.2; python_version>="3.6"pycuda<2021.1

然后執行以下指令進行安裝:

python3 -m pip install -r requirements.txt

接下來需要先下載 download.yml 里面的三個文件,

wget https://pjreddie.com/media/files/yolov3.weightswget https://raw.githubusercontent.com/pjreddie/darknet/f86901f6177dfc6116360a13cc06ab680e0c86b0/cfg/yolov3.cfgwgethttps://github.com/pjreddie/darknet/raw/f86901f6177dfc6116360a13cc06ab680e0c86b0/data/dog.jpg

然后就能執行以下指令,將 yolov3.weights 轉成 yolov3.onnx:

./yolov3_to_onnx.py -d /usr/src/tensorrt

這個執行并不復雜,是因為 TensorRT 已經提供 yolov3_to_onnx.py 的 Python 代碼,但如果將代碼打開之后,就能感受到這 750+ 行代碼要處理的內容是相當復雜,必須對 YOLOv3 的結構與算法有足夠了解,包括解析 yolov3.cfg 的 788 行配置。想象一下,如果這個代碼需要自行開發的話,這個難度有多高!

接下去再用下面指令,將 yolov3.onnx 轉成 yolov3.trt 加速引擎:

./onnx_to_tensorrt.py -d /usr/src/tensorrt

以上是從一般神經網絡模型轉成 TensorRT 加速引擎的標準步驟,這需要對所使用的神經網絡的結構層、數學公式、參數細節等等都有相當足夠的了解,才有能力將模型先轉換成 ONNX 文件,這是技術門檻比較高的環節。

-

TAO 工具訓練的模型轉成 TensorRT 引擎的工具

用 TAO 工具所訓練、修剪并匯出的 .etlt 文件,可以跳過上述過程,直接在推理設備上轉換成 TensorRT 加速引擎,我們完全不需要了解神經網絡的任何結構與算法內容,直接將 .etlt 文件復制到推理設備上,然后用 TAO 所提供的轉換工具進行轉換就可以。

這里總共需要執行三個步驟:

1、下載 tao-converter 工具,并調試環境:

請根據以下 Jetpack 版本,下載對應的 tao-converter 工具:

Jetpack 4.4:https://developer.nvidia.com/cuda102-trt71-jp44-0Jetpack 4.5:https://developer.nvidia.com/cuda110-cudnn80-trt72-0Jetpack 4.6:https://developer.nvidia.com/jp46-20210820t231431z-001zip

下載壓縮文件后執行解壓縮,就會生成 tao-converter 與 README.txt 兩個文件,再根據 README.txt 的指示執行以下步驟:

(1)安裝 libssl-dev 庫:

sudo apt install libssl-dev

(2) 配置環境,請在 ~/.bashrc 最后面添加兩行設置:

export TRT_LIB_PATH=/usr/lib/aarch64-linux-gnuexportTRT_INCLUDE_PATH=/usr/include/aarch64-linux-gnu

(3) 將 tao-convert 變成可執行文件:

source ~/.bashrcchmod +x tao-convertersudocptao-converter/usr/local/bin

2、安裝 TensorRT 的 OSS (Open Source Software)

這是 TensorRT 的開源插件,項目在 https://github.com/NVIDIA/TensorRT,下面提供的安裝說明非常復雜,我們將繁瑣的步驟整理之后,就是下面的步驟:

export ARCH=請根據設備進行設置,例如Nano為53、NX為72、Xavier為62export TRTVER=請根據系統的TensorRT版本,例如Jetpack 4.6為8.0.1git clone -b $TRTVER https://github.com/nvidia/TensorRT TRTosscd TRToss/git checkout -b $TRTVER && git submodule update --init --recursivemkdir -p build && cd buildcmake ..-DGPU_ARCHS=$ARCH-DTRT_LIB_DIR=/usr/lib/aarch64-linux-gnu/-DCMAKE_C_COMPILER=/usr/bin/gcc-DTRT_BIN_DIR=`pwd`/out-DTRT_PLATFORM_ID=aarch64-DCUDA_VERSION=10.2make nvinfer_plugin -j$(nproc)sudomv/usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1/usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1.baksudocplibnvinfer_plugin.so.8.0.1/usr/lib/aarch64-linux-gnu/libnvinfer_plugin.so.8.0.1

這樣就能開始用 tao-converter 來將 .etlt 文件轉換成 TensorRT 加速引擎了。

3、用 tao-converter 進行轉換

(1)首先將 TAO 最終導出 (export) 的文件復制到 Jetson Nano 上,例如前面的實驗中最終導出的文件 ssd_resnet18_epoch_080.etlt,

(2)在 Jetson Nano 上執行 TAO 的 ssd.ipynb 最后所提供的轉換指令,如下:

KEY=tao converter -k $KEY-d 3,300,300-o NMS-e ssd_resnet18_epoch_080.trt # 自己設定輸出名稱16-t fp16 # 使用export時相同精度nchwssd_resnet18_epoch_080.etlt

這樣就能生成在 Jetson Nano 上的 ssd_resnet18_epoch_080.trt 加速引擎文件,整個過程比傳統方式要簡便許多。

原文標題:NVIDIA Jetson Nano 2GB系列文章(64):將模型部署到Jetson設備

文章出處:【微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

-

NVIDIA

+關注

關注

14文章

4940瀏覽量

102815 -

深度學習

+關注

關注

73文章

5492瀏覽量

120976 -

模型訓練

+關注

關注

0文章

18瀏覽量

1331

原文標題:NVIDIA Jetson Nano 2GB系列文章(64):將模型部署到Jetson設備

文章出處:【微信號:NVIDIA-Enterprise,微信公眾號:NVIDIA英偉達企業解決方案】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

深度學習模型的魯棒性優化

深度學習編譯器和推理引擎的區別

深度學習模型有哪些應用場景

利用Matlab函數實現深度學習算法

基于Python的深度學習人臉識別方法

深度學習模型中的過擬合與正則化

深度學習中的模型權重

Torch TensorRT是一個優化PyTorch模型推理性能的工具

深度學習模型轉成TensorRT引擎的流程

深度學習模型轉成TensorRT引擎的流程

評論