1、NumExpr

NumExpr 是一個(gè)對(duì)NumPy計(jì)算式進(jìn)行的性能優(yōu)化。NumExpr的使用及其簡(jiǎn)單,只需要將原來的numpy語(yǔ)句使用雙引號(hào)框起來,并使用numexpr中的evaluate方法調(diào)用即可。

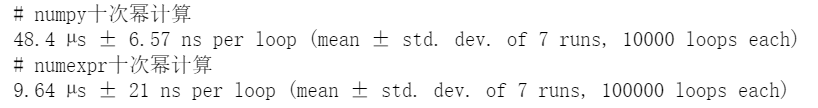

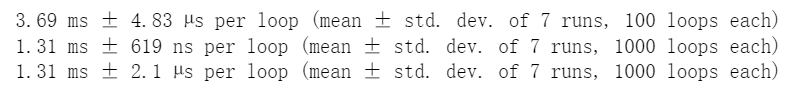

經(jīng)驗(yàn)上看,數(shù)據(jù)有上萬條+ 使用NumExpr才比較優(yōu)效果,對(duì)于簡(jiǎn)單運(yùn)算使用NumExpr可能會(huì)更慢。如下較復(fù)雜計(jì)算,速度差不多快了5倍。

importnumexprasne

importnumpyasnp

a=np.linspace(0,1000,1000)

print('#numpy十次冪計(jì)算')

%timeita**10

print('#numexpr十次冪計(jì)算')

%timeitne.evaluate('a**10')

2、Numba

Numba 使用行業(yè)標(biāo)準(zhǔn)的LLVM編譯器庫(kù)在運(yùn)行時(shí)將 Python 函數(shù)轉(zhuǎn)換為優(yōu)化的機(jī)器代碼。Python 中 Numba 編譯的數(shù)值算法可以接近 C 或 FORTRAN 的速度。如果在你的數(shù)據(jù)處理過程涉及到了大量的數(shù)值計(jì)算,那么使用numba可以大大加快代碼的運(yùn)行效率(一般來說,Numba 引擎在處理大量數(shù)據(jù)點(diǎn) 如 1 百萬+ 時(shí)表現(xiàn)出色)。numba使用起來也很簡(jiǎn)單,因?yàn)閚umba內(nèi)置的函數(shù)本身是個(gè)裝飾器,所以只要在自己定義好的函數(shù)前面加個(gè)@nb.方法就行,簡(jiǎn)單快捷!

#pipinstallnumba

importnumbaasnb

#用numba加速的求和函數(shù)

@nb.jit()

defnb_sum(a):

Sum=0

foriinrange(len(a)):

Sum+=a[i]

returnSum

#沒用numba加速的求和函數(shù)

defpy_sum(a):

Sum=0

foriinrange(len(a)):

Sum+=a[i]

returnSum

importnumpyasnp

a=np.linspace(0,1000,1000)#創(chuàng)建一個(gè)長(zhǎng)度為1000的數(shù)組

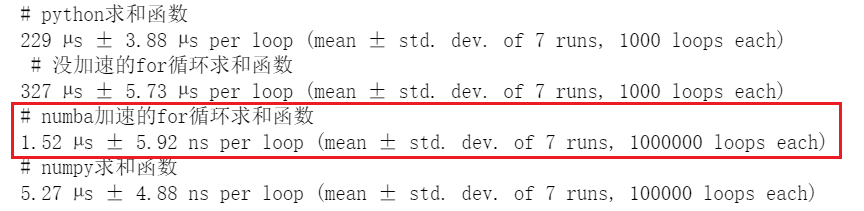

print('#python求和函數(shù)')

%timeitsum(a)

print('#沒加速的for循環(huán)求和函數(shù)')

%timeitpy_sum(a)

print('#numba加速的for循環(huán)求和函數(shù)')

%timeitnb_sum(a)

print('#numpy求和函數(shù)')

%timeitnp.sum(a)

fromnumbaimportcuda

cuda.select_device(1)

@cuda.jit

defCudaSquare(x):

i,j=cuda.grid(2)

x[i][j]*=x[i][j]

#numba的矢量化加速

frommathimportsin

@nb.vectorize()

defnb_vec_sin(a):

returnsin(a)

3、CuPy

CuPy 是一個(gè)借助 CUDA GPU 庫(kù)在英偉達(dá) GPU 上實(shí)現(xiàn) Numpy 數(shù)組的庫(kù)。基于 Numpy 數(shù)組的實(shí)現(xiàn),GPU 自身具有的多個(gè) CUDA 核心可以促成更好的并行加速。

#pipinstallcupy

importnumpyasnp

importcupyascp

importtime

###numpy

s=time.time()

x_cpu=np.ones((1000,1000,1000))

e=time.time()

print(e-s)

###CuPy

s=time.time()

x_gpu=cp.ones((1000,1000,1000))

e=time.time()

print(e-s)

上述代碼,Numpy 創(chuàng)建(1000, 1000, 1000)的數(shù)組用了 1.68 秒,而 CuPy 僅用了 0.16 秒,實(shí)現(xiàn)了 10.5 倍的加速。隨著數(shù)據(jù)量的猛增,CuPy的性能提升會(huì)更為明顯。4、pandas使用技巧

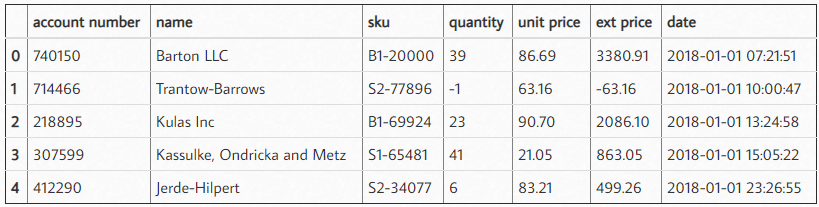

更多pandas性能提升技巧請(qǐng)戳官方文檔:https://pandas.pydata.org/pandas-docs/stable/user_guide/enhancingperf.html4.1 按行迭代優(yōu)化

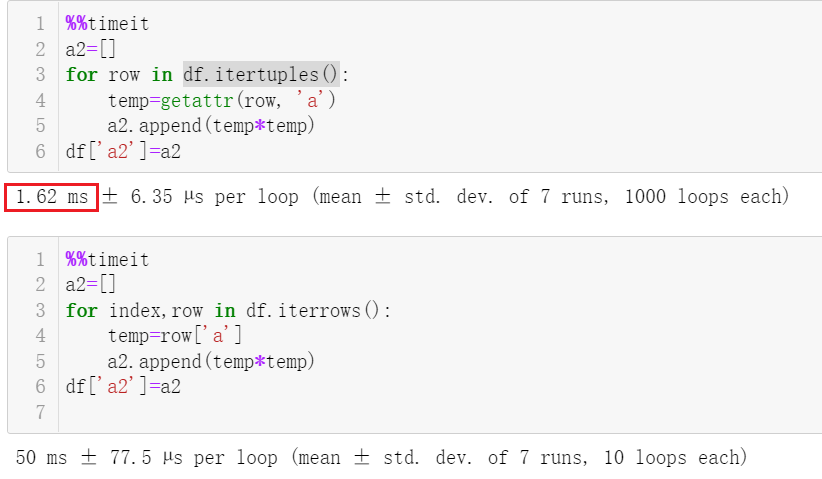

我們按行對(duì)dataframe進(jìn)行迭代,一般我們會(huì)用iterrows這個(gè)函數(shù)。在新版的pandas中,提供了一個(gè)更快的itertuples函數(shù),如下可以看到速度快了幾十倍。

importpandasaspd

importnumpyasnp

importtime

df=pd.DataFrame({'a':np.random.randn(100000),

'b':np.random.randn(100000),

'N':np.random.randint(100,1000,(100000)),

'x':np.random.randint(1,10,(100000))})

%%timeit

a2=[]

forrowindf.itertuples():

temp=getattr(row,'a')

a2.append(temp*temp)

df['a2']=a2

%%timeit

a2=[]

forindex,rowindf.iterrows():

temp=row['a']

a2.append(temp*temp)

df['a2']=a2

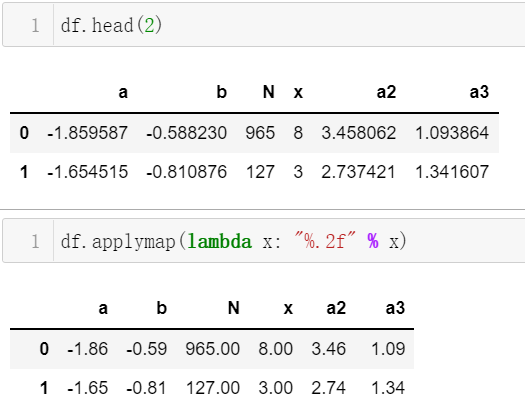

4.2 apply、applymap優(yōu)化

當(dāng)對(duì)于每行執(zhí)行類似的操作時(shí),用循環(huán)逐行處理效率很低。這時(shí)可以用apply或applymap搭配函數(shù)操作,其中apply是可用于逐行計(jì)算,而applymap可以做更細(xì)粒度的逐個(gè)元素的計(jì)算。

#列a、列b逐行進(jìn)行某一函數(shù)計(jì)算

df['a3']=df.apply(lambdarow:row['a']*row['b'],axis=1)

#逐個(gè)元素保留兩位小數(shù)

df.applymap(lambdax:"%.2f"%x)

4.3 聚合函數(shù)agg優(yōu)化

對(duì)于某列將進(jìn)行聚合后,使用內(nèi)置的函數(shù)比自定義函數(shù)效率更高,如下示例速度加速3倍

%timeitdf.groupby("x")['a'].agg(lambdax:x.sum())

%timeitdf.groupby("x")['a'].agg(sum)

%timeitdf.groupby("x")['a'].agg(np.sum)

4.4 文件操作

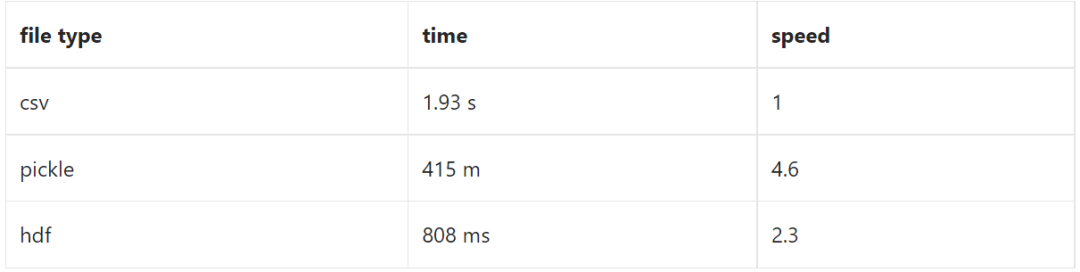

pandas讀取文件,pkl格式的數(shù)據(jù)的讀取速度最快,其次是hdf格式的數(shù)據(jù),再者是讀取csv格式數(shù)據(jù),而xlsx的讀取是比較慢的。但是存取csv有個(gè)好處是,這個(gè)數(shù)據(jù)格式通用性更好,占用內(nèi)存硬盤資源也比較少。此外,對(duì)于大文件,csv還可以對(duì)文件分塊、選定某幾列、指定數(shù)據(jù)類型做讀取。

4.5 pandas.eval

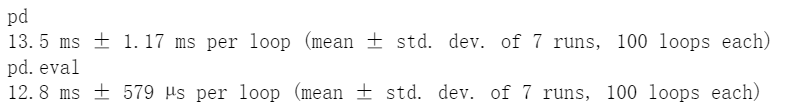

pandas.eval 是基于第一節(jié)提到的numexpr,pandas也是基于numpy開發(fā)的,numexpr同樣可以被用來對(duì)pandas加速)。使用eval表達(dá)式的一個(gè)經(jīng)驗(yàn)是數(shù)據(jù)超過 10,000 行的情況下使用會(huì)有明顯優(yōu)化效果。

importpandasaspd

nrows,ncols=20000,100

df1,df2,df3,df4=[pd.DataFrame(np.random.randn(nrows,ncols))for_inrange(4)]

print('pd')

%timeitdf1+df2+df3+df4

print('pd.eval')

%timeitpd.eval("df1+df2+df3+df4")

5、Cython優(yōu)化

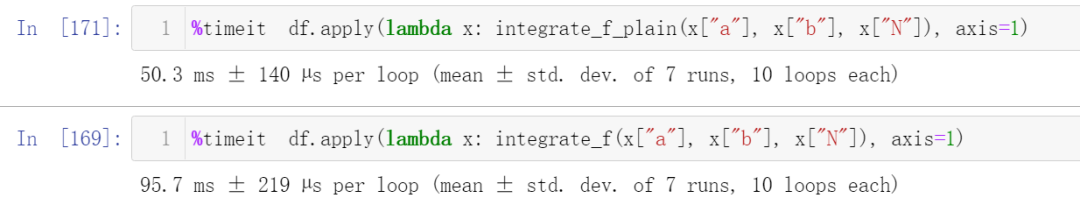

Cython是一個(gè)基于C語(yǔ)言的Python 編譯器,在一些計(jì)算量大的程序中,可以Cython來實(shí)現(xiàn)相當(dāng)大的加速。考慮大部分人可能都不太了解復(fù)雜的cython語(yǔ)句,下面介紹下Cython的簡(jiǎn)易版使用技巧。

通過在Ipython加入 Cython 魔術(shù)函數(shù)%load_ext Cython,如下示例就可以加速了一倍。進(jìn)一步再借助更高級(jí)的cython語(yǔ)句,還是可以比Python快個(gè)幾十上百倍。

%%cython

deff_plain(x):

returnx*(x-1)

defintegrate_f_plain(a,b,N):

s=0

dx=(b-a)/N

foriinrange(N):

s+=f_plain(a+i*dx)

returns*dx

6、swifter

swifter是pandas的插件,可以直接在pandas的數(shù)據(jù)上操作。Swifter的優(yōu)化方法檢驗(yàn)計(jì)算是否可以矢量化或者并行化處理,以提高性能。如常見的apply就可以通過swifter并行處理。

importpandasaspd

importswifter

df.swifter.apply(lambdax:x.sum()-x.min())

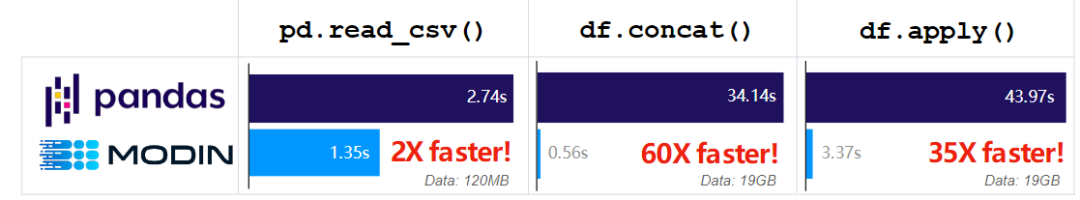

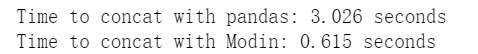

7、Modin

Modin后端使用dask或者ray(dask是類似pandas庫(kù)的功能,可以實(shí)現(xiàn)并行讀取運(yùn)行),是個(gè)支持分布式運(yùn)行的類pandas庫(kù),簡(jiǎn)單通過更改一行代碼import modin.pandas as pd就可以優(yōu)化 pandas,常用的內(nèi)置的read_csv、concat、apply都有不錯(cuò)的加速。注:并行處理的開銷會(huì)使小數(shù)據(jù)集的處理速度變慢。

!pipinstallmodin

importpandas

importmodin.pandasaspd

importtime

##pandas

pandas_df=pandas.DataFrame({'a':np.random.randn(10000000),

'b':np.random.randn(10000000),

'N':np.random.randint(100,10000,(10000000)),

'x':np.random.randint(1,1000,(10000000))})

start=time.time()

big_pandas_df=pandas.concat([pandas_dffor_inrange(25)])

end=time.time()

pandas_duration=end-start

print("Timetoconcatwithpandas:{}seconds".format(round(pandas_duration,3)))

####modin.pandas

modin_df=pd.DataFrame({'a':np.random.randn(10000000),

'b':np.random.randn(10000000),

'N':np.random.randint(100,10000,(10000000)),

'x':np.random.randint(1,1000,(10000000))})

start=time.time()

big_modin_df=pd.concat([modin_dffor_inrange(25)])

end=time.time()

modin_duration=end-start

print("TimetoconcatwithModin:{}seconds".format(round(modin_duration,3)))

print("Modinis{}xfasterthanpandasat`concat`!".format(round(pandas_duration/modin_duration,2)))

原文標(biāo)題:Pandas、Numpy 性能優(yōu)化秘籍

文章出處:【微信公眾號(hào):數(shù)據(jù)分析與開發(fā)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

數(shù)據(jù)處理

+關(guān)注

關(guān)注

0文章

548瀏覽量

28447 -

python

+關(guān)注

關(guān)注

53文章

4753瀏覽量

84068 -

性能優(yōu)化

+關(guān)注

關(guān)注

0文章

17瀏覽量

7419

原文標(biāo)題:Pandas、Numpy 性能優(yōu)化秘籍

文章出處:【微信號(hào):DBDevs,微信公眾號(hào):數(shù)據(jù)分析與開發(fā)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

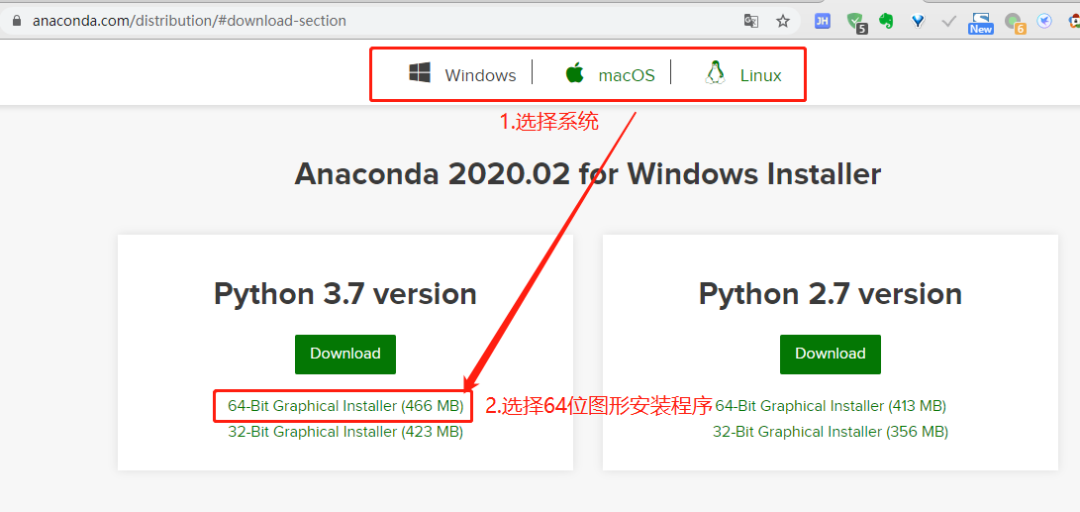

python 學(xué)習(xí):在內(nèi)網(wǎng)中 python庫(kù)-numpy 安裝方法,升級(jí)pip3版本的指令

Python利用pandas讀寫Excel文件

Python編程的十大依賴庫(kù)有哪些

phpy:PHP與Python互調(diào)用庫(kù)

使用pandas進(jìn)行數(shù)據(jù)選擇和過濾的基本技術(shù)和函數(shù)

python第三方庫(kù)有哪些

python中如何引入math庫(kù)

如何實(shí)現(xiàn)Pandas的DataFrame轉(zhuǎn)換交互式表格

Pandas:Python中強(qiáng)大方便的繪圖功能

Pandas DataFrame的存儲(chǔ)格式性能對(duì)比

Anaconda:Python 數(shù)據(jù)分析與挖掘好幫手

如何利用Python和pandas來處理json數(shù)據(jù)

Pandas:Python中最好的數(shù)據(jù)分析工具

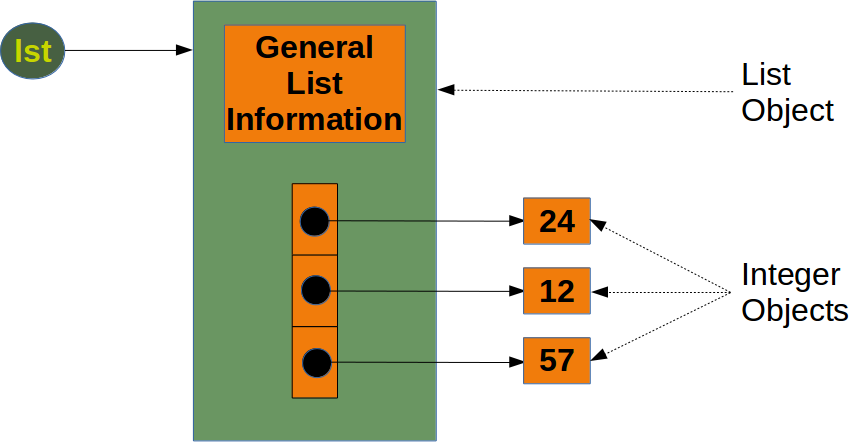

List和Numpy Array有什么區(qū)別

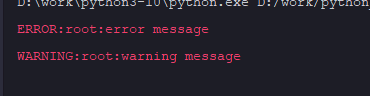

Python庫(kù)中oloredlogs的使用

詳解Python中的Pandas和Numpy庫(kù)

詳解Python中的Pandas和Numpy庫(kù)

評(píng)論