目前,我們正處于機器視覺和人工智能轉型的初期,據Yole Development等市場研究機構的分析,預計到2030年,視覺技術將創造價值100億美元的市場。該技術會滲透到包括自動駕駛、AR、可穿戴計算成像、機器人技術等各個領域。

機器視覺和人工智能領域總是離不開視覺技術的,基于事件的神經擬態視覺是一種新的成像技術范式,可以極大提高機器感知周圍環境的能力,從而做出智能決策。這種更進一步的視覺技術如何在機器視覺和人工智能領域創造新的技術標準,如何將現有應用的性能提升到全新的水平?

基于事件的視覺技術與傳統圖像傳感器的本質區別

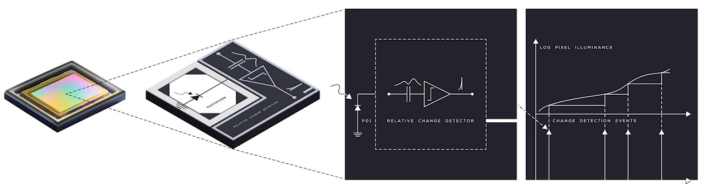

基于事件的神經擬態視覺技術受生物原理啟發,與傳統的圖像傳感器工作方式有很大的不同。類似于人眼視網膜,基于事件的神經擬態視覺技術傳感器不會在固定的時間生成圖像,而是著重于關注場景的動態變化。這種動態變化信息對于機器視覺和人工智能是相當重要的。這種工作原理意味著基于該技術的傳感器采集圖像的方式是異步的、連續的,在模擬域中運作。每個感光器都是獨立的,只對變化的事物作出反應,靜態的背景信息不會被一遍又一遍被重復采集。

(像素的智能感知,Prophesee)

為了模擬這種生物學原理,需要設計智能像素,通過像素內嵌的智能設計來實現。上圖所示的這套模擬處理系統,基于電平交叉采樣電路,每個像素都能夠對場景中的亮度變化做出反應,從而壓縮冗余,提高數據傳輸速率。

以上圖中的傳感器為例,其時間可以精確至微秒級,而且數據采集速度非常快,更重要的是每個像素都能獨立異步工作。因此基于該技術的傳感器的數據采集功能并不受場景中照明條件的影響。如此一來,這代表著其動態范圍是比傳統的圖像傳感器要高的,大概在120-130dB之間。

基于事件的異步自適應采樣和基于幀的數據采樣,差異也很明顯。在固定時間獲得的一系列圖像不可避免地會導致信息的冗余,雖然其產生的信息在時間上是連續的,但由于數據采集本身的非連續性,幀與幀之間會缺失信息。基于事件的異步自適應采樣只獲取正在變化的信息,換個說法就是捕捉時空范圍內連續的信息流(像素級別)。根據Prophesee的說法,這種傳感器不會產生原始數據,而是僅提供處理任務所需的必要信息。

(采集對比,Prophesee)

圖像之間隱藏信息

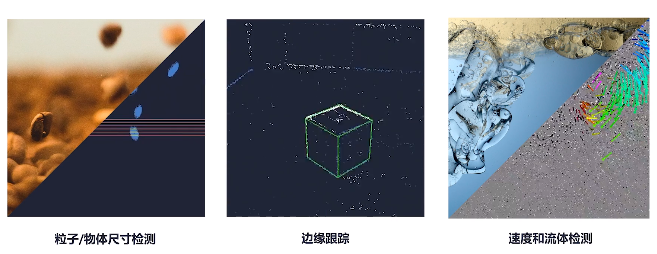

基于事件的傳感器可以快速響應場景變化,揭示迄今為止基于幀的傳感器難以記錄的信息。基于幀的捕捉采集動態范圍不可避免是有限的,而且對光照條件極度依賴,對于新興的人工智能以及機器視覺并不友好。在對于運動物體的理解上,幀與幀之間是沒有信息記錄的,這對于理解整個運動來說是很困難的,甚至有時候是不可能的。而基于事件的傳感帶來的連續的信息流,讓處理系統的跟蹤變得更為容易,對動態信息的理解更深刻。這也意味著可以在本地更新跟蹤,在時間準確度上提升一個大層次。

基于事件的傳感器能記錄亞毫秒時間級別的時間,等效于10000fps,能夠捕捉到那些轉瞬即逝的事件;因為不記錄冗余數據,系統需要處理的數據減少了10至1000倍,對于關鍵動態信息的獲取更準確;同時其高動態范圍,能夠抓取極端照明條件下隱藏起來的信息。

從機器學習的角度來看,這種連續的信息流抓取、跟蹤,對于其數學模型的構建也是一個相當大的簡化。

基于事件的傳感器演進

目前,基于事件的視覺技術傳感器已經發展到了第四代。采用背照式(BSI)3D堆棧工藝制造,硅面積相比第三代VGA傳感器減少了10倍以上。因為將CIS層堆疊在了CMOS層之上,所以器件感光區域和邏輯電路較之前代也有一定的優化。像素間距也降低至了4.86微米,加上超過80%的填充因子,傳感器具備更高的光電性能。

(應用場景,Prophesee)

基于該傳感器的機器學習,可以不使用圖像來訓練神經網絡識別物體,二是使用時間編碼的信息。這給機器學習帶來了不小的改變,一是無需等待幀圖像大大降低了延遲,二是更容易泛化,抓取最主要的事件特征,減少數據集,最后則是減少了計算量。

小結

總的來看,基于事件的視覺傳感技術不受幀速率限制,實現了更快的速度和更高動態范圍,其生成的數據量比傳統圖像傳感器少且功率更低(<10 mW),為機器視覺和人工智能提供了更具成本效益的視覺解決方案。

-

機器視覺

+關注

關注

161文章

4348瀏覽量

120134 -

視覺傳感器

+關注

關注

3文章

248瀏覽量

22857

發布評論請先 登錄

相關推薦

視覺檢測是什么意思?機器視覺檢測的適用行業及場景有哪些?

微視傳感高性能3D視覺產品亮相2024上海機器視覺展

基于事件的視覺傳感,變革機器視覺技術

基于事件的視覺傳感,變革機器視覺技術

評論