在今年 3 月的 GTC 2022 大會上,阿里云帶來了推理優化/部署、深度學習編譯器、大模型部署、訓練優化等主題的內容,分享云端機器學習平臺 PAI (Machine Learning Platform for AI) 最新的創新實踐,并已在【阿里靈杰】知乎號陸續發布三篇演講內容深度回顧。同時阿里云也分享了其設計研發的高性能云手游解決方案——彈性云手機。

專家帶你解讀,免費學習不間斷

阿里云的精彩分享均已在 NVIDIA On-Demand 上線。

云端 Triton 生產實踐

NVIDIA Triton 推理服務器是一款功能全面、可擴展且功能強大的推理解決方案,在邊緣設備和云上皆可部署。在云上將 Triton 部署到生產環境中時,應考慮效率、可擴展性以及與 Triton 自身外的云上基礎設施的集成。本演講將介紹阿里云中通過 PAI-EAS 提供 Triton 作為云服務的關鍵見解:

1) 一鍵部署 Triton 集群

2) 根據請求吞吐量擴展 Triton 集群

3) 與 OSS(對象存儲服務)原生集成

4) Triton 和 GPU 共享調度。

通過 PAI-Blade 更易用、更可靠地使用 TensorRT

TensorRT 是由 NVIDIA 推出的業界領先的推理加速器,在深度學習推理場景應用廣泛,但是通過 TensorRT 來優化深度學習模型仍有一定門檻。首先,通過 TensorRT 解析模型時會遇到轉換失敗或表現不理想的情況。其次,從零開始搭建網絡比較耗時且難以擴展。此外,在生產環境里增加新的推理框架需要嚴謹的評估。本次演講將介紹如何通過一站式 AI 加速器 PAI-Blade 解決上述問題。PAI-Blade 能夠實現 TensorRT 后端上的自動圈圖和自動化運行。同時還可以與 TensorRT Plugin 協同工作,以實現更好的性能。目前 PAI-Blade 提供對 TensorFlow 和 PyTorch 的產品化支持。

PaiSparse:面向深度學習的稀疏加速庫

隨著超大語言模型的流行, 如何部署超大模型正在成為迫切需要解決的問題。非結構化剪枝可以將模型規模縮小 99%,讓超大語言模型在單卡上部署成為可能。然而超大模型稀疏后會呈現不同的非零分布,而這些分布會直接影響硬件的計算量并影響最終的執行時間。同時與傳統的 HPC 任務不同的是,基于訓練后的稀疏矩陣分布的 tuning 在深度學習推理中是可以進行的。因此我們提出一個面向深度學習的稀疏加速庫:PaiSparse,可以自動生成更高效的稀疏算子。實驗表明,與 cuSparse 相比, PaiSparse 可以提速 1.5~5 倍。

PTXC:使用 XLA 編譯器通過云 GPU 擴展 PyTorch 訓練

在工業界實踐中,模型訓練和部署的效率、規模和適配性關系到最終的應用效果。為滿足 PyTorch eager-first 的 GPU 編譯流程, Lazy Tensor 架構被提出來。通過采用實踐驗證過的產品化 XLA 編譯器和分布式引擎, PTXC 能在阿里云 GPU 集群中以基于編譯優化的方式一鍵快速搭建易用、彈性且高效的 PyTorch 模型訓練系統。

阿里云基于 AI 編譯器的通用透明性能解決方案

本次演講將從云服務廠商的視角,分享在云端和機器學習平臺上大規模部署 AI 編譯器的實戰經驗。我們將詳細介紹近期剛剛開源的動態 shape 深度學習編譯器 BladeDISC,包括它的背景和主要特性,具體設計架構和實現細節,動態 shape 語義下的性能優化經驗,未來計劃以及在 NVIDIA 設備上的應用等。

未來游戲趨勢:通過阿里云彈性云手機解決方案打造云游戲

基于 NVIDIA GPU 及原生的 ARM 平臺,阿里云設計研發了高性能的云手游解決方案——彈性云手機,可實現虛擬化渲染及顯存隔離,在確保隔離的情況下充分發揮 GPU 性能。此外,彈性云手機無縫對接阿里巴巴云游戲流媒體平臺,該平臺兼容多種流媒體協議,并具備完整的“渲染-編碼-串流”云手游架構。

原文標題:NVIDIA On-Demand 觀看阿里云機器學習平臺 PAI 的精彩演講

文章出處:【微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

審核編輯:湯梓紅

-

NVIDIA

+關注

關注

14文章

4793瀏覽量

102429 -

機器學習

+關注

關注

66文章

8306瀏覽量

131845 -

阿里云

+關注

關注

3文章

922瀏覽量

42780

原文標題:NVIDIA On-Demand 觀看阿里云機器學習平臺 PAI 的精彩演講

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

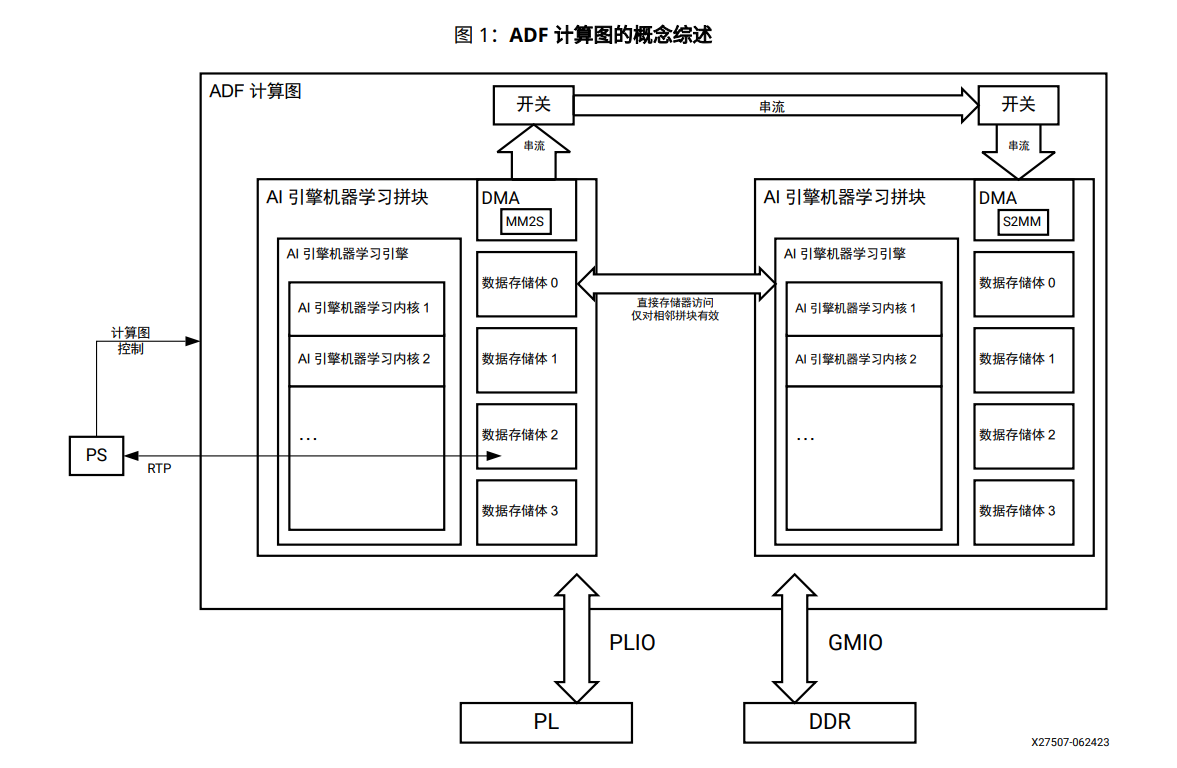

AI引擎機器學習陣列指南

【「時間序列與機器學習」閱讀體驗】+ 鳥瞰這本書

【「時間序列與機器學習」閱讀體驗】+ 簡單建議

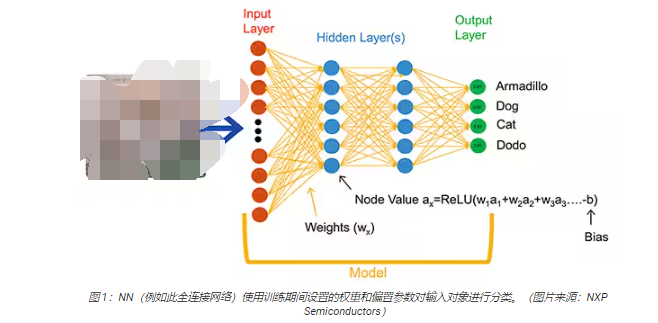

深度學習與傳統機器學習的對比

恩智浦云實驗室正式啟動人工智能創新實踐平臺

廣和通發布機器人開發平臺

榮湃半導體發布全新Pai8265xx系列柵極驅動器

WiFi模塊助力少兒編程:創新學習與實踐體驗

如何快速部署邊緣就緒的機器學習應用

云端機器學習平臺PAI最新的創新實踐

云端機器學習平臺PAI最新的創新實踐

評論