PhiGent Heimdallr - 基于Xilinx KV26的立體視覺匹配方案

概要:

立體視覺匹配的目標(biāo)是從不同視點(diǎn)圖像中找到匹配的對應(yīng)點(diǎn),最終輸出RGBD的深度圖像。

在本文中,我們將首先對基于AI 的雙目立體匹配算法進(jìn)行介紹,接著會(huì)對本方案中使用的 Xilinx Vitis AI Tools 和 Xilinx Vitis Flow 開發(fā)流程進(jìn)行介紹。

目標(biāo)及原因:

深度估算是自動(dòng)駕駛領(lǐng)域的一項(xiàng)關(guān)鍵技術(shù)。作為自動(dòng)駕駛中最常用的傳感器,攝像頭能夠獲取全面、豐富又密集的信息。基于立體視覺的深度估算技術(shù)可以準(zhǔn)確識別和定位運(yùn)動(dòng)與靜止目標(biāo)以及路面對象。隨著深度學(xué)習(xí)技術(shù)的迅猛發(fā)展以及大規(guī)模立體數(shù)據(jù)集的問世,基于神經(jīng)網(wǎng)絡(luò)的立體視覺匹配算法得以快速發(fā)展,計(jì)算精度與效率均超過了傳統(tǒng)算法。借助強(qiáng)大的特征提取功能,基于深度學(xué)習(xí)的端到端雙目立體匹配技術(shù)能確保具有弱紋理和重復(fù)紋理的對象仍然可以輸出有效的高精度深度信息,從而滿足智能駕駛系統(tǒng)在各種場景下的感測需求。

本方案使用了最新的基于卷積神經(jīng)網(wǎng)絡(luò)的立體視覺匹配算法,并通過Xilinx VitisAI 工具包,將該算法中的卷積網(wǎng)絡(luò)部分部署至賽靈思深度學(xué)習(xí)處理器(DPU)上進(jìn)行加速。同時(shí),算法中無法使用 DPU 加速的部分,如相關(guān)層操作則使用了專用的定制IP 進(jìn)行加速。除此之外,本方案還定制了專用的圖像預(yù)處理 IP 用來進(jìn)行輸入圖像的預(yù)處理操作。

本方案可以部署至賽靈思 KV260 開發(fā)板或者基于 KV26 核心板的專用定制開發(fā)板Heimdallr-DEB。

基于 KV260 開發(fā)的方案由于受限于雙目立體視覺模組的硬件接口限制,僅能使用數(shù)據(jù)回灌方式驗(yàn)證深度估計(jì)效果。基于本方案定制的 Heimdallr-DEB 開發(fā)板方案則能使用配套的雙目立體視覺模組,將本方案部署至汽車上,在車輛行駛過程中實(shí)時(shí)展示立體匹配效果。

技術(shù)方案介紹

本方案將從以下幾個(gè)部分進(jìn)行介紹:

模型的選擇及調(diào)優(yōu);

FPGA PL側(cè)開發(fā)流程;

軟件配套程序開發(fā);

方案部署及運(yùn)行。

1

模型的創(chuàng)建及調(diào)優(yōu)

模型選擇:

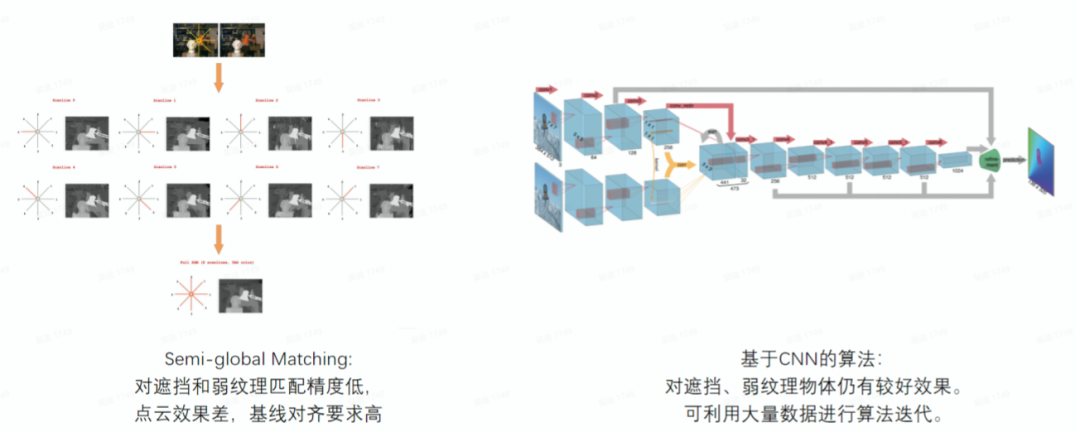

基于神經(jīng)網(wǎng)絡(luò)的雙目立體視覺方案首先需要選定算法。在深度學(xué)習(xí)大火之前,研究者們都使用基于規(guī)則的方法去進(jìn)行視差匹配,這些典型的傳統(tǒng)算法有:SGM,SGBM等。在卷積神經(jīng)網(wǎng)絡(luò)迅速發(fā)展后,有大量學(xué)者使用基于 CNN 的方法進(jìn)行立體視覺匹配算法的研究。目前,根據(jù)在 Kitti 2015 測試數(shù)據(jù)集上準(zhǔn)確率較高的幾種 CNN 算法,有 Raft-Stereo, GA-Net, FADNet 等。基于神經(jīng)網(wǎng)絡(luò)的匹配算法在遮擋、弱紋理區(qū)域仍能獲得非常好的效果,同時(shí)可以利用持續(xù)更新的數(shù)據(jù)集對算法進(jìn)行迭代。

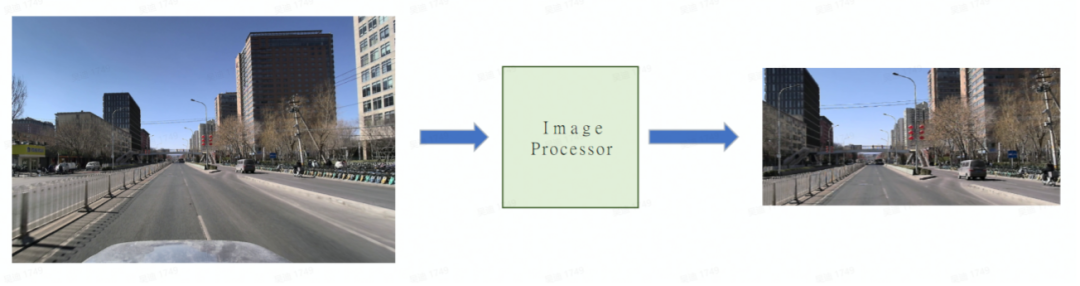

圖1:傳統(tǒng)匹配算法與基于CNN匹配算法的對比

但同時(shí),這些基于神經(jīng)網(wǎng)絡(luò)的算法或者計(jì)算量太大,或者使用了特殊的操作導(dǎo)致不適合部署到 FPGA 上實(shí)現(xiàn)。我們針對 FPGA 器件的特點(diǎn),為充分利用 FPGA 的計(jì)算特性,提高計(jì)算效率,結(jié)合了幾種主流神經(jīng)網(wǎng)絡(luò)算法的特點(diǎn),創(chuàng)造出適合部署在 FPGA 器件上的網(wǎng)絡(luò)模型 PhiFADNet - PhiGent Fast and Accurate Disparity Network。PhiFADNet 計(jì)算量小,網(wǎng)絡(luò)結(jié)構(gòu)簡單但保留了雙目神經(jīng)網(wǎng)絡(luò)算法中最重要的 correlation 層,使得該算法在低算力的同時(shí)還能報(bào)錯(cuò)不錯(cuò)的準(zhǔn)確率。

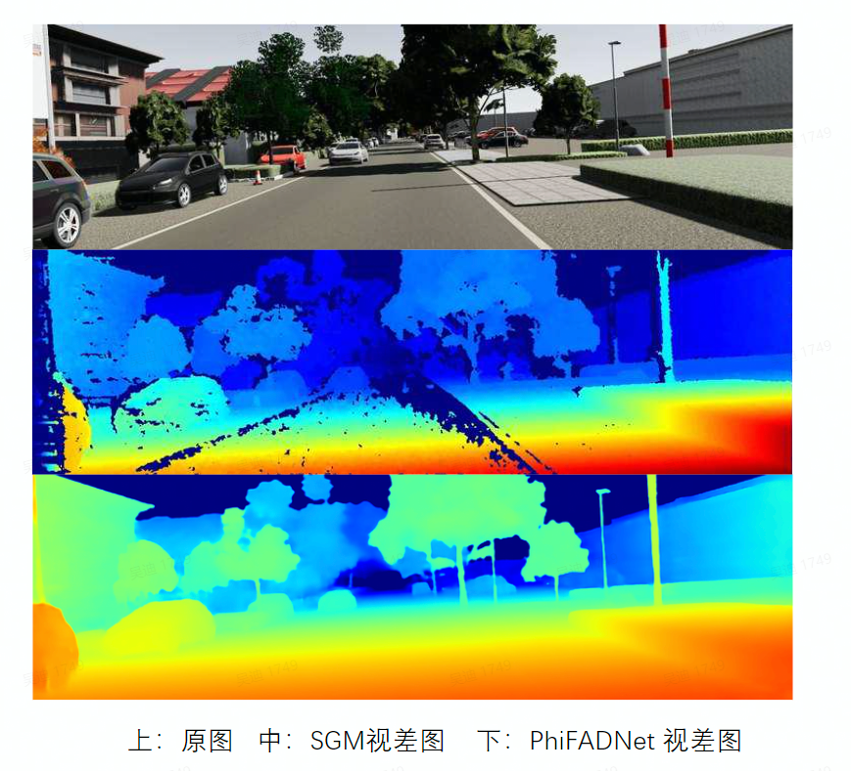

我們挑選了 Kitti 數(shù)據(jù)集中公開的一張圖片,并分別使用了SGM 和 PhiFADNet 進(jìn)行視差匹配,發(fā)現(xiàn)使用 PhiFADNet 的視差結(jié)果,在地面等弱紋理區(qū)域有更好的連續(xù)視差結(jié)果,同時(shí)在細(xì)小物體出的檢測更加準(zhǔn)確,整體的視差圖噪聲和飛點(diǎn)較少。

圖:SGM與 PhiFADNet 視差圖對比

模型量化和編譯:

Xilinx Vitis AI 提供了整套的工具用來對用戶自定義網(wǎng)絡(luò)進(jìn)行 裁剪、量化和訓(xùn)練。Vitis AI 軟件可作為 Docker 鏡像使用并且可從 Docker hub (xilinx/vitis-ai Tags | Docker Hub)下載。Vitis AI 用戶指南(Vitis AI User Guide)則提供了詳細(xì)的分步說明。我們使用 Xilinx Vitis AI Tools 對這三個(gè)網(wǎng)絡(luò)進(jìn)行 Quantization-aware training (QAT). Xilinx Vitis AI Tools 包括AI Optimizer, AI Quantizer, AI Compiler和 AI Profiler。

模型測試效果:

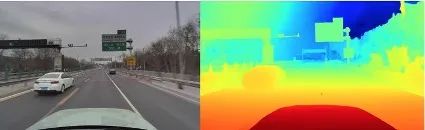

我們使用雙目模組在實(shí)車高速公路場景上采集了大量數(shù)據(jù)并進(jìn)行了訓(xùn)練,訓(xùn)練后的模型效果在實(shí)際場景中的表現(xiàn)如下。

圖:PhiFADNet 實(shí)車路段視差圖展示

2

FPGA PL 側(cè)開發(fā)

Correlation Accelerator:

FADNet 結(jié)構(gòu)中的相關(guān)層操作-correlation 并不能直接部署到 Xilinx DPU上,因此我們需要單獨(dú)把 correlation 操作提取出來進(jìn)行運(yùn)算。根據(jù)測試結(jié)果,如果使用 ZU5 芯片上的 4核 ARM-A53 進(jìn)行correlation操作,共耗時(shí)80ms,而整個(gè)神經(jīng)網(wǎng)絡(luò)其他部分使用DPU 運(yùn)行的時(shí)間加起來也就80ms。使用 ARM 完成 correlation極大的增加了整個(gè)網(wǎng)絡(luò)的延時(shí),而自動(dòng)駕駛場景對延時(shí)有著嚴(yán)格的要求。因此我們考慮使用 FPGA 對 correlation 進(jìn)行操作。

根據(jù) correlation 操作的特點(diǎn),我們定制化了一個(gè)專用 Correlation Accelerator IP 對其進(jìn)行加速。由于 correlation操作的輸入和輸出都需要連接至 DPU,因此我們需要對改操作進(jìn)行定點(diǎn)化操作,并支持 PS 進(jìn)行 shift 移位配置。使用 FPGA 進(jìn)行加速后的 Correlation 操作能獲得相比與 PS 處理時(shí)間 20倍的加速比。加速后的 Correlation 操作能極大的縮短雙目立體視覺的匹配延時(shí)。

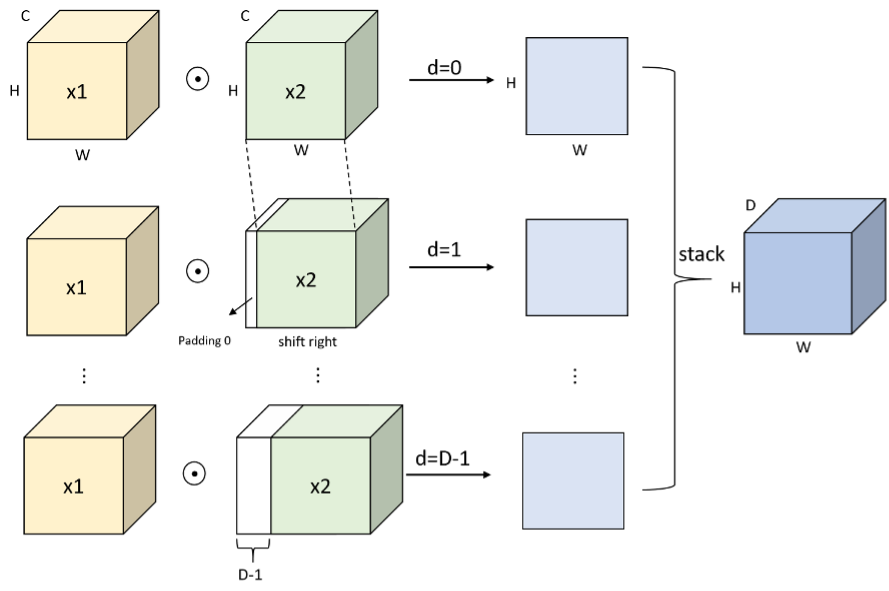

比較典型的 correlation 操作示意圖如下圖所示:

圖:Correlation 流程示例圖

圖像前處理:

無論是基于傳統(tǒng)算法或者神經(jīng)網(wǎng)絡(luò)的雙目立體匹配系統(tǒng),對圖像前處理都有著較高的要求。圖像前處理通常包括 ISP、畸變矯正、極線對齊、圖像下采樣等。

ISP模塊我們使用模組自帶的 ISP 芯片或者開發(fā)板上的 ISP 處理芯片完成圖像信號處理。

畸變矯正和極線對齊處理,我們可以通過標(biāo)定獲取雙目攝像頭模組的內(nèi)外參數(shù)并獲得矯正矩陣,通過該矯正矩陣可以同時(shí)完成圖像的畸變矯正和極線對齊。由于該操作主要是將圖像數(shù)據(jù)根據(jù)矯正矩陣進(jìn)行重拍,使用PS 端 ARM 處理器進(jìn)行該操作可以獲得較高的效率,同時(shí)節(jié)省部分 PL 資源。

最后在圖像輸入神經(jīng)網(wǎng)絡(luò)處理前,我們需要對矯正對齊后的圖像進(jìn)行下采樣處理。下采樣處理的主要目的是去除左右圖像中的無視差區(qū)域以及部分非感興趣區(qū)域(如:自動(dòng)駕駛中的天空區(qū)域),下采樣后的圖像尺寸為神經(jīng)網(wǎng)絡(luò)的輸入尺寸。我們使用 FPGA PL 部分來對該下采樣操作進(jìn)行加速。加速后的下采樣操作針對單幅 2M pixel 圖像的處理時(shí)間縮減為 7ms,而使用 PS 部分進(jìn)行該操作需要大概28ms。

圖像前處理的作用:去除圖像中的無視差區(qū)域;剔除圖像中的非感興趣區(qū)域(天空,車頭等);根據(jù)網(wǎng)絡(luò)尺寸動(dòng)態(tài)調(diào)整輸入大小。

圖:圖像前處理剔除非感興趣區(qū)域

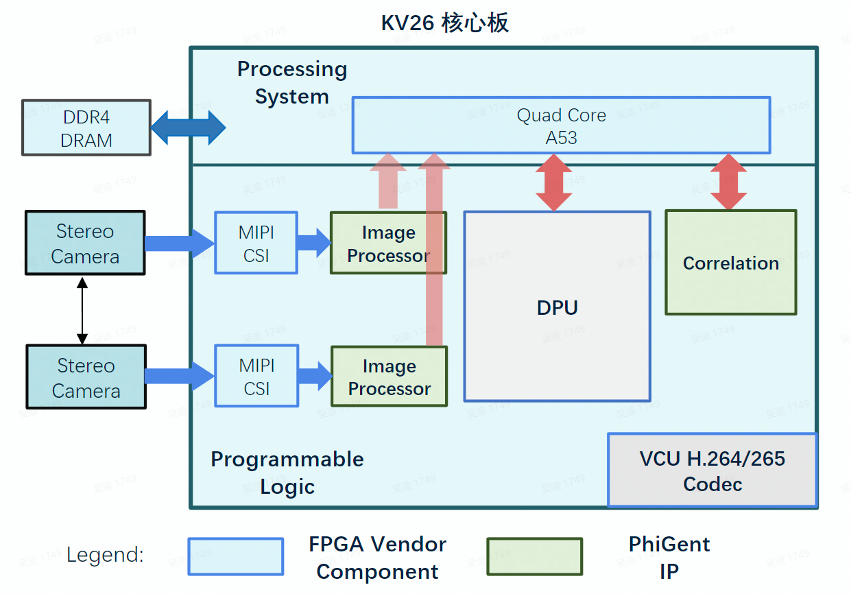

整體FPGA設(shè)計(jì)框架:

根據(jù)前文描述,整體FPGA設(shè)計(jì)框架包括雙目圖像前處理模塊(Image Processing),神經(jīng)網(wǎng)絡(luò)加速器模塊(Xilinx DPU), 相關(guān)層加速模塊(Correlation IP)。本方案使用PS和PL協(xié)同工作,PS部分主要負(fù)責(zé)圖像校正對齊,數(shù)據(jù)調(diào)度,流程控制等。整個(gè)方案運(yùn)行時(shí),PS和PL的使用率都能達(dá)到80%以上,同時(shí)通過流水線并行處理使得整個(gè)系統(tǒng)能獲得最優(yōu)的吞吐率。整個(gè) FPGA 的設(shè)計(jì)框架如下所示:

圖:基于kv26核心板的 FPGA 設(shè)計(jì)框架

FPGA工程制作:

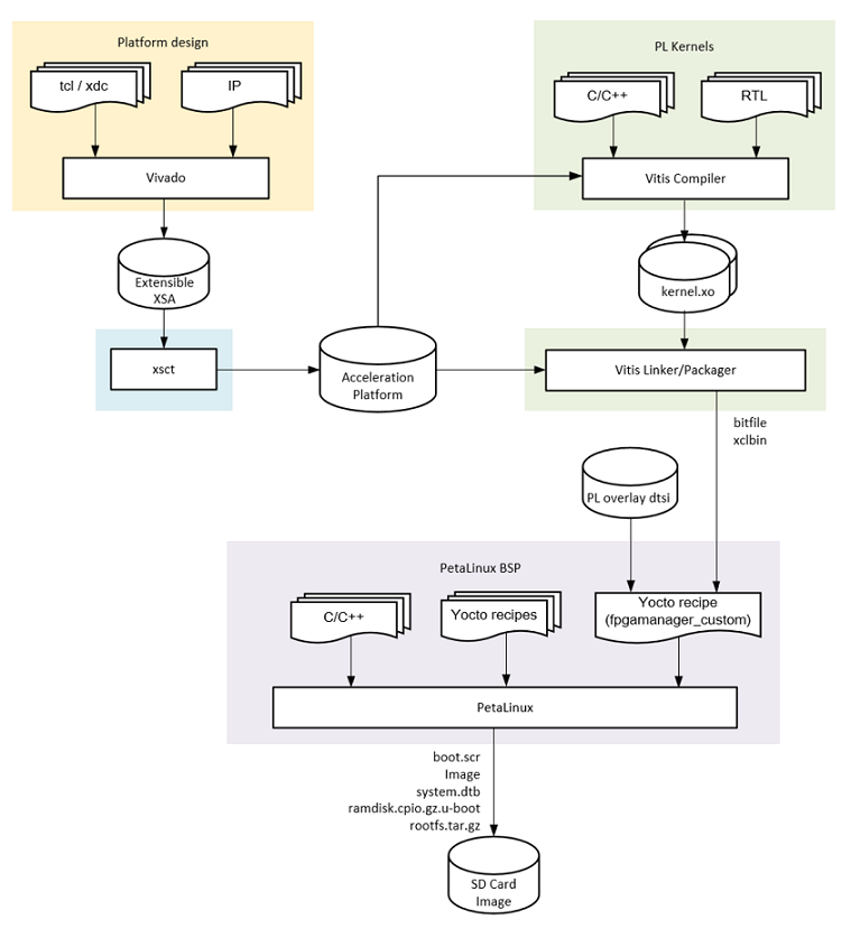

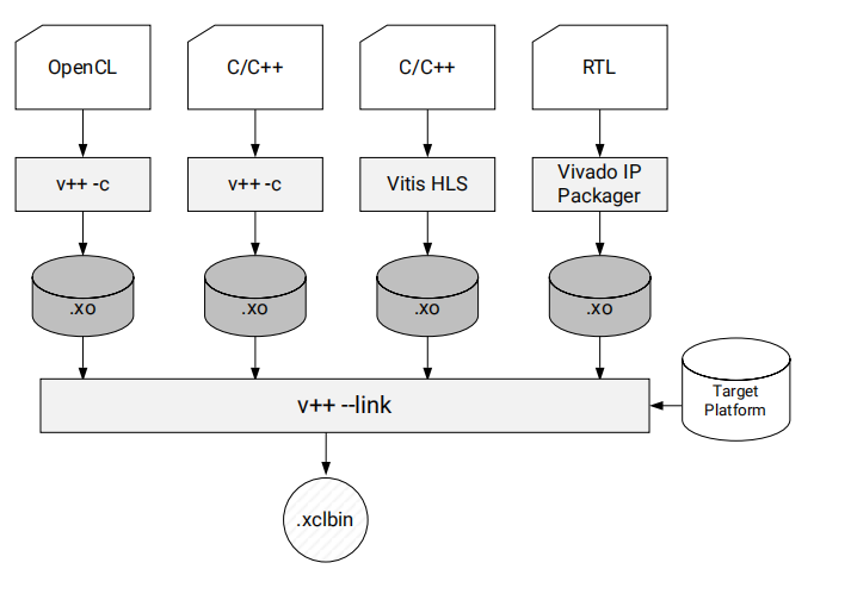

本方案使用 Xilinx Vitis Flow 完成整個(gè) FPGA 工程的開發(fā)流程。整個(gè) Vitis Flow 的開發(fā)流程如下圖所示(注:開發(fā)環(huán)境需要安裝有 Vivado 2021.1 和 Vitis 2021.1):

圖:Vitis Flow 開發(fā)流程示意圖

Vitis Platform Flow:

首先我們需要制作開發(fā)板對應(yīng)的 platform。本方案提供了兩套實(shí)現(xiàn)方案,分別是基于 Xilinx KV260 開發(fā)板和 Phigent Heimdallr-DEB 開發(fā)板。兩套開發(fā)板的核心板都為 K26 SOM 核心板,僅在外圍的 GMSL 接口上有主要不同(Phigent Heimdallr-DEB 可以接入 Phigent 定制化雙目模組)。因此兩套方案可以使用相同的 Vitis Platform。

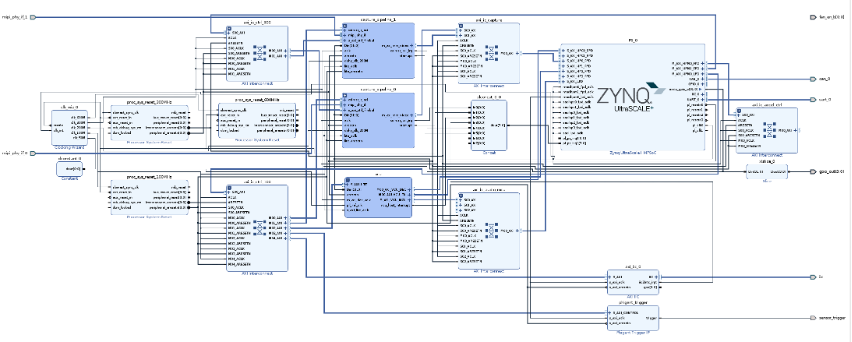

Vitis Platform Flow 首先需要使用 Vivado 生成定制化的 PL design。我們選定工程的芯片型號為 K26 SOM,然后在 vivado block design 中添加本方案需要的 platform 組件,包括 Xilinx MIPI RX Controller,VCU,Phigent Image Processor 和配套的 interconnect 等。整個(gè) platform 的 block design 設(shè)計(jì)概覽如下圖所示。完成 Platform 的設(shè)計(jì)后,使用 Vivado 工具生成 .xsa 文件,該文件在后續(xù)配套的 petalinux 工程中還會(huì)進(jìn)一步使用。

圖:使用 Vivado 生成 Block Design

生成 .xsa 文件后,使用 vitis 提供的 xsct 命令生成 pfm 文件,該文件會(huì)在后續(xù)用于集成 HLS/RTL kernel 并生成最后的 xclbin。

PL kernels:

Vitis Flow 將 FPGA 工程分成了 platform 和 PL kernels 兩個(gè)部分。其中 Platform 中用于配置工程中需要的基礎(chǔ)功能 IP、硬件接口、硬核/軟核設(shè)備等。PL kernels 為用戶自定義生成的一些加速IP,如本方案中使用 correlation IP 和 Xilinx DPU 均屬于 PL kernels。

開發(fā)完 Correlation IP 后,我們需要使用 Vitis Compiler 將 RTL kernel 編譯成可集成進(jìn)Vitis Flow 的 kernel.xo 文件。Xilinx DPU 在官方 kv260 例程中有提供生成 kernel.xo 的流程,參考鏈接為:https://github.com/Xilinx/kv260-vitis。

Device Build Process

圖:Vitis Linker 鏈接 Platform 和 PL Kernels

準(zhǔn)備好 Target Platform 和 PL kernels 后,最后使用 vitis V++ 命令將 Platform 和 PL kernel 鏈接起來并生成最后的 .xclbin 文件。

本方案中使用的整個(gè)Vitis Flow 流程可以參考:

https://github.com/PhigentRobotics/Phigent_Heimdallr

在該 git repository 中,已通過自動(dòng)化腳本將整個(gè) vitis flow 全部打包完成,用戶使用 make overlay OVERLAY=heimdallr 命令后就能自動(dòng)跑完整個(gè) vitis flow 流程并生成上板所需的 bit 文件和 xclbin文件。

3

軟件配套程序開發(fā)

軟件配套開發(fā)主要包括片上 linux 系統(tǒng)、 PS端應(yīng)用軟件、PC端應(yīng)用軟件的開發(fā)。

Linux 系統(tǒng)開發(fā):

我們使用 Xilinx 官方提供的 petalinux 工具來為開發(fā)板量身定制 uboot、kernel、rootfs。

首先我們需要?jiǎng)?chuàng)建 petalinux工程,使用如下命令,template 參數(shù)表明創(chuàng)建的 petalinux 工程使用的平臺模板,從k26開發(fā)板bsp文件導(dǎo)入。

? petalinux-create -t project xilinx-k26-starterkit-v2021.1-final.bsp -n (工程名字)

接著我們需要導(dǎo)入 vivado 工程中生成的bit等,利用petalinux-create創(chuàng)建fpga app。

? petalinux-create -t apps --template fpgamanager -n

在本方案中,我們修改的主要是 device tree 和 kernel 文件。在 FPGA工程中我們使用了定制化的 image processing IP 對圖像進(jìn)行前處理,所以需要配置相對應(yīng)的驅(qū)動(dòng)文件。使用如下命令來配置 linux 內(nèi)核。

? petalinux-config -c kernel

設(shè)備樹文件需要修改 petalinux 工程中生成的 dtsi 文件。在該文件中加入 image processing IP 的設(shè)備描述。

配置完成后,執(zhí)行如下命令進(jìn)行編譯:

? petalinux-build

編譯完成后使用前面生成的所有文件和 bit 文件生成 BOOT.BIN 文件。

? petalinux-package --boot --fsbl --fpga --u-boot --force

最后生成鏡像文件

? petalinux-package --wic --bootfiles "ramdisk.cpio.gz.u-boot boot.scr Image system.dtb BOOT.BIN" --wic-extra-args "-c xz"

鏡像文件會(huì)保存在build/images/目錄下,文件名為petalinux-sdimage.wic.xz

PS應(yīng)用程序開發(fā):

由于本方案采用的是 PS 和 PL 部分協(xié)同工作的模式,PS 側(cè)需要調(diào)度 PL 側(cè)的 MIPI Controller、Image Processor、Correlation IP 和 DPU 來完成整個(gè)雙目立體視覺方案的實(shí)施。

圖像獲取:

基于V4L2框架接口初始化mipi、Image Processor等,分別獲取兩路sensor圖像,通過時(shí)間戳進(jìn)行雙目圖像同步。

算法計(jì)算:

Xilinx Vitis AI 框架下,將左右camera圖像送入模型進(jìn)行推理,得到視差結(jié)果。

1. 左右圖像分別做圖像預(yù)處理,包括圖像極線對齊,從圖像中切割出感興趣區(qū)域等。

2. 然后左右圖分別送入網(wǎng)絡(luò)提取特征。

3. 再做correlation計(jì)算后送入網(wǎng)絡(luò)進(jìn)行視差預(yù)測。

Correlation IP調(diào)用:

應(yīng)用程序利用xrt運(yùn)行時(shí)庫與correlation ip進(jìn)行交互,將運(yùn)算輸入數(shù)據(jù)的地址和輸出數(shù)據(jù)地址設(shè)置到correlation ip寄存器,等計(jì)算完畢后將輸出結(jié)果送入解碼網(wǎng)絡(luò)。

PC端應(yīng)用軟件開發(fā):

PC端的應(yīng)用程序需要通過網(wǎng)口接收來自 FPGA 開發(fā)板生成的前處理后的左右原圖,以及顯示最后生成的深度圖。

依賴三方庫

1. Grpc

2. Protobuf

3. Qt5

4. OSG (Open Scene Graph)

雙目設(shè)備用戶開發(fā)SDK:基于grpc、protobuf與PS側(cè)grpc server通信,從設(shè)備獲取校正后圖像和視差圖,經(jīng)過同步后同時(shí)給到應(yīng)用程序。

PC端應(yīng)用程序:基于Qt5設(shè)計(jì)界面程序,使用雙目設(shè)備用戶開發(fā)SDK從設(shè)備獲取圖像和結(jié)果

4

方案部署及運(yùn)行

硬件準(zhǔn)備:

? FPGA 開發(fā)板:Xilinx KV260 或者 Phigent Heimdallr-DEB (非官方開發(fā)板,如有需要請單獨(dú)聯(lián)系)

? TF SD 卡 及配套的讀卡器

? Micro USB 線,網(wǎng)線

? Ubuntu 系統(tǒng) PC

? 安裝有 Vivado 2021.1 和 Vitis 2021.1 的服務(wù)器

SD卡文件準(zhǔn)備:

Git 路徑:

https://github.com/PhigentRobotics/Heimdallr_software

該 git repo 包含F(xiàn)PGA板卡上的可執(zhí)行應(yīng)用程序、BOOT 文件、PC端的應(yīng)用程序、BSP文件、模型等。根據(jù) git repo 里 README的描述,將鏡像文件下載至 SD 卡內(nèi)。同時(shí)將 boot_fs 內(nèi)的文件都放入 SD 文件夾內(nèi)。

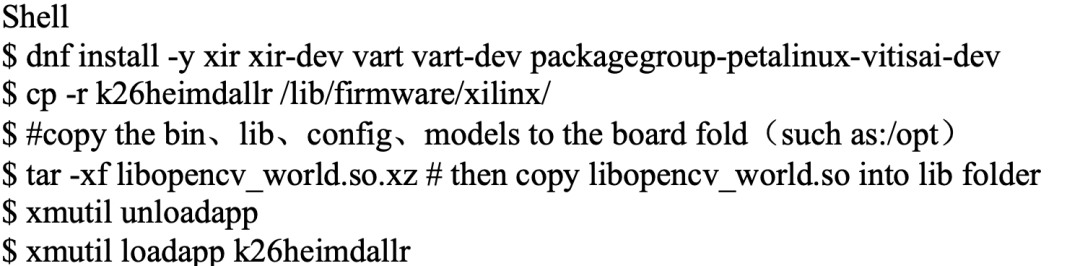

軟件配置:

將 heimdallr-hmi-bin.tgz 文件解壓至 Ubuntu PC 上,該應(yīng)用程序用于獲取左右圖和最后輸出的深度圖的顯示。

在 FPGA 的片上系統(tǒng)上安裝 vitis ai 相關(guān)環(huán)境,將模型文件,配置文件等拷貝到相應(yīng)文件夾。

程序運(yùn)行:

On board(for kv260):

1.cd /opt/

2.sh bin/run_heimdallr-app_playback.sh & # kv260 development kits

On board(for heimdalr-DEB):

3.cd /opt/

4.sh bin/bin/run_heimdallr-app.sh & # Heimdallr-DEB development kits

On PC:

5. cd heimdallr-hmi-bin

6. ./AppRun.sh

審核編輯 :李倩

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4764瀏覽量

100542 -

算法

+關(guān)注

關(guān)注

23文章

4600瀏覽量

92646 -

Xilinx

+關(guān)注

關(guān)注

71文章

2164瀏覽量

121013

原文標(biāo)題:基于Xilinx KV26的立體視覺匹配方案

文章出處:【微信號:vision263com,微信公眾號:新機(jī)器視覺】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

雙目立體視覺原理大揭秘(一)

雙目立體視覺原理大揭秘(二)

基于立體視覺的變形測量

雙目立體視覺的運(yùn)用

雙目立體視覺在嵌入式中有何應(yīng)用

基于HALCON的雙目立體視覺系統(tǒng)實(shí)現(xiàn)

圖像處理基本算法-立體視覺

Humanplus人加為各類機(jī)器人提供立體視覺感知解決方案

雙相機(jī)立體視覺和結(jié)構(gòu)光立體視覺原理及優(yōu)勢對比

雙目立體計(jì)算機(jī)視覺的立體匹配研究綜述

基于Xilinx KV26的立體視覺匹配方案

雙目立體視覺原理 HALCON的雙目視覺系統(tǒng)研究

立體視覺系統(tǒng)的設(shè)計(jì)方案

基于Xilinx KV26的立體視覺匹配方案

基于Xilinx KV26的立體視覺匹配方案

評論