Human-Object Interaction (HOI) Detection Background and Motivations

HOI Detection要求定位出存在交互的人、物并給出兩者之間的動(dòng)作關(guān)系,即最終要求給出三元組$$。實(shí)際的HOI系統(tǒng)執(zhí)行以人為中心的場景理解,因此有著廣泛的用途,例如監(jiān)控事件監(jiān)測和機(jī)器人模仿學(xué)習(xí)。

傳統(tǒng)的HOI范式傾向于以多階段的方式來解決這個(gè)有挑戰(zhàn)性的復(fù)雜問題,即先執(zhí)行object detection,再執(zhí)行動(dòng)作關(guān)系的分類,這種范式需要繁重的后處理(post-processing),例如啟發(fā)式匹配來完成任務(wù),這導(dǎo)致其無法以端到端的方式進(jìn)行training,導(dǎo)致了次優(yōu)的性能。

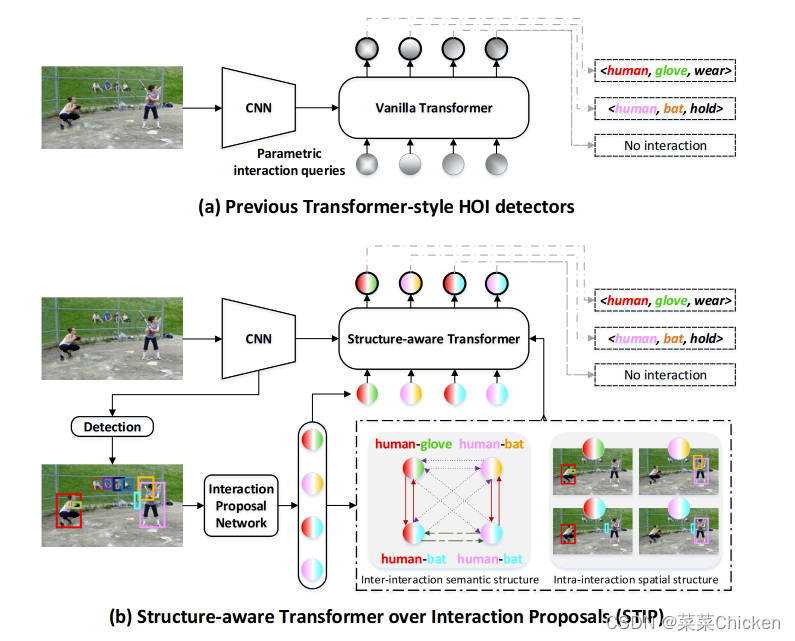

最近sota的一系列HOI方法往往受啟發(fā)于DETR,將HOI Detection視為集合預(yù)測問題來克服這一問題,實(shí)現(xiàn)end-to-end的訓(xùn)練優(yōu)化,這類方法的基本流程如下圖(a)中所示,可以看出,這類方法往往利用transformer來將可學(xué)習(xí)的queries映射為HOI的預(yù)測集合,從而實(shí)現(xiàn)one-stage的HOI detection

然而,這些HOI檢測范式中的parametric interaction queries(參數(shù)化的交互queries)往往是隨機(jī)初始化的,這就導(dǎo)致范式中的queris和輸出HOI 預(yù)測之間的對應(yīng)關(guān)系是動(dòng)態(tài)的,其中對應(yīng)于每個(gè)目標(biāo)HOI三元組的query,例如$$,在預(yù)測開始時(shí)往往是未知的,這將嚴(yán)重影響模型去探索先驗(yàn)知識(shí),即inter-interaction 或 intra-interaction structure,即交互間的結(jié)構(gòu)性關(guān)系和交互內(nèi)的結(jié)構(gòu)性關(guān)系知識(shí),而這對于交互間的關(guān)系reasoning是非常有幫助的。

(a)之前的Transformer風(fēng)格的HOI檢測范式(b)本文方法示意圖

Inter&Intra-interaction Structure For HOI Detection

交互間的結(jié)構(gòu)性(Inter-interaction Structure)非常有助于互相提供線索來提高檢測效果,例如上圖中“human wear (baseball) glove” 就提供了非常強(qiáng)的線索來提示另一個(gè)interaction:“human hold bat”,有趣的是,內(nèi)部交互結(jié)構(gòu)(Intra-interaction Structure)可以解釋為每個(gè)HOI三元組的局部空間結(jié)構(gòu),例如人和物體的布局結(jié)構(gòu)以一種額外的先驗(yàn)知識(shí)來將model的注意力引導(dǎo)到有效的圖像區(qū)域,從而描述交互行為。

STIP : Structure-aware Transformer over Interaction Proposals

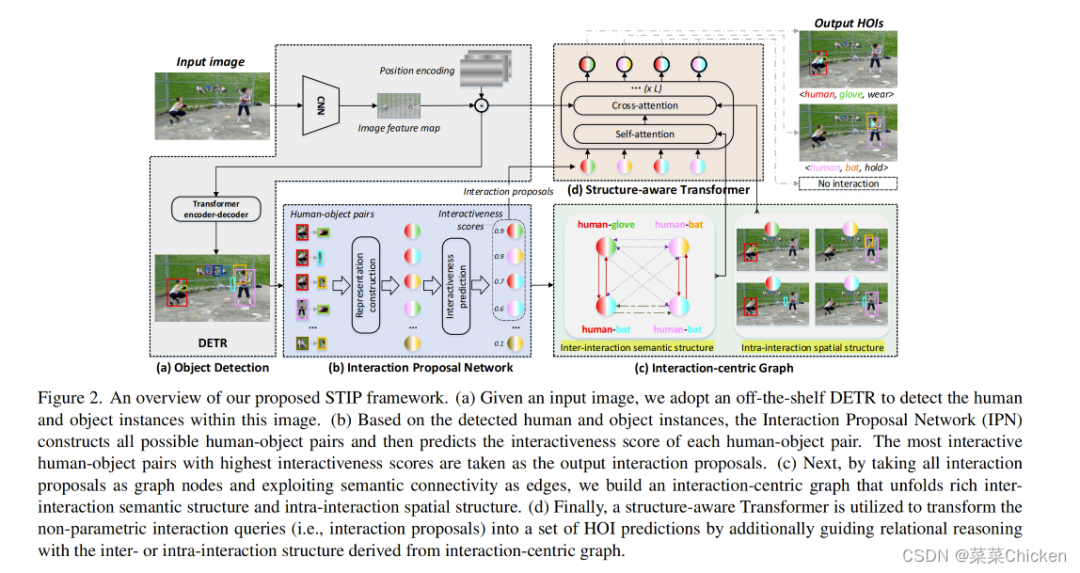

講了背景知識(shí)和基本的motivations,終于步入正題了,作者提出的方法叫做STIP( Structure-aware Transformer over Interaction Proposals),其將一階段的HOI檢測方案分解為了兩階段的級聯(lián)pipeline:首先產(chǎn)生交互proposals(有可能存在交互的人-物對),接著基于這些proposal 執(zhí)行HOI集合預(yù)測,如上圖中所示,STIP將這些proposal視為非參交互queries,從而啟發(fā)后續(xù)的HOI集合預(yù)測問題,也可以將其視為靜態(tài)的、query-based的HOI檢測pipeline。

下面將分別介紹Interaction Proposal Network 、Interaction-centric Graph和Structure-aware Transformer。

STIP整體流程示意圖

Interaction Proposal Network

STIP利用DETR作為物體(和人)檢測的base network,訓(xùn)練過程中,DETR部分的權(quán)重是凍住的,不進(jìn)行學(xué)習(xí),基于DETR給出的檢測結(jié)果,Interaction Proposal Network(IPN)將構(gòu)建存在潛在交互的的human-object對,對于每個(gè)human-object對,IPN將通過MLP給出潛在交互的分?jǐn)?shù),即 interactiveness score。只有Top-K個(gè)最高得分的human-object對將送入下一階段。

Human-Object Pairs Construction

STIP為了充分利用knowledge,從不同的信息層次來構(gòu)建Human-Object對,每個(gè)HO對都由外觀特征、空間特征、和語言學(xué)特征(linguistic features)來構(gòu)成。具體來說,外觀特征是從DETR中得到的human和object實(shí)例特征來構(gòu)建,即分類頭前的、256通道維度的區(qū)域特征(即ROI區(qū)域特征)。我們將human和object的bounding box定義為: and ,則空間特征由

來構(gòu)建,其中,則分別代表了人的區(qū)域,物體的區(qū)域,交叉的區(qū)域和聯(lián)合bounding box的區(qū)域信息。語言學(xué)特征則是將bounding box的類別名編碼為one-hot向量,向量的通道維度大小為300。每個(gè)HO對都將被如上方式進(jìn)行表征,最終concat到一起,送入MLP中。

Interactiveness Prediction

構(gòu)建Human-Object Pairs 后,將構(gòu)建出的Human-Object Pairs 經(jīng)過hard mining strategy(難樣本挖掘策略)來篩選出負(fù)樣本,正樣本則是由置信度大于0.5的human和object的bounding box IOUs組成。STIP需要預(yù)測出每個(gè)proposal成立的可能度,因此將其視為一個(gè)二分類問題,從而利用Focal loss來進(jìn)行優(yōu)化。在推理階段,只有top-K個(gè)最高得分的human-object 對將被送入下個(gè)階段作為交互proposal。

Interaction-Centric Graph

利用IPN來篩選出潛在的proposal后,接著STIP利用Interaction-Centric Graph來充分利用豐富的inter-interaction和intra-interaction structure的先驗(yàn)知識(shí),在實(shí)際實(shí)現(xiàn)中,將每個(gè)interaction proposal作為一個(gè)單一的graph node(圖節(jié)點(diǎn)),因此完整的interaction-centric graph利用每兩個(gè)nodes之間的連接來作為圖的edge。

Exploit Inter-interaction in Interaction-Centric Graph

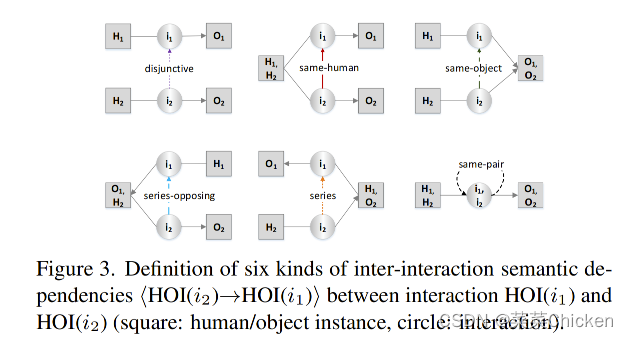

回到本文開頭提到的motivation:交互間的結(jié)構(gòu)性(Inter-interaction Structure)非常有助于互相提供線索來提高檢測效果,舉個(gè)栗子,當(dāng)圖中有一個(gè)interaction為 human hold mouse,那么很有可能圖中還有另一個(gè)相同human instance的interaction:human look-at screen。這個(gè)有趣的先驗(yàn)現(xiàn)象啟發(fā)了作者構(gòu)建一個(gè)graph來充分利用該prior的知識(shí)。作者定義了下圖所示的六種交互間的關(guān)系來充分利用該先驗(yàn):

這六種類間語義關(guān)系由兩個(gè)交互proposal之間是否共享相同的humanobject來被具體指派。

Exploit Intra-interaction in Interaction-Centric Graph

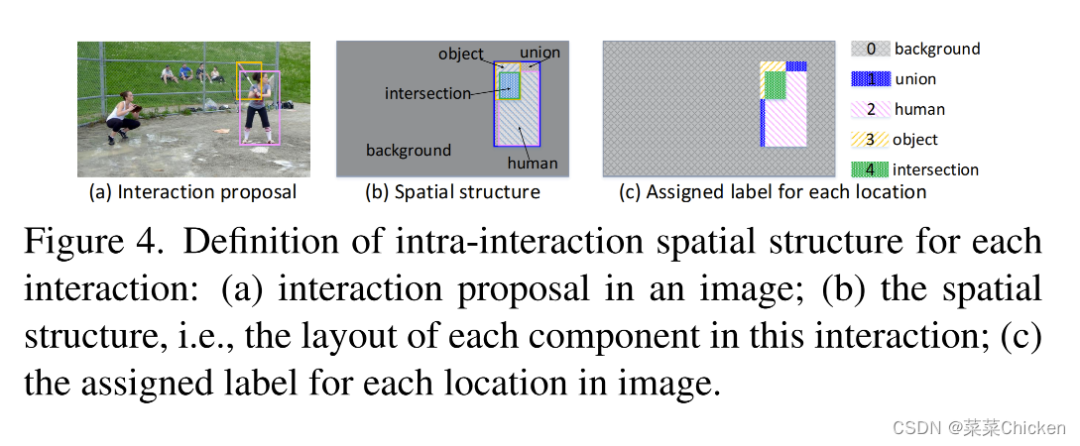

接著我們看本文開頭提到的另一條motivation:內(nèi)部交互結(jié)構(gòu)(Intra-interaction Structure)可以解釋為每個(gè)HOI三元組的局部空間結(jié)構(gòu),例如人和物體的布局結(jié)構(gòu)以一種額外的先驗(yàn)知識(shí)來將model的注意力引導(dǎo)到有效的圖像區(qū)域。 STIP也通過分類、編碼來利用interaction內(nèi)的空間關(guān)系,如下圖所示:

將背景、union、human、object、intersection分別進(jìn)行轉(zhuǎn)換編碼,從而將spatial layout structures編碼進(jìn)features中,參與特征交互。

Structure-aware Self-attention & Structure-aware Cross-attention

Structure-aware Self-attention & Structure-aware Cross-attention和傳統(tǒng)的self- attention基本類似,就不細(xì)講了~其中值得注意的是,作者受相對位置編碼的啟發(fā),將每個(gè)key 與其的 inter-interaction semantic dependency 結(jié)合:

Training Objective

針對action的監(jiān)督,也是利用folcal loss:

Experiments

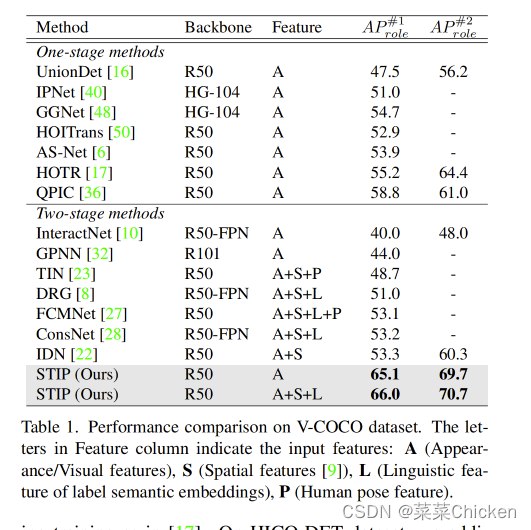

可以看出,在VCOCO數(shù)據(jù)集上,STIP的性能非常強(qiáng)勁,比之前的IDN高了十幾個(gè)點(diǎn),HICO-DET上的性能也很強(qiáng)。

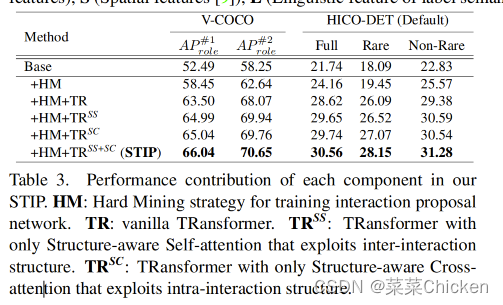

Ablation Study

從消融實(shí)驗(yàn)中可以看出, inter-interaction 和intra-interaction的相關(guān)module都非常漲點(diǎn),

Conclusion

STIP不同與以往的query-based 范式,將proposal set prediction拆開為兩個(gè)stage,第一個(gè)stage產(chǎn)生高質(zhì)量的queries,其中融合了豐富、多樣的的prior features來充分利用背景知識(shí),從而有了非常驚艷的性能效果。

審核編輯:劉清

-

編碼器

+關(guān)注

關(guān)注

45文章

3595瀏覽量

134159 -

ROI

+關(guān)注

關(guān)注

0文章

14瀏覽量

6226 -

MLP

+關(guān)注

關(guān)注

0文章

57瀏覽量

4229

原文標(biāo)題:CVPR2022 人-物交互檢測中結(jié)構(gòu)感知轉(zhuǎn)換

文章出處:【微信號:GiantPandaCV,微信公眾號:GiantPandaCV】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

人機(jī)交互界面設(shè)計(jì)在產(chǎn)品設(shè)計(jì)中的應(yīng)用

【設(shè)計(jì)技巧】rtos的核心原理簡析

怎樣去設(shè)計(jì)一種基于物聯(lián)網(wǎng)感知的家居人體健康狀況檢測系統(tǒng)

如何去實(shí)現(xiàn)一種基于物聯(lián)網(wǎng)感知的家居人體健康狀況檢測系統(tǒng)設(shè)計(jì)

CVPR2022 人-物交互檢測中結(jié)構(gòu)感知轉(zhuǎn)換相關(guān)資料推薦

OpenHarmony應(yīng)用核心技術(shù)理念與需求機(jī)遇簡析

EPON技術(shù)簡析

鼠標(biāo)HID例程(中)簡析

工業(yè)機(jī)器人技術(shù)特點(diǎn)現(xiàn)狀情況及技術(shù)趨勢簡析

簡析555電壓檢測電路資料下載

簡析電動(dòng)汽車充電樁檢測技術(shù)應(yīng)用及分析

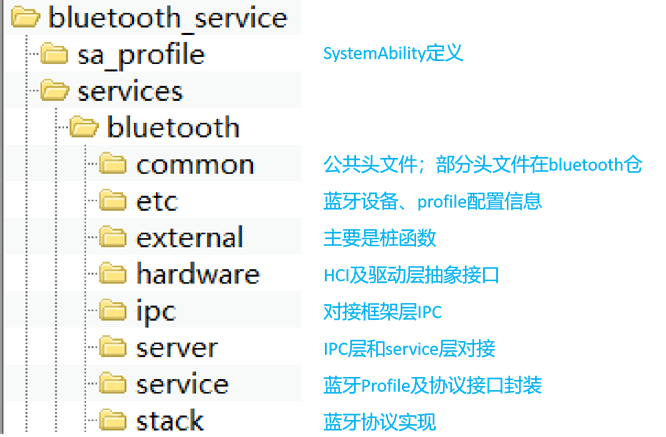

【鴻蒙】OpenHarmony 4.0藍(lán)牙代碼結(jié)構(gòu)簡析

簡析智慧燈桿一鍵告警功能的實(shí)用場景

一文簡析人-物交互檢測中結(jié)構(gòu)感知轉(zhuǎn)換

一文簡析人-物交互檢測中結(jié)構(gòu)感知轉(zhuǎn)換

評論