從新興技術轉變為AI基礎設施,大模型開源很重要,但也很難。

2020年6月,OpenAI發布GPT-3,其千億參數的規模和驚人的語言處理能力曾給國內AI界帶來極大的震動。但由于GPT-3未對國內開放,一批提供文本生成服務的商業公司在海外誕生時,我們只能望洋興嘆。

今年8月,倫敦的開源公司Stability AI發布文生圖模型Stable Diffusion,并免費開源了模型的權重和代碼,這迅速引發了AI作畫應用在全球范圍內的爆炸式增長。

可以說,今年下半年的AIGC熱潮,開源起到了直接的催化作用。

而當大模型成為所有人都能參與的游戲時,得益的并不僅僅是AIGC。

1 大模型開源進行時

四年前,一個名為BERT的語言模型問世,以3億的參數量從此改變了AI模型的游戲規則。

今天,AI模型的體量已經躍升至萬億的規模,但大模型的“壟斷性”也隨之日益凸顯:

大公司、大算力、強算法、大模型,它們共同堆砌了一道普通開發者和中小企業難以闖進的圍墻。

技術壁壘,以及訓練和使用大模型所需的計算資源和基礎設施,阻礙了我們從「煉」大模型走向「用」大模型的這條路。因此,開源迫在眉睫。通過開源讓更多人參與大模型的這場游戲,將大模型從一種新興的AI技術轉變為穩健的基礎設施,這正在成為許多大模型締造者的共識。

也是在這樣的共識下,前不久阿里巴巴達摩院在云棲大會上推出的中文模型開源社區“魔搭”(ModelScope)在AI界引起了很大的關注,目前國內的一些機構已經開始在該社區上貢獻模型,或是建立自己的開源模型體系。

國外的大模型開源生態建設目前來看要領先于國內。Stability AI是私營公司出身但自帶開源基因,有自己龐大的開發者社區,在開源的同時還有穩定的盈利模式。

今年7月發布的BLOOM有1760億參數,是目前最大的開源語言模型,它背后的BigScience更是完美契合了開源精神,從頭到腳透露著與科技巨頭對弈的氣勢。BigScience由Huggingface帶頭發起的開放式協作組織,并非正式成立的實體,BLOOM的誕生,是來自70多個國家的1000多名研究人員在超級計算機上訓練了117天的結果。

另外,科技巨頭也并非沒有參與大模型的開源。今年5月,Meta開源了1750億參數的大模型OPT,除了允許OPT可被用于非商業用途外,還發布了其代碼以及記錄培訓過程的100頁日志,可謂開源得十分徹底。

研究團隊在OPT的論文摘要里直截了當地指出,「考慮到計算成本,如果沒有大量資金,這些模型是很難復制的。對于少數可通過API獲得的模型,無法訪問完整的模型權重,這致它們難以得到研究」。模型的全稱「Open Pre-trained Transformers」也表明了Meta的開源態度。這可以說是暗諷了一把由并不「Open」的OpenAI發布的GPT-3(僅提供API付費服務)、以及今年4月谷歌推出的5400億參數大模型PaLM(未開源)。

在壟斷色彩一向濃厚的大廠中,Meta這番開源的舉動是一股清流。當時斯坦福大學基礎模型研究中心的負責人Percy Liang評價道:「這是朝著開辟研究新機遇邁出的令人興奮的一步,一般而言,我們可以認為更強的開放能夠使研究人員得以解決更深層次的問題。」

2 大模型的想象力不應止于AIGC

Percy Liang的這句話這也從學術層面回答了為何大模型一定要做開源的問題。

原創成果的誕生,需要開源來提供土壤。

一個研發團隊訓練出一個大模型,如果止步于在頂級會議上發表一篇論文,那么其他研究人員得到的就只是論文中各種「秀肌肉」的數字,而看不到模型訓練技術的更多細節,只能花時間去復現,還不一定能復現成功。可復現性是科學研究結果可靠、可信的一個保證,有了開放的模型、代碼和數據集,科研人員便能更及時地跟上最前沿的研究,站在巨人的肩膀上去觸及一顆更高處的果實,這可以省下許多時間成本、加快技術創新的速度。

國內在大模型工作上的原創力不足,就主要體現為盲追模型尺寸、但在底層架構上無甚創新,這是從事大模型研究的業內專家的普遍共識。

清華大學計算機系的劉知遠副教授向AI科技評論指出:國內在大模型的架構上有一些相對比較創新的工作,但基本上都還是以Transformer為基礎,國內還比較缺乏像Transformer這種奠基式架構,以及BERT、GPT-3這樣能夠引起領域大變革的模型。

IDEA研究院(粵港澳大灣區數字經濟研究院 )的首席科學家張家興博士也告訴AI科技評論,從百億、千億到萬億,我們突破了各種系統上、工程上的挑戰后,應該要有新的模型結構方面的思考,而不再是單純地把模型做大。

另一方面,大模型在技術上要取得進步,還需有一套模型評估標準,標準的產生則要求公開和透明。最近的一些研究正在試圖對眾多大模型提出各種評估指標,但有一些優秀的模型由于不可訪問而被排除在外,如谷歌在其Pathways架構下訓練的大模型PaLM具備超強的語言理解能力,能輕松解釋笑話的笑點,還有DeepMind的語言大模型Chinchilla,都沒有開源。

但無論是從模型本身的出色能力還是從這些大廠的地位來看,它們都本不該缺席這樣的公平競技場。

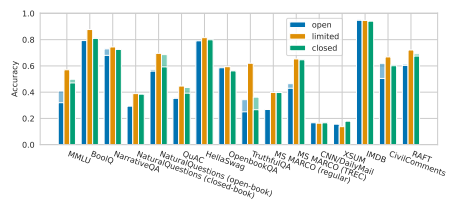

一個令人遺憾的事實是,Percy Liang最近與其同事合作的一項研究表明,與非開源模型相比,目前的開源模型在許多核心場景上的表現都存在一定的差距。如OPT-175B、BLOOM-176B以及來自清華大學的GLM-130B等開源大模型,在各項任務上幾乎全面輸給了非開源的大模型,后者包括OpenAI的InstructGPT、Microsoft/NVIDIA的TNLG-530B等等(如下圖)。

圖注:Percy Liang et al. Holistic Evaluation of Language Models

要消解這種尷尬局面,需要各個領頭羊們開源開放自家的優質大模型,這樣大模型領域的整體進展才能更快地上一個臺階。

在大模型的產業落地方面,開源更是一條必經之路。

若以GPT-3的發布為起點,大模型經過兩年多的你追我趕,在研發技術上已經較為成熟,但在全球范圍內,大模型的落地都還處于早期階段。國內各個大廠所研發的大模型固然有內部業務的落地場景,但整體上尚未有成熟的商業化模式。

在大模型落地正處蓄勢待發之時,做好開源能夠為將來大規模的落地生態打好基礎。

大模型的本質決定了落地對開源的需求。阿里巴巴達摩院副院長周靖人告訴AI科技評論,「大模型是對人類知識體系的抽象與提煉,所以它能夠應用的場景和產生的價值是巨大的。」而只有通過開源,大模型的應用潛力才能在眾多有創造力的開發者那里得到最大限度的釋放。

這是封閉了大模型內部技術細節的API模式所無法做到的。首先,這種模式的適用對象是低開發能力的模型使用者,對他們而言,大模型落地的成敗相當于完全掌握在研發機構的手中。

以提供大模型API付費服務的最大贏家OpenAI為例,據OpenAI的統計,目前全世界已經有300多個使用了GPT-3技術的應用程序,但這個事實的前提是OpenAI的研發實力底氣足、GPT-3也足夠強大。如果模型本身性能不佳,那么這類開發者也就束手無策了。

更關鍵的是,大模型通過開放API所能提供的能力有限,難以承接復雜多樣的應用需求。目前在市場上只是催生出一些具有創意的APP,但整體上還處于一種「玩具」的階段,遠沒有達到大規模產業化的地步。

「產生的價值沒有那么大,成本又收不回來,所以基于GPT-3 API的應用場景非常受限,很多工業界的人其實并不認可這種方式。」張家興說道。的確,像國外的copy.ai、Jasper這些公司是選擇做AI輔助寫作業務,用戶市場相對更大,所以才能產生比較大的商業價值,而更多應用還只是小打小鬧。

相比之下,開源開放做的是「授人以漁」。

在開源模式下,企業憑借公開的源代碼,在已有的基礎框架上進行符合自己業務需求的訓練、二次開發,這能夠發揮大模型的通用性優勢,釋放遠超于現在的生產力,最終帶來大模型技術在產業中的真正落地。

作為目前大模型商業化落地最清晰可見的一條賽道,AIGC的這一波起飛已經印證了大模型開源模式的成功,然而在其他更多應用場景上,大模型的開源開放仍屬少數,國內外皆是如此。西湖大學深度學習實驗室的負責人藍振忠曾向AI科技評論表示,目前大模型的成果雖然有很多,但開源極少,普通研究者的訪問有限,這一點很令人惋惜。

貢獻、參與、協作,以這些關鍵詞為核心的開源,能夠匯聚大量懷抱熱情的開發者,共同打造一個可能具有變革意義的大模型項目,讓大模型更快地從實驗室走向產業。

3 不可承受之重:算力

大模型開源的重要性是共識,但通往開源的路上還有一個巨大的攔路虎:算力。

這也正是當前大模型落地所面臨的最大挑戰。即便Meta開源了OPT,但到目前為止它似乎還沒有在應用市場上泛起大的漣漪,究其根本,算力成本仍然是小型開發者的不可承受之重,先不說對大模型做微調、二次開發,僅僅是做推理都很困難。

正因如此,在對拼參數的反思潮下,不少研發機構轉向了做輕量模型的思路,將模型的參數控制在幾億至幾十億之間。瀾舟科技推出的「孟子」模型、IDEA研究院開源的「封神榜」系列模型,都是國內走這條路線的代表。他們將超大模型的各種能力拆分到參數相對更小的模型上,已經在一些單項任務上證明了自身超越千億模型的能力。

但毫無疑問,大模型的路必然不會就此停下,多位業內專家都向AI科技評論表示,大模型的參數依然有上升空間,肯定還要有人去繼續探索更大規模的模型。所以我們不得不直面大模型開源后的窘境,那么,有哪些解決辦法?

我們首先從算力本身的角度來考慮。未來大規模計算機群、算力中心的建設肯定是一個趨勢,畢竟端上的計算資源終歸難以滿足需求。但如今摩爾定律已經趨緩,業界也不乏摩爾定律將要走向終結的論調,如果單純地寄希望于算力的提升,是遠水解不了近渴。

「現在一張卡可以跑(就推理而言)一個十億模型,按目前算力的增長速度,等到一張卡可以跑一個千億模型也就是算力要得到百倍提升,可能需要十年。」張家興解釋。

大模型的落地等不了這么久。

另一個方向是在訓練技術上做文章,加快大模型推理速度、降低算力成本、減少能耗,以此來提高大模型的易用性。

比如Meta的OPT(對標GPT-3)只需要16塊英偉達v100 GPU就可以訓練和部署完整模型的代碼庫,這個數字是GPT-3的七分之一。最近,清華大學與智譜AI聯合開源的雙語大模型GLM-130B,通過快速推理方法,已經將模型壓縮到可以在一臺A100(40G*8)或V100(32G*8)服務器上進行單機推理。

在這個方向上努力當然是很有意義的,大廠們不愿意開源大模型一個不言自明的原因,就是高昂的訓練成本。此前有專家估計,GPT-3的訓練使用了上萬塊英偉達v100 GPU,總成本高達2760萬美元,個人如果要訓練出一個PaLM也要花費900至1700萬美元。大模型的訓練成本若能降下來,自然也就能提高他們的開源意愿。

但歸根結底,這只能從工程上對算力資源的約束起到緩解作用,而并非終極方案。盡管目前許多千億級、萬億級的大模型已經開始宣傳自己的「低能耗」優勢,但算力的圍墻仍然太高。

最終,我們還是要回到大模型自身尋找突破點,一個十分被看好的方向便是稀疏動態大模型。

稀疏大模型的特點是容量非常大,但只有用于給定任務、樣本或標記的某些部分被激活。也就是說,這種稀疏動態結構能夠讓大模型在參數量上再躍升幾個層級,同時又不必付出巨大的計算代價,一舉兩得。這與GPT-3這樣的稠密大模型相比有著極大的優勢,后者需要激活整個神經網絡才能完成即使是最簡單的任務,資源浪費巨大。

谷歌是稀疏動態結構的先行者,他們于2017年首次提出了MoE(Sparsely-Gated Mixture-of-Experts Layer,稀疏門控的專家混合層),去年推出的1.6萬億參數大模型Switch Transformers就融合了MoE風格的架構,訓練效率與他們之前的稠密模型T5-Base Transformer相比提升了7倍。

而今年的PaLM所基于的Pathways統一架構,更是稀疏動態結構的典范:模型能夠動態地學習網絡中的特定部分擅長何種任務,我們根據需要調用經過網絡的小路徑即可,而無需激活整個神經網絡才能完成一項任務。

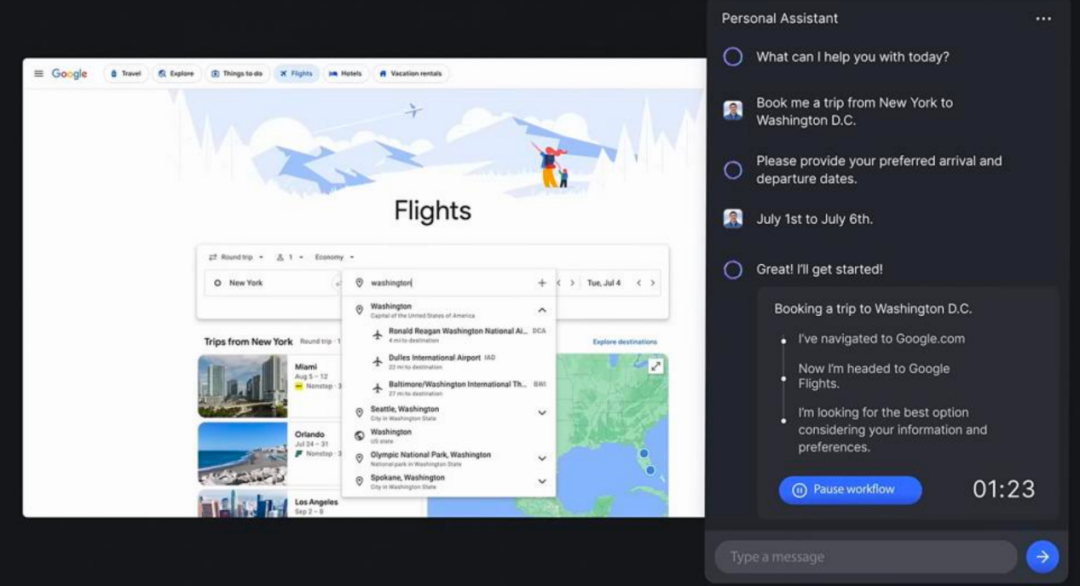

圖注:Pathways架構

這本質上與人腦的運作方式類似,人腦中有百億個神經元,但在執行特定任務中只激活特定功能的神經元,否則巨大的能耗是人難以承受的。

大、通用,且高效,這種大模型路線無疑具有很強的吸引力。

「以后有了稀疏動態的加持,計算代價就不會那么大,但是模型參數一定會越來越大,稀疏動態結構或許會為大模型打開一個新天地,再往十萬億、百萬億走也沒問題。」張家興相信,稀疏動態結構將是解決大模型尺寸與算力代價之間矛盾的最終途徑。但他也補充說,在當下這種模型結構還未普及的情況下,再盲目將模型繼續做大確實意義不大。

目前國內在這個方向上的嘗試還比較少,且不如谷歌做得更徹底。大模型結構上的探索創新與開源相互促進,我們需要更多開源來激發大模型技術的變革。

阻礙大模型開源的,除了大模型的算力成本導致的低可用性,還有安全問題。

對于大模型尤其是生成大模型開源后帶來的濫用風險,國外擔憂的聲音似乎更多,爭議也不少,這成了許多機構選擇不開源大模型的憑據,但或許也是他們拒絕慷慨的一個借口。

OpenAI已經因此招致了許多批評。他們在2019年發布GPT-2時就聲稱,模型的文本生成能力過于強大,可能會帶來倫理方面的危害,因而不適合開源。一年后公開GPT-3時也僅僅提供了API試用,目前GPT-3的開源版本實際上是由開源社區自行復現的。

事實上,對大模型的訪問限制反而會不利于大模型提高穩健性、減少偏見和毒性。Meta AI的負責人Joelle Pineau在談到開源OPT的決定時,曾誠懇地表示,單靠自家團隊解決不了全部問題,比如文本生成過程中可能產生的倫理偏見和惡意詞句。他們認為,如果做足功課,就可以在負責任的情況下讓大模型變得可以公開訪問。

在防范濫用風險的同時保持開放獲取和足夠的透明度,這并非易事。作為打開了「潘多拉魔盒」的人,Stability AI享受了主動開源帶來的好名聲,但最近也遭遇了開源帶來的反噬,在版權歸屬等方面引起了爭議。

開源背后的「自由與安全」這一古老的辯證命題由來已久,或許并沒有一個絕對正確的答案,但是在大模型開始走向落地的當下,一個清楚的事實是:大模型開源,我們做得還遠遠不夠。

兩年多過去,我們已經擁有了自己的萬億級別大模型,在接下來大模型從「讀萬卷書」到「行萬里路」的轉變過程中,開源是一個必然的選擇。

最近,GPT-4正呼之欲出,所有人都對它能力上的飛躍抱著極大的期待,但我們不知道,未來它能給多少人釋放多大的生產力?

審核編輯 :李倩

-

AI

+關注

關注

87文章

30106瀏覽量

268401 -

模型

+關注

關注

1文章

3171瀏覽量

48711 -

大模型

+關注

關注

2文章

2322瀏覽量

2479

原文標題:AI 大模型開源之困:壟斷、圍墻與算力之殤

文章出處:【微信號:信息與電子工程前沿FITEE,微信公眾號:信息與電子工程前沿FITEE】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

AI大模型開源之困:壟斷、圍墻與算力之殤

AI大模型開源之困:壟斷、圍墻與算力之殤

評論