導讀:移動數據的迅速攀升、蓬勃發展的人工智能及機器學習(AI / ML)應用,以及 5G 通信對帶寬前所未有的需求,導致對現有云數據中心的服務器、存儲和網絡架構形成了巨大壓力。這些頗具挑戰性的應用需要高 I / O 帶寬和低延遲通信的支持。112G SerDes 技術具有卓越的長距性能、優秀的設計裕度、優化的功耗和面積,是下一代云網絡、AI / ML 和 5G 無線應用的理想選擇。由于更小的 UI 和更低的 SNR,在采用 112G 數據速率的過程中會遇到更大的挑戰。解決這一問題需要綜合考慮 RX / TX 規范、串擾、抖動、碼間干擾(ISI)和噪聲等多種因素,IEEE 標準也推出了通道運行裕度(COM)和有效回波損耗(ERL)作為測量標準,用于檢查高速串行系統的互操作裕度。

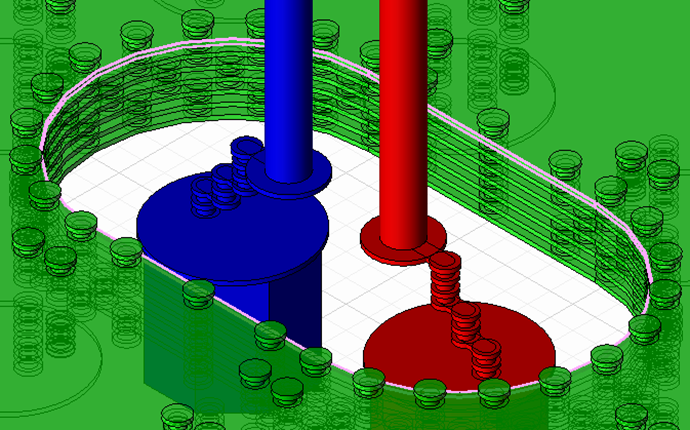

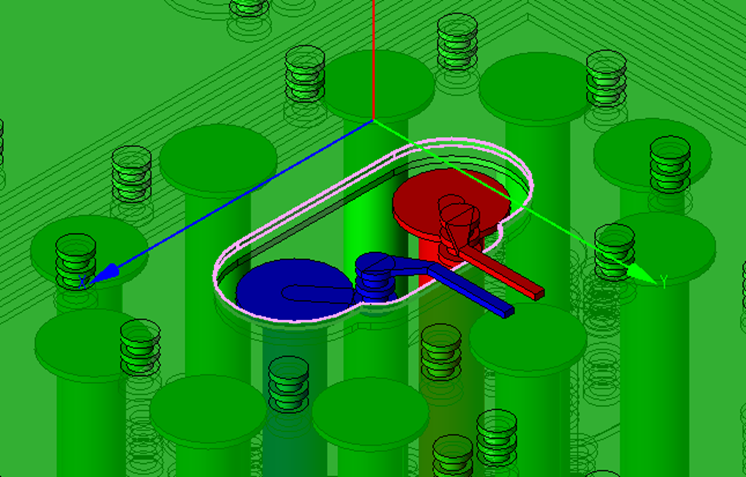

體現到信號完整性工程師的實際工作中,一項重要內容就是要分析和優化無源鏈路中的阻抗連續性和不同信號之間的串擾。封裝基板上的Core層過孔和BGA焊盤區域,是封裝上影響最大的阻抗不連續段,同時,這個區域因為有比較長的過孔縱向耦合,也是最容易引入串擾的地方,是我們需要重點優化的。本文我們將聚焦封裝Core層過孔的阻抗連續性優化。

一、封裝過孔區域的阻抗特性分析

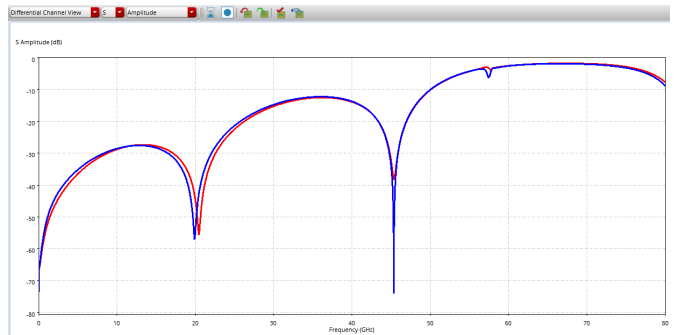

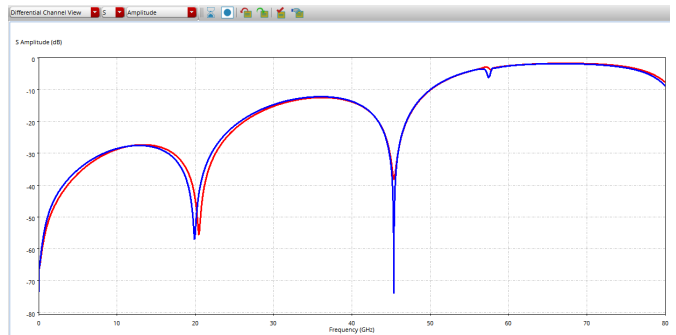

下圖是一個典型的封裝Core過孔和BGA焊盤區域的差分回波損耗結果。在奈奎斯特頻率以下的差模-差模回損都已基本控制到-20dB以下。

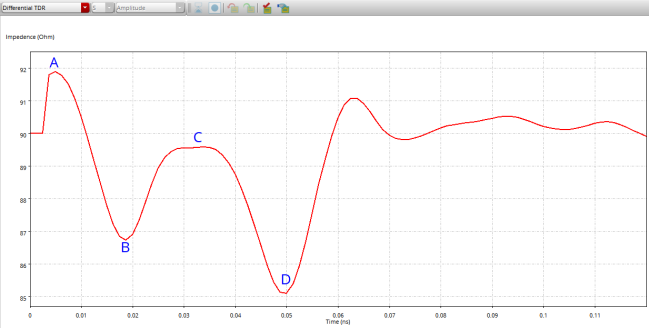

我們再看下其對應的TDR結果。可以看到實際阻抗并不是很靠近目標值90歐姆的一條直線,而是存在多個阻抗不連續點。

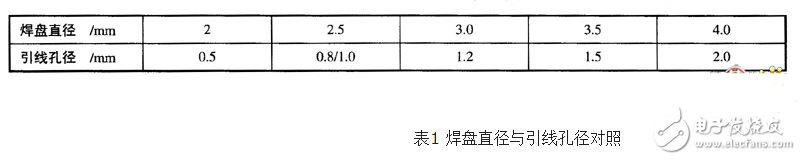

我們可以結合Layout結構來理解其中的各段阻抗變化。首先看下阻抗最低的D點,這個地方對應的是BGA焊盤區域。一般要控制差分阻抗90歐,差分走線的線寬在25-30um左右,而BGA焊盤的直徑會有500-600um,所以這里最容易出現阻抗偏低的情況,需要把相鄰的幾層平面挖空。

另外一個阻抗較低的B點是Core層過孔的焊盤位置。這個焊盤的直徑一般是250-350um,也是比走線線寬高 了一個數量級,所以這里也要對相鄰幾層的平面做挖空處理。

C點區域是Core過孔的筒身部分。這部分會根據不同的筒身高度(Core層厚度)、相鄰層挖空大小/層數、周圍回流地孔的距離/數量等體現出容性或者感性。

最開始的阻抗較大的A點是走線在回流平面挖空區域部分。這個地方因為相鄰層都挖空掉,按照差分線寬量級的寬度布線,就會出現實際阻抗比目標值高的情況。

二、封裝過孔分析案例自動化建模

如上所述,封裝Core層過孔和BGA焊盤區域的多個布線參數都會影響這段鏈路的阻抗連續性,而且鏈路上不同組件對這些參數的調整方向需求有的還相互沖突,需要綜合權衡。這么多參數需要調整,不可能把所有的組合都先在封裝工具中設計出來再逐一用仿真工具提取模型進行分析。比較常見的做法是由資深的SI工程師根據經驗判斷最關鍵的參數和大致的取值范圍,請封裝設計工程師做幾種不同的場景,然后在這基礎上把各層挖空大小做成變量進行掃描,或者根據仿真結果手動迭代調整參數。但是,這種做法存在很多限制:首先是嚴重依賴資深工程師的經驗;其次是受項目交付周期限制,實際能覆蓋到的參數組合和調整范圍空間都比較有限;最后,如果出線層、疊層、材料、管腳排布、信號速率等發生變化,這些參數調整的結論不能直接復用,重新建模分析又非常消耗時間。

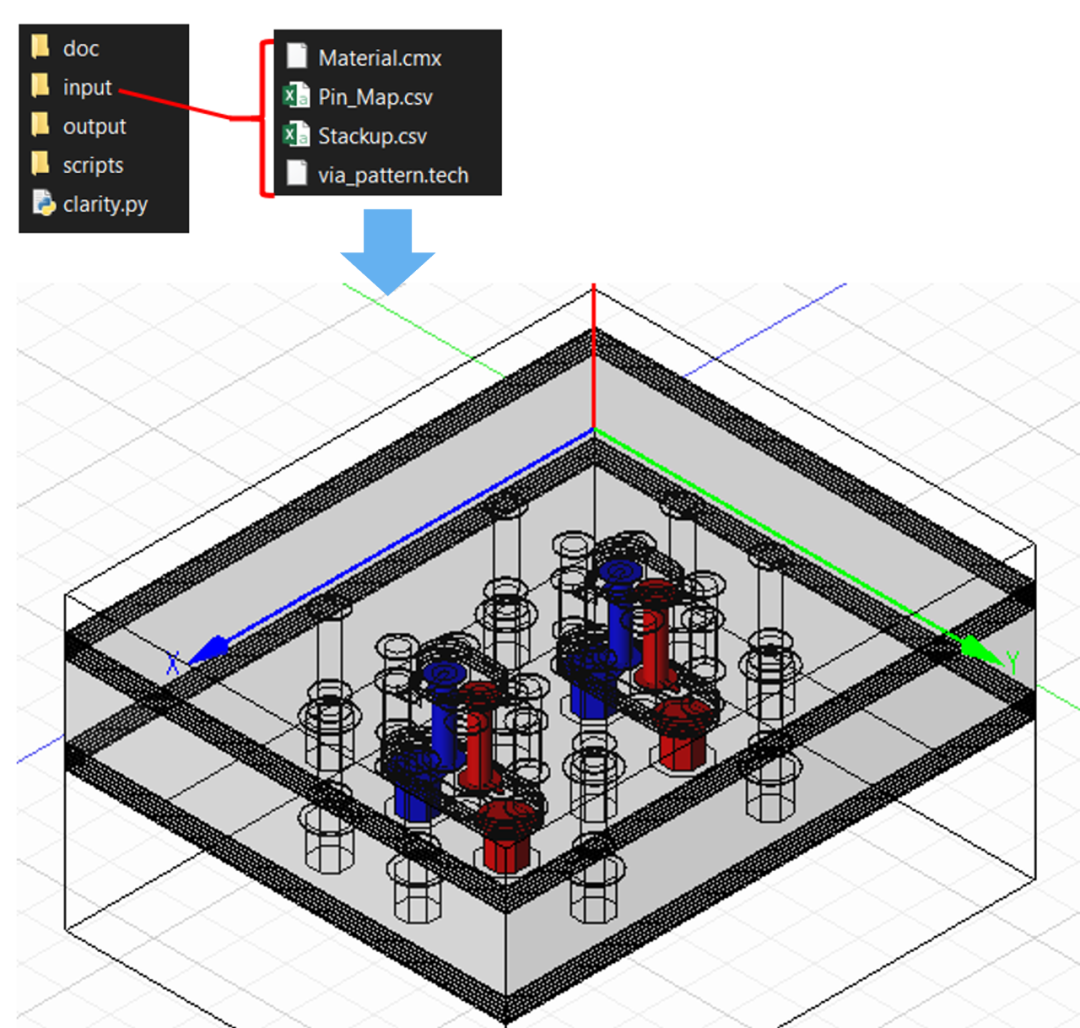

筆者的做法是利用仿真工具強大的參數表達式功能,編寫Python腳本,讀入PadStack、疊層材料、Pin Map等信息,自動創建封裝過孔優化工程,把上述各種參數,包括過孔間距、挖空區域大小、挖空層數、回流過孔方式、回流過孔距離、挖空區域走線線寬等,都在模型中做成可掃描的參數。這樣,調整參數時只要在仿真工具中修改數值,整個仿真結構也會跟著改動,不需要返回封裝設計工具進行調整,更加方便快捷。而且,不管疊層、材料、管腳排布等如何變化,只要簡單修改輸入配置文件,十分鐘就能完成新的仿真工程建模。

三、設計參數自動化/智能化調整

完成仿真工程建模后,下一步就是要調整設計樣式的選擇和各設計參數的取值,以優化阻抗連續性和串擾大小。這里會遇到一個問題,就是由于參數數量多,每個參數還有各自的取值范圍,即便SI工程師根據經驗固定某些參數的數值或者綁定不同參數同步變化進行簡化,各參數排列組合后的取值空間很可能依然是巨大的。以5個獨立變量,每個變量10個掃描數值來計算,排列組合的取值空間就達到10^5=100,000個,這個數量級根本不可能在實際項目交付過程中去遍歷。即使是每個變量只有5個掃描數值,排列組合的取值空間也達到5^5=3125個,很難遍歷完成。因此,一般的做法還是需要SI工程師手動進行”調整參數”->”仿真”->”分析結果”->”調整參數”->”仿真“的迭代,受到項目交付周期和有效仿真/分析時間的限制,實際能完成的迭代次數非常有限,通常都不見得能找到最優解。

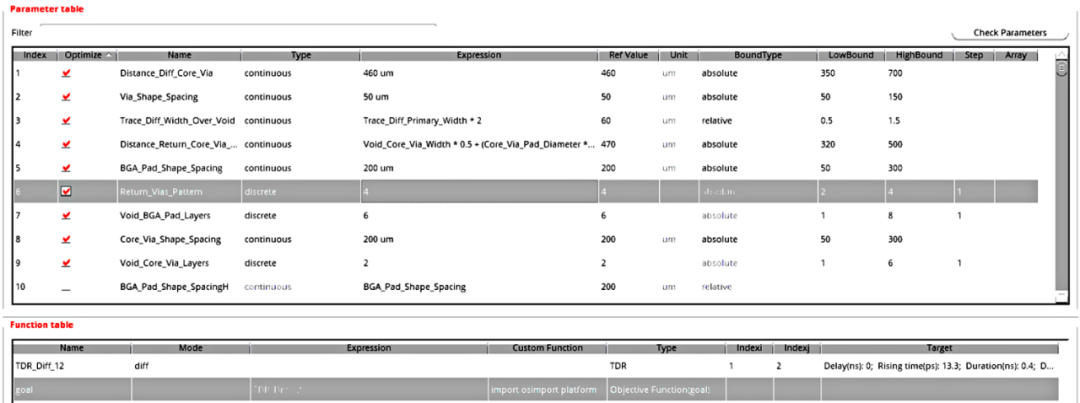

隨著仿真工具的發展,現在調參這個難題可以交給AI引擎來自動實現。這里我們利用Cadence最新推出的Optimality Intelligent System Explorer智能優化引擎來完成封裝過孔優化。在Cadence Clarity 3D Solver仿真工具中打開通過腳本創建出來的仿真工程,通過菜單欄命令打開Optimality Explorer優化引擎,接下來只需要設置好需要調整哪些參數、每個參數的取值范圍,然后定義好我們要優化的目標、設置并行跑的任務數量和仿真服務器資源,剩下的就是等Optimality Explorer根據機器學習算法自動完成” 調整參數”->” 仿真”->” 分析結果”->” 調整參數”->” 仿真 “的迭代,最終得到我們想要的優化結果了。

值得一提的是,Optimality Explorer除了官方給出的一些常用的插損、回損、串擾、TDR等優化目標,還支持Python接口,可以用Python自定義任意的目標函數,比如本例我們用了自定義的TDR指標作為優化目標,綜合考慮了TDR結果中的阻抗偏差最大值、阻抗偏差峰峰值、偏差阻抗長度等指標。

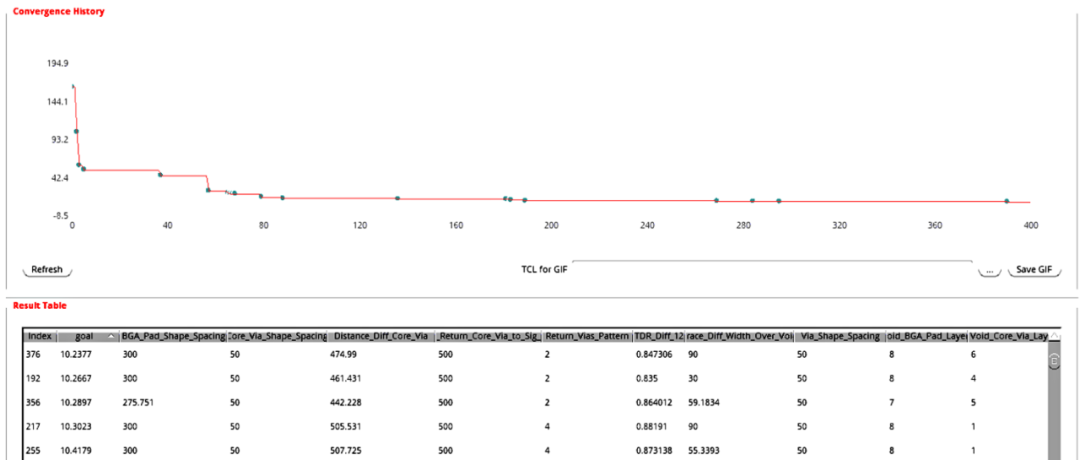

Optimality Explorer的收斂曲線如下。經過幾十次迭代后,得到的仿真結果TDR指標就已經優于工程師手動迭代的結果。因為是工具自動調參,不需要工程師干預,我們可以按原定設置最大迭代次數繼續進行優化,進一步得到更優化的結果。

審核編輯:湯梓紅

-

封裝

+關注

關注

126文章

7778瀏覽量

142718 -

Core

+關注

關注

0文章

174瀏覽量

42893 -

BGA

+關注

關注

4文章

535瀏覽量

46727 -

過孔

+關注

關注

2文章

197瀏覽量

21836

原文標題:自動化建模和優化112G封裝過孔——封裝Core層過孔和BGA焊盤區域的阻抗優化

文章出處:【微信號:sim_ol,微信公眾號:模擬在線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

高速差分過孔之間的串擾分析及優化

用于嵌入式設計的BGA封裝技術

如何區別焊盤和過孔_過孔與焊盤的區別

自動化建模和優化112G封裝過孔——封裝Core層過孔和BGA焊盤區域的阻抗優化

自動化建模和優化112G封裝過孔——封裝Core層過孔和BGA焊盤區域的阻抗優化

評論