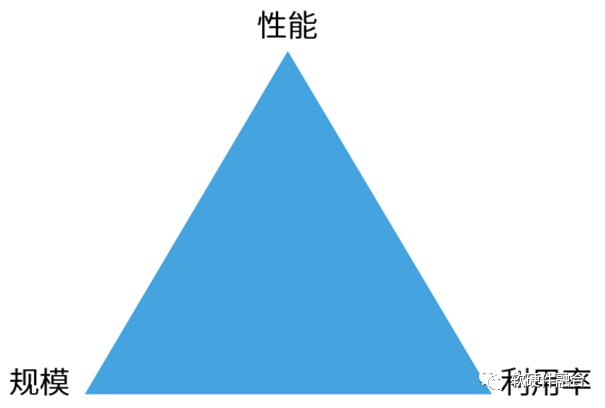

1 算力由性能、規(guī)模和利用率三部分組成

算力 = (單芯片)性能 x 規(guī)模(即數(shù)量) x 利用率。

算力是由性能、規(guī)模、利用率三部分共同組成的,相輔相成,缺一不可:

有的算力芯片,可能可以做到性能狂飆,但較少考慮芯片的通用性易用性,然后芯片銷量不高落地規(guī)模小,那就無(wú)法做到宏觀算力的真正提升。

有的算力提升方案,重在規(guī)模投入,攤大餅有一定作用,但不是解決未來(lái)算力需求數(shù)量級(jí)提升的根本。

有的解決方案,通過(guò)各種資源池化和跨不同的邊界算力共享,來(lái)提升算力利用率,但改變不了目前算力芯片性能瓶頸的本質(zhì)。

性能、規(guī)模、利用率,宏觀微觀,牽一發(fā)而動(dòng)全身。管中窺豹終有偏,既要考慮多種因素協(xié)同設(shè)計(jì),更要宏觀的統(tǒng)籌算力問(wèn)題。

2 最核心的,通過(guò)超異構(gòu)實(shí)現(xiàn)芯片性能的數(shù)量級(jí)提升

一方面,超異構(gòu)可以通過(guò)集成更多的加速引擎來(lái)實(shí)現(xiàn)相比CPU、GPU的性能的數(shù)量級(jí)提升,但更多的計(jì)算是在DSA架構(gòu)引擎完成的,從單位晶體管資源的性能效率視角看,是和DSA在一個(gè)量級(jí)的。

工藝進(jìn)步、3D封裝、Chiplet封裝等各種創(chuàng)新,支持?jǐn)?shù)量級(jí)提升的設(shè)計(jì)規(guī)模。但要想充分利用這些價(jià)值,就需要?jiǎng)?chuàng)新的系統(tǒng)架構(gòu)。超異構(gòu)計(jì)算,通過(guò)分布式系統(tǒng)設(shè)計(jì),可以駕馭數(shù)量級(jí)提升的更大的設(shè)計(jì)規(guī)模。因此,可以做到相比傳統(tǒng)DSA再繼續(xù)10倍甚至100倍的性能提升。

3 在超異構(gòu)的約束下,實(shí)現(xiàn)規(guī)模化落地

3.1 芯片要更好的支持規(guī)模化

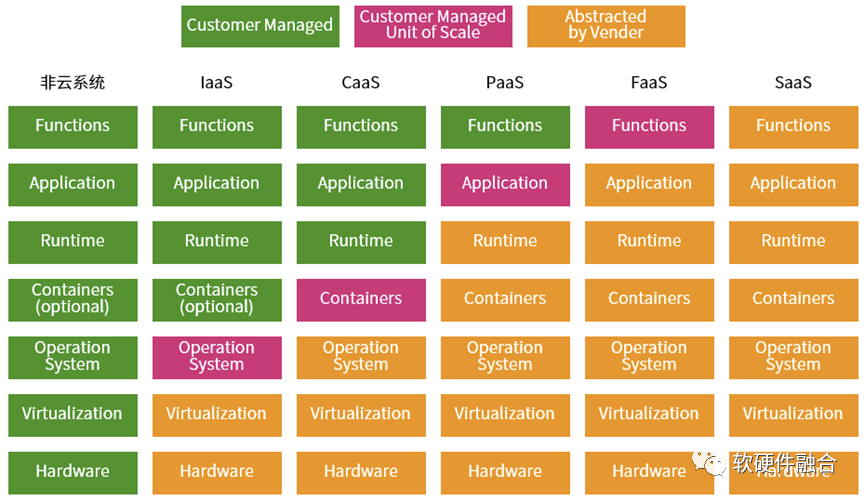

從微服務(wù)的視角,云計(jì)算是由不同的服務(wù)組成的分層服務(wù)體系:每一層就是一個(gè)服務(wù)族,然后不同層次的服務(wù)族組成整個(gè)云計(jì)算服務(wù)體系,這就是我們所熟悉的云計(jì)算三層服務(wù)IaaS、PaaS和SaaS。

更詳細(xì)的軟件堆棧如上圖所示,從非云系統(tǒng)所有的“服務(wù)”堆棧都需要用戶自己擁有并維護(hù),經(jīng)過(guò)IaaS、CaaS、PaaS、FaaS,再到最后的SaaS,一切都由供應(yīng)商運(yùn)營(yíng)維護(hù)。從左到右的過(guò)程,就是“服務(wù)”堆棧的下層layer不斷地由云運(yùn)營(yíng)商接管的過(guò)程。

這是一個(gè)鮮明的“二八定律”案例:80%的任務(wù)由云運(yùn)營(yíng)商負(fù)責(zé),20%的任務(wù)由用戶負(fù)責(zé);站在用戶的角度,20%自己負(fù)責(zé)的任務(wù)價(jià)值占到80%,而運(yùn)營(yíng)商負(fù)責(zé)的部分只占到到20%的價(jià)值。

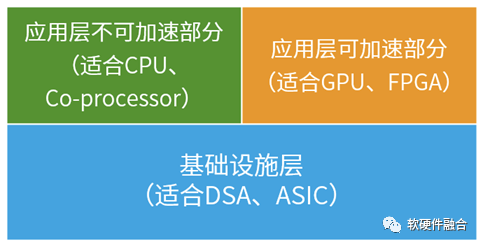

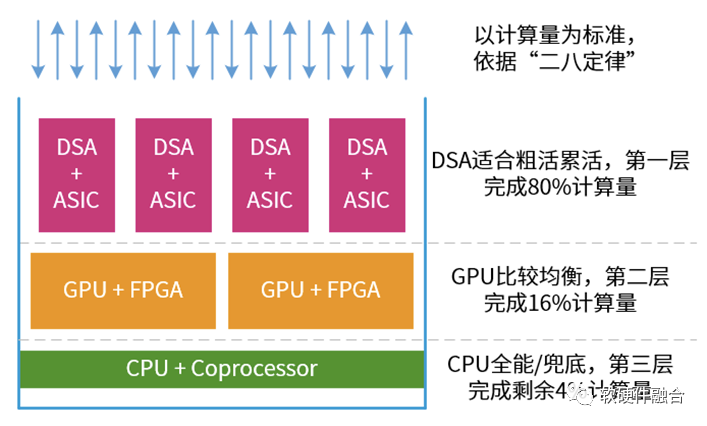

因此,基于二八定律,我們可以把整個(gè)系統(tǒng)分為三部分:

基礎(chǔ)設(shè)施層。基礎(chǔ)設(shè)施層的任務(wù)都相對(duì)確定,適合DSA和ASIC處理引擎處理。

應(yīng)用層可加速部分任務(wù)。基礎(chǔ)設(shè)施層是CSP使用,而應(yīng)用層則是給到用戶應(yīng)用。用戶的應(yīng)用多種多樣,因此應(yīng)用層的加速也需要一定程度的彈性。這樣,GPU和FPGA就相對(duì)比較合適。

應(yīng)用層的不可加速部分。主要是一些通用的處理,如控制以及一些細(xì)粒度的計(jì)算。協(xié)處理器是CPU的一部分。因此,CPU適合各類通用任務(wù)處理,CPU負(fù)責(zé)兜底。

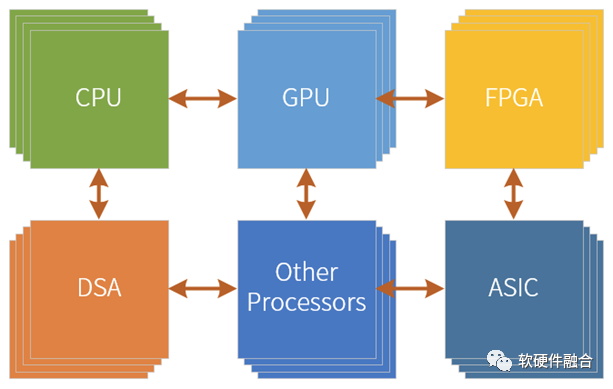

如上圖所示,整個(gè)系統(tǒng)的處理有點(diǎn)像塔防游戲:DSA負(fù)責(zé)干粗活累活,大量的計(jì)算任務(wù)在DSA中完成;GPU是性能和靈活性折中一些,負(fù)責(zé)一些彈性加速的計(jì)算任務(wù);CPU啥都能干,但性能較差,因此負(fù)責(zé)兜底,也就是其他處理引擎都干不了的,都放在CPU。

這樣,CPU+GPU+DSA+etc.的超異構(gòu)計(jì)算架構(gòu)就可以實(shí)現(xiàn)“包治百病”的、相對(duì)通用的計(jì)算架構(gòu)和平臺(tái),就可以實(shí)現(xiàn)在云、網(wǎng)、邊、端等大算力場(chǎng)景以及用戶的絕大部分覆蓋。

更多場(chǎng)景和更多用戶的覆蓋,這樣才能真正實(shí)現(xiàn)芯片的規(guī)模化落地。芯片的大規(guī)模落地之后,又進(jìn)一步攤薄一次性研發(fā)成本,進(jìn)一步降低成本,形成良性循環(huán)。

3.2 宏觀算力建設(shè)實(shí)現(xiàn)芯片規(guī)模化

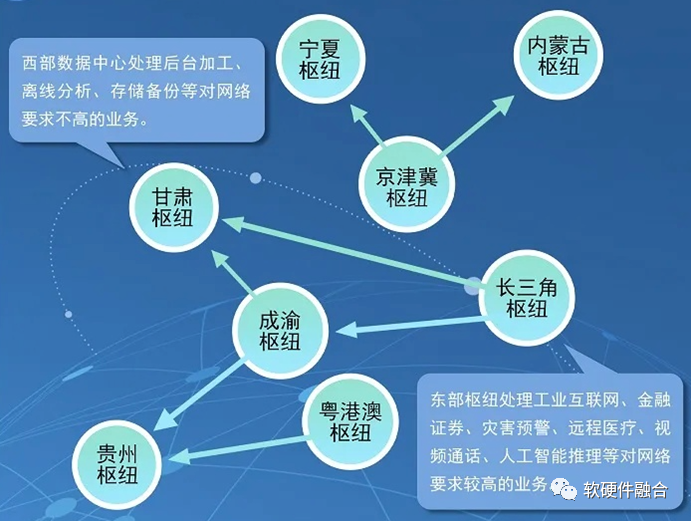

要想持續(xù)不斷地增加算力,不可避免的就是建設(shè)更多的數(shù)據(jù)中心。2022年2月,國(guó)家發(fā)改委、中央網(wǎng)信辦、工業(yè)和信息化部、國(guó)家能源局聯(lián)合印發(fā)通知,同意在京津冀、長(zhǎng)三角、粵港澳大灣區(qū)、成渝、內(nèi)蒙古、貴州、甘肅、寧夏等8地啟動(dòng)建設(shè)國(guó)家算力樞紐節(jié)點(diǎn),并規(guī)劃了10個(gè)國(guó)家數(shù)據(jù)中心集群。至此,全國(guó)一體化大數(shù)據(jù)中心體系完成總體布局設(shè)計(jì),“東數(shù)西算”工程正式全面啟動(dòng)。

“東數(shù)西算”通過(guò)構(gòu)建數(shù)據(jù)中心、云計(jì)算、大數(shù)據(jù)一體化的新型算力網(wǎng)絡(luò)體系,將東部算力需求有序引導(dǎo)到西部,優(yōu)化數(shù)據(jù)中心建設(shè)布局,促進(jìn)東西部協(xié)同聯(lián)動(dòng)。“東數(shù)西算”工程有三個(gè)總體思路:一是推動(dòng)全國(guó)數(shù)據(jù)中心適度集聚、集約發(fā)展。通過(guò)在全國(guó)布局8個(gè)算力樞紐,引導(dǎo)大型、超大型數(shù)據(jù)中心向樞紐內(nèi)集聚,形成數(shù)據(jù)中心集群。二是促進(jìn)數(shù)據(jù)中心由東向西梯次布局、統(tǒng)籌發(fā)展。三是實(shí)現(xiàn)“東數(shù)西算”循序漸進(jìn)、快速迭代。

除了大型云數(shù)據(jù)中心建設(shè)之外,也需要更多的邊緣數(shù)據(jù)中心和服務(wù)器、更多的超高算力的智慧終端,以及更智慧的網(wǎng)絡(luò)核心設(shè)備,來(lái)共同提升宏觀總算力。

4 在超異構(gòu)的約束下,提升算力利用率

4.1 提升算力利用率的手段

云計(jì)算出現(xiàn)之前,部署一套互聯(lián)網(wǎng)系統(tǒng),一般有兩種方式:小規(guī)模的時(shí)候,自己購(gòu)買物理的服務(wù)器,然后租用運(yùn)營(yíng)商的機(jī)房;超過(guò)一定規(guī)模的時(shí)候,就需要自己建機(jī)房,租用運(yùn)營(yíng)商的網(wǎng)絡(luò),自己運(yùn)維數(shù)據(jù)中心的軟件和硬件。這個(gè)時(shí)候的算力資源是一個(gè)個(gè)孤島,整個(gè)業(yè)務(wù)的模式也非常之重,成本很高而且彈性不足。如果算力資源配置比較多,就意味著資源浪費(fèi)和利用率低;如果算力資源配置比較少,就意味著無(wú)法支撐業(yè)務(wù)的發(fā)展,丟失關(guān)鍵的商業(yè)機(jī)會(huì)。

云計(jì)算通過(guò)互聯(lián)網(wǎng)按需提供IT資源,并且采用按使用量付費(fèi)的方式。用戶可以根據(jù)需要從云服務(wù)商那里獲得技術(shù)服務(wù),例如計(jì)算能力、存儲(chǔ)和數(shù)據(jù)庫(kù),而無(wú)需購(gòu)買、擁有和維護(hù)物理數(shù)據(jù)中心及服務(wù)器。云服務(wù)使用多少支付多少,可以幫助用戶降低運(yùn)維成本,用戶可以根據(jù)業(yè)務(wù)需求的變化快速調(diào)整服務(wù)的使用。

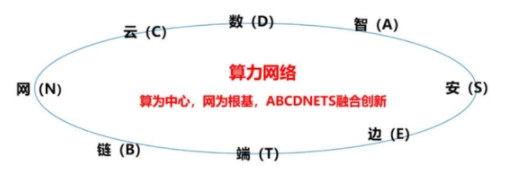

其他如基于分布式云的邊緣計(jì)算、跨不同云廠家的MSP、算力網(wǎng)絡(luò)以及云網(wǎng)邊端融合等,都是盡可能的把算力資源整合成一個(gè)巨大的資源池,然后可以靈活的根據(jù)各種完全動(dòng)態(tài)變化的需求來(lái)提供合適的算力。

我們分析一下,要想提升算力利用率,肯定不能是算力的孤島:

第一個(gè)階段,所有的設(shè)備是孤島,各自要實(shí)現(xiàn)各自的所有功能。軟件應(yīng)用也是單機(jī)版,算力利用率很低,應(yīng)用的規(guī)模受單個(gè)硬件規(guī)格的限制;

第二階段,有了互聯(lián)網(wǎng)。不同的設(shè)備可以進(jìn)行協(xié)作。可以通過(guò)C/S架構(gòu)實(shí)現(xiàn)跨設(shè)備的軟件應(yīng)用協(xié)作。這樣,應(yīng)用的規(guī)模就突破了單個(gè)設(shè)備的約束。

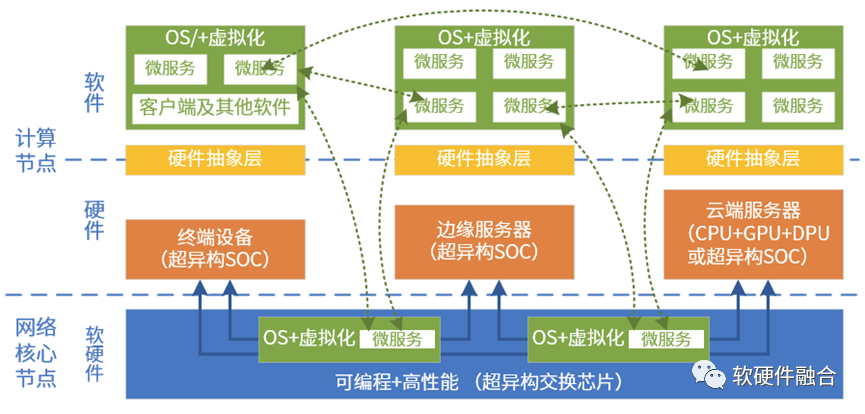

第三階段,所有的算力資源形成一個(gè)整體。可以自動(dòng)的、任意的切分算力資源。軟件也升級(jí)成了MicroService架構(gòu)。這樣可以根據(jù)設(shè)備的規(guī)格大小,運(yùn)行合適大小合適數(shù)量的微服務(wù)。只有資源形成巨大的資源池,然后通過(guò)各種運(yùn)營(yíng)管理,才能真正提高算力的利用率。

4.2 芯片視角看算力利用率

資源池化是提升算力利用率的根本途徑,但資源要想池化,對(duì)硬件有很高的要求:

不同設(shè)備架構(gòu)/接口一致。比如CPU等引擎架構(gòu)一致(比如都是x86架構(gòu)平臺(tái)),那么軟件可以運(yùn)行在任何一個(gè)設(shè)備上,硬件也可以支持各種不同的軟件運(yùn)行。比如NVMe SSD,可以被不同的用戶訪問(wèn),也可以同時(shí)或分時(shí)地支持多種用戶的工作。

支持虛擬化。一方面是資源粒度的問(wèn)題,另一方面是資源自由和動(dòng)態(tài)分配的問(wèn)題,都可以通過(guò)虛擬化技術(shù)解決。虛擬化還可以實(shí)現(xiàn)不同架構(gòu)/接口的抽象,屏蔽硬件差異。

通常,算力的平臺(tái)都是CPU,而且目前x86架構(gòu)CPU占據(jù)了絕大部分市場(chǎng)份額,并且x86 CPU對(duì)虛擬化的支持也非常的好。CPU對(duì)資源池化的支持,或者說(shuō)對(duì)算力更高利用率的支持,是相當(dāng)?shù)挠押谩?/p>

但是,隨著性能需求越來(lái)越高,不得不通過(guò)超異構(gòu)計(jì)算來(lái)數(shù)量級(jí)提升算力的時(shí)候,問(wèn)題出現(xiàn)了。在超異構(gòu)的架構(gòu)下,如何實(shí)現(xiàn)更高的靈活性,如何實(shí)現(xiàn)更高的擴(kuò)展性,如何實(shí)現(xiàn)各類資源的輕松便捷地池化和共享,則是一個(gè)全新的挑戰(zhàn):

處理引擎要支持虛擬化和高可擴(kuò)展性;

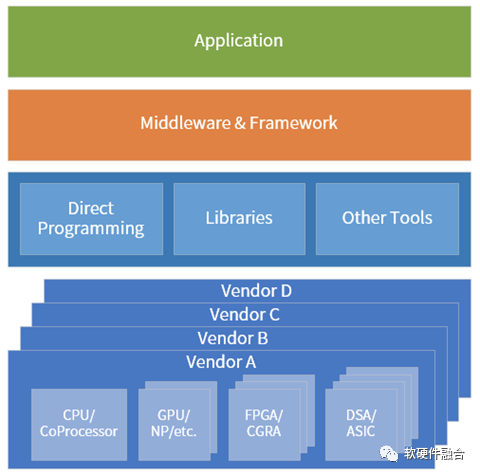

軟件可以跨不同廠家的、不同架構(gòu)處理引擎;

軟件可以跨跨CPU、GPU、DSA等不同類型處理引擎;

軟件可以跨云網(wǎng)邊端。

5 展望,云網(wǎng)邊端大融合

在虛擬化的加持下,軟件可以實(shí)現(xiàn)完全高可用:軟件可以脫離硬件實(shí)體,隨意的尋找合適的平臺(tái)運(yùn)行,自適應(yīng)的在云、網(wǎng)、邊、端運(yùn)行。

隨著CPU的性能瓶頸,I/O虛擬化技術(shù)完全硬件化的情況下,硬件接口直接暴露給軟件,這就需要云數(shù)據(jù)中心內(nèi)部,以及跨云邊端的硬件平臺(tái)一致性。

要想實(shí)現(xiàn)跨云網(wǎng)邊端、跨不同廠家的芯片平臺(tái)、跨不同類型不同架構(gòu)的處理引擎,就需要芯片、系統(tǒng)、框架和庫(kù)、以及上層應(yīng)用的多方協(xié)同,就需要開源開放的超異構(gòu)計(jì)算生態(tài)。

萬(wàn)物互聯(lián),當(dāng)所有的設(shè)備算力資源匯集成一個(gè)大的共享資源池,算力資源將取之不盡用之不竭。

審核編輯:劉清

-

晶體管

+關(guān)注

關(guān)注

77文章

9505瀏覽量

136959 -

CSP

+關(guān)注

關(guān)注

0文章

117瀏覽量

27978 -

DSA

+關(guān)注

關(guān)注

0文章

47瀏覽量

15046 -

PaaS

+關(guān)注

關(guān)注

2文章

130瀏覽量

21360

原文標(biāo)題:再來(lái)聊聊大家都經(jīng)常聊的算力話題

文章出處:【微信號(hào):阿寶1990,微信公眾號(hào):阿寶1990】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

“算力”的分層定義-初級(jí)算力

算力系列基礎(chǔ)篇——算力101:從零開始了解算力

大模型時(shí)代的算力需求

畢業(yè)設(shè)計(jì)話題

聊一聊大家都是在什么公司的網(wǎng)站上選擇器件型號(hào)?

rx580算力,rx580顯卡算力,rx588算力,rx588顯卡算力 精選資料分享

聊聊關(guān)于架構(gòu)的話題

何為算力

【職場(chǎng)雜談】與嵌入式物聯(lián)網(wǎng)架構(gòu)師聊一聊幾個(gè)話題

算力網(wǎng)絡(luò):算力和網(wǎng)絡(luò)的關(guān)系

算力網(wǎng)絡(luò)是什么意思

創(chuàng)新算力網(wǎng)關(guān):中國(guó)電信聚力推進(jìn)算力網(wǎng)絡(luò)關(guān)鍵核心技術(shù)攻關(guān)

什么是算力?算力可分為哪些算力類別?

聊聊大家都經(jīng)常聊的算力話題

聊聊大家都經(jīng)常聊的算力話題

評(píng)論