寫在前面

今天給大家帶來一篇事件抽取數據增強方法,全名為《Mask-then-Fill: A Flexible and Effective Data Augmentation Framework for Event Extraction》,即一種靈活有效的事件抽取數據增強框架-Mask-then-Fill。

介紹

事件抽取,即從非機構化文本中抽取指定的事件的觸發詞及其事件要素,為了減輕人工標注,常采用數據增強方法,對原有數據進行擴充,在有限的數據內,盡可能提高模型的效果及泛化性。目前,自然語言處理的數據增強方法主要分為兩類:(1)修改原有訓練數據樣本;(2)生成+采樣。而事件抽取任務需要在保持事件結構(觸發器和參數)不變的情況下增加訓練數據,因此“生成+采樣”的方法并不適用,本論文主要采用“修改原有訓練數據樣本”方法進行數據增強。

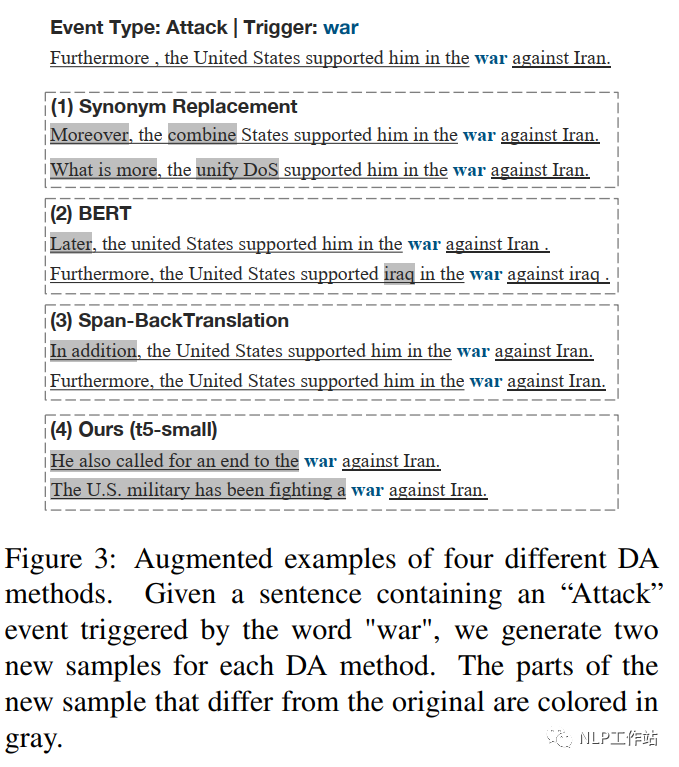

如圖1所示,現有對事件抽取進行數據增強的方法主要包括:(1)回譯;(2)同義詞替換;(3)BERT換詞。但,同義詞替換和回譯方法缺乏語義多樣性,只能生成語義相似的樣本;而基于BERT的方法只能替換單詞,不能改變語法,不能生成包含各種表達式的樣本。

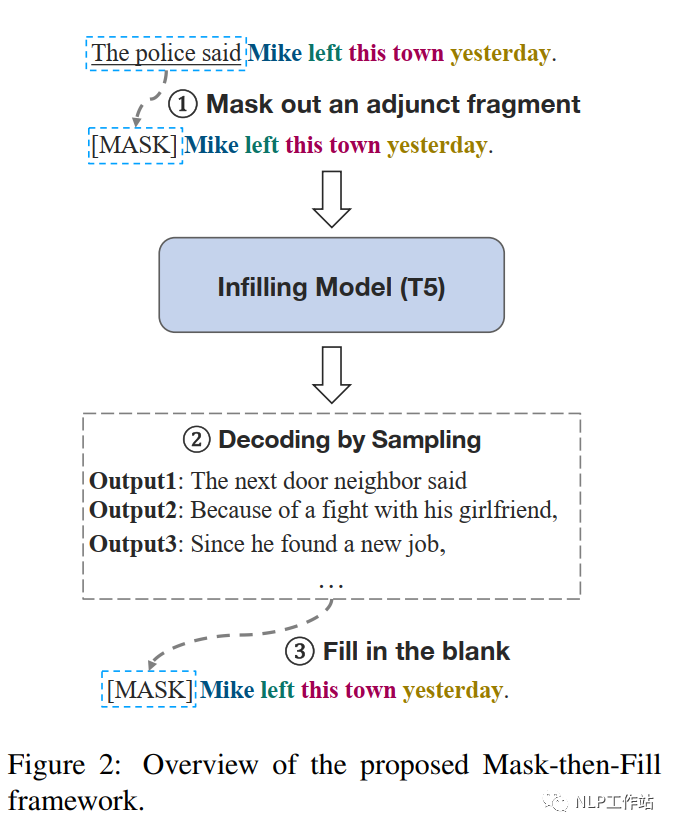

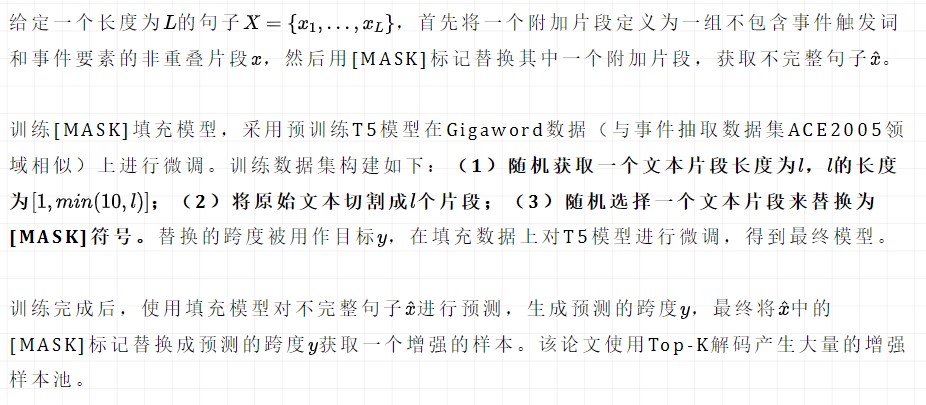

為了解決數據增強多樣性的問題,該論文提出了“掩碼-填充”方法,在保持原事件結構不變的情況下生成更多樣化的數據。首先定義兩種類型文本片段:(1)事件相關片段(觸發詞和事件要素);(2)附加片段。然后隨機掩碼一個附件片段,最后采用微調后的T5模型進行文本填充。

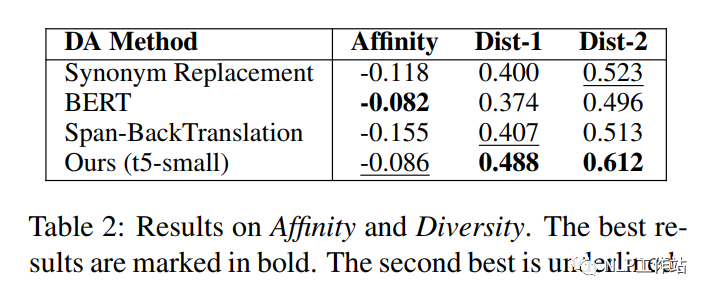

并且引入親和度(Affinity)和多樣性(Diversity)兩個指標進行進一步研究,發現Mask-then-Fill方法增強的數據具有更好的多樣性和更少的分布變化,在多樣性和分布相似性之間實現了良好的平衡。

Mask-then-Fill Framework

掩碼-填充框架如圖2所示,文本主要包括事件相關片段(帶顏色內容)和附加片段(帶下劃線內容),框架的核心是在不引入新的事件前提下,重寫整個附屬片段。

Experimental Setup

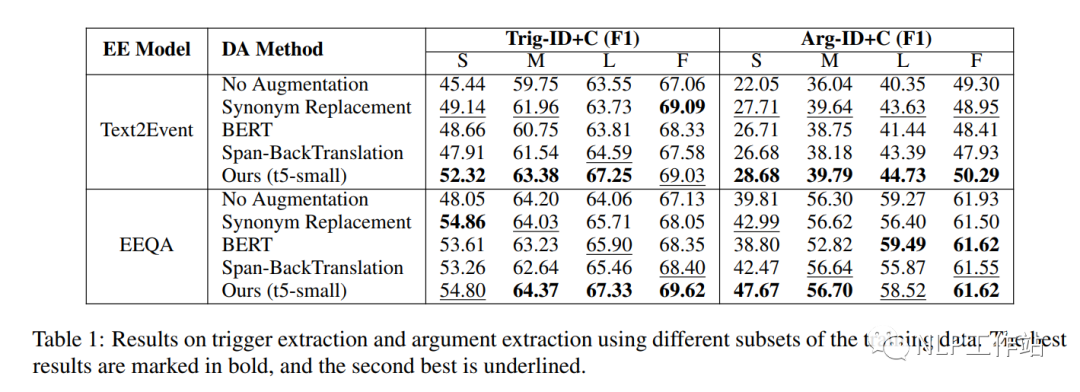

采用ACE2005數據集上進行對比實驗,從訓練集中隨機抽取1000、4000和8000個樣本來模擬低資源設置,創建小型、中型和大型訓練集。并在數據增強時,僅對訓練數據集進行數據增強,開發集和測試集保持不變。

在Text2Event模型和Text2Event模型兩個具有代表性的事件抽取模型上進行實驗,并對比與同義詞替換、回譯、BERT模型三種數據增強方法之間的差異。

Results and Analysis

如表1所示,整體上Mask-then-Fill方法最優。

從表2可以看出,我Mask-then-Fill方法增強的數據具有更好的多樣性和更少的分布偏移,在多樣性和分布相似性之間取得了平衡。

圖3展示了由不同的數據增強方法生成的示例。

總結

該框架的主要優點在于可以將文本中任意長度的片段替換為可變長度的片段,而現有的方法只能替換單個單詞或固定長度的片段。

審核編輯:劉清

-

J-BERT

+關注

關注

0文章

5瀏覽量

7787 -

觸發器

+關注

關注

14文章

1996瀏覽量

61053 -

ACE

+關注

關注

0文章

21瀏覽量

10645 -

Fill

+關注

關注

0文章

4瀏覽量

2877

原文標題:事件抽取數據增強方法-Mask-then-Fill

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

CIC抽取濾波器MATLAB仿真和FPGA實現

怎樣去設計一種CIC抽取濾波器并對其進行MATLAB仿真呢

一種基于復用組件的WEB測控軟件框架設計

一種基于XML的可復用Web圖表框架

有限狀態機的一種實現框架

一種新的DSA圖像增強算法

一種基于框架特征的共指消解方法

一種用于交通流預測的深度學習框架

一種靈活有效的事件抽取數據增強框架-Mask-then-Fill

一種靈活有效的事件抽取數據增強框架-Mask-then-Fill

評論