譯者按: 最近一段時(shí)間,ChatGPT 作為一個(gè)現(xiàn)象級(jí)應(yīng)用迅速躥紅,也帶動(dòng)了對(duì)其背后的大語(yǔ)言模型 (LLM) 的討論,這些討論甚至出了 AI 技術(shù)圈,頗有些到了街談巷議的程度。在 AI 技術(shù)圈,關(guān)于 LLM 和小模型的討論在此之前已經(jīng)持續(xù)了不短的時(shí)間,處于不同生態(tài)位置和產(chǎn)業(yè)環(huán)節(jié)的人都有表達(dá)自己的觀點(diǎn),其中不少是有沖突的。

大模型的研究者和大公司出于不同的動(dòng)機(jī)站位 LLM,研究者出于對(duì) LLM 的突現(xiàn)能力 (emergent ability) 的好奇和對(duì) LLM 對(duì) NLP 領(lǐng)域能力邊界的拓展、而大公司可能更多出自于商業(yè)利益考量;而社區(qū)和中小公司猶猶豫豫在小模型的站位上徘徊,一方面是由于對(duì) LLM 最終訓(xùn)練、推理和數(shù)據(jù)成本的望而卻步,一方面也是對(duì)大模型可能加強(qiáng)大公司數(shù)據(jù)霸權(quán)的隱隱擔(dān)憂。但討論,尤其是公開(kāi)透明的討論,總是好事,讓大家能夠聽(tīng)到不同的聲音,才有可能最終收斂至更合理的方案。

我們選譯的這篇文章來(lái)自于 2021 年 10 月的 Hugging Face 博客,作者在那個(gè)時(shí)間點(diǎn)站位的是小模型,一年多以后的 2023 年作者的觀點(diǎn)有沒(méi)有改變我們不得而知,但開(kāi)卷有益,了解作者當(dāng)時(shí)考慮的那些點(diǎn),把那些合理的點(diǎn)納入自己的思考體系,并結(jié)合新的進(jìn)展最終作出自己的判斷可能才是最終目的。

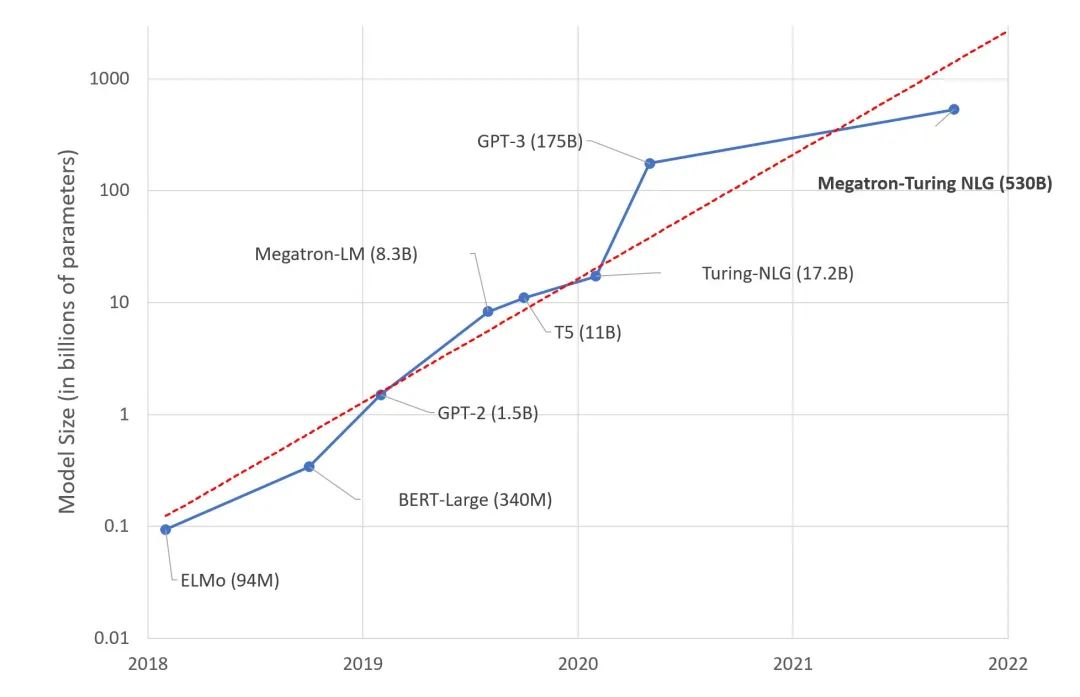

不久前,微軟和 Nvidia 推出了 Megatron-Turing NLG 530B,一種基于 Transformer 的模型,被譽(yù)為是 “世界上最大且最強(qiáng)的生成語(yǔ)言模型”。

毫無(wú)疑問(wèn),此項(xiàng)成果對(duì)于機(jī)器學(xué)習(xí)工程來(lái)講是一場(chǎng)令人印象深刻的能力展示,表明我們的工程能力已經(jīng)能夠訓(xùn)練如此巨大的模型。然而,我們應(yīng)該為這種超級(jí)模型的趨勢(shì)感到興奮嗎?我個(gè)人傾向于否定的回答。我將在通過(guò)本文闡述我的理由。

這是你的深度學(xué)習(xí)大腦

研究人員估計(jì),人腦平均包含 860 億個(gè)神經(jīng)元和 100 萬(wàn)億個(gè)突觸。可以肯定的是,這里面并非所有的神經(jīng)元和突觸都用于語(yǔ)言。有趣的是,GPT-4 預(yù)計(jì)有大約 100 萬(wàn)億個(gè)參數(shù)...... 雖然這個(gè)類(lèi)比很粗略,但難道我們不應(yīng)該懷疑一下構(gòu)建與人腦大小相當(dāng)?shù)恼Z(yǔ)言模型長(zhǎng)期來(lái)講是否是最佳方案?

當(dāng)然,我們的大腦是一個(gè)了不起的器官,它經(jīng)過(guò)數(shù)百萬(wàn)年的進(jìn)化而產(chǎn)生,而深度學(xué)習(xí)模型僅有幾十年的歷史。不過(guò),我們的直覺(jué)告訴我們: 有些東西無(wú)法計(jì)算 (這是個(gè)雙關(guān)語(yǔ),:)) 。

深度學(xué)習(xí),深度銷(xiāo)金窟?

如你所料,在龐大的文本數(shù)據(jù)集上訓(xùn)練一個(gè) 5300 億參數(shù)的模型需要相當(dāng)多的基礎(chǔ)設(shè)施。事實(shí)上,Microsoft 和 Nvidia 使用了數(shù)百臺(tái) DGX A100 GPU 服務(wù)器,每臺(tái) 19 萬(wàn) 9 千美元。如果再把網(wǎng)絡(luò)設(shè)備、托管成本等因素考慮進(jìn)去的話,任何想要重現(xiàn)該實(shí)驗(yàn)的組織或個(gè)人都必須花費(fèi)近 1 億美元。來(lái)根薯?xiàng)l壓壓驚?

說(shuō)真的,有哪些組織有那種值得花費(fèi) 1 億美元來(lái)構(gòu)建深度學(xué)習(xí)基礎(chǔ)設(shè)施的業(yè)務(wù)?再少點(diǎn),又有哪些組織有那種可以值得花費(fèi) 1000 萬(wàn)美元基礎(chǔ)設(shè)施的業(yè)務(wù)?很少。既然很少,那么請(qǐng)問(wèn),這些模型為誰(shuí)而生呢?

GPU 集群的熱

盡管訓(xùn)練大模型需要杰出的工程能力,但在 GPU 上訓(xùn)練深度學(xué)習(xí)模型本身卻是一種蠻力技術(shù)。根據(jù)規(guī)格表,每臺(tái) DGX 服務(wù)器可消耗高達(dá) 6.5 千瓦的功率。同時(shí),數(shù)據(jù)中心 (或服務(wù)器機(jī)柜) 至少需要同樣多的冷卻能力。除非你是史塔克家族的人 (Starks) ,需要在冬天讓臨冬城 (Winterfell) 保持溫暖,否則你必須處理散熱問(wèn)題。

此外,隨著公眾對(duì)氣候和社會(huì)責(zé)任問(wèn)題意識(shí)的增強(qiáng),還需要考慮碳足跡問(wèn)題。根據(jù)馬薩諸塞大學(xué) 2019 年的一項(xiàng)研究,“在 GPU 上訓(xùn)練一次 BERT 產(chǎn)生的碳足跡大致與一次跨美飛行相當(dāng)”。

BERT-Large 有 3.4 億個(gè)參數(shù)。我們可以通過(guò)此推斷 Megatron-Turing 的碳足跡大致如何……認(rèn)識(shí)我的人都知道,我并不是一個(gè)熱血環(huán)保主義者。盡管如此,這些數(shù)字也不容忽視。

所以呢?

我對(duì) Megatron-Turing NLG 530B 和接下來(lái)可能會(huì)出現(xiàn)的模型巨獸感到興奮嗎?不。我認(rèn)為值得增加成本、復(fù)雜性以及碳足跡去換取 (相對(duì)較小的) 測(cè)試基準(zhǔn)上的改進(jìn)嗎?不。我認(rèn)為構(gòu)建和推廣這些龐大的模型能幫助組織理解和應(yīng)用機(jī)器學(xué)習(xí)嗎?不。

我想知道這一切有什么意義。為了科學(xué)而科學(xué)?好的老營(yíng)銷(xiāo)策略?技術(shù)至上?可能每個(gè)都有一點(diǎn)。如果是這些意義的話,我就不奉陪了。

相反,我更專(zhuān)注于實(shí)用且可操作的技術(shù),大家都可以使用這些技術(shù)來(lái)構(gòu)建高質(zhì)量的機(jī)器學(xué)習(xí)解決方案。

使用預(yù)訓(xùn)練模型

在絕大多數(shù)情況下,你不需要自定義模型架構(gòu)。也許你會(huì) 想要 自己定制一個(gè)模型架構(gòu) (這是另一回事),但請(qǐng)注意此處猛獸出沒(méi),僅限資深玩家!

一個(gè)好的起點(diǎn)是尋找已經(jīng)針對(duì)你要解決的任務(wù)預(yù)訓(xùn)練過(guò)的模型 (例如,英文文本摘要) 。

然后,你應(yīng)該快速嘗試一些模型,用它們來(lái)預(yù)測(cè)你自己的數(shù)據(jù)。如果指標(biāo)效果不錯(cuò),那么打完收工!如果還需要更高一點(diǎn)的準(zhǔn)確率,你應(yīng)該考慮對(duì)模型進(jìn)行微調(diào) (稍后會(huì)詳細(xì)介紹) 。

使用較小的模型

在評(píng)估模型時(shí),你應(yīng)該從那些精度滿足要求的模型中選擇尺寸最小的那個(gè)。它預(yù)測(cè)得更快,并且需要更少的硬件資源來(lái)進(jìn)行訓(xùn)練和推理。節(jié)儉需要從一開(kāi)始就做起。

這其實(shí)也不算什么新招。計(jì)算機(jī)視覺(jué)從業(yè)者會(huì)記得 SqueezeNet 2017 年問(wèn)世時(shí),與 AlexNet 相比,模型尺寸減少了 50 倍,而準(zhǔn)確率卻與 AlexNet 相當(dāng)甚至更高。多聰明!

自然語(yǔ)言處理社區(qū)也在致力于使用遷移學(xué)習(xí)技術(shù)縮減模型尺寸,如使用知識(shí)蒸餾技術(shù)。DistilBERT 也許是其中最廣為人知的工作。與原始 BERT 模型相比,它保留了 97% 的語(yǔ)言理解能力,同時(shí)尺寸縮小了 40%,速度提高了 60%。你可以 Hugging Face 嘗試一下 DistilBERT。同樣的方法也已經(jīng)應(yīng)用于其他模型,例如 Facebook 的 BART,你可以在 Hugging Face 嘗試 DistilBART。

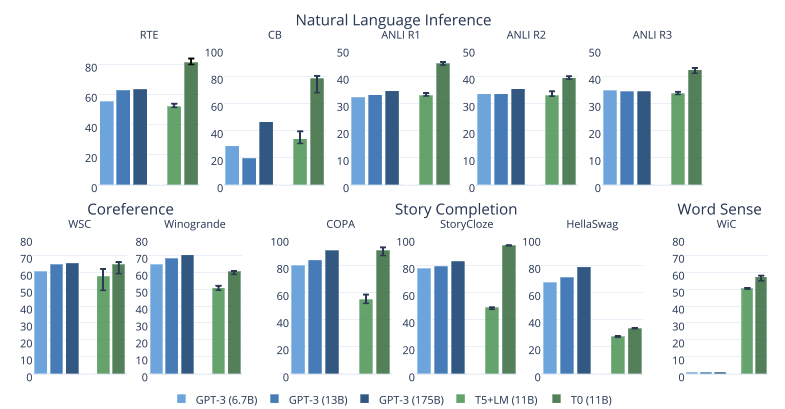

Big Science 項(xiàng)目的最新模型也令人印象深刻。下面這張來(lái)自于論文的圖表明,他們的 T0 模型在許多任務(wù)上都優(yōu)于 GPT-3,同時(shí)尺寸小 16 倍。你可以 Hugging Face 嘗試 T0。

微調(diào)模型

如果你需要特化一個(gè)模型,你不應(yīng)該從頭開(kāi)始訓(xùn)練它。相反,你應(yīng)該對(duì)其進(jìn)行微調(diào),也就是說(shuō),僅針對(duì)你自己的數(shù)據(jù)訓(xùn)練幾個(gè)回合。如果你缺少數(shù)據(jù),也許這些數(shù)據(jù)集中的某個(gè)可以幫助你入門(mén)。

猜對(duì)了,這是進(jìn)行遷移學(xué)習(xí)的另一種方式,它會(huì)幫助你節(jié)省一切!

收集、存儲(chǔ)、清理和標(biāo)注的數(shù)據(jù)更少,

更快的實(shí)驗(yàn)和迭代,

生產(chǎn)過(guò)程所需的資源更少。

換句話說(shuō): 節(jié)省時(shí)間,節(jié)省金錢(qián),節(jié)省硬件資源,拯救世界!

如果你需要教程,Hugging Face 課程可以幫助你立即入門(mén)。

使用云基礎(chǔ)設(shè)施

不管你是否喜歡它們,事實(shí)是云公司懂得如何構(gòu)建高效的基礎(chǔ)設(shè)施。可持續(xù)性研究表明,基于云的基礎(chǔ)設(shè)施比其他替代方案更節(jié)能減排: 請(qǐng)參閱 AWS、Azure 和 Google。Earth.org 宣稱雖然云基礎(chǔ)設(shè)施并不完美,“[它] 比替代方案更節(jié)能,并促進(jìn)了環(huán)境友好的服務(wù)及經(jīng)濟(jì)增長(zhǎng)。"

在易用性、靈活性和隨用隨付方面,云肯定有很多優(yōu)勢(shì)。它也比你想象的更環(huán)保。如果你的 GPU 不夠用,為什么不嘗試在 AWS 的機(jī)器學(xué)習(xí)托管服務(wù) Amazon SageMaker 上微調(diào)你的 Hugging Face 模型?我們?yōu)槟銣?zhǔn)備了大量示例。

優(yōu)化你的模型

從編譯器到虛擬機(jī),軟件工程師長(zhǎng)期以來(lái)一直在使用能夠針對(duì)任何運(yùn)行硬件自動(dòng)優(yōu)化代碼的工具。

然而,機(jī)器學(xué)習(xí)社區(qū)仍在這個(gè)課題上苦苦掙扎,這是有充分理由的。優(yōu)化模型的尺寸和速度是一項(xiàng)極其復(fù)雜的任務(wù),其中涉及以下技術(shù):

專(zhuān)用硬件加速: 如訓(xùn)練加速硬件 (Graphcore、Habana) 、推理加速硬件 (Google TPU,AWS Inferentia)。

剪枝: 刪除對(duì)預(yù)測(cè)結(jié)果影響很小或沒(méi)有影響的模型參數(shù)。

融合: 合并模型層 (例如,卷積和激活) 。

量化: 以較小的位深存儲(chǔ)模型參數(shù) (例如,使用 8 位而不是 32 位)

幸運(yùn)的是,自動(dòng)化工具開(kāi)始出現(xiàn),例如 Optimum 開(kāi)源庫(kù)和 Infinity,Infinity 是一個(gè)最低能以 1 毫秒的延遲提供 Transformers 推理能力的容器化解決方案。

結(jié)論

在過(guò)去的幾年里,大語(yǔ)言模型的尺寸平均每年增長(zhǎng) 10 倍。這開(kāi)始看起來(lái)像另一個(gè)摩爾定律。

這條路似曾相識(shí),我們應(yīng)該知道這條路遲早會(huì)遇到收益遞減、成本增加、復(fù)雜性等問(wèn)題以及新的風(fēng)險(xiǎn)。指數(shù)的結(jié)局往往不是會(huì)很好。還記得 Meltdown and Spectre 嗎?我們想知道人工智能的 Meltdown and Spectre 會(huì)是什么嗎?

審核編輯:劉清

-

gpu

+關(guān)注

關(guān)注

28文章

4703瀏覽量

128725 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8382瀏覽量

132444 -

nlp

+關(guān)注

關(guān)注

1文章

487瀏覽量

22015 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1549瀏覽量

7507

原文標(biāo)題:大語(yǔ)言模型: 新的摩爾定律?

文章出處:【微信號(hào):zenRRan,微信公眾號(hào):深度學(xué)習(xí)自然語(yǔ)言處理】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

大語(yǔ)言模型背后的Transformer,與CNN和RNN有何不同

【大語(yǔ)言模型:原理與工程實(shí)踐】大語(yǔ)言模型的基礎(chǔ)技術(shù)

大語(yǔ)言模型:原理與工程時(shí)間+小白初識(shí)大語(yǔ)言模型

【《大語(yǔ)言模型應(yīng)用指南》閱讀體驗(yàn)】+ 基礎(chǔ)知識(shí)學(xué)習(xí)

如何更改ABBYY PDF Transformer+界面語(yǔ)言

ABBYY PDF Transformer+改善轉(zhuǎn)換結(jié)果之識(shí)別語(yǔ)言

你了解在單GPU上就可以運(yùn)行的Transformer模型嗎

一種新的動(dòng)態(tài)微觀語(yǔ)言競(jìng)爭(zhēng)社會(huì)仿真模型

超大Transformer語(yǔ)言模型的分布式訓(xùn)練框架

探究超大Transformer語(yǔ)言模型的分布式訓(xùn)練框架

一種基于亂序語(yǔ)言模型的預(yù)訓(xùn)練模型-PERT

基于Transformer的大型語(yǔ)言模型(LLM)的內(nèi)部機(jī)制

大語(yǔ)言模型中的語(yǔ)言與知識(shí):一種神秘的分離現(xiàn)象

介紹一種基于Transformer的大語(yǔ)言模型

介紹一種基于Transformer的大語(yǔ)言模型

評(píng)論