大數據的來源主要包括:商業數據、互聯網數據、物聯網數據。其中,商業數據來源于企業的內部系統(如企業ERP、POS 終端系統、網上支付系統等);互聯網數據包括:QQ、微信、微博、網站數據;物聯網數據來源于物聯網硬件設備(如射頻識別裝置、全球定位設備、傳感器設備、視頻監控設備等)。

大數據的數據類型可分為三種:結構化數據、半結構化數據、非結構化數據。其中,結構化數據是關系數據庫中的數據,可直接被使用和存儲;半結構化數據可通過一定規律存儲,如excel表格中的數據;非結構化數據是雜亂無章的,如郵件、網頁的文字和圖像,需要進行相應的處理才可被存儲。

數據采集技術是數據科學的重要組成部分,技術是大數據處理的關鍵技術之一。常用的采集方法包括兩種:ETL工具采集、網頁數據采集。

一、ETL工具采集

ETL工具采集是將業務系統的數據通過抽取、清洗轉換后加載至數據倉庫的過程,目的是將企業中的分散零亂、標準不統一的數據整合,為企業的決策提供分析依據。

ETL采集是商業智能項目的重要環節,目前,互聯網公司會采用該技術獲取相關數據。

二、網頁數據采集

網頁數據采集是在互聯網中采集數據。網頁數據具有多元異構交互性、社會性、突發性、高噪聲等特點,非結構化數據比例較高,且數據實時性較強。

目前,網頁數據主要通過爬蟲采集。爬蟲采集需編寫爬蟲程序或爬蟲腳本,爬蟲流程是訪問一個url(根據網絡資料理解:url的中文名稱是統一資源定位符,統一資源定位符是互聯網資源位置和訪問方法的一種簡潔的表示,俗稱網址),并通過模仿HTTP請求(根據網絡資料:HTTP請求是指從客戶端到服務器端的請求消息)獲取網頁。爬蟲過程類似于通過瀏覽器查看并獲取網頁的信息。

因為Python運行效率較高,且具有較成熟的爬蟲框架和網頁解析庫文件,所以可快速處理網絡數據。后文通過Python介紹爬蟲(網絡爬蟲)。

網絡爬蟲(Web crawler) 是按照一定規則,自動抓取萬維網(英文名稱為World Wide Web,簡稱WWW)信息的程序或腳本,一般可分為數據采集,處理,儲存三部分。

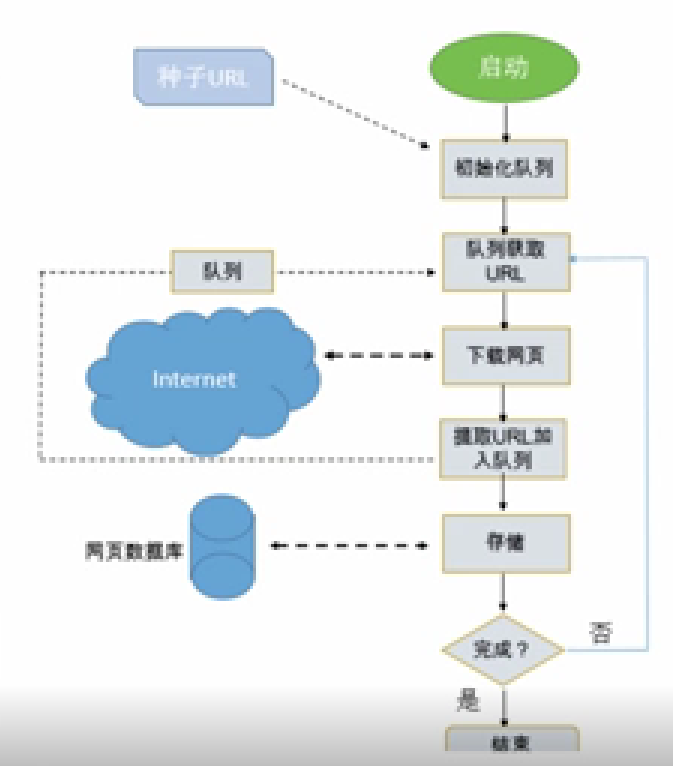

其中,數據采集是通過模仿HTTP請求獲取網頁,數據處理是對網頁中非結構化的數據進行處理,數據存儲包括將新URL放置于URL隊列中和將爬取的數據存儲至數據存儲介質中。

圖片來源:學堂在線《大數據導論》

網絡爬蟲的系統結構如下:首先啟動爬蟲應用程序。一般,爬蟲應用程序具有初始化隊列,初始化隊列中具有種子URL。然后,下載種子URL所對應的網頁,網頁中可提取新的URL并加入URL隊列。再然后,將網頁進行簡單處理后存儲至數據庫中。以上爬蟲過程結束后,再從URL隊列中獲取新URL,并下載新URL所對應的網頁,重復爬蟲過程。

圖片來源:學堂在線《大數據導論》

審核編輯:劉清

-

傳感器

+關注

關注

2548文章

50740瀏覽量

752148 -

數據采集

+關注

關注

38文章

5925瀏覽量

113539 -

ERP

+關注

關注

0文章

503瀏覽量

34355 -

POS

+關注

關注

3文章

119瀏覽量

28294

原文標題:大數據相關介紹(12)——數據采集(上)

文章出處:【微信號:行業學習與研究,微信公眾號:行業學習與研究】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

基于USB數據采集系統的研究與設計--ResearchandDesignofDataAequisitio

淺談幾種主流數控機床的數據采集技術分享

基于PDA的核數據采集系統的研究

基于PDA的核數據采集系統的研究

工業數據采集類型與數據采集的方法

數據采集技巧和技術

如何采集工業設備數據?工業數據采集的方法有哪些?

數據采集技術常用的采集方法包括幾種

數據采集技術常用的采集方法包括幾種

評論