電子發(fā)燒友網(wǎng)報道(文/李彎彎、吳子鵬)從OpenAI去年底推出ChatGPT以來,人工智能領域持續(xù)火熱。近日,高潮更是一波接著一波,首先是OpenAI繼ChatGPT之后又推出了更強大的大型多模態(tài)模型GPT-4,接著是國內(nèi)百度終于正式發(fā)布了其大型語言模型文心一言。昨日,微軟宣布將GPT-4全面接入所有辦公軟件,更是炸翻全場。

種種跡象表明,大模型的應用即將走進千家萬戶,人工智能產(chǎn)業(yè)發(fā)展迎來高潮。大家知道,無論是ChatGPT、文心一言,還是其他生成式AI模型的訓練和部署,對算力都有很高的要求。那么目前國內(nèi)在這方面具備怎樣的條件?大模型的發(fā)展將帶來怎樣的機會和挑戰(zhàn)?帶著這些問題,電子發(fā)燒友最近對多家大算力芯片、接口IP、服務器企業(yè)做了深度調(diào)研。

大算力芯片的機會和挑戰(zhàn)

目前,全球大模型的訓練基本都是采用英偉達的GPU。OpenAI之前推出的ChatGPT,以及最近發(fā)布的GPT-4,都是在大量英偉達A100的基礎上訓練而成。據(jù)說微軟的Azure云服務為ChatGPT構(gòu)建了超過1萬枚英偉達A100GPU芯片的AI計算集群。

國內(nèi)大模型的訓練也基本倚賴英偉達的GPU,業(yè)內(nèi)人士認為,想要做好AI大模型,1萬枚英偉達A100芯片是門檻。然而國內(nèi)擁有1萬枚英偉達A100芯片的企業(yè)少之又少。從這個層面來看,國內(nèi)企業(yè)想要布局類似ChatGPT這樣大規(guī)模的模型短期來看還很難。

從長遠來看,未來大模型的研發(fā)和部署是必然趨勢,而每個大模型訓練和部署的背后,都有幾萬個GPU在支持。可想而知,未來隨著這方面的研發(fā)和應用的普及,通用GPU市場需求將會迎來爆發(fā)式增長。這對GPU企業(yè)來說將會是巨大的機會。

登臨科技聯(lián)合創(chuàng)始人王平在接受電子發(fā)燒友采訪的時候表示:“以電力為例,可以很清楚的看到這個市場未來的變化。幾十年前,電力只是用在一些小用量的場景,隨著電力的供給越來越多,電器也越來越多的時候,最后電力就成了一個基本設施。可以說,算力也是朝著基礎設施的方向在發(fā)展。而現(xiàn)在通用GPU還遠沒有到爆炸式需求的階段。”

然而從目前的情況來看,國內(nèi)的GPU還難以在大模型的訓練中承擔起重要責任,不過可以看到有不少企業(yè)在該領域持續(xù)耕耘。對于國內(nèi)的GPU企業(yè)可以怎么做,才能在抓住ChatGPT帶來的這波機會,如何為國內(nèi)大模型的發(fā)展提供算力支持?

在接受電子發(fā)燒友采訪的時候,燧原科技創(chuàng)始人兼COO張亞林談到了幾點:首先,企業(yè)需要能夠提供更高性價比的算力,從ChatGPT訓練就能看到算力的成本有多高,從這個角度來看,并不是所有人都能玩得起這場游戲。

其次,大算力芯片企業(yè)需要能夠站到系統(tǒng)的角度思考問題,最終算力的呈現(xiàn)是一個集群系統(tǒng),這里面包含幾千張加速卡,幾千顆芯片,大量的互聯(lián)和存儲,很多服務器。整個系統(tǒng)的設計、調(diào)動能力、是否易用跟芯片的設計會不太一樣。這樣更能夠提供滿足用戶需求的產(chǎn)品。

在人工智能算力領域,燧原科技已經(jīng)有很深的積累。目前已經(jīng)迭代兩代訓練和推理產(chǎn)品,第三代在研發(fā)中。此外,燧原科技已經(jīng)在科研領域和智慧城市的應用中落地了訓練和推理的超千卡算力集群。張亞林表示,類似ChatGPT這樣的AIGC生成式模型,對于燧原科技而言是個機遇,公司可以把已經(jīng)積累的系統(tǒng)集群的經(jīng)驗推廣到更多的客戶賽道上,幫助客戶使能更多大模型的生成。

面對與國際巨頭的差距,天數(shù)智芯對電子發(fā)燒友表示,堅持通用GPU發(fā)展的路線,全面覆蓋訓練和推理兩條產(chǎn)品發(fā)展主線。結(jié)合行業(yè)解決方案為各行業(yè)、各產(chǎn)業(yè)發(fā)展提供完整成熟的軟硬件一體化方案。在未來的產(chǎn)品發(fā)展上,逐步縮小和國際先進產(chǎn)品的差距,為國內(nèi)人工智能發(fā)展提供強有力的支持。

天數(shù)智芯自2021年3月推出云端訓練通用GPU產(chǎn)品--天垓100,并于2022年12月推出云端推理通用GPU產(chǎn)品--智鎧100,截止目前,天數(shù)智芯訂單規(guī)模就已經(jīng)突破5億元。目前,基于天垓100訓練的模型種類超過了兩百種。天數(shù)智芯表示,公司在訓練芯片上堅持通用GPU架構(gòu)、主流生態(tài)兼容等發(fā)展路線,對于通用性、兼容性、安全性等方面都進行了支持,可以為ChatGPT的發(fā)展提供有效安全的算力底座。

對于以ChatGPT為代表的大模型訓練和部署,對通用GPU或者算力的高要求,登臨科技聯(lián)合創(chuàng)始人王平談到,從ChatGPT用戶數(shù)超1億,日訪問量幾千萬的數(shù)據(jù)來看,它的運營成本相當高,每天的電費達到幾十萬人民幣量級。他認為,這時候計算效率很重要,如果計算架構(gòu)相比于傳統(tǒng)的GPGPU更有優(yōu)勢的話,它在計算效率上也就會更有優(yōu)勢。

就比如登臨科技的一些計算密度更大的產(chǎn)品。登臨科技是一家專注于高性能通用計算平臺的芯片研發(fā)與技術(shù)創(chuàng)新的公司,登臨自主研發(fā)的GPU+架構(gòu)正式采用了軟件定義的片內(nèi)異構(gòu)體系,目前首款基于GPU+的系列產(chǎn)品—Goldwasser已在云至邊緣的各個應用場景實現(xiàn)規(guī)模化落地。據(jù)王平介紹,登臨科技希望通過異構(gòu),從由點及面在一些足夠大的市場領域,把產(chǎn)品做到比英偉達同系列產(chǎn)品更具性價比優(yōu)勢,甚至超過英偉達。

高速接口IP的機會和挑戰(zhàn)

就如上文所言,大模型的訓練需要大量的GPU,ChatGPT的訓練就使用了1萬張英偉達的高端GPU。然而從訓練的角度來看,計算性能再好的GPU芯片如A100如果無法集群在一起去訓練,那么訓練一個類ChatGPT的大模型可能需要上百年。因此,AI大模型的訓練對高速接口IP是一個巨大的挑戰(zhàn),也是一個巨大的機遇。

在以ChatGPT為代表的生成式AI大模型產(chǎn)業(yè)中,接口IP能夠發(fā)揮哪些作用呢?奎芯科技市場及戰(zhàn)略副總裁唐睿在接受電子發(fā)燒友網(wǎng)采訪時談到了幾點:

首先是芯片上的互聯(lián)接口,也就是Die to Die類型的互聯(lián)接口IP,包括UCIe等,用以擴充單芯片的計算能力;其次是Chip to Chip類型的互聯(lián)接口IP,包括SerDes/PCIe/CXL等,能夠加快芯片之間的互聯(lián)和數(shù)據(jù)交換,滿足更高帶寬的需求;此外還有內(nèi)存接口IP,包括SATA、DDR、HBM等,能夠用于打造更高性能的存儲產(chǎn)品,幫助類ChatGPT存儲和交換大規(guī)模的數(shù)據(jù);再上一層就是數(shù)據(jù)通訊接口的接口IP。因此,從訓練的角度來看,類ChatGPT應用的爆發(fā),能夠帶來非常大的接口IP需求。

奎芯科技成立于2021年,目前已經(jīng)推出的高速接口IP組合包括USB、PCIe、SATA、SerDes、MIPI、DDR、HDMI、DP、HBM等豐富的類型。唐睿指出,從技術(shù)上來看,國產(chǎn)接口IP廠商確實還處于追趕的位置,不過這種差距已經(jīng)越來越小。2023年,奎芯科技將會推出一系列性能達到國際領先水平的接口IP產(chǎn)品,包括HBM3以及其他領先的D2D類型的互聯(lián)接口IP。

當前,AI大模型訓練所用到的算力集群基本上都是基于英偉達通用算力芯片來打造,在這方面國產(chǎn)通用算力芯片還存在一定的性能差距。唐睿表示,國產(chǎn)高性能計算芯片還是有機會的,AI大模型并不是一個近期出現(xiàn)的新鮮事物,近些年國內(nèi)AI產(chǎn)業(yè)已經(jīng)在跟進這一趨勢,只是類ChatGPT類型應用背后的大模型參數(shù)規(guī)模更大。

針對這方面的需求,國內(nèi)芯片產(chǎn)業(yè)也早就啟動了這方面的布局,包括奎芯科技所在的接口IP賽道,都在向這個方向努力。不過,從IP研發(fā)到芯片設計,再到應用落地,這中間會有一個時間差。實際上,國外的公司也是在用之前的芯片通過互聯(lián)在做這方面的硬件支持。

服務器廠商的機會和挑戰(zhàn)

大模型的訓練和部署離不開服務器的支持。微軟Azure AI基礎設施總經(jīng)理尼迪·卡佩爾表示,他們構(gòu)建了一個系統(tǒng)架構(gòu),可以在非常大的范圍內(nèi)運行且十分可靠,這是ChatGPT成功的重要原因。云服務依賴于數(shù)千個不同的部件,包括服務器、管道、不同的金屬和礦物等。

近年來,在全球數(shù)字化、智能化的浪潮下,智能手機、自動駕駛、數(shù)據(jù)中心、圖像識別等應用推動AI服務器市場迅速成長。根據(jù)IDC數(shù)據(jù),2021年全球AI服務器市場規(guī)模已達到 145億美元,并預計2025年將超過260億美元。

近段時間ChatGPT概念的火熱,更是對算力基礎設施的需求起到了帶動作用。寧暢副總裁兼CTO趙雷此前在接受媒體采訪的時候表示,ChatGPT的訓練和部署,都需要大量智能計算數(shù)據(jù)存儲以及傳輸資源,計算機基礎設施、算力等上游技術(shù)將因此受益。

寧暢是一家集研發(fā)、生產(chǎn)、部署、運維一體的服務器廠商,及IT系統(tǒng)解決方案提供商。該公司很早就開始著重發(fā)力于人工智能服務器和液冷服務器。趙雷表示,公司目前在用的、在研的人工智能和液冷服務器,包括今年推出的浸沒液冷服務器,剛好跟上算力高速增長的市場需求。公司隨時準備著為客戶提供合適的高算力產(chǎn)品和解決方案。

在人工智能服務器方面,寧暢已經(jīng)推出多款產(chǎn)品,包括X620 G50、X660 G45、X640 G40、X620 G40。日前,百度正式發(fā)布大型語言模型文心一言,隨后寧暢聯(lián)合百度宣布寧暢AI服務器支持百度文心一言,寧暢憑借AI服務器產(chǎn)品及定制化服務,為百度文心一言提供算力保障。

目前國內(nèi)有不少優(yōu)秀的服務器廠商,除了上述提到的寧暢,還有浪潮信息、中科曙光等。不過整體來看,國內(nèi)在算力的提供商仍然存在瓶頸,比如總體算力不夠,算力分布不均。也就是說存在部分客戶算力過剩,部分客戶算力不足,或者A時間算力過剩,B時間算力不足的情況。短期來看,這個問題要靠云技術(shù)解決,長期來看是要提供過剩的算力。也就是說,需要云技術(shù)去平衡協(xié)調(diào)算力不均勻的問題,還需要提高算力、算力效率等。

另外還有算力成本的問題,雖然目前每單位算力單價已經(jīng)下降,但是過去幾年服務器的平均售價一直上漲。趙雷認為,可能算力類型單一,不太能夠有效地支撐高速增長的模式,可能要有各種各樣不同類型的算力。比如ChatGPT,是不是可以做針對GPT模型專門的ASIC。算力的應用類型越窄,它的效率就會越高,越通用效率就越低。

總結(jié)

顯然,隨著ChatGPT、GPT-4及文心一言等大型語言模型的發(fā)布,以及未來大模型在各個領域中實現(xiàn)部署應用,人們離期待已久的通用人工智能也就越來越近。而大模型的研發(fā)和應用部署,也將給算力芯片、接口IP、服務器等產(chǎn)業(yè)帶來前所未有的機會。同時國內(nèi)在這些領域具備自己的獨特優(yōu)勢,也面臨著諸多挑戰(zhàn)。這將會是一場持久戰(zhàn)。

種種跡象表明,大模型的應用即將走進千家萬戶,人工智能產(chǎn)業(yè)發(fā)展迎來高潮。大家知道,無論是ChatGPT、文心一言,還是其他生成式AI模型的訓練和部署,對算力都有很高的要求。那么目前國內(nèi)在這方面具備怎樣的條件?大模型的發(fā)展將帶來怎樣的機會和挑戰(zhàn)?帶著這些問題,電子發(fā)燒友最近對多家大算力芯片、接口IP、服務器企業(yè)做了深度調(diào)研。

大算力芯片的機會和挑戰(zhàn)

目前,全球大模型的訓練基本都是采用英偉達的GPU。OpenAI之前推出的ChatGPT,以及最近發(fā)布的GPT-4,都是在大量英偉達A100的基礎上訓練而成。據(jù)說微軟的Azure云服務為ChatGPT構(gòu)建了超過1萬枚英偉達A100GPU芯片的AI計算集群。

國內(nèi)大模型的訓練也基本倚賴英偉達的GPU,業(yè)內(nèi)人士認為,想要做好AI大模型,1萬枚英偉達A100芯片是門檻。然而國內(nèi)擁有1萬枚英偉達A100芯片的企業(yè)少之又少。從這個層面來看,國內(nèi)企業(yè)想要布局類似ChatGPT這樣大規(guī)模的模型短期來看還很難。

從長遠來看,未來大模型的研發(fā)和部署是必然趨勢,而每個大模型訓練和部署的背后,都有幾萬個GPU在支持。可想而知,未來隨著這方面的研發(fā)和應用的普及,通用GPU市場需求將會迎來爆發(fā)式增長。這對GPU企業(yè)來說將會是巨大的機會。

登臨科技聯(lián)合創(chuàng)始人王平在接受電子發(fā)燒友采訪的時候表示:“以電力為例,可以很清楚的看到這個市場未來的變化。幾十年前,電力只是用在一些小用量的場景,隨著電力的供給越來越多,電器也越來越多的時候,最后電力就成了一個基本設施。可以說,算力也是朝著基礎設施的方向在發(fā)展。而現(xiàn)在通用GPU還遠沒有到爆炸式需求的階段。”

然而從目前的情況來看,國內(nèi)的GPU還難以在大模型的訓練中承擔起重要責任,不過可以看到有不少企業(yè)在該領域持續(xù)耕耘。對于國內(nèi)的GPU企業(yè)可以怎么做,才能在抓住ChatGPT帶來的這波機會,如何為國內(nèi)大模型的發(fā)展提供算力支持?

在接受電子發(fā)燒友采訪的時候,燧原科技創(chuàng)始人兼COO張亞林談到了幾點:首先,企業(yè)需要能夠提供更高性價比的算力,從ChatGPT訓練就能看到算力的成本有多高,從這個角度來看,并不是所有人都能玩得起這場游戲。

其次,大算力芯片企業(yè)需要能夠站到系統(tǒng)的角度思考問題,最終算力的呈現(xiàn)是一個集群系統(tǒng),這里面包含幾千張加速卡,幾千顆芯片,大量的互聯(lián)和存儲,很多服務器。整個系統(tǒng)的設計、調(diào)動能力、是否易用跟芯片的設計會不太一樣。這樣更能夠提供滿足用戶需求的產(chǎn)品。

在人工智能算力領域,燧原科技已經(jīng)有很深的積累。目前已經(jīng)迭代兩代訓練和推理產(chǎn)品,第三代在研發(fā)中。此外,燧原科技已經(jīng)在科研領域和智慧城市的應用中落地了訓練和推理的超千卡算力集群。張亞林表示,類似ChatGPT這樣的AIGC生成式模型,對于燧原科技而言是個機遇,公司可以把已經(jīng)積累的系統(tǒng)集群的經(jīng)驗推廣到更多的客戶賽道上,幫助客戶使能更多大模型的生成。

面對與國際巨頭的差距,天數(shù)智芯對電子發(fā)燒友表示,堅持通用GPU發(fā)展的路線,全面覆蓋訓練和推理兩條產(chǎn)品發(fā)展主線。結(jié)合行業(yè)解決方案為各行業(yè)、各產(chǎn)業(yè)發(fā)展提供完整成熟的軟硬件一體化方案。在未來的產(chǎn)品發(fā)展上,逐步縮小和國際先進產(chǎn)品的差距,為國內(nèi)人工智能發(fā)展提供強有力的支持。

天數(shù)智芯自2021年3月推出云端訓練通用GPU產(chǎn)品--天垓100,并于2022年12月推出云端推理通用GPU產(chǎn)品--智鎧100,截止目前,天數(shù)智芯訂單規(guī)模就已經(jīng)突破5億元。目前,基于天垓100訓練的模型種類超過了兩百種。天數(shù)智芯表示,公司在訓練芯片上堅持通用GPU架構(gòu)、主流生態(tài)兼容等發(fā)展路線,對于通用性、兼容性、安全性等方面都進行了支持,可以為ChatGPT的發(fā)展提供有效安全的算力底座。

對于以ChatGPT為代表的大模型訓練和部署,對通用GPU或者算力的高要求,登臨科技聯(lián)合創(chuàng)始人王平談到,從ChatGPT用戶數(shù)超1億,日訪問量幾千萬的數(shù)據(jù)來看,它的運營成本相當高,每天的電費達到幾十萬人民幣量級。他認為,這時候計算效率很重要,如果計算架構(gòu)相比于傳統(tǒng)的GPGPU更有優(yōu)勢的話,它在計算效率上也就會更有優(yōu)勢。

就比如登臨科技的一些計算密度更大的產(chǎn)品。登臨科技是一家專注于高性能通用計算平臺的芯片研發(fā)與技術(shù)創(chuàng)新的公司,登臨自主研發(fā)的GPU+架構(gòu)正式采用了軟件定義的片內(nèi)異構(gòu)體系,目前首款基于GPU+的系列產(chǎn)品—Goldwasser已在云至邊緣的各個應用場景實現(xiàn)規(guī)模化落地。據(jù)王平介紹,登臨科技希望通過異構(gòu),從由點及面在一些足夠大的市場領域,把產(chǎn)品做到比英偉達同系列產(chǎn)品更具性價比優(yōu)勢,甚至超過英偉達。

高速接口IP的機會和挑戰(zhàn)

就如上文所言,大模型的訓練需要大量的GPU,ChatGPT的訓練就使用了1萬張英偉達的高端GPU。然而從訓練的角度來看,計算性能再好的GPU芯片如A100如果無法集群在一起去訓練,那么訓練一個類ChatGPT的大模型可能需要上百年。因此,AI大模型的訓練對高速接口IP是一個巨大的挑戰(zhàn),也是一個巨大的機遇。

在以ChatGPT為代表的生成式AI大模型產(chǎn)業(yè)中,接口IP能夠發(fā)揮哪些作用呢?奎芯科技市場及戰(zhàn)略副總裁唐睿在接受電子發(fā)燒友網(wǎng)采訪時談到了幾點:

首先是芯片上的互聯(lián)接口,也就是Die to Die類型的互聯(lián)接口IP,包括UCIe等,用以擴充單芯片的計算能力;其次是Chip to Chip類型的互聯(lián)接口IP,包括SerDes/PCIe/CXL等,能夠加快芯片之間的互聯(lián)和數(shù)據(jù)交換,滿足更高帶寬的需求;此外還有內(nèi)存接口IP,包括SATA、DDR、HBM等,能夠用于打造更高性能的存儲產(chǎn)品,幫助類ChatGPT存儲和交換大規(guī)模的數(shù)據(jù);再上一層就是數(shù)據(jù)通訊接口的接口IP。因此,從訓練的角度來看,類ChatGPT應用的爆發(fā),能夠帶來非常大的接口IP需求。

奎芯科技成立于2021年,目前已經(jīng)推出的高速接口IP組合包括USB、PCIe、SATA、SerDes、MIPI、DDR、HDMI、DP、HBM等豐富的類型。唐睿指出,從技術(shù)上來看,國產(chǎn)接口IP廠商確實還處于追趕的位置,不過這種差距已經(jīng)越來越小。2023年,奎芯科技將會推出一系列性能達到國際領先水平的接口IP產(chǎn)品,包括HBM3以及其他領先的D2D類型的互聯(lián)接口IP。

當前,AI大模型訓練所用到的算力集群基本上都是基于英偉達通用算力芯片來打造,在這方面國產(chǎn)通用算力芯片還存在一定的性能差距。唐睿表示,國產(chǎn)高性能計算芯片還是有機會的,AI大模型并不是一個近期出現(xiàn)的新鮮事物,近些年國內(nèi)AI產(chǎn)業(yè)已經(jīng)在跟進這一趨勢,只是類ChatGPT類型應用背后的大模型參數(shù)規(guī)模更大。

針對這方面的需求,國內(nèi)芯片產(chǎn)業(yè)也早就啟動了這方面的布局,包括奎芯科技所在的接口IP賽道,都在向這個方向努力。不過,從IP研發(fā)到芯片設計,再到應用落地,這中間會有一個時間差。實際上,國外的公司也是在用之前的芯片通過互聯(lián)在做這方面的硬件支持。

服務器廠商的機會和挑戰(zhàn)

大模型的訓練和部署離不開服務器的支持。微軟Azure AI基礎設施總經(jīng)理尼迪·卡佩爾表示,他們構(gòu)建了一個系統(tǒng)架構(gòu),可以在非常大的范圍內(nèi)運行且十分可靠,這是ChatGPT成功的重要原因。云服務依賴于數(shù)千個不同的部件,包括服務器、管道、不同的金屬和礦物等。

近年來,在全球數(shù)字化、智能化的浪潮下,智能手機、自動駕駛、數(shù)據(jù)中心、圖像識別等應用推動AI服務器市場迅速成長。根據(jù)IDC數(shù)據(jù),2021年全球AI服務器市場規(guī)模已達到 145億美元,并預計2025年將超過260億美元。

近段時間ChatGPT概念的火熱,更是對算力基礎設施的需求起到了帶動作用。寧暢副總裁兼CTO趙雷此前在接受媒體采訪的時候表示,ChatGPT的訓練和部署,都需要大量智能計算數(shù)據(jù)存儲以及傳輸資源,計算機基礎設施、算力等上游技術(shù)將因此受益。

寧暢是一家集研發(fā)、生產(chǎn)、部署、運維一體的服務器廠商,及IT系統(tǒng)解決方案提供商。該公司很早就開始著重發(fā)力于人工智能服務器和液冷服務器。趙雷表示,公司目前在用的、在研的人工智能和液冷服務器,包括今年推出的浸沒液冷服務器,剛好跟上算力高速增長的市場需求。公司隨時準備著為客戶提供合適的高算力產(chǎn)品和解決方案。

在人工智能服務器方面,寧暢已經(jīng)推出多款產(chǎn)品,包括X620 G50、X660 G45、X640 G40、X620 G40。日前,百度正式發(fā)布大型語言模型文心一言,隨后寧暢聯(lián)合百度宣布寧暢AI服務器支持百度文心一言,寧暢憑借AI服務器產(chǎn)品及定制化服務,為百度文心一言提供算力保障。

目前國內(nèi)有不少優(yōu)秀的服務器廠商,除了上述提到的寧暢,還有浪潮信息、中科曙光等。不過整體來看,國內(nèi)在算力的提供商仍然存在瓶頸,比如總體算力不夠,算力分布不均。也就是說存在部分客戶算力過剩,部分客戶算力不足,或者A時間算力過剩,B時間算力不足的情況。短期來看,這個問題要靠云技術(shù)解決,長期來看是要提供過剩的算力。也就是說,需要云技術(shù)去平衡協(xié)調(diào)算力不均勻的問題,還需要提高算力、算力效率等。

另外還有算力成本的問題,雖然目前每單位算力單價已經(jīng)下降,但是過去幾年服務器的平均售價一直上漲。趙雷認為,可能算力類型單一,不太能夠有效地支撐高速增長的模式,可能要有各種各樣不同類型的算力。比如ChatGPT,是不是可以做針對GPT模型專門的ASIC。算力的應用類型越窄,它的效率就會越高,越通用效率就越低。

總結(jié)

顯然,隨著ChatGPT、GPT-4及文心一言等大型語言模型的發(fā)布,以及未來大模型在各個領域中實現(xiàn)部署應用,人們離期待已久的通用人工智能也就越來越近。而大模型的研發(fā)和應用部署,也將給算力芯片、接口IP、服務器等產(chǎn)業(yè)帶來前所未有的機會。同時國內(nèi)在這些領域具備自己的獨特優(yōu)勢,也面臨著諸多挑戰(zhàn)。這將會是一場持久戰(zhàn)。

聲明:本文內(nèi)容及配圖由入駐作者撰寫或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場。文章及其配圖僅供工程師學習之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問題,請聯(lián)系本站處理。

舉報投訴

-

人工智能

+關注

關注

1791文章

46845瀏覽量

237535

發(fā)布評論請先 登錄

相關推薦

AI for Science:人工智能驅(qū)動科學創(chuàng)新》第4章-AI與生命科學讀后感

很幸運社區(qū)給我一個閱讀此書的機會,感謝平臺。

《AI for Science:人工智能驅(qū)動科學創(chuàng)新》第4章關于AI與生命科學的部分,為我們揭示了人工智能技術(shù)在生命科學領域中的廣泛應用和

發(fā)表于 10-14 09:21

《AI for Science:人工智能驅(qū)動科學創(chuàng)新》第一章人工智能驅(qū)動的科學創(chuàng)新學習心得

的同時,確保其公正性、透明度和可持續(xù)性,是當前和未來科學研究必須面對的重要課題。此外,培養(yǎng)具備AI技能的科研人才,也是推動這一領域發(fā)展的關鍵。

4. 激發(fā)創(chuàng)新思維

閱讀這一章,我被深深啟發(fā)的是人工智能

發(fā)表于 10-14 09:12

什么是AI服務器?AI服務器的優(yōu)勢是什么?

AI服務器是一種專門為人工智能應用設計的服務器,它采用異構(gòu)形式的硬件架構(gòu),通常搭載GPU、FPGA、ASIC等加速芯片,利用CPU與加速芯片

環(huán)球儀器助力應對服務器組裝挑戰(zhàn)

隨著智能化、云服務、AI等產(chǎn)業(yè)的發(fā)展,算力的作用日漸突出。服務器作為提供

算力:人工智能發(fā)展的新引擎

的算力支持。 但,算力的提升往往伴隨著高昂的成本,維護以及電力消耗都是不小的開支、高性能計算硬件的購置。此外,AI模型的規(guī)模和復雜性不斷增加,所需的

億鑄科技談大算力芯片面臨的技術(shù)挑戰(zhàn)和解決策略

隨著人工智能技術(shù)的飛速發(fā)展,算力已成為推動產(chǎn)業(yè)變革的關鍵力量,但大模型的快速發(fā)展,參數(shù)的爆發(fā),對于算

算力服務器為什么選擇GPU

隨著人工智能技術(shù)的快速普及,算力需求日益增長。智算中心的服務器作為支撐大規(guī)模數(shù)據(jù)處理和計算的核心設備,其性能優(yōu)化顯得尤為關鍵。而GPU

人工智能芯片與服務器芯片的區(qū)別

人工智能芯片(AI芯片)與服務器芯片在多個方面存在顯著差異,這些差異主要體現(xiàn)在設計目標、功能特性、應用場景以及技術(shù)

OpenAI推出新模型CriticGPT,用GPT-4自我糾錯

在人工智能領域,每一次技術(shù)的革新都標志著向更高級別智能邁進的一步。OpenAI,作為這一領域的佼佼者,近日再次引領了行業(yè)的新潮流。周四,該公司發(fā)布了一則令人振奮的新聞稿,宣布新推出了一款

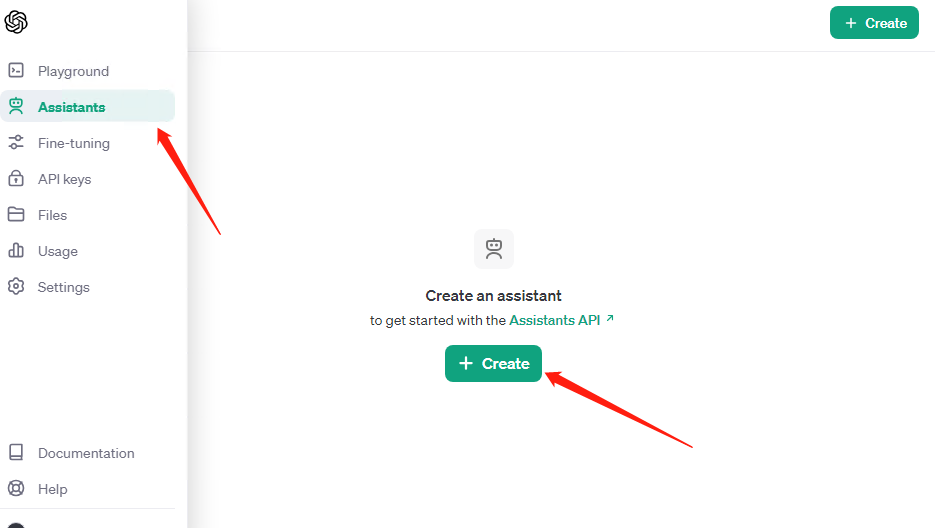

OpenAI API Key獲取:開發(fā)人員申請GPT-4 API Key教程

? OpenAI的GPT-4模型因其卓越的自然語言理解和生成能力,成為了許多開發(fā)者的首選工具。獲取GPT-4 API Key并將其應用于項目,如開發(fā)一個ChatGPT聊天應用,不僅是實踐人工智能

弘信電子簽訂算力服務器產(chǎn)品銷售合同

弘信電子的子公司甘肅燧弘人工智能科技有限公司與慶陽市京合云計算科技有限公司簽訂了算力服務器產(chǎn)品銷售合同 。

算力網(wǎng)絡面臨三大挑戰(zhàn)

2024年,以AIGC為代表的人工智能技術(shù)將進一步激發(fā)算力需求,算力網(wǎng)絡、智算中心、超

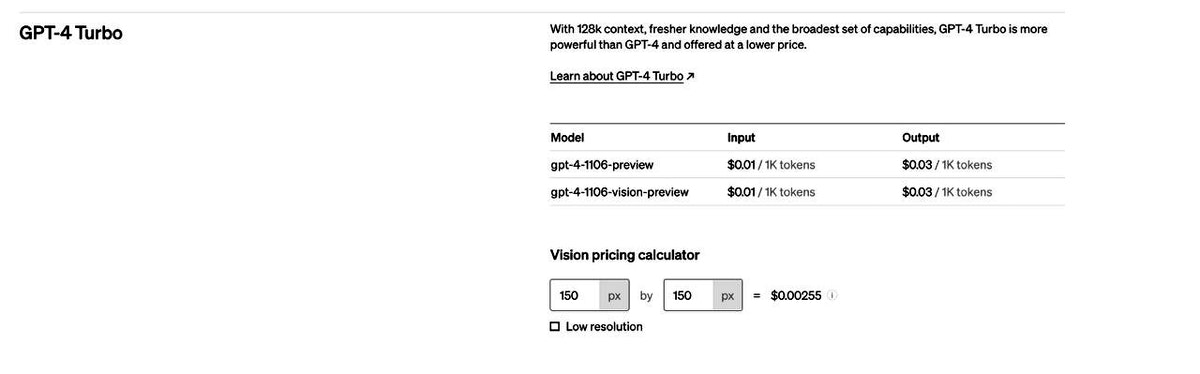

ChatGPT plus有什么功能?OpenAI 發(fā)布 GPT-4 Turbo 目前我們所知道的功能

的改進。在這里,我們全面了解GPT-4 Turbo是什么、它的主要功能以及它如何使開發(fā)人員和用戶受益。 了解 OpenAI 的最新更新、具有視覺功能的 GPT-4 Turbo 及其主要功能,包括改進的知識

OpenAI發(fā)布的GPT-4 Turbo版本ChatGPT plus有什么功能?

GPT-4的最新版本。OpenAI憑借承諾增強功能和成本效率的模型實現(xiàn)了巨大飛躍,為人工智能行業(yè)樹立了新標準。 我們來看看OpenAI帶來了什么: 文本和圖像理解 GPT-4 Turbo憑借兩個獨特的版本脫穎而出:以文本為中心的

GPT-4全面接入Office!人工智能迎來發(fā)展高潮,國內(nèi)算力芯片、接口IP、服務器的機會和挑戰(zhàn)!

GPT-4全面接入Office!人工智能迎來發(fā)展高潮,國內(nèi)算力芯片、接口IP、服務器的機會和挑戰(zhàn)!

評論