答者:sonta

NLP已經(jīng)死了

NLP社區(qū)可以大致分為兩個group: 一種是相信AGI的,一種是不相信的。

對于前者來說,LLM的興起當然是極其令人興奮的。之前的NLP模型對他們來說基本全是玩具,而LLM才是通往AGI的正確道路。他們會高呼生在這個時代極其幸運,并且all in LLM research。這無疑是正確的方向之一,如果你對LLM有興趣,野心和激情,那么all in LLM也是一個很不錯的選擇(如果有計算資源)。我摘錄一些dalao對LLM未來研究的建議(侵刪)僅供參考:

某dalao的建議

某LLM教父的twitter

可是對我來說,(API-driven or prompt-driven or ..) LLM research只能讓我感到無聊,并不能讓我感到興奮,所以我潤ML了,非必要不投*ACL(NLP潤ML人快來私戳,樂)。(Update:潤了,但沒完全潤,還是準備做點scale up一些非attention架構的work的)

我屬于第一類

后者的很多人應該像我一樣對LLM的research感到無聊,畢竟整個學科在越來越工程化。如果還打算繼續(xù)留下來做NLP research的,就需要好好想想如何說服自己,自己做的研究是有意義的。畢竟騙審稿人容易,騙自己難,做自己都認為沒價值的research還有什么樂趣呢?在LLM的邊邊角角繼續(xù)打不痛不癢的補丁,然后被GPT的下一個版本薄紗,那這樣,存在主義危機 (existential crisis) 就會像幽靈一樣陰魂不散。

因為我是做Parsing的,所以我很早之前就體會到現(xiàn)在許多人才體會到的心情(See 為什么研究NLP句法分析的人不多?- sonta的回答 - 知乎 https://www.zhihu.com/question/489981289/answer/2148458380) 。就算沒有LLM,在其他的比較強的神經(jīng)網(wǎng)絡里面,句法信息也是可有可無的。所以單純做句法這個方向從實用的角度來看基本上可以說是毫無意義的,跟現(xiàn)在在LLM時代做其他NLP任務一樣。那么我是如何說服自己做的呢?那當然是好玩。Parsing argubly是NLP最有意思的方向(從算法的好玩的角度來看)。現(xiàn)在的Parsing track已經(jīng)大約有一半的work干脆實驗都不做了,直接純理論分析向(感謝Jason Eisner, Ryan Cotterell),就講究一個好玩,樂。Parsing這種偏理論的方向至少還能玩玩理論,那么其他更加應用的方向呢?我不知道。反正我感覺沒啥好做的。

舉Parsing的例子主要是想說,Parsing領域的今天就是很多NLP子領域的明天。NLP很多dalao都是做Parsing起家,那他們?yōu)槭裁船F(xiàn)在不做了呢?因為Parsing is almost solved,他們當然轉向了其他更有前景的,unsolved的NLP子方向。而如今在LLM時代,NLP整個領域面臨solved,很多中間任務幾乎沒有存在的價值,

ChatGPT 印證了模型大一統(tǒng)的可行性,這在未來五年會對 NLP 從業(yè)者帶來怎樣的沖擊?(https://www.zhihu.com/question/575391861/answer/2832979762)

通向AGI之路:大型語言模型(LLM)技術精要(https://zhuanlan.zhihu.com/p/597586623)

甚至直接面向應用(e.g. 翻譯 潤色 糾錯 etc)的任務都面臨直接被GPT系列薄紗的危機, 那么小潤潤parsing,大潤或許可以考慮潤出做純NLP的research,例如跟我一樣潤ML,或者做一些NLP與其他學科的交叉,

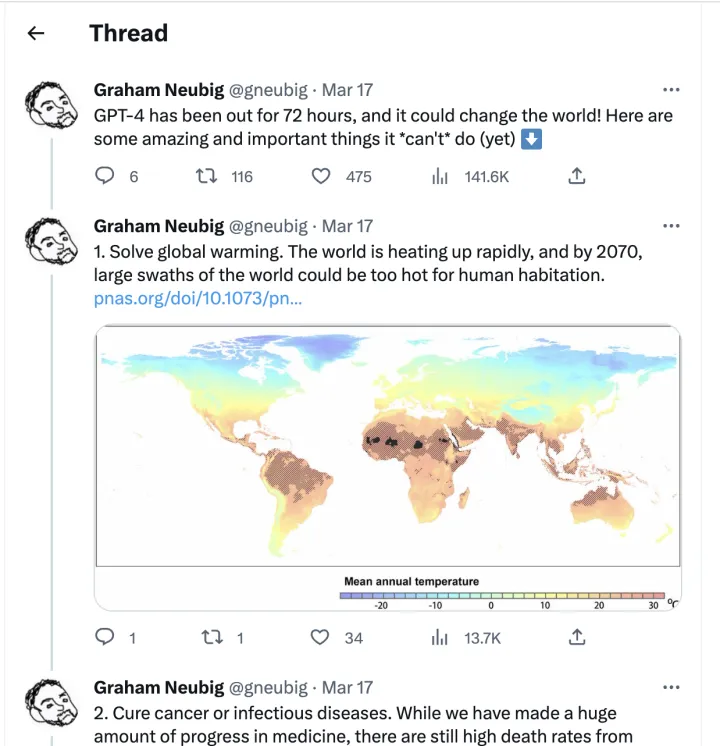

當然,你也可以跟著Neubig一起去做保護環(huán)境(狗頭

鏈接:https://www.zhihu.com/question/589704718/answer/2946475253

答者:霜清老人

鏈接:https://www.zhihu.com/question/589704718/answer/2945714404

答者:北極光

NLP community is broken

在過去,研究的意義是前瞻、指導應用發(fā)展。但如今 NLP 的學術研究已經(jīng)跟不上工業(yè)界的進步,用有限資源做出的 toy 在兩三個月的審稿周期后就已被淘汰。現(xiàn)在群魔亂舞的 peer-review 也無法有效評估和引導研究的價值,rebuttal、recycle 只會進一步浪費時間

一個越多被提及的說法是「ACL 系列會議愛收精致的垃圾」。NLP community 在歷史的慣性逐步衰減后可能會迎來凋亡,或者成為圈地自萌的娛樂場

鏈接:https://www.zhihu.com/question/589704718/answer/2946162537

答者:匿名用戶

沒在名校強組,資源有限,在讀博一,有點49年入國軍的感覺了,能夠感覺到這是AI時代,(巨頭公司/機構)大有可為,但和我沒什么關系了。大概在接下來的幾個月一兩年內能夠看到大模型顯著地改變無數(shù)人的生活、工作,創(chuàng)造出巨量的價值,明明我就在做相關的研究,但我不僅沒法參與到這一切中,甚至還讓自己原有的努力作廢。

本來找了個ACL22的新數(shù)據(jù)集,加點ICLR、ICML里學到最新的trick,投個C會練練手。好巧不巧是個文本生成任務,看了下自己用的BART-base(別問,問就是large跑不起來),再看了下ChatGPT和GPT-4生成的結果,思考了一下午我的工作意義在哪里,怎么編出來意義,我已經(jīng)想到審稿人在說:“糊弄的結果騙騙哥們兒可以,哥們打個哈哈就給你reject了,別真把自己騙了以為做的那坨東西就有意義了”。想了一下午,感覺或許能強行挽尊比GPT-3.5有限地強點,至于ChatGPT和GPT-4,無能為力。如果我的模型能勝出那只能是因為prompt沒選好。

畢竟還是需要發(fā)故事會達到畢業(yè)要求的,可以遇見未來只能試著去啃一啃大模型懶得去關注的邊邊角角,講一兩個自己都不相信的科幻故事,換個文憑。

update:看了下評論大伙評論的一些觀點:

快潤:小潤交叉學科,大潤跨學科,超大潤直接退學。感覺如果是碩士生還是硬著頭皮做下去畢業(yè)就行。答主自己打算趁著最后一點時間,努力把手頭做的工作投出去,之后無論是實習還是交換都會有底氣一些。目前來看組里面也比較迷茫,不是很確定接下來做什么。大概率是去做NLP應用到某個具體領域(結合做的工程項目),但這樣的交叉領域能不能讓組里的大伙畢業(yè)完全不好說。

做LLM相關工作/api-driven的科研:可能這樣的工作手快發(fā)幾篇論文或者混個碩士畢業(yè)沒問題,但是很難攢成一個博士畢業(yè)要求大論文的工作,大概率在開題之后的半年到一年,之前的工作就被新的LLM薄紗了,除了極少數(shù)有資源的博士生之外,很難專門去做LLM相關工作。

鏈接:https://www.zhihu.com/question/589704718/answer/2946249350

答者:劉聰NLP

有資源的NLPer,研究大模型基座;少資源的NLPer,研究大模型微調;沒資源的NLPer,研究接口調用。

沒有資源的,為什么不研究prompt模板呢,因為也已經(jīng)有自動化模板生成API。

不開玩笑的說,大模型賦予小模型更多能力的工作,可能是之后要研究的重點,畢竟10億參數(shù)的模型部署還可以嘗試,100億甚至1000億的模型對于企業(yè)來說還是壓力過大的。

鏈接:https://www.zhihu.com/question/589704718/answer/2946686094

答者:艾倫

坐標美國 Top 10 的 CS PhD。

最近聽到很多NLP換方向的故事。我本人當初本來想做NLP方向,剛開始讀博時臨時改成Data Mining。

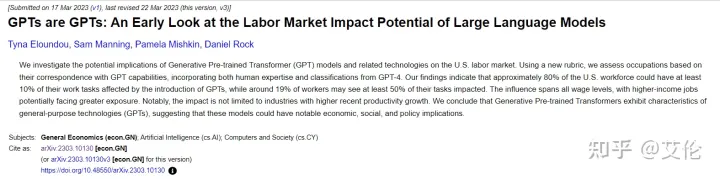

可以看到這是AI領域內的失業(yè),將來領域外必然更多。詳見以下論文:

曾經(jīng)人們還坦言人類的創(chuàng)造力機器無法輕易取代,而現(xiàn)在來看,AI在很多方面的創(chuàng)造力甚至遠高于人類

接下來可能會發(fā)生的事情:

會有一場超大模型的軍備競賽。先前大廠普遍認為搞超大模型沒前途。從成本出發(fā),無論是大規(guī)模高質量的數(shù)據(jù)標注還是模型訓練,都很少有人愿意接受,大廠工程師們吃著安穩(wěn)飯,更是不敢把身家性命抵到這種高成本卻前途未卜的事情上。OpenAI是一家小而精,且對大模型有著極高信仰的組織。OpenAI 把事情做絕,用 ChatGPT 和 GPT-4證明了把模型做大所能達到的境界。其他大廠得以說服自己(以及PMs),順著這個方向把模型做得更大更powerful。

NLP和CV方向會從學術界轉向工業(yè)界的趨勢。此處“工業(yè)界”特指有財力和資源實行大規(guī)模、高質量數(shù)據(jù)標注,以及超大模型訓練的Big Tech。學術界當前的研究像小打小鬧,這種小作坊的模式終究無法和大廠匹敵。試想一下,一個實驗室?guī)讉€PhD搶8塊V100能做出什么呢?

NLP頂會會涌現(xiàn)出一大批在各個應用場景(e.g. social network, biomedical, text generation...)evaluate ChatGPT/GPT-4的文章,包括但不限于ACL/EMNLP/NAACL/EACL,這就跟當年 transformer 走紅時一樣

雖然GPT-4讓很多傳統(tǒng) NLP 研究死掉,但也會開辟一些新坑。比如

DeepFake Detection 和 Misinformation Detection,因為將來社交網(wǎng)絡上很多內容都會是GPT生成的,不僅僅是 GPT-4 的textual output這么簡單(Generated Audio, Images, Videos, etc)

Societal Impacts of GPT-4,這和Social Computing更相關,不僅限于NLP研究了

感覺最近每一天都在印證未來簡史中的情節(jié)。未來,已來

審核編輯 :李倩

-

算法

+關注

關注

23文章

4601瀏覽量

92673 -

GPT

+關注

關注

0文章

352瀏覽量

15318 -

nlp

+關注

關注

1文章

487瀏覽量

22015

原文標題:GPT-4 發(fā)布后,你的 NLP 研究發(fā)生了怎樣的變化?

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

GPT-4發(fā)布!多領域超越“人類水平”,專家:國內落后2-3年

ChatGPT升級 OpenAI史上最強大模型GPT-4發(fā)布

ChatGPT又進化了,GPT-4發(fā)布

GPT-4 的模型結構和訓練方法

人工通用智能的火花:GPT-4的早期實驗

GPT-4已經(jīng)會自己設計芯片了嗎?

gpt-4怎么用 英特爾Gaudi2加速卡GPT-4詳細參數(shù)

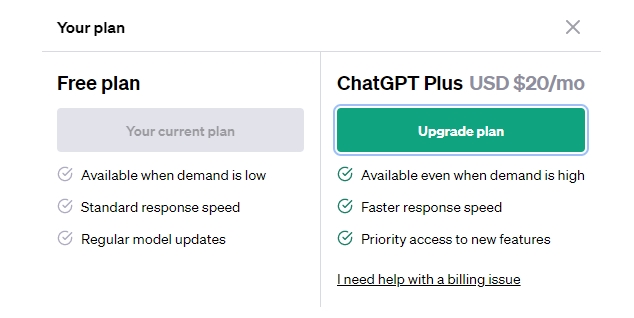

GPT-3.5 vs GPT-4:ChatGPT Plus 值得訂閱費嗎 國內怎么付費?

chatGPT和GPT4有什么區(qū)別

GPT-4沒有推理能力嗎?

ChatGPT plus有什么功能?OpenAI 發(fā)布 GPT-4 Turbo 目前我們所知道的功能

GPT-4發(fā)布后,你的NLP研究發(fā)生了怎樣的變化?

GPT-4發(fā)布后,你的NLP研究發(fā)生了怎樣的變化?

評論