編者按:

自古以來,人類形象已被廣泛記錄在繪畫、雕塑等形式多樣的藝術(shù)作品中,但目前大多數(shù)以人為中心的計(jì)算機(jī)視覺任務(wù),都僅僅關(guān)注了現(xiàn)實(shí)世界中的真實(shí)照片,而忽略了人在虛擬場景下的表征。

針對(duì)于此,IDEA 研究院的 CVPR 2023 入選論文之一“Human-Art: A Versatile Human-Centric Dataset Bridging Natural and Artificial Scenes”,提出了首個(gè)同時(shí)包含現(xiàn)實(shí)和虛擬場景的大規(guī)模全場景人體數(shù)據(jù)集 Human-Art,現(xiàn)已正式開源。

本期《IDEA有研知》為你詳細(xì)介紹Human-Art 數(shù)據(jù)集及下游任務(wù)表現(xiàn)。另外,本文作者在博士階段首篇投稿論文即中CVPR,文末“科研有門道”環(huán)節(jié)將帶你一同聽聽她的科研心得~

話不多說

先來看看 Human-Art 輔助訓(xùn)練的模型效果

天馬行空的兒童簡筆畫,大人未必?cái)?shù)得清

用Human-Art訓(xùn)練的模型能輕松辨認(rèn)計(jì)算

創(chuàng)作中國傳統(tǒng)皮影畫,已有模型束手無策?

用Human-Art訓(xùn)練一下,一鍵即可生成

左:原始Stable Diffusion模型生成圖

右:使用包含Human-Art數(shù)據(jù)微調(diào)后的模型生成圖

上圖給定文本:

“一張描述了三個(gè)人坐在中國亭子的皮影戲圖片”

上圖給定文本:

“一張描述了三個(gè)女人走路的色彩豐富的皮影戲圖片”

Human-Art 數(shù)據(jù)集現(xiàn)已正式開源

涵蓋5個(gè)真實(shí)場景和15個(gè)虛擬場景

代碼地址:

https://github.com/IDEA-Research/HumanArt

項(xiàng)目主頁:

https://idea-research.github.io/HumanArt/

5萬張圖像,超12.3萬個(gè)人物形象,

Human-Art為CV領(lǐng)域拓展虛擬場景

在照相機(jī)發(fā)明前,人類形象已在各類藝術(shù)創(chuàng)作載體上被記錄和呈現(xiàn)。從古代的壁畫到紙上的水墨畫、油畫,以及姿態(tài)豐富的人體雕塑,再到如今AIGC創(chuàng)作出各種各樣的虛擬人物,大量的藝術(shù)作品同樣提供了與人體相關(guān)的、豐富多樣的視覺數(shù)據(jù)。

然而,現(xiàn)有的計(jì)算機(jī)視覺任務(wù)、訓(xùn)練的數(shù)據(jù)集等大多只關(guān)注到了真實(shí)世界的照片,這導(dǎo)致相關(guān)模型在更豐富的場景下,常常出現(xiàn)性能下降甚至完全失效的問題。即使是SOTA性能的人體檢測模型,面對(duì)虛擬場景的人體數(shù)據(jù)時(shí)也往往令人大失所望,檢測準(zhǔn)確率不足20%。

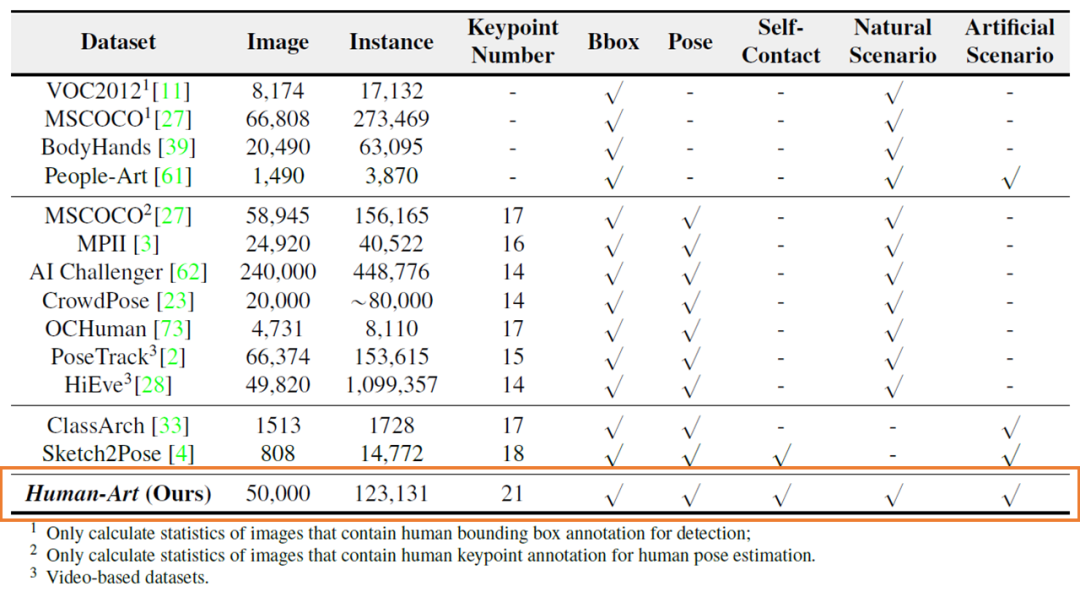

已有工作關(guān)注到了虛擬場景數(shù)據(jù)集稀缺的問題,如ClassArch、Sketch2Pose、People-Art等數(shù)據(jù)集納入了人造場景下的數(shù)據(jù),但都存在數(shù)據(jù)規(guī)模小(最多的ClassArch也僅收集了1513張照片),僅能支持單一場景的人體檢測任務(wù)等不足。

Human-Art數(shù)據(jù)集與常用數(shù)據(jù)集的對(duì)比

經(jīng)過近半年的工作,本文研究團(tuán)隊(duì)收集了來自5個(gè)現(xiàn)實(shí)場景和15個(gè)虛擬場景的5萬張高質(zhì)量圖像,提出了首個(gè)同時(shí)包含現(xiàn)實(shí)和虛擬場景,具有人體框、人體關(guān)鍵點(diǎn)、自接觸點(diǎn)及文本描述的多場景大規(guī)模數(shù)據(jù)集Human-Art,彌補(bǔ)了先前數(shù)據(jù)集場景不足等問題。

Human-Art選取的場景,包括3個(gè)3D虛擬場景和12個(gè)2D虛擬場景。圖片風(fēng)格除了常見的油畫、水墨畫等繪畫外,還有線條簡單的兒童簡筆畫、素描畫,形象大小各異的卡通畫,造型和服裝繁復(fù)的手辦模型,以及中國傳統(tǒng)的皮影等等。不同的場景都存在一定的數(shù)據(jù)處理難題,部分場景如雕塑、壁畫的人物形象殘缺或極難辨認(rèn)等,需要研究團(tuán)隊(duì)耗費(fèi)大量時(shí)間和人力解決。(小編:聽說搭建數(shù)據(jù)集初期收集了近100萬張圖片,需要靠作者肉眼快速辨認(rèn)才完成初篩……)經(jīng)年累月斑駁褪色、細(xì)節(jié)難辨的壁畫

也是Human-Art數(shù)據(jù)集涵蓋的場景之一

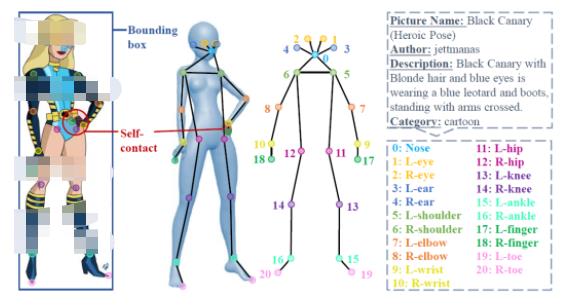

Human-Art 每張圖片標(biāo)注了人體框、21 個(gè)人體關(guān)鍵點(diǎn)、自接觸點(diǎn)及文本描述信息。為方便學(xué)術(shù)界和工業(yè)界的使用,Human-Art定義的21個(gè)人體關(guān)鍵點(diǎn)擴(kuò)展了真實(shí)人體數(shù)據(jù)集MSCOCO中定義的17個(gè)關(guān)鍵點(diǎn),新增4個(gè)腳趾尖、手指尖關(guān)鍵點(diǎn)。

Human-Art的21個(gè)標(biāo)注點(diǎn)信息

Human-Art 可支持多項(xiàng)人體相關(guān)的計(jì)算機(jī)視覺任務(wù),如全場景人體檢測、全場景人體 2D/3D 姿態(tài)估計(jì)、全場景人體圖片生成,并為各項(xiàng)下游任務(wù)提供基準(zhǔn)結(jié)果。相信未來將有助于提升各類模型在虛擬場景下訓(xùn)練的性能,也可以為更多研究方向如 out-of-distribution(OOD)問題等提供幫助,為學(xué)術(shù)界帶來更多思考。

支持多項(xiàng)以人為主的下游視覺任務(wù),

經(jīng)Human-Art訓(xùn)練的模型表現(xiàn)如何?

下游任務(wù)一:人體檢測

人體檢測(Human Detection)是從場景中識(shí)別并框出人物。過往的檢測方案存在兩個(gè)問題:一是大多選用通用的物體數(shù)據(jù)集訓(xùn)練,沒有特別針對(duì)人做檢測,二是使用的數(shù)據(jù)集通常僅僅包含現(xiàn)實(shí)場景,人體檢測器在虛擬風(fēng)格上的泛化性極差。

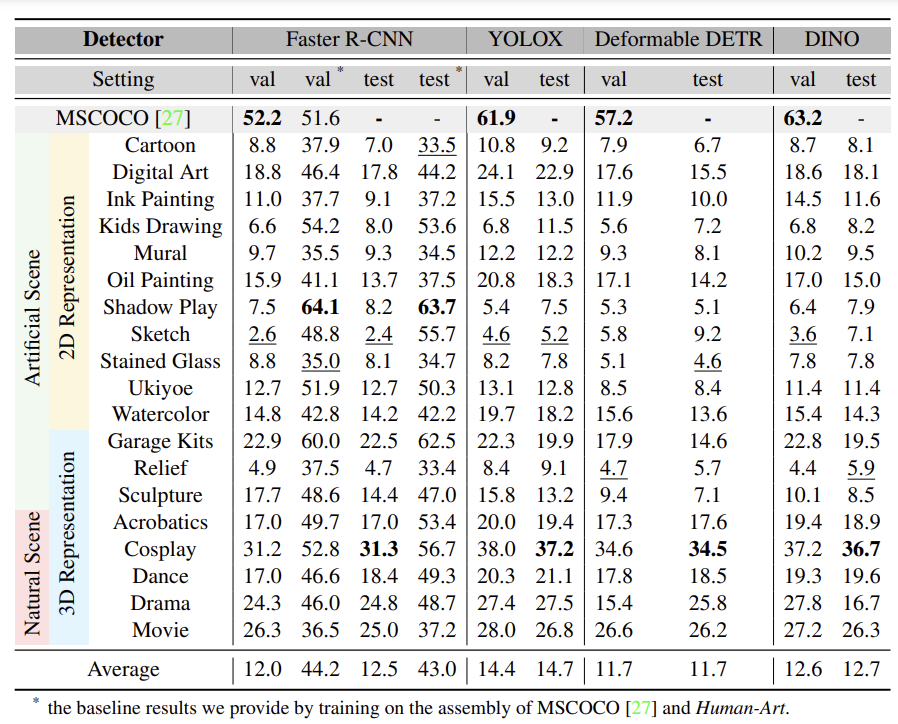

Human-Art中的圖片均以人為中心,支持對(duì)風(fēng)格更具包容性的人體檢測器訓(xùn)練。為了論證Human-Art數(shù)據(jù)集對(duì)于多風(fēng)格訓(xùn)練的作用,研究團(tuán)隊(duì)在四個(gè)檢測器(Faster R-CNN、YOLOX、Deformable DETR、DINO)上進(jìn)行了實(shí)驗(yàn)。

四種主要檢測器

使用Human-Art訓(xùn)練測試結(jié)果

可以看到,未經(jīng)過Human-Art訓(xùn)練的檢測器在多風(fēng)格人體數(shù)據(jù)上表現(xiàn)極差,而經(jīng)過訓(xùn)練后,F(xiàn)aster R-CNN檢測準(zhǔn)確率在皮影風(fēng)格上的提升可以高達(dá)56%,平均準(zhǔn)確率提升達(dá)到31%。

下游任務(wù)二:2D人體姿態(tài)估計(jì)

人體姿態(tài)估計(jì)(Human Pose Estimation)是通過圖片還原其中人體關(guān)鍵點(diǎn)的位置,主要?jiǎng)澐譃?D人體姿態(tài)估計(jì)和3D人體姿態(tài)估計(jì)。復(fù)雜姿態(tài)、遮擋和多樣化的背景,使其仍然相當(dāng)具有挑戰(zhàn)性。

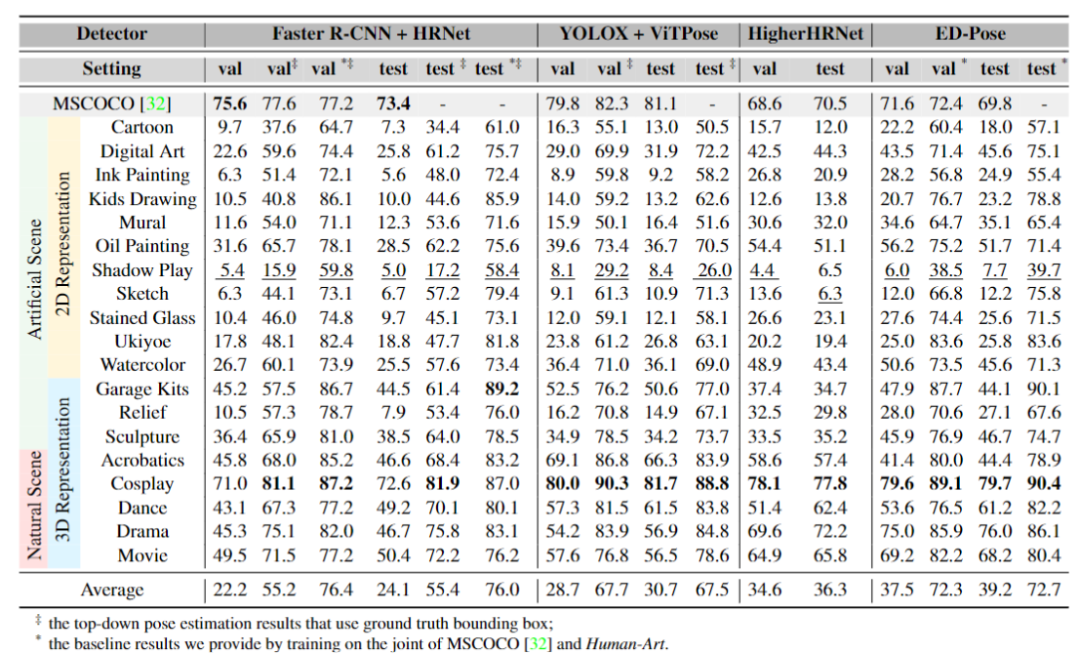

2D人體姿態(tài)估計(jì)可以被主要分為三類:自頂向下的方法(top-down)、自底向上的方法(bottom-up),以及單階段方法(one-stage)。與人體檢測類似,人體姿態(tài)識(shí)別也存在在虛擬風(fēng)格上的泛化性問題。

2D人體姿態(tài)估計(jì)中

使用Human-Art訓(xùn)練前后對(duì)比

研究團(tuán)隊(duì)在實(shí)驗(yàn)中對(duì)比了三類方法在Human-Art上的結(jié)果。由于自頂向下的方法嚴(yán)重依賴于檢測器,使用未經(jīng)訓(xùn)練的人體姿態(tài)檢測器直接測試后的表現(xiàn)較難提升。相比之下,自底向上和單階段方法訓(xùn)練的檢測器達(dá)到了更高精度,如自底向上方法HigherHRNet在多風(fēng)格數(shù)據(jù)上的結(jié)果相比自頂向下的SOTA方法ViTPose有約6個(gè)點(diǎn)的提升,單階段方法ED-Pose框架訓(xùn)練的模型準(zhǔn)確率更是高出近10個(gè)點(diǎn)。(拓展了解:ICLR 2023入選論文ED-Pose)

下游任務(wù)三:3D人體姿態(tài)估計(jì)

單目3D人體姿態(tài)估計(jì)的深度信息檢測一直是任務(wù)難題,Human-Art標(biāo)注的自接觸點(diǎn)信息能優(yōu)先緩解這一問題。自接觸點(diǎn)通過合理的深度優(yōu)化,將接觸區(qū)域映射到粗略SMPL模型(一種常用3D人體姿態(tài)的表征方法)的頂點(diǎn)上,最小化接觸頂點(diǎn)之間的距離。

Human-Art標(biāo)注的自接觸關(guān)鍵點(diǎn)

能幫助優(yōu)化3D人體姿態(tài)估計(jì)

下游任務(wù)四:圖片生成

Stable Diffusion等模型的提出,讓圖片生成任務(wù)成為領(lǐng)域內(nèi)外的話題熱點(diǎn)。然而現(xiàn)有生成的人物類圖像,仍存在如多手多腳/少手少腳、肢體位置錯(cuò)亂等問題,且無法更為精準(zhǔn)地控制生成地人體姿態(tài)等。

Human-Art提供了豐富的以人為中心的圖片及對(duì)應(yīng)標(biāo)注,能為生成具有合理結(jié)構(gòu)人體的圖片提供了良好先驗(yàn)。同時(shí),由于其豐富的標(biāo)注,Human-Art可以有效輔助可控生成(如Text2Image、Pose & Text2Image),例如使用姿態(tài)信息(Pose)和文本(Text)信息訓(xùn)練作為條件指導(dǎo)生成。

Pose & Text2Image模型效果對(duì)比

圖中Ours為基于Stable Diffusion改進(jìn)的模型

在Human-Art及其他數(shù)據(jù)上共同訓(xùn)練的結(jié)果

審核編輯 :李倩

-

計(jì)算機(jī)視覺

+關(guān)注

關(guān)注

8文章

1696瀏覽量

45929 -

數(shù)據(jù)集

+關(guān)注

關(guān)注

4文章

1205瀏覽量

24648

原文標(biāo)題:CVPR 2023 | 港中大&IDEA開源首個(gè)大規(guī)模全場景人體數(shù)據(jù)集Human-Art

文章出處:【微信號(hào):CVer,微信公眾號(hào):CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

港中大IDEA開源首個(gè)大規(guī)模全場景人體數(shù)據(jù)集Human-Art

港中大IDEA開源首個(gè)大規(guī)模全場景人體數(shù)據(jù)集Human-Art

評(píng)論