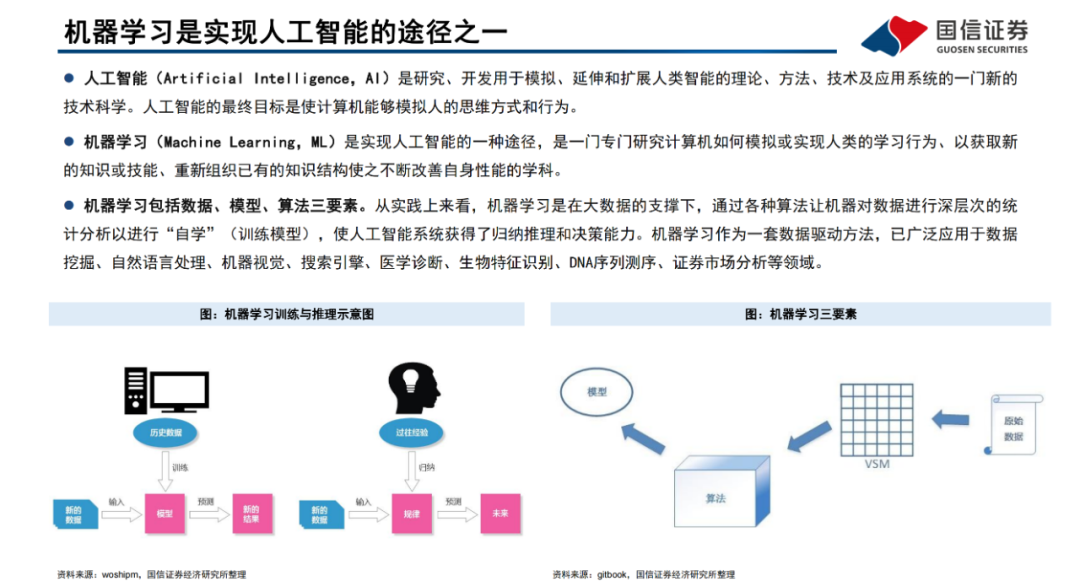

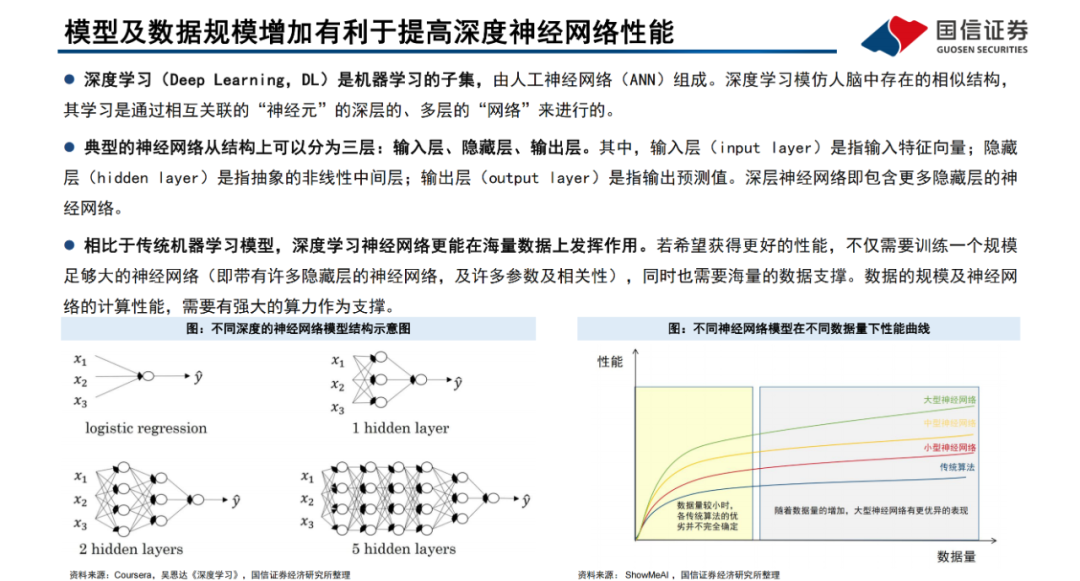

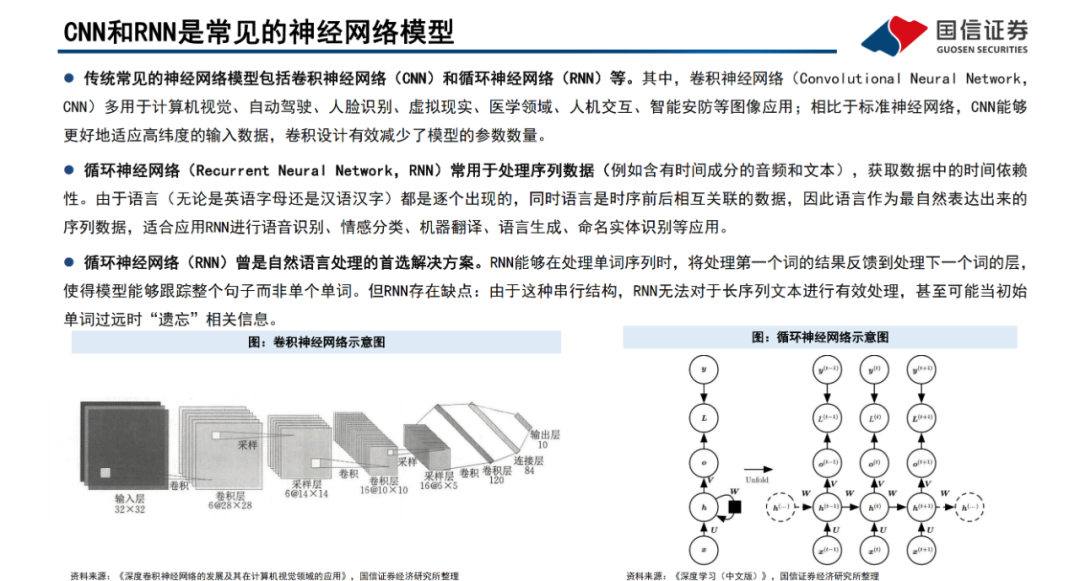

機(jī)器學(xué)習(xí)是一門(mén)專門(mén)研究計(jì)算機(jī)如何模擬或?qū)崿F(xiàn)人類(lèi)的學(xué)習(xí)行為、以獲取新的知識(shí)或技能、重新組織已有的知識(shí)結(jié)構(gòu)使之不斷改善自身性能的學(xué)科,廣泛應(yīng)用于數(shù)據(jù)挖掘、計(jì)算機(jī)視覺(jué)、自然語(yǔ)言處理等領(lǐng)域。深度學(xué)習(xí)是機(jī)器學(xué)習(xí)的子集,主要由人工神經(jīng)網(wǎng)絡(luò)組成。與傳統(tǒng)算法及中小型神經(jīng)網(wǎng)絡(luò)相比,大規(guī)模的神經(jīng)網(wǎng)絡(luò)及海量的數(shù)據(jù)支撐將有效提高深度神經(jīng)網(wǎng)絡(luò)的表現(xiàn)性能。

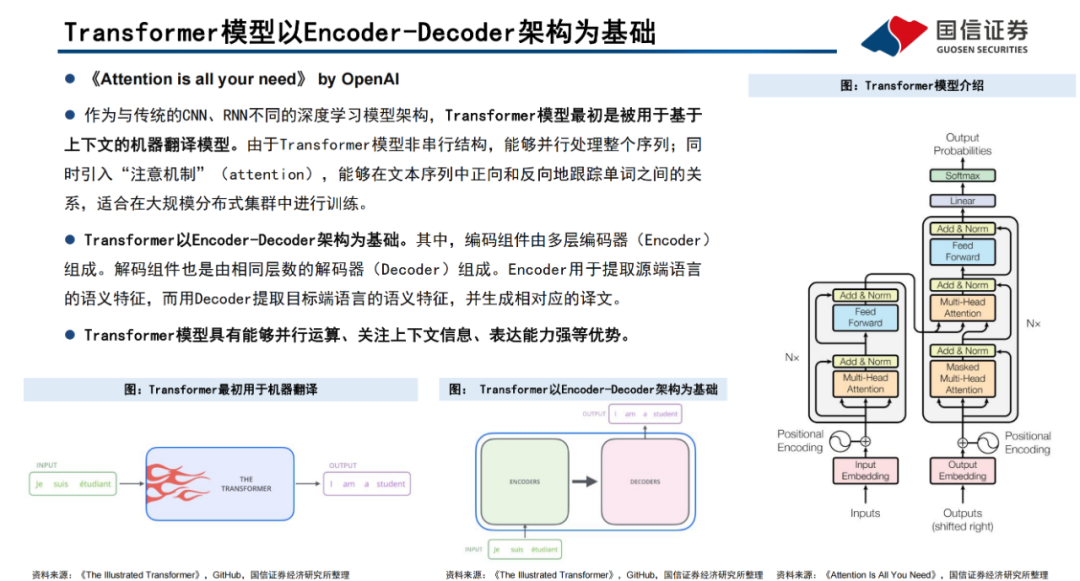

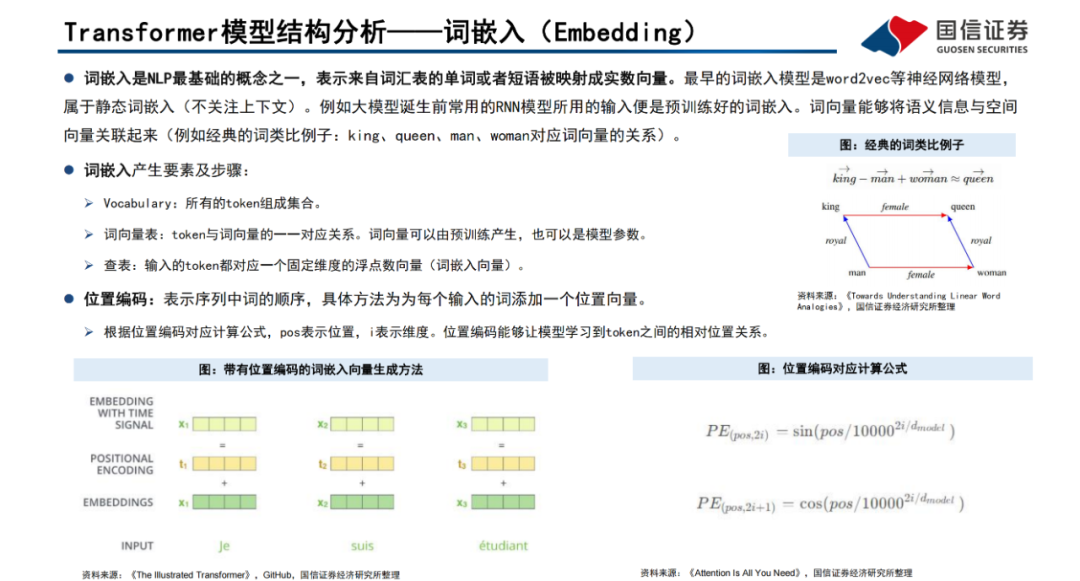

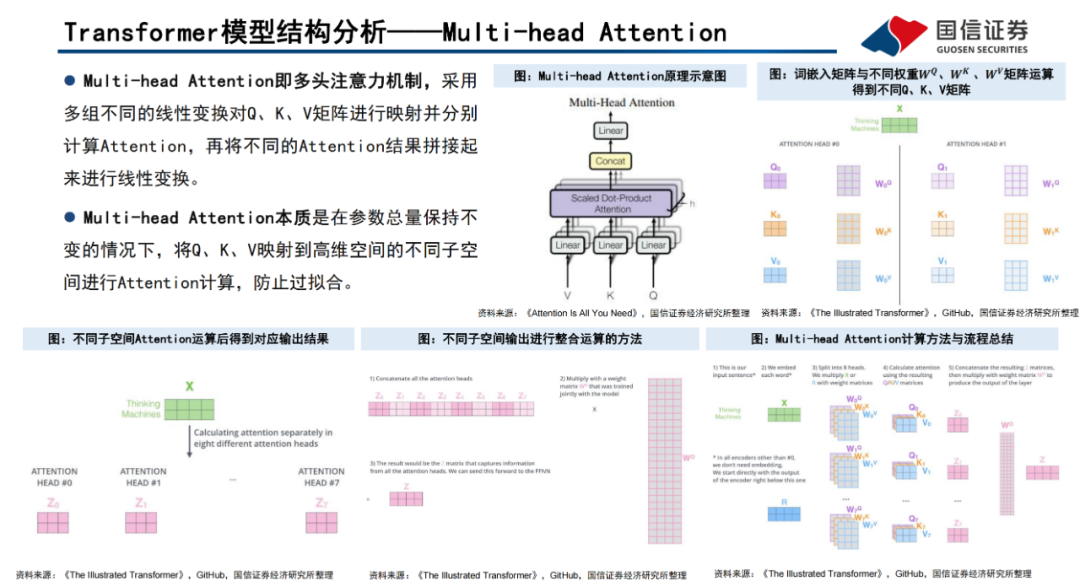

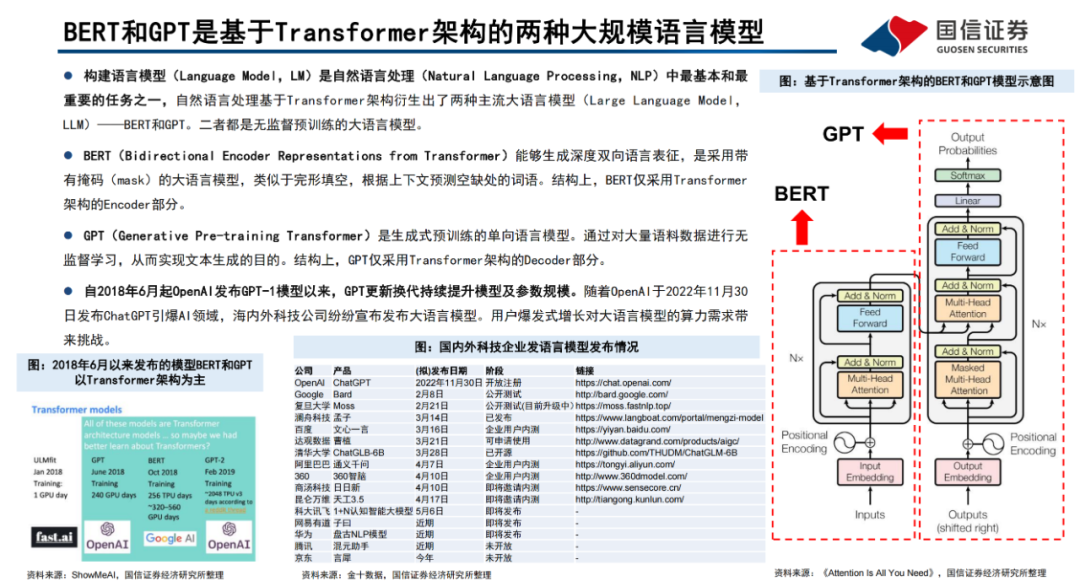

Transformer模型是一種非串行的神經(jīng)網(wǎng)絡(luò)架構(gòu),最初被用于執(zhí)行基于上下文的機(jī)器翻譯任務(wù)。Transformer模型以Encoder-Decoder架構(gòu)為基礎(chǔ),能夠并行處理整個(gè)文本序列,同時(shí)引入“注意機(jī)制”(Attention),使其能夠在文本序列中正向和反向地跟蹤單詞之間的關(guān)系,適合在大規(guī)模分布式集群中進(jìn)行訓(xùn)練,因此具有能夠并行運(yùn)算、關(guān)注上下文信息、表達(dá)能力強(qiáng)等優(yōu)勢(shì)。Transformer模型以詞嵌入向量疊加位置編碼作為輸入,使得輸入序列具有位置上的關(guān)聯(lián)信息。

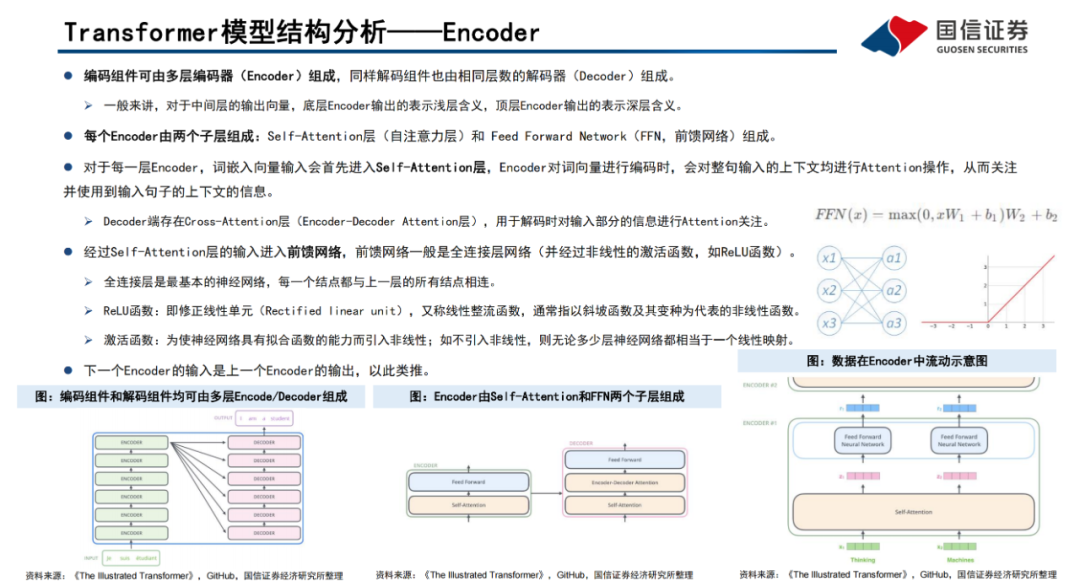

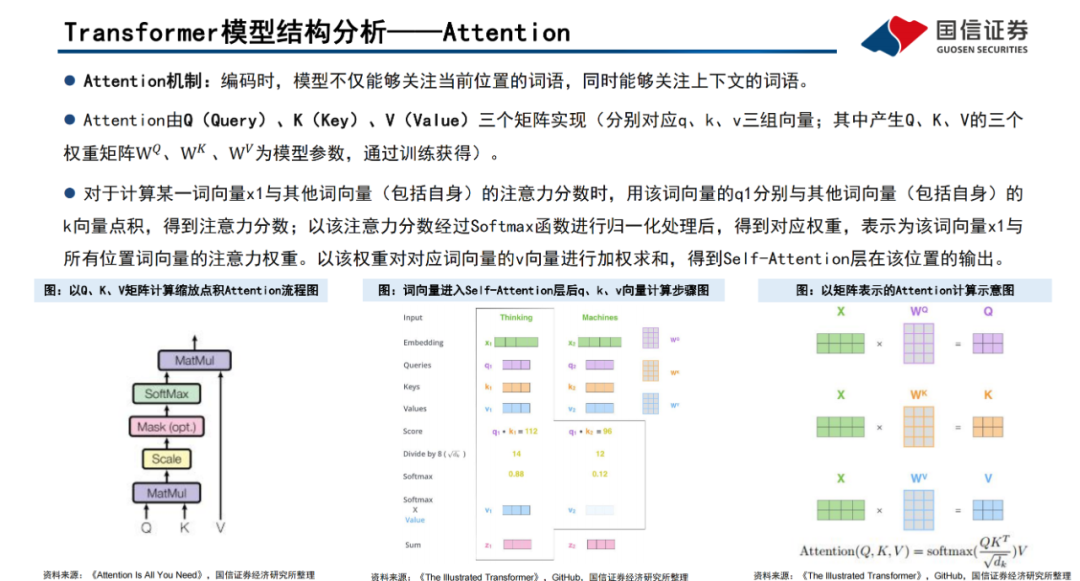

編碼器(Encoder)由Self-Attention(自注意力層)和 Feed Forward Network(前饋網(wǎng)絡(luò))兩個(gè)子層組成,Attention使得模型不僅關(guān)注當(dāng)前位置的詞語(yǔ),同時(shí)能夠關(guān)注上下文的詞語(yǔ)。

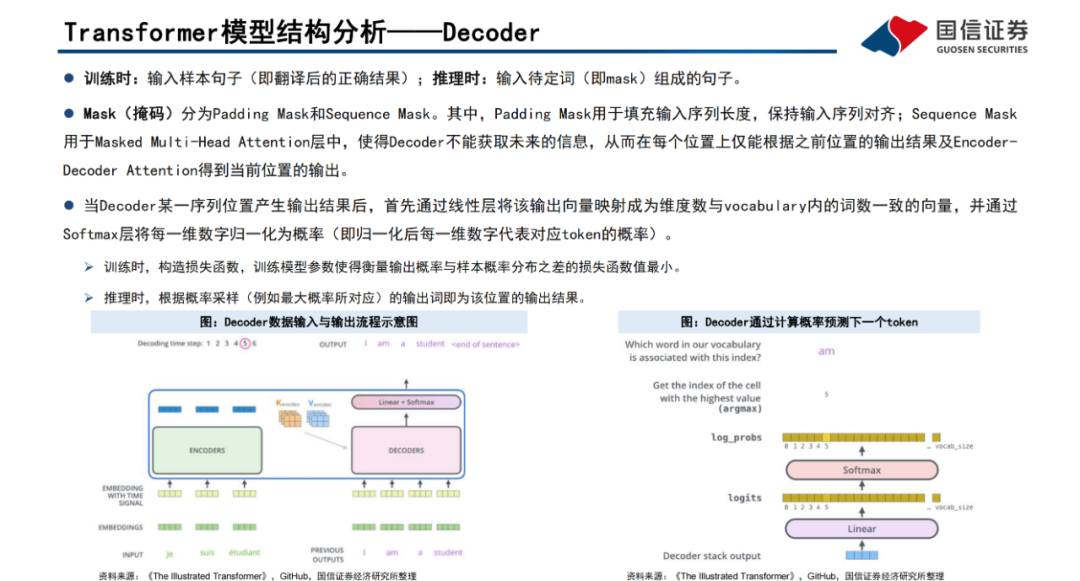

解碼器(Decoder)通過(guò)Encoder-DecoderAttention層,用于解碼時(shí)對(duì)于輸入端編碼信息的關(guān)注;利用掩碼(Mask)機(jī)制,對(duì)序列中每一位置根據(jù)之前位置的輸出結(jié)果循環(huán)解碼得到當(dāng)前位置的輸出結(jié)果。

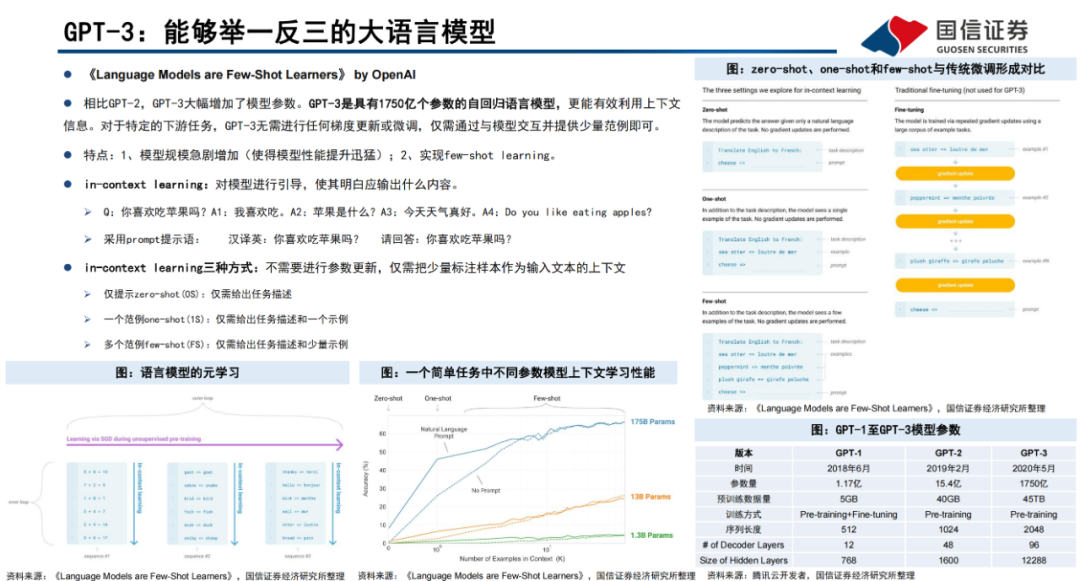

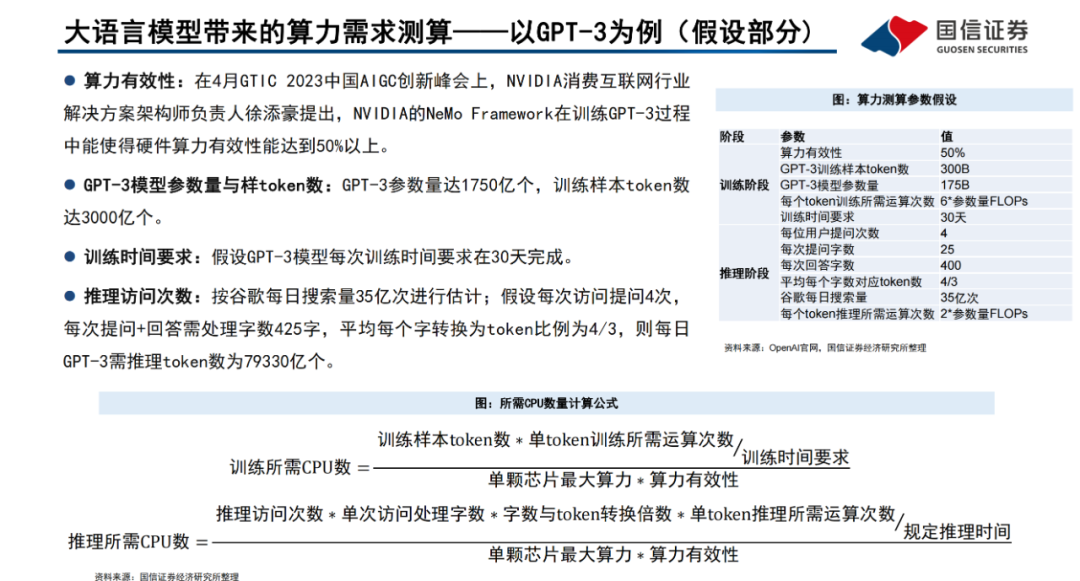

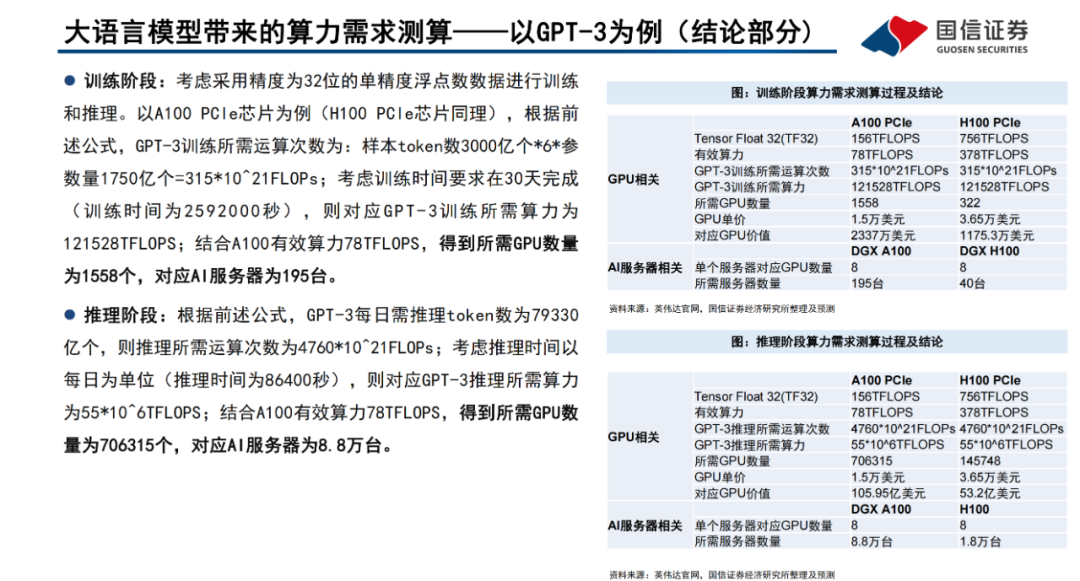

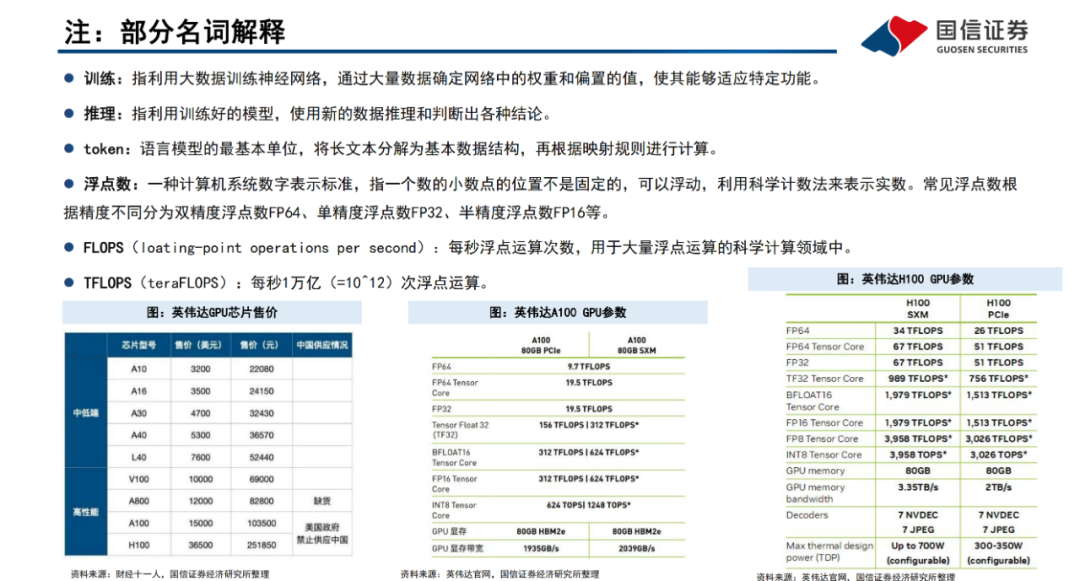

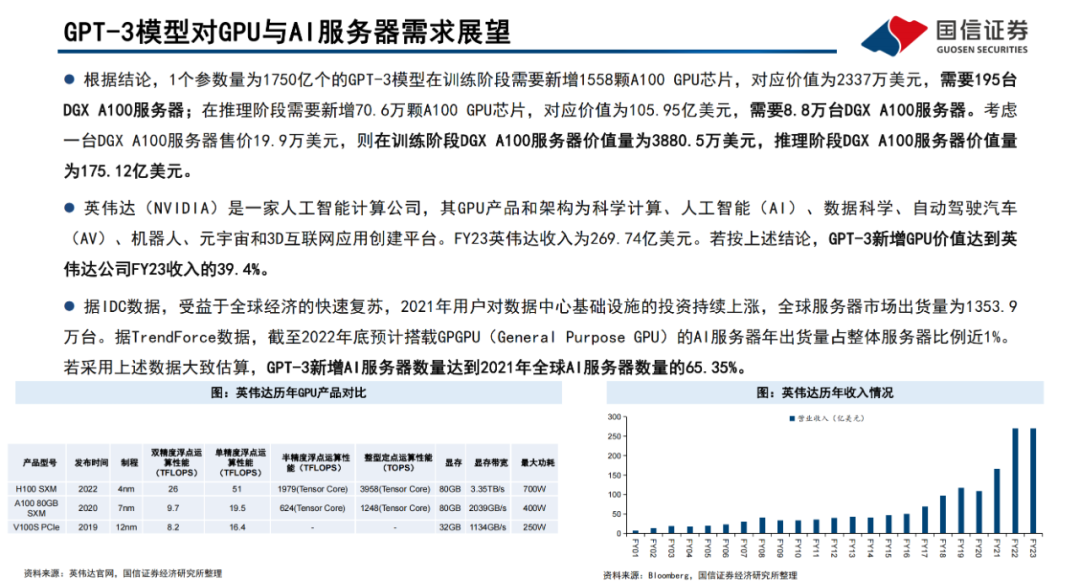

以GPT-3為例,GPT-3參數(shù)量達(dá)1750億個(gè),訓(xùn)練樣本token數(shù)達(dá)3000億個(gè)。考慮采用精度為32位的單精度浮點(diǎn)數(shù)數(shù)據(jù)來(lái)訓(xùn)練模型及進(jìn)行谷歌級(jí)訪問(wèn)量推理,假設(shè)GPT-3模型每次訓(xùn)練時(shí)間要求在30天完成,對(duì)應(yīng)GPT-3所需運(yùn)算次數(shù)為3.15*10^23FLOPs,所需算力為121.528PFLOPS,以A100PCle芯片為例,訓(xùn)練階段需要新增A100 GPU芯片1558顆,對(duì)應(yīng)DGX A100服務(wù)器195臺(tái)。

假設(shè)推理階段按谷歌每日搜索量35億次進(jìn)行估計(jì),則每日GPT-3需推理token數(shù)達(dá)7.9萬(wàn)億個(gè),所需運(yùn)算次數(shù)為4.76*10^24FLOPs,所需算力為55EFLOPs,則推理階段需要新增A100 GPU芯片70.6萬(wàn)顆,對(duì)應(yīng)DGX A100服務(wù)器8.8萬(wàn)臺(tái)。

-

神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

42文章

4765瀏覽量

100561 -

計(jì)算機(jī)

+關(guān)注

關(guān)注

19文章

7429瀏覽量

87730 -

機(jī)器學(xué)習(xí)

+關(guān)注

關(guān)注

66文章

8381瀏覽量

132431

原文標(biāo)題:AI大語(yǔ)言模型原理、演進(jìn)及算力測(cè)算

文章出處:【微信號(hào):AI_Architect,微信公眾號(hào):智能計(jì)算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

詳解深度學(xué)習(xí)、神經(jīng)網(wǎng)絡(luò)與卷積神經(jīng)網(wǎng)絡(luò)的應(yīng)用

從AlexNet到MobileNet,帶你入門(mén)深度神經(jīng)網(wǎng)絡(luò)

解析深度學(xué)習(xí):卷積神經(jīng)網(wǎng)絡(luò)原理與視覺(jué)實(shí)踐

深度神經(jīng)網(wǎng)絡(luò)是什么

如何構(gòu)建神經(jīng)網(wǎng)絡(luò)?

基于深度神經(jīng)網(wǎng)絡(luò)的激光雷達(dá)物體識(shí)別系統(tǒng)

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

【人工神經(jīng)網(wǎng)絡(luò)基礎(chǔ)】為什么神經(jīng)網(wǎng)絡(luò)選擇了“深度”?

深度學(xué)習(xí):神經(jīng)網(wǎng)絡(luò)和函數(shù)

什么是神經(jīng)網(wǎng)絡(luò)?什么是卷積神經(jīng)網(wǎng)絡(luò)?

淺析三種主流深度神經(jīng)網(wǎng)絡(luò)

淺析三種主流深度神經(jīng)網(wǎng)絡(luò)

如何提高深度神經(jīng)網(wǎng)絡(luò)的表現(xiàn)性能

如何提高深度神經(jīng)網(wǎng)絡(luò)的表現(xiàn)性能

評(píng)論