【核芯觀察】是電子發(fā)燒友編輯部出品的深度系列專(zhuān)欄,目的是用最直觀的方式令讀者盡快理解電子產(chǎn)業(yè)架構(gòu),理清上、中、下游的各個(gè)環(huán)節(jié),同時(shí)迅速了解各大細(xì)分環(huán)節(jié)中的行業(yè)現(xiàn)狀。以ChatGPT為首的AI大模型在今年以來(lái)可以說(shuō)是最熱的賽道,而AI大模型對(duì)算力的需求爆發(fā),也帶動(dòng)了AI服務(wù)器中各種類(lèi)型的芯片需求,所以本期核芯觀察將關(guān)注ChatGPT背后所用到的算力芯片產(chǎn)業(yè)鏈,梳理目前主流類(lèi)型的AI算力芯片產(chǎn)業(yè)上下游企業(yè)以及運(yùn)作模式。

ChatGPT帶火AI大模型行業(yè)

ChatGPT是OpenAI公司在2022年11月底發(fā)布的一款聊天機(jī)器人,屬于AICG(生成式人工智能技術(shù))之一,ChatGPT能夠通過(guò)理解和學(xué)習(xí)人類(lèi)語(yǔ)言來(lái)進(jìn)行對(duì)話,還能根據(jù)聊天上下文的信息進(jìn)行理解互動(dòng),完成包括撰寫(xiě)郵件、文案、翻譯、生成代碼等多種任務(wù)。

與以往的決策式AI相比,生成式AI不僅僅局限于通過(guò)簡(jiǎn)單分析現(xiàn)有數(shù)據(jù)來(lái)進(jìn)行決策,而是對(duì)現(xiàn)有數(shù)據(jù)進(jìn)行學(xué)習(xí)后,根據(jù)已有知識(shí)進(jìn)行模仿來(lái)生成全新的內(nèi)容。

ChatGPT可以理解成是利用GPT模型并結(jié)合多種技術(shù),包括多輪對(duì)話建模、對(duì)話行為分類(lèi)、情感分析、GPT全稱(chēng)是Generative Pre-trained Transformer,顧名思義這是一種生成式預(yù)訓(xùn)練語(yǔ)言模型,ChatGPT目前是基于GPT-3.5和GPT-4這兩個(gè)大語(yǔ)言模型構(gòu)建的。GPT的核心結(jié)構(gòu)是Transformer模型架構(gòu),可以說(shuō)ChatGPT是基于Transformer的文本生成能力,在大規(guī)模的對(duì)話語(yǔ)料上進(jìn)行了無(wú)監(jiān)督預(yù)訓(xùn)練,然后在特定的對(duì)話任務(wù)上進(jìn)行有監(jiān)督微調(diào),使得其可以自然地生成文本或者回答問(wèn)題,適用于自然語(yǔ)言生成的任務(wù),因此在聊天互動(dòng)上會(huì)有較好的表現(xiàn)。

在實(shí)際用戶體驗(yàn)中,ChatGPT展現(xiàn)出極高的對(duì)話質(zhì)量和實(shí)用性,盡管仍會(huì)出現(xiàn)一些事實(shí)性錯(cuò)誤,但超強(qiáng)的對(duì)話能力讓它迅速出圈,僅僅在上線兩個(gè)月后活躍用戶數(shù)就突破一億,成為史上增速最快的消費(fèi)級(jí)應(yīng)用。

與此同時(shí),ChatGPT的爆火,也引爆了AI大模型創(chuàng)業(yè)的新一輪熱潮,除了各大互聯(lián)網(wǎng)巨頭、高校團(tuán)隊(duì)之外,王小川、李開(kāi)復(fù)、賈揚(yáng)清等業(yè)界明星創(chuàng)業(yè)者也紛紛加入AI大模型創(chuàng)業(yè)的賽道,開(kāi)發(fā)類(lèi)ChatGPT的產(chǎn)品。

但這種AI大模型背后的技術(shù)底層并不簡(jiǎn)單,它需要海量的數(shù)據(jù)、復(fù)雜的算法和強(qiáng)大的算力來(lái)支撐。其中,算力是人工智能發(fā)展最大的瓶頸,也是當(dāng)前AI大模型核心競(jìng)爭(zhēng)力的關(guān)鍵因素。目前,AI大模型主要依賴(lài)于GPU或CPU+FPGA、ASIC等算力芯片來(lái)實(shí)現(xiàn)其高效運(yùn)行。這些算力芯片是針對(duì)人工智能算法做了特殊加速設(shè)計(jì)的芯片,也被稱(chēng)為AI加速器或計(jì)算卡,是AI的算力基礎(chǔ)。

所以,在當(dāng)前AI大模型行業(yè)的熱潮下,算力需求暴增帶來(lái)的是相關(guān)芯片需求的大幅上漲。有機(jī)構(gòu)預(yù)計(jì),AI訓(xùn)練對(duì)于算力的需求未來(lái)將會(huì)以每3.5個(gè)月翻一番的速度增長(zhǎng)。因此我們?cè)谶@期核芯觀察中,會(huì)著重關(guān)注ChatGPT火熱背后的算力芯片產(chǎn)業(yè)鏈。

大模型時(shí)代需要更多芯片算力

目前市面上主要的AICG預(yù)訓(xùn)練大模型主要有OpenAI的GPT系列、谷歌的PaLM、Meta的LLaMA、百度的文心系列、騰訊的混元系列、阿里巴巴的通義千問(wèn)、華為的盤(pán)古大模型等等

根據(jù)OpenAI公布的數(shù)據(jù),GPT模型從2018年6月首次發(fā)布到2023年5月,已經(jīng)迭代了四格大版本,參數(shù)量從GPT-1的1.17億到GPT-3的1750億到GPT-3的1750億。而最新的GPT-4雖然沒(méi)有公布訓(xùn)練參數(shù)量,不過(guò)根據(jù)OpenAI的說(shuō)法,GPT-4主要的升級(jí)是多模態(tài)能力方面,會(huì)使用到更多計(jì)算資源。

近期谷歌發(fā)布的PaLM2的升級(jí)也類(lèi)似,在參數(shù)量與PaLM2基本同是5400億的情況下大幅提升多模態(tài)能力,也就是可以同時(shí)處理文本、圖像、音頻等多種內(nèi)容。

而百度的類(lèi)ChatGPT模型文心一言,是基于百度文心大模型打造,2021年12月百度推出的文心ERNIE 3.0 Titan參數(shù)量規(guī)模高達(dá)2600億。

當(dāng)然由于大模型類(lèi)型的不同比如NLP、CV,也有融合了NLP和CV的多模態(tài),所以參數(shù)量也不直接代表大模型的實(shí)際能力。

參數(shù)量越高,意味著消耗的算力資源越多。以ChatGPT為例,由于ChatGPT與13億參數(shù)的InstructGPT是一對(duì)姐妹模型,僅在采集數(shù)據(jù)方式上有差異。參數(shù)規(guī)模為13.2億的GPT-3 XL與ChatGPT接近,而OpenAI公開(kāi)的數(shù)據(jù)中,GPT-3 XL訓(xùn)練所需算力是27.5PFlop/s-day(1PetaFLOP/s的效率運(yùn)行27.5天),那么我們可以大致認(rèn)為ChatGPT訓(xùn)練一次所需算力同樣是需要1PetaFLOP/s的效率運(yùn)行27.5天。

如果使用英偉達(dá)V100 GPU,按照半精度(FP16)算力125TFLOPS計(jì)算,ChatGPT至少需要一塊V100 GPU不間斷滿載運(yùn)行220天才能完成一次訓(xùn)練;如使用SXM版本的A100,按照半精度算力624TFLOPS計(jì)算,那么ChatGPT進(jìn)行一次訓(xùn)練也需要一塊A100運(yùn)行44天左右。

目前SXM版本最高規(guī)格顯存的V100和A100單卡市場(chǎng)售價(jià)大約分別為2.5萬(wàn)元和9萬(wàn)元左右。

當(dāng)然由于技術(shù)形式的不同,實(shí)際訓(xùn)練中的效率不會(huì)這么高,而這樣的訓(xùn)練成本僅是13億參數(shù)量的模型。如今AI大模型動(dòng)輒千億,甚至萬(wàn)億的參數(shù)量規(guī)模,比如有機(jī)構(gòu)報(bào)告推算GPT-4模型參數(shù)量達(dá)到1萬(wàn)億,那么在暴增的數(shù)據(jù)量下,為了縮短訓(xùn)練時(shí)間,對(duì)于AI服務(wù)器等算力硬件的需求量毫無(wú)疑問(wèn)會(huì)隨著模型訓(xùn)練數(shù)據(jù)量增加而提高。

另一方面,在ChatGPT這類(lèi)聊天應(yīng)用中,巨大的用戶訪問(wèn)量也給算力帶來(lái)巨大的性能和成本壓力。根據(jù)Similarweb數(shù)據(jù),今年2月OpenAI訪問(wèn)量已經(jīng)達(dá)到11億次,而根據(jù)Fortune的數(shù)據(jù),用戶每次與ChatGPT互動(dòng)產(chǎn)生的云算力成本約0.01美元,如果往低了算,每次訪問(wèn)網(wǎng)站僅進(jìn)行一次互動(dòng),那么單月僅算力成本也要1100萬(wàn)美元。

未來(lái)在包括類(lèi)ChatGPT在內(nèi)的AI大模型進(jìn)入到更多行業(yè)應(yīng)用之后,市場(chǎng)需求持續(xù)開(kāi)拓,AI服務(wù)器市場(chǎng)規(guī)模將有很大的市場(chǎng)空間,相關(guān)下游應(yīng)用對(duì)于算力硬件的需求將會(huì)迎來(lái)新一輪爆發(fā)。

IDC的數(shù)據(jù)顯示,2021年,全球AI服務(wù)器市場(chǎng)規(guī)模為156億美元,同比增長(zhǎng)39.1%;預(yù)計(jì)到2025年全球AI服務(wù)器市場(chǎng)規(guī)模將會(huì)達(dá)到317.9億美元,復(fù)合年均增長(zhǎng)率為19%。根據(jù)集邦咨詢數(shù)據(jù),截至2022年,預(yù)估搭載GPGPU的AI服務(wù)器年出貨量占整體服務(wù)器比重近1%,而2023年,在ChatGPT相關(guān)應(yīng)用加持下,預(yù)估出貨量年同比增長(zhǎng)8%,2022~2026年CAGR將達(dá)10.8%。

AI大模型背后用到哪些芯片?

在AI大模型領(lǐng)域,主要包括訓(xùn)練(training)和推理(inference)兩個(gè)步驟,訓(xùn)練即前面提到的通過(guò)大量經(jīng)過(guò)標(biāo)記的數(shù)據(jù)來(lái)訓(xùn)練能夠完成特定功能的模型,而推斷即利用經(jīng)過(guò)訓(xùn)練后的模型,根據(jù)新導(dǎo)入的數(shù)據(jù)來(lái)推斷出結(jié)論。

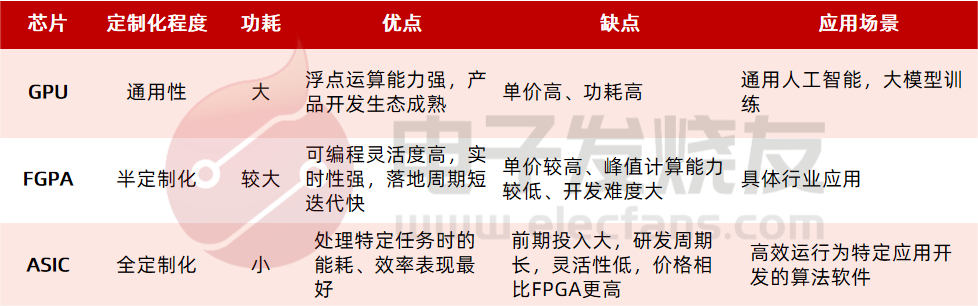

用于人工智能的服務(wù)器目前主要用到CPU搭配GPU、FPGA、AI ASIC這幾種加速芯片,根據(jù)不同的計(jì)算任務(wù)選擇不同的芯片搭配。對(duì)于大模型訓(xùn)練而言,傳統(tǒng)的CPU受限于單行運(yùn)算,主要在邏輯控制、串行運(yùn)算等方面有優(yōu)勢(shì),不擅長(zhǎng)復(fù)雜算法運(yùn)算和處理并行重復(fù)的操作。所以CPU在深度學(xué)習(xí)中會(huì)被用于推理或預(yù)測(cè)等領(lǐng)域,而在服務(wù)器中,CPU可以負(fù)責(zé)整個(gè)系統(tǒng)的管理和控制,是服務(wù)器的基礎(chǔ)硬件,而GPU、FPGA、ASIC等加速芯片則負(fù)責(zé)AI計(jì)算任務(wù)的加速,兩者相互協(xié)作,共同提升整個(gè)系統(tǒng)的性能。按照IDC的數(shù)據(jù)CPU在基礎(chǔ)型、高性能型、推理型、訓(xùn)練型服務(wù)器中成本占比分別為32%、23.3%、25%、9.8%。

GPU則是目前AI服務(wù)器最常見(jiàn)的芯片,它提供多核并行計(jì)算的基礎(chǔ)結(jié)構(gòu),可以支撐大算力需求,并且擁有高浮點(diǎn)運(yùn)算能力,在處理圖形數(shù)據(jù)和復(fù)雜算法方面與CPU相比有明顯優(yōu)勢(shì),滿足深度學(xué)習(xí)領(lǐng)域的大量數(shù)據(jù)運(yùn)算需求。不過(guò)GPU管理控制能力弱,需要配合CPU使用,功耗也較高。

FPGA也就是現(xiàn)場(chǎng)可編程門(mén)陣列,特點(diǎn)是可以無(wú)限次編程、靈活性較高,延時(shí)低,實(shí)時(shí)性強(qiáng),可以同時(shí)進(jìn)行數(shù)據(jù)并行和任務(wù)并行計(jì)算,在處理特定應(yīng)用時(shí)會(huì)有明顯的效率優(yōu)勢(shì)。同時(shí)可重復(fù)編程為算法功能實(shí)現(xiàn)和優(yōu)化提供較大的修改空間。但與此同時(shí)FPGA開(kāi)發(fā)難度大,價(jià)格較高,所以應(yīng)用場(chǎng)景會(huì)受到一定限制。

AI用ASIC顧名思義是全定制化的芯片,專(zhuān)為特定應(yīng)用或?qū)崿F(xiàn)某種特定功能而專(zhuān)門(mén)設(shè)計(jì)的AI芯片,在處理相應(yīng)任務(wù)時(shí)的能耗、效率表現(xiàn)都最好。但ASIC前期研發(fā)成本高、時(shí)間周期長(zhǎng),并且由于定制化設(shè)計(jì),應(yīng)用場(chǎng)景極為局限。在深度學(xué)習(xí)算法穩(wěn)定后,可以通過(guò)根據(jù)算法需求設(shè)計(jì)ASIC,提供最高效率的算力硬件,大規(guī)模應(yīng)用下能夠大幅降低整體系統(tǒng)成本。

總結(jié)一下這四種芯片在AI計(jì)算中起到的不同作用:CPU主要用于邏輯判斷、任務(wù)調(diào)度和控制方面;模型訓(xùn)練則往往會(huì)使用GPU;FPGA多數(shù)在研發(fā)階段、數(shù)據(jù)中心、AI推理方面;AI用ASIC主要面向使用特定AI算法的應(yīng)用場(chǎng)景,需要較為成熟的應(yīng)用支撐其量產(chǎn)。

根據(jù)IDC的數(shù)據(jù),中國(guó)AI芯片市場(chǎng)上目前GPU占比最高為89%,其次是NPU占到9.6%,ASIC和FPGA僅分別占1%和0.4%。其中NPU主要是用在邊緣側(cè)。而對(duì)于AI服務(wù)器的使用領(lǐng)域,按照當(dāng)前趨勢(shì),在市場(chǎng)增長(zhǎng)的情況下,服務(wù)器用于推理的負(fù)載占比會(huì)緩慢增加。2021用于推理和訓(xùn)練的占比分別為40.9%和59.1%,IDC預(yù)測(cè)2025年推理和訓(xùn)練的占比調(diào)整為 60.8%和39.2%。

不過(guò)隨著AI大模型的成熟、算法持續(xù)優(yōu)化、芯片性能的提升等因素變化,未來(lái)模型消耗的算力需求、服務(wù)器數(shù)量需求可能會(huì)比預(yù)測(cè)的數(shù)據(jù)要低。

下一期內(nèi)容,我們將會(huì)對(duì)AI大模型中使用到的CPU、GPU、FPGA、ASIC這些細(xì)分領(lǐng)域產(chǎn)業(yè)鏈中做進(jìn)一步的分析梳理,記得關(guān)注我們~

聲明:本文內(nèi)容及配圖由入駐作者撰寫(xiě)或者入駐合作網(wǎng)站授權(quán)轉(zhuǎn)載。文章觀點(diǎn)僅代表作者本人,不代表電子發(fā)燒友網(wǎng)立場(chǎng)。文章及其配圖僅供工程師學(xué)習(xí)之用,如有內(nèi)容侵權(quán)或者其他違規(guī)問(wèn)題,請(qǐng)聯(lián)系本站處理。

舉報(bào)投訴

-

算力芯片

+關(guān)注

關(guān)注

0文章

44瀏覽量

4502 -

算力

+關(guān)注

關(guān)注

1文章

925瀏覽量

14738 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1548瀏覽量

7487

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

AI算力芯片供電電源測(cè)試?yán)?費(fèi)思低壓大電流系列電子負(fù)載

AI算力芯片作為驅(qū)動(dòng)復(fù)雜計(jì)算任務(wù)的核心引擎,其性能與穩(wěn)定性成為了決定應(yīng)用成敗的關(guān)鍵因素。而在這背后,供電電源的穩(wěn)定性和高效性則是保障AI算

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構(gòu)分析」閱讀體驗(yàn)】--全書(shū)概覽

本帖最后由 1653149838.791300 于 2024-10-16 22:19 編輯

感謝平臺(tái)提供的書(shū)籍,厚厚的一本,很有分量,感謝作者的傾力付出成書(shū)。

本書(shū)主要講算力芯片CPU

發(fā)表于 10-15 22:08

名單公布!【書(shū)籍評(píng)測(cè)活動(dòng)NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架構(gòu)分析

試用評(píng)測(cè)資格!

前言

不知不覺(jué)中,我們來(lái)到一個(gè)計(jì)算機(jī)科學(xué)飛速發(fā)展的時(shí)代,手機(jī)和計(jì)算機(jī)中各類(lèi)便捷的軟件已經(jīng)融入日常生活,在此背景下,硬件特別是算力強(qiáng)勁的芯片,對(duì)于軟件服務(wù)起到不可替代的支撐作用。

發(fā)表于 09-02 10:09

淺析三大算力之異同

隨著一年多前ChatGPT的出現(xiàn)引爆人工智能(AI)浪潮,支撐大模型背后的“算力”概念突然闖進(jìn)我們的視野,成為科技圈炙手可熱的新詞,引領(lǐng)著最新潮流。作為數(shù)字經(jīng)濟(jì)時(shí)代新生產(chǎn)

商湯科技采購(gòu)40000顆英偉達(dá)芯片,縮小中美算力差距

徐冰認(rèn)為,國(guó)產(chǎn)芯片崛起以及算力商品化帶來(lái)的投資價(jià)值,使中美算力差距有望逐步縮小。只要中國(guó)持續(xù)在算

揭秘芯片算力:為何它如此關(guān)鍵?

在數(shù)字化時(shí)代,芯片作為電子設(shè)備的核心組件,其性能直接關(guān)系到設(shè)備的運(yùn)行速度和處理能力。而芯片的算力,即其計(jì)算能力,更是衡量芯片性能的重要指標(biāo)。

算力系列基礎(chǔ)篇——算力101:從零開(kāi)始了解算力

相信大家已經(jīng)感受到,我們正處在一個(gè)人工智能時(shí)代。如果要問(wèn)在人工智能時(shí)代最重要的是什么?那必須是:算力!算力!算

大算力時(shí)代, 如何打破內(nèi)存墻

設(shè)計(jì)的不斷革新,進(jìn)入了大算力時(shí)代。 目前,主流AI芯片的架構(gòu)仍然沿用了傳統(tǒng)的馮·諾依曼模型,這一設(shè)計(jì)將計(jì)算單元與數(shù)據(jù)存儲(chǔ)分離。在這種架構(gòu)下,處理器需要從內(nèi)存中讀取數(shù)據(jù),執(zhí)行計(jì)算任務(wù),然后將結(jié)果寫(xiě)回內(nèi)存。盡管AI

高算力芯片:未來(lái)科技的加速器?

在數(shù)字化時(shí)代,芯片作為電子設(shè)備的核心組件,其性能直接關(guān)系到設(shè)備的運(yùn)行速度和處理能力。而芯片的算力,即其計(jì)算能力,更是衡量芯片性能的重要指標(biāo)。

智能算力規(guī)模超通用算力,大模型對(duì)智能算力提出高要求

電子發(fā)燒友網(wǎng)報(bào)道(文/李彎彎)算力是設(shè)備通過(guò)處理數(shù)據(jù),實(shí)現(xiàn)特定結(jié)果輸出的計(jì)算能力,常用FLOPS作為計(jì)量單位。FLOPS是Floating-point Operations Per Second

ChatGPT算力芯片如何做算力輸出

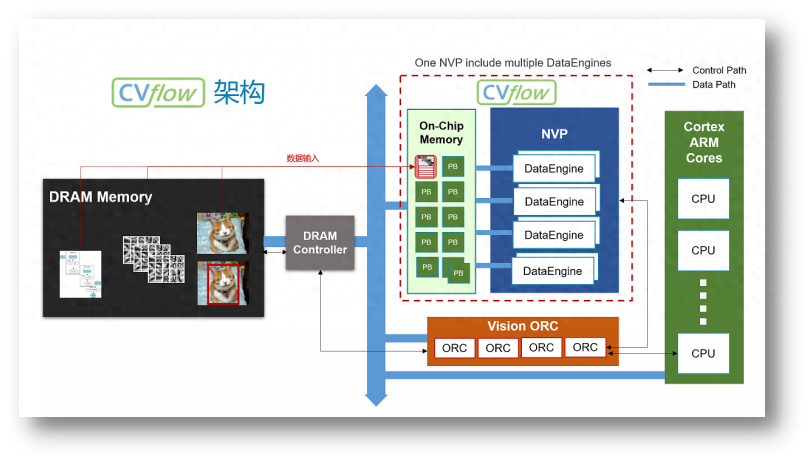

算力卡的核心當(dāng)然還是計(jì)算芯片,會(huì)搭配大容量高帶寬的內(nèi)存、緩存,以及搭載CPU用于調(diào)度,為了幫助數(shù)據(jù)傳輸,便會(huì)使用高速通道,這便是PCIe(高速串行計(jì)算機(jī)擴(kuò)展總線標(biāo)準(zhǔn))在系統(tǒng)中的作用:提供總線通道。

發(fā)表于 01-11 10:01

?455次閱讀

芯科技,解密ChatGPT暢聊之算力芯片

的GPU服務(wù)器,尤其是英偉達(dá)的A100 GPU,提供了強(qiáng)大而精確的計(jì)算能力。ChatGPT的功能遠(yuǎn)超日常對(duì)話,它能夠?qū)W習(xí)、理解并生成人類(lèi)般的文本,是人工智能領(lǐng)域的一個(gè)重要突破。但其真正力量的源泉,是背后那些不斷工作的算

淺談為AI大算力而生的存算-體芯片

大模型爆火之后,存算一體獲得了更多的關(guān)注與機(jī)會(huì),其原因之一是因?yàn)榇?b class='flag-5'>算一體芯片的裸算力相比傳統(tǒng)架構(gòu)的AI芯

發(fā)表于 12-06 15:00

?367次閱讀

大算力芯片里的HBM,你了解多少?

最近,隨著人工智能行業(yè)的高速崛起,大算力芯片業(yè)成為半導(dǎo)體行業(yè)為數(shù)不多的熱門(mén)領(lǐng)域HBM(高寬帶內(nèi)存:High-bandwidthmemory)作為大算

ChatGPT背后的算力芯片

ChatGPT背后的算力芯片

評(píng)論