Temperature 在模型中的作用

Temperature 是一個超參數,可用于控制生成語言模型中生成文本的隨機性和創造性。它用于調整模型的softmax輸出層中預測詞的概率。溫度參數定義為在應用 softmax 函數之前用于調整 logits 的比例因子的倒數。

當Temperature 設置為較低的值時,預測詞的概率會變尖銳,這意味著選擇最有可能的詞的概率更高。這會產生更保守和可預測的文本,因為模型不太可能生成意想不到或不尋常的詞。另一方面,當Temperature 設置為較高值時,預測詞的概率被拉平,這意味著所有詞被選擇的可能性更大。這會產生更有創意和多樣化的文本,因為模型更有可能生成不尋常或意想不到的詞。

溫度參數通常設置為 0.1 到 1.0 之間的值,具體取決于生成文本中所需的隨機性和創造性水平。溫度值為 1.0 對應于標準 softmax 函數,其中預測詞的概率未按比例縮放。

一般來說,Temperature 越低,GPT-3越有可能選擇出現概率較高的單詞。當我們想要GPT-3解釋概念時,它特別有用,因為答案只有一個。如果想要產生想法或完成一個故事,Temperature 設置的更大會給我們帶來更多的多樣性。

比如說以下提示:

Prompt: “The quick brown fox”

Temperature = 0.1:

“The quick brown fox jumped over the lazy dog. The quick brown fox jumped over the lazy dog. The quick brown fox jumped over the lazy dog.”

Temperature = 0.5:

“The quick brown fox jumped over the lazy dog. The lazy cat was not impressed. The quick brown fox ran away.”

Temperature = 1.0:

“The quick brown fox jumped over the lazy dog. Suddenly, a flock of birds flew overhead, causing the fox to stop in its tracks. It looked up at the sky, wondering where they were going.”

可以看到,Temperature 對生成文本的質量和創造性有重大影響。低值生成更可預測和重復的文本,而高值生成更多樣化和創造性的文本。

Temperature 的數學原理解釋

神經網絡的輸出是詞匯表中每個單詞(實際上是標記)的概率分布,告訴它這些單詞中任何一個可能跟隨輸入文本的可能性。

該概率分布由softmax函數計算:

如果將Temperature 參數(T)添加到softmax函數,則公式如下:

更深入的解釋Temperature 參數:

如果當T趨于無窮時會發生什么。每個x_i / T都會趨于0,從而得到一個均勻分布。也就是說概率分布變得更 “平”, 這會導致結果更隨機。

當T很小(比如0.1)時會發生什么。每個x_i / T之間的差異變得更加明顯(例如5比1變成50比10),這樣概率分布變得“更尖”,也就是說結果會更確定。

總結

Temperature 參數是語言生成模型中一個重要的超參數,可用于控制生成文本的隨機性和創造性。通過調整該參數,可以生成更保守或更有創意的文本,雖然Temperature 參數是生成高質量文本的強大工具,但需要注意的是,它并不能提高生成語言模型的性能。因為生成文本的質量高度依賴于訓練數據的質量、模型的架構以及其他超參數,如學習率和批處理大小。在設計和訓練生成語言模型時,必須考慮所有這些因素。

另外就是Temperature 參數可能并不總是提高生成文本的質量,特別是在訓練數據有限或有噪聲的情況下。在這種情況下,其他技術,如數據增強、正則化或遷移學習可能更有效地提高模型的性能。

最后Temperature 可以控制語言生成模型的行為。通過適當的調整,可以得到我們期望的結果。比如說生成更確定的答案可以降低該值,而生成更發散和創造性的答案可以提高該值,所以嘗試一下不同的值,看看這些更改對不的提示有什么影響,這會幫助我們更好的獲得想要的結果。

-

Temperature

+關注

關注

0文章

62瀏覽量

62405 -

LLM

+關注

關注

0文章

273瀏覽量

306

發布評論請先 登錄

相關推薦

High Temperature (HT) Manageme

Measuring Temperature with the

Distributed Temperature Sensin

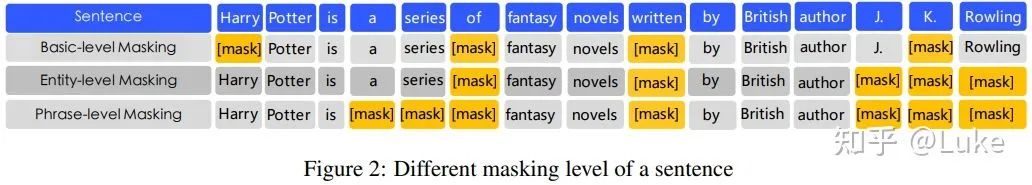

NLP的介紹和如何利用機器學習進行NLP以及三種NLP技術的詳細介紹

NLP中的深度學習技術概述

關于“NLP中的遷移學習”的教程

NLP 2019 Highlights 給NLP從業者的一個參考

金融市場中的NLP 情感分析

LLMs時代進行無害性評估的基準解析

大語言模型(LLMs)如何處理多語言輸入問題

NLP / LLMs中的Temperature是什么?

NLP / LLMs中的Temperature是什么?

評論