例如你坐在副駕所欣賞到的沿途美景信息,AI分分鐘給重建了出來:

看到過的水中的魚兒、草原上的馬兒,也不在話下:

這就是由新加坡國立大學和香港中文大學共同完成的最新研究,團隊將項目取名為MinD-Video。

Cinematic Mindscapes: High-quality Video Reconstruction from Brain Activity 主頁:https://mind-video.com/ 論文:https://arxiv.org/abs/2305.11675 代碼:https://github.com/jqin4749/MindVideo

這波操作,宛如科幻電影《超體》中Lucy讀取反派大佬記憶一般:

引得網友直呼:

推動人工智能和神經科學的前沿。

值得一提的是,大火的Stable Diffusion也在這次研究中立了不小的功勞。

怎么做到的?

從大腦活動中重建人類視覺任務,尤其是功能磁共振成像技術(fMRI)這種非侵入式方法,一直是受到學界較多的關注。

因為類似這樣的研究,有利于理解我們的認知過程。

但以往的研究都主要聚焦在重建靜態圖像,而以高清視頻形式來展現的工作還是較為有限。

之所以會如此,是因為與重建一張靜態圖片不同,我們視覺所看到的場景、動作和物體的變化是連續、多樣化的。

而fMRI這項技術的本質是測量血氧水平依賴(BOLD)信號,并且在每隔幾秒鐘的時間里捕捉大腦活動的快照。

相比之下,一個典型的視頻每秒大約包含30幀畫面,如果要用fMRI去重建一個2秒的視頻,就需要呈現起碼60幀。

因此,這項任務的難點就在于解碼fMRI并以遠高于fMRI時間分辨率的FPS恢復視頻。

為了彌合圖像和視頻大腦解碼之間差距,研究團隊便提出了MinD-Video的方法。

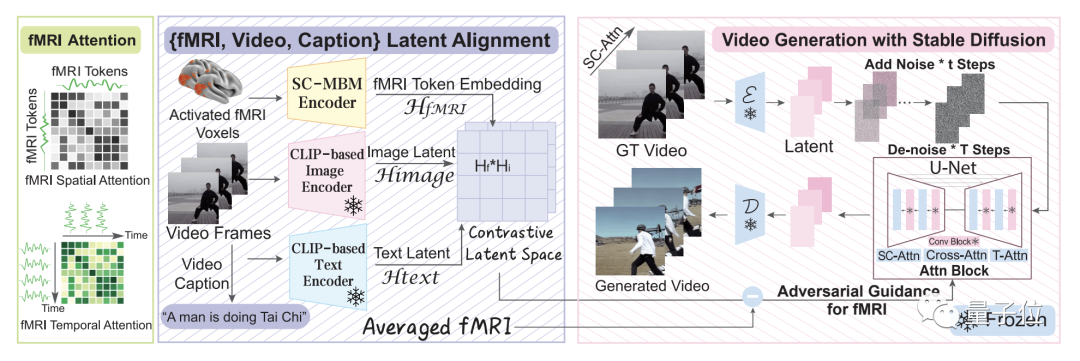

整體來看,這個方法主要包含兩大模塊,它們分別做訓練,然后再在一起做微調。

這個模型從大腦信號中逐步學習,在第一個模塊多個階段的過程,可以獲得對語義空間的更深入理解。

具體而言,便是先利用大規模無監督學習與mask brain modeling(MBM)來學習一般的視覺fMRI特征。

然后,團隊使用標注數據集的多模態提取語義相關特征,在對比語言-圖像預訓練(CLIP)空間中使用對比學習訓練fMRI編碼器。

在第二個模塊中,團隊通過與增強版Stable Diffusion模型的共同訓練來微調學習到的特征,這個模型是專門為fMRI技術下的視頻生成量身定制的。

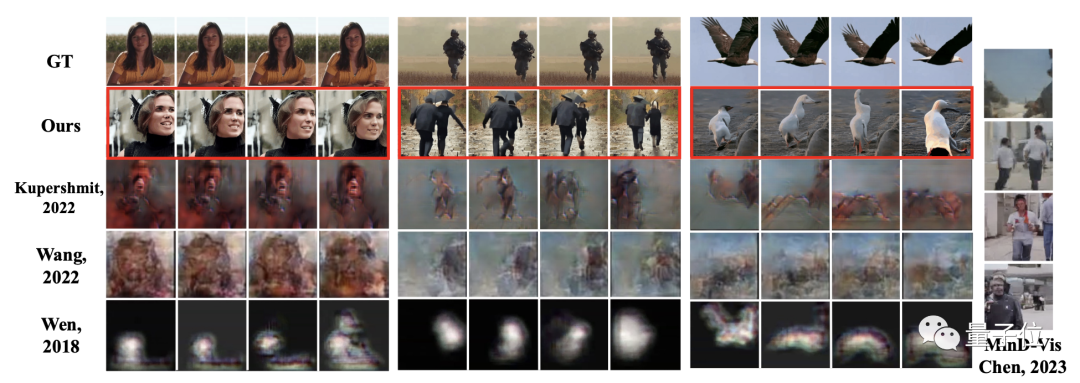

如此方法之下,團隊也與此前的諸多研究做了對比,可以明顯地看到MinD-Video方法所生成的圖片、視頻質量要遠優于其它方法。

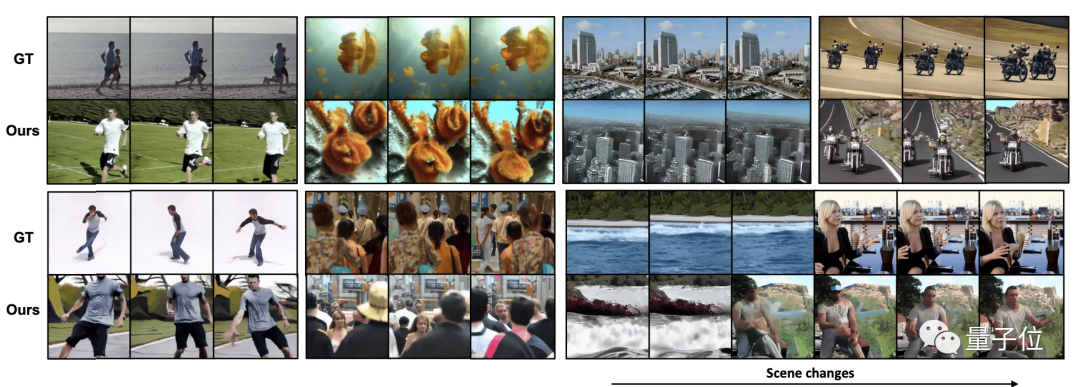

而且在場景連續變化的過程中,也能夠呈現高清、有意義的連續幀。

研究團隊

這項研究的共同一作,其中一位是來自新加坡國立大學的博士生Zijiao Chen,目前在該校的神經精神疾病多模式神經成像實驗室(MNNDL_Lab)。

另一位一作則是來自香港中文大學的Jiaxin Qing,就讀專業是信息工程系。

除此之外,通訊作者是新加坡國立大學副教授Juan Helen ZHOU。

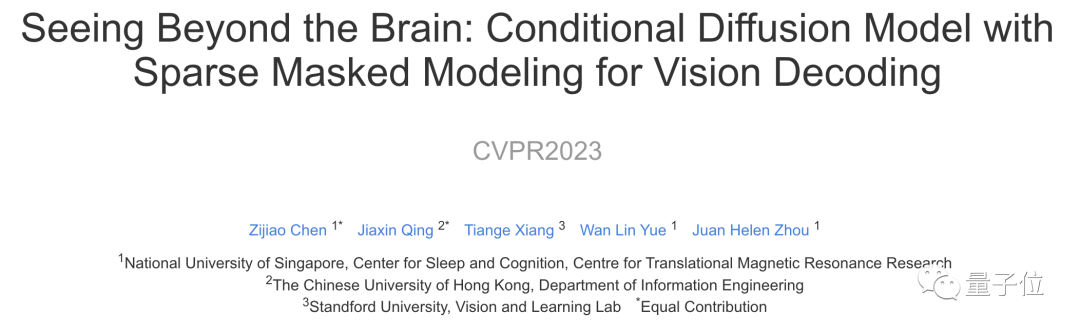

據了解,這次的新研究是他們團隊在此前一項名為MinD-Vis的功能磁共振成像圖像重建工作的延伸。

MinD-Vis已經被CVPR 2023所接收。

審核編輯 :李倩

-

AI

+關注

關注

87文章

30146瀏覽量

268421 -

人工智能

+關注

關注

1791文章

46859瀏覽量

237579 -

視覺

+關注

關注

1文章

146瀏覽量

23893

原文標題:驚!大腦視覺信號被Stable Diffusion復現成視頻!"AI讀腦術"又來了!

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

PCB視頻板 —— 開啟視覺盛宴的關鍵之匙

實操: 如何在AirBox上跑Stable Diffusion 3

STM32F4在APP運行時導致IAP程序被修改怎么解決?

UL Procyon AI 發布圖像生成基準測試,基于Stable Diffusion

Stability AI推出全新Stable Video 3D模型

Stability AI推出Stable Video 3D模型,可制作多視角3D視頻

韓國科研團隊發布新型AI圖像生成模型KOALA,大幅優化硬件需求

OpenAI視頻模型Sora的架構及應用場景

Stability AI試圖通過新的圖像生成人工智能模型保持領先地位

一種新的分割模型Stable-SAM

NeurIPS23|視覺 「讀腦術」:從大腦活動中重建你眼中的世界

免費開源圖像修復工具lama-cleaner介紹

LDR6020 VR串流線方案:實現同時充電傳輸視頻信號

驚!大腦視覺信號被Stable Diffusion復現成視頻!

驚!大腦視覺信號被Stable Diffusion復現成視頻!

評論